一种结合对话信息的多模型意图识别方法与流程

1.本发明涉及的是意图识别领域,具体涉及一种结合对话信息的多模型意图识别方法。

背景技术:

2.随着社会经济的发展,各行各业都需要客服业务,以解决用户在使用相关服务时的问题,但随着业务量的扩大,客服规模也在逐渐扩大,从而会导致投入人力过多,成本过高等一系列问题,因此智能客服成为了解决这一困境的主要手段。目前智能客服已经被广泛应用到各行各业的方方面面,比如:保险、银行、通信等各个领域。

3.意图识别是智能客服系统中的核心任务,智能客服系统通过识别用户的意图,来进行相应的回复以及操作,但现阶段的很多智能客服系统只能实现一问一答的形式,无法联系用户的对话上下文来精确理解用户的实际意图,因此容易出现智能客服意图理解错误,意图识别准确率低,用户体验较差的问题。

4.综上所述,本发明提出了一种结合对话信息的多模型意图识别方法。

技术实现要素:

5.针对现有技术上存在的不足,本发明目的是在于提供一种结合对话信息的多模型意图识别方法,通过结合对话信息,建立了三种不同长短期记忆网络模块,分别是负责全局状态的lstm

global

,负责角色状态的lstm

role

和负责意图状态的lstm

intent

,通过对三种不同的状态模块进行分别建模,更好地结合了对话的上下文信息,解决了单轮对话问答,意图识别效果差的问题。并进一步结合simcse-bert模型对用户对话文本进行高效准确地文本向量化表示,从而很好地提高了意图识别的准确率。

6.为了实现上述目的,本发明是通过如下的技术方案来实现:一种结合对话信息的多模型意图识别方法,包括以下步骤:

7.s1、该结合对话信息的多模型意图识别方法的输入为用户的上下文对话文本。

8.s2、首先利用语料库中的用户的上下文对话文本对bert模型进行增量预训练。

9.s3、将增量预训练后的bert模型进行对比学习训练,得到simcse-bert模型,其中simcse-bert模型的目标函数为:

[0010][0011]

其中为原句的向量表示,为原句正例的向量表示,为原句负例的向量表示,为向量与的余弦相似度,τ为温度参数。

[0012]

s4、将文本数据输入至simcse-bert模型得到文本的向量化表示u

t

,将文本向量化表示u

t

,输入至dialoguelstm模型。

[0013]

s5、dialoguelstm采用dialougernn的训练思路,并在原模型基础上,进行改进,采用了lstm模块。dialoguelstm模型由三个lstm模块组成,包括负责全局状态的lstm

global

、负责角色状态的lstm

role

、负责意图状态的lstm

intent

。

[0014]

s6、首先根据输入的文本向量化表示u

t

,更新全局状态lstm

global

的状态,其更新方式如下:

[0015][0016]

其中g

t

为本轮的对话的全局状态,u

t

为本轮对话的文本向量表示,rs,t-1为上一轮对话说话者的状态。

[0017]

s7、接下来通过注意力机制计算本轮的上下文隐藏向量dt,其计算方式如下:

[0018][0019]ct

=a[g1,g2,...,g

t-1

]

t

[0020]

其中a表示对过去全局状态g1,g2,...,g

t-1

的注意力分数,dt为本轮的上下文隐藏向量,u

t

为本轮对话的文本向量表示,wa为变量参数。

[0021]

s8、在计算得到本轮的上下文隐藏向量dt后,需更新本轮对话的说话者状态r

s,t

,而本轮聆听者的状态保持不变,其更新公式如下:

[0022][0023]

其中r

s,t

为本轮对话的说话者状态,u

t

为本轮对话的文本向量表示,dt为本轮的上下文隐藏向量。

[0024]

s9、最后更新意图状态it,意图状态的更新方式如下:

[0025]it

=lstm

intent

(r

s,t

)

[0026]

其中r

s,t

为本轮对话的说话者状态,i

t

为更新后的意图状态。

[0027]

s10、将更新得到的意图状态it输入至全连接层(full connected layer)以及softmax函数得到本轮意图识别的分类结果。

[0028]

本发明具有以下有益效果:

[0029]

1.本发明通过结合对话信息,建立了三种不同长短期记忆网络模块,分别是负责全局状态的lstm

global

,负责角色状态的lstm

role

和负责意图状态的lstm

intent

,通过对三种不同的状态模块进行分别建模,更好地结合了对话的上下文信息,解决了单轮对话问答,意图识别效果差的问题,提高了意图识别的准确率。

[0030]

2.构建了全局上下文隐藏向量dt,该向量通过对过去的全局状态g1,g2,...,g

t-1

使用注意力机制,更好地实现了上下文特征表征,为用户的意图识别提供了重要特征。

[0031]

3.本发明进一步结合了simcse-bert模型对用户对话文本进行高效准确地文本向量化表示,从而使意图识别的准确率得到进一步提升。

附图说明

[0032]

下面结合附图和具体实施方式来详细说明本发明;

[0033]

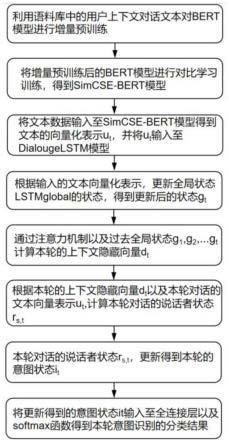

图1为本发明的整体流程示意图;

[0034]

图2为本发明的结合对话信息的多模型意图识别方法的架构示意图。

具体实施方式

[0035]

为使本发明实现的技术手段、创作特征、达成目的与功效易于明白了解,下面结合具体实施方式,进一步阐述本发明。

[0036]

实施例1:参照图1和图2,本实施例提供了一种结合对话信息的多模型意图识别方法,包括以下步骤:

[0037]

1、设bert模型的transformer encoder层数为12层。

[0038]

2、利用语料库中的用户的上下文对话文本对bert模型进行增量预训练。

[0039]

3、将增量预训练后的bert模型进行对比学习训练,得到simcse-bert模型,其中simcse-bert模型的目标函数为:

[0040][0041]

其中为原句的向量表示,为原句正例的向量表示,为原句负例的向量表示,为向量与的余弦相似度,τ为温度参数。

[0042]

4、将文本数据输入至simcse-bert模型得到文本的向量化表示u

t

,将文本向量化表示u

t

,输入至dialoguelstm模型。

[0043]

5、首先根据输入的文本向量化表示u

t

,更新全局状态lstm

global

的状态,其更新方式如下:

[0044][0045]

其中g

t

为本轮的对话的全局状态,u

t

为本轮对话的文本向量表示,rs,t-1为上一轮对话说话者的状态。

[0046]

6、接下来通过注意力机制计算本轮的上下文隐藏向量dt,其计算方式如下:

[0047][0048]ct

=a[g1,g2,...,g

t-1

]

t

[0049]

其中a表示对过去全局状态g1,g2,...,g

t-1

的注意力分数,dt为本轮的上下文隐藏向量,u

t

为本轮对话的文本向量表示,wa为变量参数。

[0050]

7、接着更新本轮对话的说话者状态r

s,t

,而本轮聆听者的状态保持不变,其更新公式如下:

[0051][0052]

其中r

s,t

为本轮对话的说话者状态,u

t

为本轮对话的文本向量表示,dt为本轮的上下文隐藏向量。

[0053]

8、最后更新意图状态it,意图状态的更新方式如下:

[0054]it

=lstm

intent

(r

s,t

)

[0055]

其中r

s,t

为本轮对话的说话者状态,i

t

为更新后的意图状态。

[0056]

9、将更新得到的意图状态it输入至全连接层(full connected layer)以及softmax函数得到本轮意图识别的分类结果。

[0057]

本实施例通过结合对话信息,建立了三种不同长短期记忆网络模块,分别是负责全局状态的lstm

global

,负责角色状态的lstm

role

和负责意图状态的lstm

intent

,通过对三种不同的状态模块进行分别建模,更好地结合了对话的上下文信息,解决了单轮对话问答,意图识别效果差的问题,提高了意图识别的准确率。构建了全局上下文隐藏向量dt,该向量通过对过去的全局状态g1,g2,...,g

t-1

使用注意力机制,更好地实现了上下文特征表征,为用户的意图识别提供了重要特征。本实施例进一步结合了simcse-bert模型对用户对话文本进行高效准确地文本向量化表示,从而使意图识别的准确率得到进一步提升。

[0058]

以上显示和描述了本发明的基本原理和主要特征和本发明的优点。本行业的技术人员应该了解,本发明不受上述实施例的限制,上述实施例和说明书中描述的只是说明本发明的原理,在不脱离本发明精神和范围的前提下,本发明还会有各种变化和改进,这些变化和改进都落入要求保护的本发明范围内。本发明要求保护范围由所附的权利要求书及其等效物界定。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1