一种面向精准感知的无人机分层逻辑决策系统的制作方法

1.本发明涉及无人机感知领域,特别适用于复杂场景下目标的精准感知。

背景技术:

2.无人机作为一种新型遥感传感器,目前被越来越多地应用于农林、国土、交通、环境监测、火灾预警等领域。无人机影像目标检测技术作为该应用领域的核心技术,对于无人机影像的应用具有极其重要的意义。尽管当前无人机视觉感知的智能化建设已有一定基础,能够对行人、车辆等目标进行比较准确的识别,但在数据、模型方面还存在很多问题。

3.在数据方面,无人机航拍影像具有如下特征:(1)小目标占比多。在相对尺度方面,航拍影像中多数目标边界框面积与图像面积之比中位数在0.08%~0.58%之间;在绝对尺度方面,航拍影像中有较多分辨率小于32像素

×

32像素的目标。(2)尺度差异大。由于无人机飞行高度不固定,载荷相机焦距不固定,造成无人机航拍影像中目标尺度多样化。(3)背景复杂。由于无人机飞行高度和俯仰角的变化,航拍影像中往往包含复杂的语义信息,如光照剧烈变化、目标遮挡、目标稠密相连、图像形状失真等问题。

4.在模型方面,目前提出了多种多样的航拍影像目标检测方法:针对复杂背景的检测方法有srpn、mda-net、多尺度空洞卷积等;针对小目标的检测方法有icn、din、lsn、特征金字塔等;针对旋转目标的检测方法有rrpn、drn、roi transformer等。

5.目前在无人机目标感知领域,大多是通过提出新的目标检测模型来提升感知精度。然而,不同模型均有适用的领域,没有哪一种模型可以在所有类型的目标上都做到最优,同时对模型精度的过度追求也忽视了无人机本身和载荷的灵活性。因此,精准感知不仅需要优秀的算法和模型,更需要从系统层面进行设计,通过对遥感影像的智能获取和多种信息的融合决策,实现算法模型和系统硬件的一体化感知。

技术实现要素:

6.针对复杂场景下目标信息难以精准感知的问题,提出了一种分层逻辑决策系统,对信息感知、信息提取、信息融合、逻辑决策、资源调度等无人机全流程、全要素进行统筹规划。本方法可以实现无人机在复杂场景下对目标的精准感知。

7.为了实现上述目的,本发明采用的技术方案为:

8.一种面向精准感知的无人机分层逻辑决策系统,包括:

9.感知层:基于深度学习算法,训练特征提取模型,并接收图像数据,基于训练好的特征提取模型提取目标的颜色、纹理和边缘特征,并进行多尺度特征融合;

10.语义层:根据感知层获得的目标特征,提取需要的目标语义,包括可见光目标语义、红外目标语义和场景分割语义;

11.信号层:根据语义层获得的目标语义,提取目标置信度、目标位置、目标尺度和目标速度;

12.逻辑决策层:对信号层提取的信息进行融合决策,分析无人机和载荷应当采取的

行动,并向无人机和载荷发布对应的控制指令,包括扫描、变倍和数引;

13.系统资源层:在无人机和载荷执行控制指令后,将最新的感知信息发送给感知层,进入下一个循环。

14.进一步的,信号层提取目标置信度、目标位置、目标尺度和目标速度的具体计算方式为:

15.从语义层输出直接获取有无目标、目标置信度和目标边界框信息;

16.计算目标中心点坐标,中心点横坐标x=(x1+x2)/2,纵坐标y=(y1+y2)/2;其中,(x1,y1)为目标边界框左上角坐标,(x2,y2)为右下角坐标;

17.计算目标尺度大小:s=(y

2-y1)*(x

2-x1);

18.计算目标速度大小:目标移动速度其中,(x',y')为上帧中心点位置,δt为相邻帧时间差。

19.进一步的,逻辑决策层的具体处理过程为:

20.(1)构建精准感知的逻辑决策模型的有限状态机表达式为:

21.m=(t,e,δ,t0,f)

22.式中,t为状态机中无人机和载荷的所有动作的集合,e为各状态所能响应的事件的集合,δ为状态转移函数,即不同状态间的事件响应规则,δ:t

×e→

t;,t0为初始状态;为某场景下行为终止状态集合;

23.其中,无人机和载荷的所有动作的集合t={数引定位、目标跟踪、变倍+、变倍-,变倍停,场景进入},场景进入为初始状态t0;

24.不同状态间的事件响应规则δ为:

25.若当前状态为“场景进入”,发生事件为“存在目标”,则系统状态转移至“目标跟踪”;

26.若当前状态为“目标跟踪”,发生事件为“目标出中心,跟踪失效”,则系统状态转移至“数引定位”;

27.若当前状态为“数引定位”,发生事件为“目标在中心,定位完成”,则系统状态转移至“目标跟踪”;

28.若当前状态为“目标跟踪”,发生事件为“速度小、尺度小”,则系统状态转移至“变倍+”;

29.若当前状态为“目标跟踪”,发生事件为“速度大、难跟上”,则系统状态转移至“变倍

‑”

;

30.若当前状态为“变倍+”,发生事件为“尺度和速度满足要求”,则系统状态转移至“变倍停”;

31.若当前状态为“变倍

‑”

,发生事件为“速度满足要求”,则系统状态转移至“变倍停”;

32.若当前状态为“变倍停”,发生事件为“存在目标”,则系统状态转移至“跟踪”;

33.各状态所能响应的事件的集合e为:

34.存在目标:根据信号层输出直接判断;

35.目标在中心和出中心:定义视场中心区域为s,若目标中心点(x,y)在区域s外,则

认为目标出中心,若目标中心点(x,y)在区域s内,则认为目标在中心;

36.速度条件:定义目标的正常速度区间为[v1,v2],目标实际速度为v,若v》v2,则目标速度大;若v∈[v1,v2],则目标速度满足要求;若v《v1,则目标速度低;

[0037]

尺度条件:定义目标合适尺度为s0,目标当前实际尺度为s,若s《s0,则目标尺度小;若s≥s0,则目标尺度满足要求;

[0038]

(2)基于构建的逻辑决策模型,判断当前发生事件,控制无人机和载荷自主进行数引定位、焦距调节和目标跟踪行为。

[0039]

本发明与背景技术相比具有如下优点:

[0040]

1.本发明从感知、语义、信号、逻辑决策和系统资源方面设计全流程的精准感知模型,流程框架具有较好的通用性。

[0041]

2.本发明充分利用无人机和载荷特性,通过反馈控制、软硬件配合,动态调整遥感影像切片大小,获取感知模型合适的输入,从而提升模型的识别效果。

[0042]

3.本发明所述系统可通过逻辑决策层的合理设计,实现多种感知信息的融合决策,进行智能化精准感知,并在外部环境发生变化时动态对无人机和载荷的行为进行调整。

附图说明

[0043]

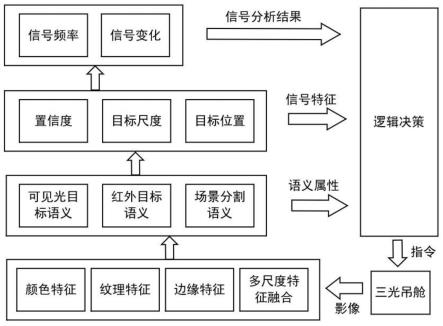

图1是本发明无人机分层逻辑决策系统框架图。

[0044]

图2是感知层特征提取深度神经网络示意图。

[0045]

图3是本发明视场中心区域定义及目标是否在中心判断示意图。

[0046]

图4是本发明运动目标场景下基于状态机的精准感知逻辑决策模型示意图。

[0047]

图5是本发明场景分割效果示意图,上半为原始场景,下半为场景分割后效果。

[0048]

图6是本发明库区巡逻场景异常人员精准感知逻辑决策模型示意图。

具体实施方式

[0049]

下面结合附图和具体实施方式对本发明的技术方案做进一步描述。

[0050]

实施例1

[0051]

本发明实施例中展示了对运动目标的持续识别过程,体现了系统通过载荷的动态控制对运动目标的精准感知能力。如图1所示,一种面向精准感知的无人机分层逻辑决策系统,其包括:

[0052]

感知层:基于深度学习算法,训练特征提取模型,并接收图像数据,基于训练好的特征提取模型提取目标的颜色、纹理和边缘特征,并进行多尺度特征融合;其中数据是感知的基础,根据场景需求,通过人工采集、半自动标注和自动知识提取技术,制备专业的航拍影像数据集;模型是感知的途径,基于深度学习算法,结合空洞卷积和多尺度检测思想,构建感知模型,如图2所示。

[0053]

语义层:根据感知层获得的目标特征,提取需要的目标语义,包括可见光目标语义、红外目标语义和场景分割语义;其中,对于可见光相机,模型在网络最后的预测层输出分类结果,根据需求获得目标类别信息和场景分割信息;对于红外相机,模型充分考虑远距离系统性衰减,取径向基神经网络对非制冷型红外测温数据进行非线性修正,降低远距离目标温度数据误差。

[0054]

信号层:根据语义层获得的目标语义,提取目标置信度、目标位置、目标尺度和目标速度;其中,提取目标置信度、目标位置、目标尺度和目标速度的具体计算方式为:

[0055]

从语义层输出直接获取有无目标、目标置信度和目标边界框信息;

[0056]

计算目标中心点坐标,中心点横坐标x=(x1+x2)/2,纵坐标y=(y1+y2)/2;其中,(x1,y1)为目标边界框左上角坐标,(x2,y2)为右下角坐标;

[0057]

计算目标尺度大小:s=(y

2-y1)*(x

2-x1);

[0058]

计算目标速度大小:目标移动速度其中,(x',y')为上帧中心点位置,δt为相邻帧时间差。

[0059]

逻辑决策层:对信号层提取的信息进行融合决策,分析无人机和载荷应当采取的行动,并向无人机和载荷发布对应的控制指令,包括扫描、变倍和数引;

[0060]

逻辑决策层的具体处理过程为:

[0061]

构建精准感知的逻辑决策模型的有限状态机表达式为:

[0062]

m=(t,e,δ,t0,f)

[0063]

式中,t为状态机中无人机和载荷的所有动作的集合,e为各状态所能响应的事件的集合,δ为状态转移函数,即不同状态间的事件响应规则,δ:t

×e→

t;,t0为初始状态;为某场景下行为终止状态集合;

[0064]

定义无人机和载荷的所有动作的集合t如下所示:

[0065][0066]

定义不同状态间的事件响应规则δ如下所示:

[0067][0068]

定义各状态所能响应的事件的集合e:

[0069]

·“存在目标”:根据信号层输出直接判断;

[0070]

·“目标出中心与在中心”:定义视场中心区域为s,若目标中心点(x,y)在区域s外,则认为目标出中心。同理,若目标中心点(x,y)在区域s内,则认为目标在中心,如图3所示;

[0071]

·“速度条件”:定义目标的常规速度区间为[v1,v2],目标实际速度为v。若v》v2,则目标速度偏大,载荷难以跟上目标;若v∈[v1,v2],则目标速度在此视场大小下恰好合适;若v《v1,则目标速度偏低,可放大目标尺度进行更精确的感知;

[0072]

·“尺度条件”:一般而言,对小目标的检测精度通常较低。因此,定义目标合适尺度为s0,目标当前实际尺度为s,若s《s0,则目标尺度较小若s≥s0,则认为目标尺度已达到精准感知要求;

[0073]

根据上述定义,设计运动目标场景下基于状态机的精准感知逻辑决策模型,如图4所示,该模型可控制无人机载荷根据目标当前状态自主进行数引定位、焦距调节、目标跟踪等行为,从而实现目标的精准感知。

[0074]

系统资源层:在无人机和载荷执行控制指令后,将最新的感知信息发送给感知层,进入下一个循环。

[0075]

系统资源层为无人机和载荷硬件设备,该实例中载荷为三光吊舱;在逻辑决策层,将决策结果传递给控制系统,发布对应的控制指令,载荷收到控制指令后,执行数引、变倍、跟踪等具体操作;载荷将新的遥感影像图传递给感知层的特征提取模型,重新进入下一轮循环。

[0076]

本实例体现了系统具有在复杂场景下对目标进行精准感知的能力。一方面,任何目标检测模型都有自己的优势和局限性,通过系统化设计,可以将目标图像切片调整到模

型适合识别的尺度,充分发挥感知模型的优势,从而得到更加精确的识别效果。另一方面,系统能够通过自动化的载荷控制,保持相机对目标的凝视,能够持续获取运动目标、闪烁目标等复杂场景下的目标影像,为精准感知提供持续可靠的信息支持。

[0077]

实施例2

[0078]

本发明实施例中展示了库区巡逻场景中异常人员精准识别流程,体现了系统通过信息融合,进行精准感知的能力。库区巡逻旨在对库区中的人员进行识别判定,并将异常人员告警上报。具体实施如下:

[0079]

特征提取模型输出层加上场景分割head,同时进行目标检测和场景分割,场景分割结果如图5所示,可将库区地形划分为草地和道路。

[0080]

设计逻辑决策模型如图6所示,将目标检测和场景分割信息进行融合决策,并通过载荷控制,进行库区人员身份的精准识别。具体过程包括:

[0081]

正常状态下,无人机在库区巡逻扫描,并根据天时(白天/黑夜)自主切换相机;

[0082]

当发现目标时,系统感知层和语义层进行特征提取和识别分类,获取目标类别信息和场景分割信息;

[0083]

逻辑决策层通过融合决策评估目标行为,假设库区道路上有监控,若目标为人且在道路,则认为威胁程度低,无人机短暂对目标进行跟踪,无异常则继续巡逻扫描。若目标为人且在草地,认为对方有躲避监控嫌疑,威胁程度较高,目标可疑;

[0084]

对于在草地的可疑目标,载荷通过数引变倍锁定目标人脸,获取人脸影像切片,进而进行人脸检测;

[0085]

若人脸检测结果是内部人员,则目标无威胁,无人机继续进行巡逻扫描;若是不明人员,则进行告警上报。

[0086]

本实例体现了系统对多种信息的融合决策能力,通过对目标类别语义和场景分割语义的综合分析,实现对目标身份信息的精准探查,并根据目标威胁程度控制无人机自主采取对应措施。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1