一种基于多模态输入与注意力机制的单视图位姿估计方法及其系统

1.本发明属于从单视图中估计物体6d位姿的技术领域,涉及一种基于多模态输入与注意力机制的单视图位姿估计方法及其系统。

背景技术:

2.在机器人抓取或增强现实等应用中,从rgb图像中估计物体的6d位姿是一项重要任务。尽管引入深度图像可以给该任务带来显著改善,然而深度图像并非总是很容易获得。例如手机、平板电脑、工业相机,大多没有提供深度数据。因此,大量研究致力于仅使用rgb图像估计已知对象的6d位姿。传统方法将rgb图像特征与物体的3d模型进行匹配来解决这个问题,这些方法依赖人工标注特征,且对光照变化、背景杂波或少纹理物体缺乏鲁棒性。深度学习的发展加速了从rgb图像中估计物体6d位姿的研究。目前较为流行的关键点方法,利用关键点作为中间监督信号,进行模型训练,然后将神经网络预测出的2d关键点结合pnp算法估计物体的6d位姿,例如pvnet【peng s等,pixel-wise voting network for 6dof pose estimation ieee/cvf 2019】、pix2pose【park k等,pixel-wise coordinate regression of objects for6d pose estimation.ieee/cvf 2019】等。

3.但是关键点方法的性能依赖于以下两个假设:1)深度学习模型可以准确预测二维关键点位置;2)预测出的二维关键点提供了足够的约束条件以回归物体6d位姿。然而物体存在部分被遮挡等因素会导致关键点预测不准确,因此这两种假设在许多现实环境中不易成立。

技术实现要素:

4.本发明的目的是克服现有单视图6d位姿估计方法存在的不足之处,提供一种基于多模态输入与注意力机制的单视图位姿估计方法及其系统,结合多模态输入与注意力特征增强技术,从二维图像中学习对象多种中间表示特征,进而从单张rgb图像中估计对象的6d位姿,具有更高的鲁棒性和位姿估计精度。

5.为解决上述技术问题,本发明采用以下技术方案。

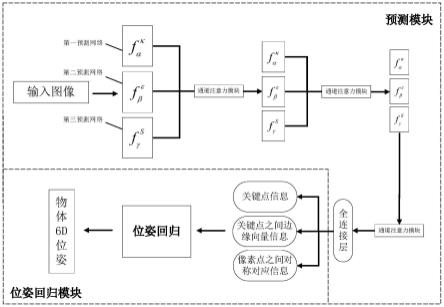

6.本发明的一种基于多模态输入与注意力机制的单视图位姿估计方法,构建一个包括预测模块和位姿回归模块的单视图位姿估计系统,结合多模态输入与注意力特征增强技术,从二维图像中学习对象的多种中间表示特征,进而回归对象6d位姿,其方法包括以下步骤:

7.步骤1、预测模块利用多种中间表示来表达rgb图像中的几何信息,同时引入注意力机制,以提升网络训练效率;所述的多种中间表示包括rgb图像的关键点κ、边缘向量ε和密集逐像素对应关系s;

8.所述的预测模块,包括第一预测网络第二预测网络第三预测网络和一个全连接网络,三个预测网络的每个降采样模块之间都嵌入了通道注意力模块;使用

pvnet作为主干网,是一个基于关键点的位姿估计网络,采用投票的方法预测可见和不可见的k个关键点;预测网络用以优化物体位姿;

9.步骤2、位姿回归模块获取预测模块得到的中间表示结果,将关键点、边缘向量和密集逐像素对应关系信息组合起来,通过epnp计算和奇异值分解从中间表示结果中回归物体6d位姿;

10.所述的位姿回归模块,用预测模块的各网络预测出的中间表示{κ,ε,s}作为输入,输出物体i的6d位姿:ri∈so(3),

11.具体地,所述的步骤1包括:

12.以关键点作为节点构造一个完全连通图ε:是预测沿着该图的图边缘向量的网络,采用resnet-18作为骨干网络;ε显式表达每对关键点之间的位移,|ε|表示预定义图形中的边数,因此

13.预测生成反映像素对称对应关系的第三种中间表示s,来反映物体的潜在反射对称性;扩展flownet的网络架构,将flownet预测的密集像素流与pvnet预测出的掩码图相融合,预测掩码区域内每个像素的对称对应关系;

14.的损失l1,的损失l2,的损失l3均使用fast rcnn中平滑损失进行训练;为体现不同中间表示对位姿估计网络效果的重要程度,使用x,y,z三个参数分别对三种中间表示的损失进行加权处理,其中x+y+z=1,因此总损失为:

15.l=xl1+yl2+zl3ꢀꢀ

(1)

16.通道注意力模块,将和每个残差块输出维度为的张量f作为注意力模块输入,进行平均池化操作,通道注意力模块通过执行卷积核大小为n=5的一维卷积来生成维度为的信道权重;得到的权重通过激活函数处理和维度还原后得到结果f

′

,并将其作为下一个残差块的输入。

17.具体地,所述的步骤2包括:

18.将标准坐标系中的三维关键点真值坐标表示为边缘向量真值表示为为将预测模块输出的关键点坐标表示为边缘向量表示为边缘向量表示为对称对应表示为为便于计算,使用齐次坐标标以及对应于pk,νe,q

s,1

和q

s,2

,这些齐次坐标由已知的相机内参归一化;

19.使用epnp算法,并结合中间表示的约束计算物体6d位姿;首先为三种预测元素引入以下差分向量:

[0020][0021]

[0022][0023]

其中es和e

t

是边e的端点,是基坐标系下反射对称平面的法线;

[0024]

其次,(2)式转化为形如a1x,a2x,a3x的形式,同理将(3)式转换为a4x,a5x,a6x,(4)式转化为a7x;将a1,a2,a3,a4,a5,a6合并为a;为描述预测值与真实值之间的关系,引入形式为ax=0的线性系统,其中a是维度为(3|κ|+3|ε|+|s|)

×

12的矩阵;x是一个在仿射空间中包含旋转矩阵r和平移向量t参数的向量;

[0025]

接着,使用epnp算法计算:

[0026][0027]

(5)式中vi是a的第i个最小奇异值对应的右奇异向量;理想情况下当预测元素无噪声时,n=1,x=vi是最优解;选择与epnp相同的n=4;为了计算最优的x,使用以下目标函数在交替优化过程中优化隐变量λi和旋转矩阵r:

[0028][0029]

(6)式中包括vi的前9个元素;在获得最优λi后,运用svd分解将投影至so(3),即得到旋转矩阵r=udiag(1,1,1)v

t

;最后利用ax=0得到相对应的平移向量t:

[0030][0031]

(7)式中a1=a

[:,1:9]

,a2=a

[:,10:12]

,由r展平得到。

[0032]

本发明的一种基于多模态输入与注意力机制的单视图位姿估计系统,包括:

[0033]

预测模块,利用多种中间表示来表达rgb图像中的几何信息,同时引入注意力机制,以提升网络训练效率;包括第一预测网络第二预测网络第三预测网络和一个全连接网络,三个预测网络的每个降采样模块之间都嵌入了通道注意力模块;使用pvnet作为主干网,是一个基于关键点的位姿估计网络,采用投票的方法预测可见和不可见的k个关键点;预测网络用以优化物体位姿;

[0034]

位姿回归模块,获取预测模块得到的中间表示结果,将关键点、边缘向量和密集逐像素对应关系信息组合起来,通过epnp计算和奇异值分解从中间表示结果中回归物体6d位姿;所述的位姿回归模块,用预测模块的各网络预测出的中间表示{κ,ε,s}作为输入,输出物体i的6d位姿:ri∈so(3),

[0035]

进一步的,在所述的预测模块中:

[0036]

使用pvnet作为主干网,是一个基于关键点的位姿估计网络,以关键点作为节点构造一个完全连通图,是预测沿着该图的图边缘向量的网络,其结构采用resnet-18作为骨干网络;ε显式表达每对关键点之间的位移,|ε|表示预定义图形中的边

数;ε是一个完全连通图,因此

[0037]

预测生成反映像素对称对应关系的第三种中间表示s,反映物体的潜在反射对称性;扩展了flownet的网络架构,将flownet预测的密集像素流与pvnet预测出的掩码图相融合,预测掩码区域内每个像素的对称对应关系;

[0038]

的损失l1、的损失l2、的损失l3均使用fast rcnn中平滑损失进行训练;为体现不同中间表示对位姿估计网络效果的重要程度,使用x,y,z三个参数分别对三种中间表示的损失进行加权处理,其中x+y+z=1;因此总损失为:

[0039]

l=xl1+yl2+zl3ꢀꢀ

(1)

[0040]

通道注意力模块,将和每个残差块输出维度为的张量f作为注意力模块输入,进行平均池化操作,通道注意力模块通过执行卷积核大小为n=5的一维卷积来生成维度为的信道权重;得到的权重通过激活函数处理和维度还原后得到结果f

′

,并将其作为下一个残差块的输入。

[0041]

进一步的,所述的位姿回归模块:

[0042]

将标准坐标系中的三维关键点真值坐标表示为边缘向量真值表示为为将预测模块输出的关键点坐标表示为边缘向量表示为边缘向量表示为对称对应表示为为便于计算,使用齐次坐标标以及对应于pk,νe,q

s,1

和q

s,2

,这些齐次坐标由已知的相机内参归一化;

[0043]

使用epnp算法,并结合中间表示的约束计算物体6d位姿;首先为三种预测元素引入以下差分向量:

[0044][0045][0046][0047]

其中es和e

t

是边e的端点,是基坐标系下反射对称平面的法线;

[0048]

其次,将(2)式转化为形如a1x,a2x,a3x的形式,同理将(3)式转换为a4x,a5x,a6x,(4)式转化为a7x;将a1,a2,a3,a4,a5,a6合并为a;为描述预测值与真实值之间的关系,引入形式为ax=0的线性系统,其中a是维度为(3|κ|+3|ε|+|s|)

×

12的矩阵;x是一个在仿射空间中包含旋转矩阵r和平移向量t参数的向量;

[0049]

接着,使用epnp算法计算x:

[0050][0051]

(5)式中vi是a的第i个最小奇异值对应的右奇异向量;理想情况下当预测元素无

噪声时,n=1,x=vi是最优解;选择与epnp相同的n=4;为了计算最优的x,使用以下目标函数在交替优化过程中优化隐变量λi和旋转矩阵r:

[0052][0053]

(6)式中包括vi的前9个元素;在获得最优λi后,运用svd分解将投影至so(3),即得到旋转矩阵r=udiag(1,1,1)v

t

;最后利用ax=0得到相对应的平移向量t:

[0054][0055]

(7)式中a1=a

[:,1:9]

,a2=a

[:,10:12]

,由r展平得到。

[0056]

与现有技术相比,本发明具有以下优点和有益效果:

[0057]

1.本发明提出一种新的6d位姿估计方法,该方法主要包括基于通道注意力的6d位姿估计网络。卷积神经网络模型(cnn)因其卷积核大小和特征池化等原因会导致预测6d位姿中存在一定的局限性。当网络输入中的目标区域图像占输入整体图像比例较小时,背景信息会在多次迭代卷积过程中产生大量噪声,影响目标区域的特征提取。为了克服卷积网络的局限性,提升网络训练效率以及准确性,本发明引入通道注意力模块,能更好地提取图像中细节特征,得到更精确的位姿估计结果。

[0058]

2.本发明使用关键点、关键点之间边缘向量、密集逐像素对应关系多种中间表示在输入图像中表达不同的几何信息,最大限度地提高生成的物体6d位姿估计的准确性。在关键点基础上添加对称对应约束,可以提升模型在估计旋转矩阵方面的性能;将边缘向量添加到关键点和对称对应中,对平移和旋转提供了更多约束。边缘向量比关键点提供更多的平移约束,因为它们表示相邻的关键点位移,并为回归提供梯度信息。与对称对应不同,边缘向量约束旋转参数的3个自由度,这进一步提高了估计旋转矩阵的性能。

[0059]

3.即使在复杂环境与遮挡条件下,本发明方法都能相当准确的预测出物体6d位姿。使用在6d位姿估计测试中两个流行的基准数据集linemod和occlusion linemod上评估本发明6d位姿估计网络性能,并与当前先进的6d位姿估计算法(如pix2pose、pvnet、posecnn、cdpn等)进行对比,本发明在linemod数据集上的平均add(-s)精度为92.8;在occlusion linemod数据集上的平均add(-s)精度为48.0。在处理遮挡问题方面,本发明方法相对pix2pose提升了16%,清晰显示了本发明在预测遮挡对象6d位姿上的优势。

附图说明

[0060]

图1是本发明的一种实施例的系统框图。

[0061]

图2是本发明的一种实施例的通道注意力模块图。

[0062]

图3是本发明实验中不同物体中间表示结果与位姿估计结果图。

[0063]

图4是本发明实验中不同比例遮挡下位姿估计结果图。

[0064]

图5是本发明实验中模型添加注意力模块前后网络训练损失对比图。

[0065]

图6是本发明实验中猫模型添加注意力模块前后网络训练损失对比图。

具体实施方式

[0066]

本发明公开了一种基于多模态输入与注意力机制的单视图位姿估计方法及其系

统,所构建的系统包括预测模块和位姿回归模块,结合多模态输入与注意力特征增强技术,从二维图像中学习对象的多种中间表示特征,进而回归对象6d位姿,其步骤包括:预测模块采用resnet-18作为骨干网络,该模块加入通道注意力机制估计物体6d位姿的多种中间表示,包括关键点、关键点之间的边缘向量和像素点之间的对称对应关系;位姿回归模块运用epnp算法和奇异值分解从中间表示结果中回归物体的6d位姿。本发明提供了一种准确的、方便的、从单视图中快速估计物体6d位姿的技术。

[0067]

下面结合附图,对本发明做进一步详细说明。

[0068]

图1是本发明的一种实施例的系统框图,同时体现了本发明的技术原理:旨在从单张rgb图像中估计对象的6d位姿,本发明方法包括:

[0069]

步骤1、预测模块利用多种中间表示来表达rgb图像中的几何信息,同时引入注意力机制,以提升网络训练效率;

[0070]

步骤2、位姿回归模块获取预测模块得到的中间表示结果,将关键点、边缘向量和密集逐像素对应关系信息组合起来,通过epnp计算和奇异值分解从中间表示结果中回归物体6d位姿。

[0071]

其预测模块,包括三个预测网络:第一预测网络第二预测网络和第三预测网络以及一个全连接网络,三个预测网络的每个降采样模块之间都嵌入了通道注意力模块。

[0072]

使用pvnet作为主干网,这是一个基于关键点的位姿估计网络,它采用投票的方法预测可见和不可见的k个关键点。为解决关键点预测不准确时位姿误差大的问题,引入另外两个预测网络以优化物体位姿。

[0073]

本发明以关键点作为节点构造一个完全连通图,是预测沿着该图的图边缘向量的网络,其结构采用resnet-18作为骨干网络。ε显式表达每对关键点之间的位移,|ε|表示预定义图形中的边数。本发明中ε是一个完全连通图,因此

[0074]

预测生成反映像素对称对应关系的第三种中间表示s,这些对称对应反映了物体的潜在反射对称性。扩展了flownet的网络架构,将flownet预测的密集像素流与pvnet预测出的掩码图相融合,预测掩码区域内每个像素的对称对应关系。与前两种中间表示方式相比,对称对应的数据量更大,对位姿估计结果的约束性更强,特别是为被遮挡的对象提供了丰富的约束,能更好地解决遮挡问题。

[0075]

本发明中的损失l1,的损失l2,的损失l3均使用fast rcnn中平滑损失进行训练。为体现不同中间表示对位姿估计网络效果的重要程度,本发明使用x,y,z三个参数分别对三种中间表示的损失进行加权处理,其中x+y+z=1。因此总损失为:

[0076]

l=xl1+yl2+zl3ꢀꢀ

(1)

[0077]

如图2所示,通道注意力模块,将和每个残差块输出维度为的张量f作为注意力模块输入,进行平均池化操作,通道注意力模块通过执行卷积核大小为n=5的一维卷积来生成维度为的信道权重。得到的权重通过激活函数处理和维度还原后得

到结果f

′

,并将其作为下一个残差块的输入。

[0078]

位姿回归模块:将网络预测出的中间表示{κ,ε,s}作为输入,输出物体i的6d位姿(ri∈so(3),)。

[0079]

本发明将标准坐标系中的三维关键点真值坐标表示为边缘向量真值表示为将预测模块输出的关键点坐标表示为边缘向量表示为对称对应表示为为便于计算本发明使用齐次坐标以及对应于pk,νe,q

s,1

和q

s,2

,这些齐次坐标由已知的相机内参归一化。

[0080]

本发明使用epnp算法,并结合中间表示的约束计算物体6d位姿。首先本发明为三种预测元素引入以下差分向量:

[0081][0082][0083][0084]

其中es和e

t

是边e的端点,是基坐标系下反射对称平面的法线。

[0085]

其次,将(2)式转化为形如a1x,a2x,a3x的形式,同理将(3)式转换为a4x,a5x,a6x,(4)式转化为a7x。将a1,a2,a3,a4,a5,a6合并为a。为描述预测值与真实值之间的关系,本发明引入形式为ax=0的线性系统,其中a是维度为(3|κ|+3|ε|+|s|)

×

12的矩阵。x是一个在仿射空间中包含旋转矩阵r和平移向量t参数的向量。

[0086]

接着,使用epnp算法计算x:

[0087][0088]

(5)式中vi是a的第i个最小奇异值对应的右奇异向量。理想情况下当预测元素无噪声时,n=1,x=vi是最优解。然而,在现实情况下,该方法的性能较差。本发明选择与epnp相同的n=4。为了计算最优的x,本发明使用以下目标函数在交替优化过程中优化隐变量λi和旋转矩阵r:

[0089][0090]

(6)式中包括vi的前9个元素。在获得最优λi后,运用svd分解将投影至so(3),即得到旋转矩阵r=udiag(1,1,1)v

t

。最后利用ax=0得到相对应的平移向量t:

[0091][0092]

(7)式中a1=a

[:,1:9]

,a2=a

[:,10:12]

,由r展平得到。

[0093]

本发明的实验验证说明:

[0094]

图3展示了本发明位姿估计的三种中间表示结果以及单目标物体6d位姿估计结

果:(a)表示输入图像;(b),(c),(d)分别表示预测出的关键点,边缘向量与对称对应图像;(e)表示回归计算出的6d位姿,其中绿色框代表物体6d位姿真实值,蓝色框代表本发明预测出的物体6d位姿。图4展示了在不同比例遮挡条件下本发明物体6d位姿估计结果。可以发现,即使在复杂环境与遮挡条件下,本发明都能相当准确的预测出物体6d位姿。本发明使用在6d位姿估计测试中两个流行的基准数据集linemod和occlusion linemod上评估本发明6d位姿估计网络性能,并与当前先进的6d位姿估计算法(如pix2pose、pvnet、posecnn、cdpn等)进行对比。如表1,表2所示,本发明在linemod数据集上的平均add(-s)精度为92.8;在occlusion linemod数据集上的平均add(-s)精度为48.0。

[0095]

从图3、图4、表1和表2可知,本发明可以实现精确的位姿估计,在linemod和occlusion linemod上的测试结果优于大多数最先进的方法。本发明优于用于预测关键点的主干模型pvnet,性能在所有对象类中都有提升,这表明了使用多种中间表示方法明显优于仅使用关键点的方法。在处理遮挡问题方面,本发明方法相对pix2pose提升了16%,这清晰地显示了多种中间表示在预测遮挡对象6d位姿上的优势。

[0096]

表1linemod数据集上的add(-s)性能比较

[0097][0098]

表2occlusion linemod数据集上的add(-s)性能比较

[0099][0100]

为验证添加注意力机制模块的性能,本发明在相同数据集上测试添加注意力模块前后的训练效果,图5是改进前后的综合损失曲线。

[0101]

由图5不难看出,在主干网络中添加注意力模块可优化物体位姿估计的最终训练结果,且训练过程中损失收敛速度更快,损失更小。实验结果表明,基础神经网络使用改进后的resnet-18与之前相比,在linemod数据集下的add(-s)指标平均提升了3.1%,在

occlusion linemod数据集下的add(-s)指标平均提升了1.4%,说明了本发明可更精确的估计物体6d位姿。

[0102]

综上所述,本发明提出一种基于多模态输入与注意力机制的单视图位姿估计方法及系统,该方法包括两个模块。第一个模块利用多种中间表示来表达rgb图像中的几何信息,同时引入注意力机制,以提升网络训练效率。该模块除了预测关键点之外,还能够预测相邻关键点之间的边缘向量。另外,本发明利用预测密集逐像素对应关系来反映像素之间的基本对称关系。这种集成多种中间表示的位姿估计方法相较于仅使用关键点表示的方法,提供了更多的约束,在存在遮挡、阴影等情况时也能实现精确的位姿预测。第二个模块获取先前模块得到的中间表示结果,将关键点、边缘向量和密集逐像素对应关系信息组合起来,通过epnp计算和奇异值分解从中间表示结果中回归物体6d位姿。该技术适用于船舶综合保障、自动化分拣、自动驾驶、医疗、虚拟现实、增强现实、工业制造等多个领域,可以精确地从图像中获取物体的6d位姿,为工业制造智能化、信息化提供技术支撑,具有广阔的市场前景。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1