基于文本蕴含的无触发词文本事件检测方法及系统

文档序号:33402690发布日期:2023-03-08 18:52阅读:128来源:国知局

导航: X技术> 最新专利>计算;推算;计数设备的制造及其应用技术

1.本发明涉及事件检测技术领域,具体涉及一种基于文本蕴含的无触发词文本事件检测方法及系统。

背景技术:

2.事件检测是信息抽取领域的重要课题,其目标是在非结构化的文本中检测出事件的发生,并得到正确的事件类型。事件检测目前已被广泛应用于事件溯源,风险预警,构建事件知识图谱构建等。

3.目前,常用的事件检测技术一方面大多使用触发词信息进行事件检测。然而触发词的标注过程耗时费力,选取极为不易,且不同的词语都可以代表同一事件的发生,所以不同的标注人员很可能选择不同的单词作为触发词,这无形当中降低了触发词识别的准确率,而触发词识别的错误会间接影响到事件类型的分类和检测结果;另一方面,现有的事件检测技术一般是基于深度学习的方法,而深度学习的方法十分依赖大规模、高质量的数据,而现实情况是已有的高质量的事件类型标注数据非常稀缺。

4.由此可见,现有的事件检测技术非常依赖样本数据(触发词和事件类型标注数据等)的数据量和质量,以致于无法在小数据集(样本数据的数据量少且质量不高)的情况下实现事件类型的精准检测。

技术实现要素:

5.(一)解决的技术问题

6.针对现有技术的不足,本发明提供了一种基于文本蕴含的无触发词文本事件检测方法及系统,解决了现有技术无法在小数据集的情况下实现事件类型精准检测的问题。

7.(二)技术方案

8.为实现以上目的,本发明通过以下技术方案予以实现:

9.第一方面,本发明首先提出了一种基于文本蕴含的无触发词文本事件检测方法,所述方法包括:

10.构建事件类型-假设描述性模板,基于所述事件类型-假设描述性模板将待检测文本的候选事件类型描述为多个不同的假设;

11.将待检测文本作为前提,并将所述前提分别和各个所述假设拼接后输入自然语言推理模型中,推理所述前提和所述假设是否满足蕴含关系;

12.输出和所述前提满足蕴含关系的所述假设所对应的事件类型作为待检测文本所属的事件类型。

13.优选的,所述假设包括正例假设和负例假设。

14.优选的,基于所述事件类型-假设描述性模板将待检测文本的候选事件类型描述为多个不同的假设包括:

15.在所述事件类型-假设描述性模板中填入正确的候选事件生成正例假设,填入错

误的候选事件则生成负例假设。

16.优选的,所述自然语言推理模型包括:

17.按照数据输入至输出的先后顺序逐一分布的嵌入层、bi-lstm layer、注意力机制,以及输出层;

18.其中,

19.所述嵌入层用于将由前提和假设拼接而成的输入文本转化为向量;

20.所述bi-lstm layer用于将由嵌入层输入的向量进行前向、后向学习,并将经过前向、后向学习的向量拼接为一个向量;

21.所述注意力机制用于计算bi-lstm layer输出的所有向量的矩阵中每个单词对应的权重和最终文本对应的语义向量;

22.所述输出层根据语义向量计算前提和假设满足蕴含关系的得分并将得分转化为概率。

23.优选的,所述输出和所述前提满足蕴含关系的所述假设所对应的事件类型作为待检测文本所属的事件类型包括:

24.输出每一对前提和假设满足蕴含关系时前提和假设的蕴含概率,然后将前提和假设的蕴含概率超过一定阈值时,该假设所对应的事件类型作为待检测文本所属的事件类型;

25.所述阈值根据单事件类型抽取和多事件类型抽取的需要进行设定。

26.第二方面,本发明还提出了一种基于文本蕴含的无触发词文本事件检测系统,所述系统包括:

27.事件类型-假设描述模块,用于在构建事件类型-假设描述性模板后,基于所述事件类型-假设描述性模板将待检测文本的候选事件类型描述为多个不同的假设;

28.前提和假设蕴含关系推理模块,用于将待检测文本作为前提,并将所述前提分别和各个所述假设拼接后输入自然语言推理模型中,推理所述前提和所述假设是否满足蕴含关系;

29.事件检测结果输出模块,用于输出和所述前提满足蕴含关系的所述假设所对应的事件类型作为待检测文本所属的事件类型。

30.优选的,所述假设包括正例假设和负例假设。

31.优选的,所述事件类型-假设描述模块基于所述事件类型-假设描述性模板将待检测文本的候选事件类型描述为多个不同的假设包括:

32.在所述事件类型-假设描述性模板中填入正确的候选事件生成正例假设,填入错误的候选事件则生成负例假设。

33.优选的,所述自然语言推理模型包括:

34.按照数据输入至输出的先后顺序逐一分布的嵌入层、bi-lstm layer、注意力机制,以及输出层;

35.其中,

36.所述嵌入层用于将由前提和假设拼接而成的输入文本转化为向量;

37.所述bi-lstm layer用于将由嵌入层输入的向量进行前向、后向学习,并将经过前向、后向学习的向量拼接为一个向量;

38.所述注意力机制用于计算bi-lstm layer输出的所有向量的矩阵中每个单词对应的权重和最终文本对应的语义向量;

39.所述输出层根据语义向量计算前提和假设满足蕴含关系的得分并将得分转化为概率。

40.优选的,所述事件检测结果输出模块输出和所述前提满足蕴含关系的所述假设所对应的事件类型作为待检测文本所属的事件类型包括:

41.输出每一对前提和假设满足蕴含关系时前提和假设的蕴含概率,然后将前提和假设的蕴含概率超过一定阈值时,该假设所对应的事件类型作为待检测文本所属的事件类型;

42.所述阈值根据单事件类型抽取和多事件类型抽取的需要进行设定。

43.(三)有益效果

44.本发明提供了一种基于文本蕴含的无触发词文本事件检测方法及系统。与现有技术相比,具备以下有益效果:

45.1、本发明首先通过构建事件类型-假设描述性模板,将待检测文本的候选事件类型描述为假设;然后将待检测文本作为前提,并将该前提分别和上述各个假设拼接后输入自然语言推理模型中推理前提和各个假设间是否满足蕴含关系;最后输出和前提满足蕴含关系的假设所对应的事件类型即为待检测文本所属的事件类型。本发明可在小数据集的情况下实现事件类型的精准检测,降低了事件检测技术对样本数据质量和数量方面的依赖性。

46.2、本发明构建的事件类型-假设描述性模板,可通过直观的描述性语言来表达具有丰富语义信息的特定事件类型标签,从而使文本和标签通过语义关系连接起来,通过该模板将填入的正确候选事件生成正例假设,将填入的错误候选事件生成负例假设,从而使得一条样本可以生成一系列假设,起到数据扩充的作用,以使得自然推理模型可以在生成的大量假设中学习到用于推理的知识;此外,将文本和标签通过语义连接能够更高效的利用预训练语言模型里的潜在知识,从而间接使得最终的事件类型检测结果更加精准。

47.3、本发明利用自然语言推理模型推理前提和假设是否满足蕴含关系,并计算每一对前提和假设满足蕴含关系的概率,可以更为精准的检测到事件类型。

48.4、本发明在进行事件检测时,可根据实际需要设置阈值,并将满足前提和假设的蕴含概率超过一定阈值时该假设所对应的多个事件类型作为待检测文本所属的事件类型输出,从而可以实现多事件类型的抽取,即检测一个文本中同时描述多种事件的发生。

附图说明

49.为了更清楚地说明本发明实施例或现有技术中的技术方案,下面将对实施例或现有技术描述中所需要使用的附图作简单地介绍,显而易见地,下面描述中的附图仅仅是本发明的一些实施例,对于本领域普通技术人员来讲,在不付出创造性劳动的前提下,还可以根据这些附图获得其他的附图。

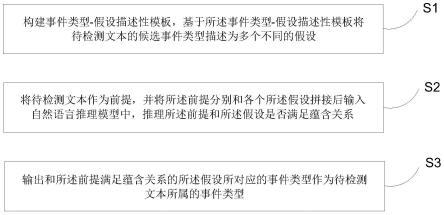

50.图1为本发明中基于文本蕴含的无触发词文本事件检测方法的流程图;

51.图2为本发明中基于文本蕴含的无触发词文本事件检测方法的实施例图;

52.图3为本发明实施例中自然语言推理模型模型的结构图。

具体实施方式

53.为使本发明实施例的目的、技术方案和优点更加清楚,对本发明实施例中的技术方案进行清楚、完整地描述,显然,所描述的实施例是本发明一部分实施例,而不是全部的实施例。基于本发明中的实施例,本领域普通技术人员在没有做出创造性劳动前提下所获得的所有其他实施例,都属于本发明保护的范围。

54.本技术实施例通过提供一种基于文本蕴含的无触发词文本事件检测方法及系统,解决了现有技术无法在小数据集的情况下实现事件类型精准检测的问题,实现了基于精准事件检测结果进行事件溯源,风险预警,以及事件知识图谱构建等目的。

55.本技术实施例中的技术方案为解决上述技术问题,总体思路如下:

56.本技术的技术方案提出的一种基于文本蕴含的无触发词文本事件检测方法,首先通过构建事件类型-假设描述性模板,将待检测文本的候选事件类型描述为假设;然后将待检测文本作为前提,并将该前提分别和上述各个假设拼接后输入自然语言推理模型中推理前提和各个假设间是否满足蕴含关系;最后输出和前提满足蕴含关系的假设所对应的事件类型即为待检测文本所属的事件类型。本发明将事件检测任务重构为文本蕴含任务,在低资源场景下即可实现事件检测;利用事件类型-假设描述性模板将待检测文本的候选事件类型描述为假设,可以进行数据扩充,有效解决已有标注数据稀缺、触发词标注困难等问题;并且可根据实际需要设置阈值,从而实现单个事件类型和多个事件类型作为待检测文本所属的事件类型输出。

57.为了更好的理解上述技术方案,下面将结合说明书附图以及具体的实施方式对上述技术方案进行详细的说明。

58.事件检测的目标是在非结构化的文本中检测出事件的发生,并得到正确的事件类型。例如,对于以下文本:"at least 19people were killed and 114people were wounded in tuesday's southern philippines airport blast,officials said,butreports saidthe deathtoll could climb to 30",我们需要利用模型检测出文本中描述中的"die","injure"和"attack"三种事件。已有的大多数做法是,先在上述文本中识别出哪一个词语是触发词(触发词是最能代表事件发生的词),再对触发词进行分类得到事件类型。例如,对于上面的例子中的"die"事件’,模型先通过序列标注、分类或其他方式在所有单词中识别出"killed"作为事件触发词,再对触发词进行分类得到文本的事件类型"die"。而从事件检测所使用的模型方面看,近年的大部分研究是使用深度学习模型实现事件检测。然而,利用触发词进行事件检测的技术非常依赖触发词的数量和质量,同时利用模型的事件检测技术又非常依赖事件类型标注数据的数量和质量。所以在样本数据的数据量少且质量不高(小数据集)的情况下很难实现事件类型的精准检测。

59.基于此,本发明提出了一种基于文本蕴含的无触发词文本事件检测技术,其可在标注数据稀缺的情况下实现无触发词的事件检测。

60.实施例1:

61.第一方面,本发明首先提出了一种基于文本蕴含的无触发词文本事件检测方法,参见图1,该方法包括:

62.s1、构建事件类型-假设描述性模板,基于所述事件类型-假设描述性模板将待检测文本的候选事件类型描述为多个不同的假设;

63.s2、将待检测文本作为前提,并将所述前提分别和各个所述假设拼接后输入自然语言推理模型中,推理所述前提和所述假设是否满足蕴含关系;

64.s3、输出和所述前提满足蕴含关系的所述假设所对应的事件类型作为待检测文本所属的事件类型。

65.可见,本实施例首先通过构建事件类型-假设描述性模板,将待检测文本的候选事件类型描述为假设;然后将待检测文本作为前提,并将该前提分别和上述各个假设拼接后输入自然语言推理模型中推理前提和各个假设间是否满足蕴含关系;最后输出和前提满足蕴含关系的假设所对应的事件类型即为待检测文本所属的事件类型。本实施例可在小数据集的情况下实现事件类型的精准检测,降低了事件检测技术对样本数据质量和数量方面的依赖性。

66.下面结合附图1-3,以及对s1-s3具体步骤的解释,来详细说明本发明一个实施例的实现过程。

67.s1、构建事件类型-假设描述性模板,基于所述事件类型-假设描述性模板将待检测文本的候选事件类型描述为多个不同的假设。

68.为了将事件检测任务重构为文本蕴含任务,首先需要构建一个可直观的、将事件类型描述为假设的标准描述性模板,用该描述性模板来描述某个事件的发生,然后用不同的候选事件类型填充该模板生成多个假设。在本实施例中,我们构建事件类型-假设描述性模板,该模板通过直观的描述性语言来表达具有丰富语义信息的特定事件类型标签,从而使文本和标签通过语义关系连接起来。事件类型-假设描述性模板是连接文本与事件类型的桥梁,在该模板中填入正确的候选事件生成正例假设(正例假设用1表示),填入错误的候选事件则生成负例假设(负例假设用0表示),因此一条样本可以生成一系列假设,以使得自然推理模型可以在生成的大量假设中学习到用于推理的知识。这是因为,利用事件类型-假设描述性模板构造假设起到数据扩充的作用,另外,文本和标签通过语义连接能够更高效的利用后续的预训练语言模型里的潜在知识(预训练模型蕴含丰富的语义信息)。

69.参见图2,本实施例的事件类型-假设描述性模板被设计为

‘

this sentence describes_’,模板将候选事件类型描述为假设,样本的正例假设之一为

‘

this sentence describes life:die’,负例假设之一是

‘

this sentence describes life:divorce’。一条文本可以不属于任何一种事件类型,因此可以生成最少0个正例假设和最多n个负例假设,其中,n是事件类型的总数量。

70.s2、将待检测文本作为前提,并将所述前提分别和各个所述假设拼接后输入自然语言推理模型中,推理所述前提和所述假设是否满足蕴含关系。

71.在经过上述s1步骤后,获得多个正例假设负例假设,而这些正例假设将全部用于自然语言推理模型的训练,多少负例假设被用于训练自然语言推理模型才能获得最好的结果将通过实验验证。具体的,我们将待检测文本作为前提,然后分别和生成的假设拼接后一起输入自然语言推理模型中,推理前提和假设是否满足蕴含关系,并计算每一对前提和假设满足蕴含关系的概率。

72.本实施例的自然语言推理(natural language inference,nli)模型的结构如图3所示,模型主要由以下层构成:

73.embedding layer(嵌入层):给定输入文本,使用预训练语言模型robertalarge获

得输入文本内各单词的向量化表示。输入的文本由前提和假设拼接而成,记为(x1,x2...x

t

),每个单词经过embedding layer后映射为对应的词向量(e1,e2...e

t

),这些词向量按照时间顺序依次传入bi-lstm中。

74.bi-lstm layer:使用bi-directional lstm network,因为它可以利用文章的上下文信息。bi-lstm其实是按照时间步骤,将单词对应的词向量从前向后传递一遍,再从后向前传递一遍,因此每个时间步骤对应着2个输出的隐状态向量。将这两个向量进行拼接,作为对应的输出hi。这样的前后向设计能够让每个时刻输出的向量既包含了左边序列的信息,又包含了右边序列的信息。与单向lstm比较,可以获取更加全面的语义信息。

75.attentionlayer:注意力机制能够让模型关注到文本中的关键部分。触发词信息对我们的模型是不可见的,因此我们使用注意力机制让模型更加关注重要的词。hi表示词向量经过bi-lstm层后第i个位置的输出,h=[h1,h2,...h

t

]表示bi-lstm输出的所有向量的矩阵。注意力层根据h计算每个单词对应的权重a和最终文本对应的语义向量c。

[0076]

outputlayer(输出层):全连接层作为输出层,根据语义向量c计算前提和假设满足蕴含关系的得分,再通过softmax函数将得分转化为概率。

[0077]

s3、输出和所述前提满足蕴含关系的所述假设所对应的事件类型作为待检测文本所属的事件类型。

[0078]

本实施例中的nli模型是一个二分类模型。在训练nli模型阶段,我们使用全部的正例假设和部分随机选取的负例假设来训练推理模型。但是在模型的评估和预测阶段所有假设都会被推理,然后将推理的结果整合到一起作为sentence的最终预测结果。

[0079]

经过s2步骤中nli模型推理之后,输出每一对前提和假设满足蕴含关系时前提和假设的蕴含概率,然后将前提和假设的蕴含概率超过一定阈值时,该假设所对应的事件类型作为待检测文本所属的事件类型。

[0080]

阈值的选取根据实际需要进行设置,所以本实施例支持多事件类型抽取,即一个文本中同时可描述多种事件的发生。实现方法是:在推理阶段,前提和每一个假设独立进行推理,可能出现一个前提和多个假设满足蕴含关系的情况,因此推理结果可以包含多事件类型。

[0081]

至此,则完成了本实施例一种基于文本蕴含的无触发词文本事件检测方法的全部流程。

[0082]

为了验证本实施例中基于文本蕴含的无触发词文本事件检测方法的有效性,我们将本实施例的方法以及该方法涉及的模型与其他经典的,以及最新的事件检测方法在ace数据集上进行了实验对比。

[0083]

数据集和评价指标。我们使用automatic content extraction(ace)2005corpus中的英文数据集进行实验。本数据集中包含实体,关系,事件等信息,事件信息中包含触发词,论元等信息。因为本实施例的方法是不需要触发词就能实现事件类型的识别,因此我们在数据集中删除了触发词注释等额外信息,保留了sentence和目标事件类型。另外,如果一个句子中包含多种事件类型,我们保留所有事件类型;如果一个句子包含多个同类型事件,我们保留一个事件类型标签。不属于任何事件类型的句子依然保留。

[0084]

我们将数据集划分为529/30/40分别用于训练,验证和评估,并使用micro f1 score作为评价指标。

[0085]

实验参数设定。在实验中,使用adam优化器,学习率为1e-5,模型训练时对前10%steps使用warmup策略。bi-lstm隐层状态的维数设置为128,dropout设置为0.5,batch_size为36,随机种子设置为42。训练期间根据模型在验证集的表现选择最优模型。

[0086]

基线模型。用于实验的现有技术和模型如下:

[0087]

dmcnn建立了动态多池化卷积模型;

[0088]

dbrnn利用文档级别的信息增强ed;

[0089]

jmee使用注意力机制增强gcn模型用于事件检测;

[0090]

tbnnam进行无触发词事件抽取;

[0091]

eeqa将事件检测转化为问答任务;

[0092]

gatedgcn基于句法依赖图和图卷积网络实现事件检测;

[0093]

ekd使用外部知识库增强事件检测;

[0094]

lear独立编码文本和标签注释,并将标签知识明确集成到文本表示中。

[0095]

结果和分析。

[0096]

a、验证本实施例的方法在为了简化数据标注而放弃触发词信息时方法的有效性。

[0097]

将本实施例提出的方法和基线模型在ace数据集上进行事件检测的结果进行对比,比较的指标为micro f1,precision和recall得分。

[0098]

表1不同模型在使用、不使用触发词和外部知识时的有效性对比

[0099][0100]

参见表1,可知,我们根据是否使用触发词信息和其他外部知识将已有方法分为三组,加粗的数据是组内的最佳结果。经过对比,结果如下:

[0101]

(1)第一组模型除了使用了触发器信息外还使用了其他额外的信息,包括外部知识和语法依赖图等。lear是目前得分最高的模型,取得了81.61的最高f1值得分。第一组模型的f1值得分比我们方法的要高,这是因为这些模型学习了触发词信息和外部信息中的有助于完成事件检测任务的知识,而这些知识对我们的模型却是不可见的。

[0102]

(2)第二组模型使用触发信息进行训练。从表中可以看出,我们提出的方法的f1分数高于第二组的方法,尽管这些方法可以学习我们模型看不到的触发词信息。

[0103]

(3)第三组模型既不使用触发信息也不使用其他外部知识,我们的模型优于比较

tbnnam模型。数据标注的难度限制了事件检测的发展,放弃使用触发词让数据标注更容易。在表中我们还提供了使用不同预训练语言模型的实验结果,使用robertalarge的f1得分比使用robertabase高2.65,这表明该方法受益于更大的和表示能力更强的预训练语言模型。

[0104]

总得来说,我们提出的方法为了简化数据标注而放弃了触发词信息,但方法是有效的。

[0105]

b、验证本实施例的方法和多标签分类方式在不同数量的训练数据场景下的对比结果。

[0106]

表2本方法与基于多标签分类的方法在使用不同规模的训练数据时的比较结果

[0107]

trainsplitmethodsprecisionrecallffulltrainingmc71.0969.3070.05 te(ours)72.2278.5075.1450%mc55.9250.3052.93 te(ours)61.8578.3869.1310%mc51.0425.7033.66 te(ours)63.5273.5468.16

[0108]

我们将训练集数据切分为不同数量(100%,50%,10%),为了测试我们的方法在不同规模训练数据的情况下的性能。如表2示, mc代表基于多标签分类的模型,ec代表基于文本蕴含的模型。在数据充足的情况下,我们的模型比基于多标签分类的模型f1分数更高5.05。在使用50%和10%训练数据的场景下,训练数据稀缺对mc模型的影响非常明显,mc模型的f1分数分别是52.93和33.66,文本蕴含的模型f1分数分别是69.13和68.16.当训练数据量从50%下降到10%,基于文本蕴含的方法f1得分仅仅下降大约1,表明我们提出的方法可以非常有效缓解训练数据稀缺带来的负面影响,这是因为:)在将ed任务转化为蕴含任务的过程中,从小规模的训练数据中生成了大量的假设,模型可以在这些大量的假设中学习到用于推理的知识,(2)用于构造文本蕴含的描述性模板将文本和label自然的连接在一起,使二者在语义上有了关联,更有效的利用了预训练模型的语义表示能力。

[0109]

考虑到我们方法在数据量较小的情况下表现优异,下面我们在训练数据极度缺乏的情况下进行实验。

[0110]

c、验证本实施例的方法在数据极度缺乏的场景下的表现。

[0111]

表3本实施例方法在数据极度缺乏的场景下的表现

[0112]

settingsmodelf11-shotlear30.23 nli

roberta-large

(ours)51.505-shotlear63.52 nli

roberta-large

(ours)61.06

[0113]

为了评估我们的方法在数据极度缺乏的场景下的表现,我们在1-shot和5-shot场景下进行了实验。我们引入目前最优模型lear作为对比模型。我们的数据处理方法和对比工作保持一致,对于1-shot,我们为每个类别选择一个样本作为训练集,5-shot的设置是类似的。参见表3,表3呈现了实验的结果,尽管对比模型引入了先验知识增强文本表示,模型的可见信息比我们方法更多,我们的方法依然表现出优异的性能。我们的模型在5-shot情

况下比对比方法f1得分低2.46,但是在1-shot情况下比对比模型高出21.27。

[0114]

d、验证本实施例的方法在解决长尾问题时的有效性。

[0115]

大多数事件检测工作的评估侧重于micro f1分数。由于事件类型的长尾分布,micro f1分数通常由频繁事件类型主导。为了验证本实施例的方法能够更好的解决长尾问题,通过以下实验加以证明。

[0116]

表4本实施例的方法对于两个类别标签的预测结果

[0117][0118]

在ace2005数据集中,有一些标签数量很少,甚至不足十个,有的标签标注了超过五百个。考虑到我们方法在数据极度缺少的情况下表现很好,我们设计了实验测试模型对训练集中的低频标签的预测能力。根据训练集中标签出现的频率,我们将标签分成两类:sparsely-labeled和densely-labeled。sparsely-labeled代表标签出现频率低于50,densely-labeled代表标签出现频率高于150。参见表4,为不同模型对于两个类别标签的预测结果,可以看到在sparsely-labeled和densely-labeled两种设置下我们模型的性能相差3.27,而对比模型的性能相差6.66,这意味着我们的方法面对低频和高频标签时的预测性能波动更小,有利于解决长尾问题。

[0119]

实施例2:

[0120]

第二方面,本发明还提供了一种基于文本蕴含的无触发词文本事件检测系统,该系统包括:

[0121]

事件类型-假设描述模块,用于在构建事件类型-假设描述性模板后,基于所述事件类型-假设描述性模板将待检测文本的候选事件类型描述为多个不同的假设;

[0122]

前提和假设蕴含关系推理模块,用于将待检测文本作为前提,并将所述前提分别和各个所述假设拼接后输入自然语言推理模型中,推理所述前提和所述假设是否满足蕴含关系;

[0123]

事件检测结果输出模块,用于输出和所述前提满足蕴含关系的所述假设所对应的事件类型作为待检测文本所属的事件类型。

[0124]

可选的,所述假设包括正例假设和负例假设。

[0125]

可选的,所述事件类型-假设描述模块基于所述事件类型-假设描述性模板将待检测文本的候选事件类型描述为多个不同的假设包括:

[0126]

在所述事件类型-假设描述性模板中填入正确的候选事件生成正例假设,填入错误的候选事件则生成负例假设。

[0127]

可选的,所述自然语言推理模型包括:

[0128]

按照数据输入至输出的先后顺序逐一分布的嵌入层、bi-lstm layer、注意力机制,以及输出层;

[0129]

其中,

[0130]

所述嵌入层用于将由前提和假设拼接而成的输入文本转化为向量;

[0131]

所述bi-lstm layer用于将由嵌入层输入的向量进行前向、后向学习,并将经过前

向、后向学习的向量拼接为一个向量;

[0132]

所述注意力机制用于计算bi-lstm layer输出的所有向量的矩阵中每个单词对应的权重和最终文本对应的语义向量;

[0133]

所述输出层根据语义向量计算前提和假设满足蕴含关系的得分并将得分转化为概率。

[0134]

可选的,所述事件检测结果输出模块输出和所述前提满足蕴含关系的所述假设所对应的事件类型作为待检测文本所属的事件类型包括:

[0135]

输出每一对前提和假设满足蕴含关系时前提和假设的蕴含概率,然后将前提和假设的蕴含概率超过一定阈值时,该假设所对应的事件类型作为待检测文本所属的事件类型;

[0136]

所述阈值根据单事件类型抽取和多事件类型抽取的需要进行设定。

[0137]

可理解的是,本发明实施例提供的基于文本蕴含的无触发词文本事件检测系统与上述基于文本蕴含的无触发词文本事件检测方法相对应,其有关内容的解释、举例、有益效果等部分可以参照基于文本蕴含的无触发词文本事件检测方法中的相应内容,此处不再赘述。

[0138]

综上所述,与现有技术相比,具备以下有益效果:

[0139]

1、本发明首先通过构建事件类型-假设描述性模板,将待检测文本的候选事件类型描述为假设;然后将待检测文本作为前提,并将该前提分别和上述各个假设拼接后输入自然语言推理模型中推理前提和各个假设间是否满足蕴含关系;最后输出和前提满足蕴含关系的假设所对应的事件类型即为待检测文本所属的事件类型。本发明可在小数据集的情况下实现事件类型的精准检测,降低了事件检测技术对样本数据质量和数量方面的依赖性。

[0140]

2、本发明构建的事件类型-假设描述性模板,可通过直观的描述性语言来表达具有丰富语义信息的特定事件类型标签,从而使文本和标签通过语义关系连接起来,通过该模板将填入的正确候选事件生成正例假设,将填入的错误候选事件生成负例假设,从而使得一条样本可以生成一系列假设,起到数据扩充的作用,以使得自然推理模型可以在生成的大量假设中学习到用于推理的知识;此外,将文本和标签通过语义连接能够更高效的利用预训练语言模型里的潜在知识,从而间接使得最终的事件类型检测结果更加精准。

[0141]

3、本发明利用自然语言推理模型推理前提和假设是否满足蕴含关系,并计算每一对前提和假设满足蕴含关系的概率,可以更为精准的检测到事件类型。

[0142]

4、本发明在进行事件检测时,可根据实际需要设置阈值,并将满足前提和假设的蕴含概率超过一定阈值时该假设所对应的多个事件类型作为待检测文本所属的事件类型输出,从而可以实现多事件类型的抽取,即检测一个文本中同时描述多种事件的发生。

[0143]

需要说明的是,在本文中,诸如第一和第二等之类的关系术语仅仅用来将一个实体或者操作与另一个实体或操作区分开来,而不一定要求或者暗示这些实体或操作之间存在任何这种实际的关系或者顺序。而且,术语“包括”、“包含”或者其任何其他变体意在涵盖非排他性的包含,从而使得包括一系列要素的过程、方法、物品或者设备不仅包括那些要素,而且还包括没有明确列出的其他要素,或者是还包括为这种过程、方法、物品或者设备所固有的要素。在没有更多限制的情况下,由语句“包括一个

……”

限定的要素,并不排除在

包括所述要素的过程、方法、物品或者设备中还存在另外的相同要素。

[0144]

以上实施例仅用以说明本发明的技术方案,而非对其限制;尽管参照前述实施例对本发明进行了详细的说明,本领域的普通技术人员应当理解:其依然可以对前述各实施例所记载的技术方案进行修改,或者对其中部分技术特征进行等同替换;而这些修改或者替换,并不使相应技术方案的本质脱离本发明各实施例技术方案的精神和范围。

- 该技术已申请专利。仅供学习研究,如用于商业用途,请联系技术所有人。

- 技术研发人员:安春燕 张延

- 技术所有人:内蒙古大学

- 我是此专利的发明人

- 该领域下的技术专家

- 如您需求助技术专家,请点此查看客服电话进行咨询。

- 1、李老师:1.计算力学 2.无损检测

- 2、毕老师:机构动力学与控制

- 3、袁老师:1.计算机视觉 2.无线网络及物联网

- 4、王老师:1.计算机网络安全 2.计算机仿真技术

- 5、王老师:1.网络安全;物联网安全 、大数据安全 2.安全态势感知、舆情分析和控制 3.区块链及应用

- 如您是高校老师,可以点此联系我们加入专家库。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1

精彩留言,会给你点赞!

专利分类正在加载中....