一种基于深度学习的虚拟试衣系统

1.本发明属于人工智能领域,具体涉及一种基于深度学习的虚拟试衣系统。

背景技术:

2.虚拟试穿是实现用户不用脱去身上衣服,实现变装察看效果的一种技术应用。现有技术中公开了一些相关虚拟试穿技术:如申请号202210564865.5的中国专利申请文件“基于深度学习的服装设计方法、装置、设备及存傅介质”中,使用决策树来提取风格特征,使用分割来提取衣服的颜色和纹理等信息。然后,该种方法在提取准确性上稍有不足。又如申请号202211006799.6的中国专利申请文件“一种基于深度学习的民族服装设计方法”,针对民族特色服饰进行风格、结构的迁移设计,采用标签对迁移进行参考和指导。又如申请号202210568501.4的中国专利申请文件“基于循环三级变换的全方位虚拟试穿方法、系统及介质”,采用三级变换语义生成算法来获得语义布局结构。又如申请号202210556717.9的中国专利申请文件“虚拟试穿方法及其系统、和提供虚拟试穿信息方法”,以激光雷达的方式获取人体的轮廓和区域信息,并设定多个子区域来完成服装合成。然而,现有技术并没有在图片处理上,通过试穿者的穿衣图片作为输入图片,底板,利用风格参考来生成统一风格的风格迁移结果,并通过式样控制字进一步编辑生成结果,形成最终的风格可迁移、式样可编辑的虚拟试衣系统,当前,随着深度学习逐步发展,通过机器学习方法实现上述目的成为可能。

技术实现要素:

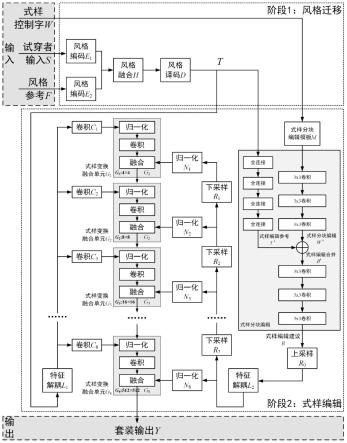

3.为了解决通过机器学习方法实现虚拟试穿的问题,根据本技术一些实施例的基于深度学习的虚拟试衣系统,包括

4.风格迁移模块,输出图片的风格迁移特征;

5.式样编辑模块,根据所述图片的风格迁移特征和式样控制字,获取式样编辑分块建议特征,并根据式样编辑分块建议特征获取虚拟试衣图片。

6.根据本技术一些实施例的基于深度学习的虚拟试衣系统,所述风格迁移模块包括

7.风格编码器e1,所述风格编码器e1的输入是试穿者输入图片;

8.风格编码器e2,所述风格编码器e2的输入是风格参考图片;

9.风格融合器h,包括第一输入端和第二输入端,所述风格编码器e1的输出与风格融合器h的第一输入连接,所述风格编码器e2的输出与风格融合器h的第二输入连接;

10.风格译码器d,所述风格融合器h的输出与所述风格译码器d的输入连接,所述风格译码器d输出图片的风格迁移特征。

11.根据本技术一些实施例的基于深度学习的虚拟试衣系统,所述式样编辑模块包括

12.式样分块编辑单元,用于根据所述图片的风格迁移特征和式样控制字,获取式样编辑分块建议特征;

13.上采样单元r0,对所述式样编辑分块建议特征进行上采样;

14.特征解耦单元l2,对上采样后的特征进行解耦;

15.下采样单元,对解耦后的特征上进行采样;

16.归一化单元,对归一化的特征进行归一化;

17.特征解耦单元l1,对图片的风格迁移特征进行解耦;

18.卷积,对解耦后的特征进行卷积;

19.式样变换融合单元,将卷积后的特征归一化及卷积,并将卷积后的特征与所述归一化单元归一化后的特征融合,得到输出图像。

20.根据本技术一些实施例的基于深度学习的虚拟试衣系统,所述式样分块编辑单元,包括三层卷积组成的第一卷积神经网络,每层为3

×

3卷积核;

21.四层全连接层组成的全连接网络,每层为1

×

1卷积核;

22.三层卷积组成的第二卷积神经网络,每层为3

×

3卷积核。

23.根据本技术一些实施例的基于深度学习的虚拟试衣系统,式样变换融合单元包括归一化单元、卷积单元以及融合单元;

24.所述下采样单元包括下采样单元r1~r7;

25.所述归一化单元包括归一化单元n1~n8;

26.所述式样变换融合单元包括式样变换融合单元g1~g8;

27.所述卷积包括卷积c1~c8。

28.根据本技术一些实施例的基于深度学习的虚拟试衣系统,上采样单元输入是分块建议特征,上采样单元r0与特征解耦单元l2的输入连接,所述特征解耦单元l2的输出与归一化单元n8的输入和下采样单元r7的输入分别连接,所述下采样单元r7的输出与归一化单元n7和下采样单元r6的输入分别连接,所述下采样单元r6的输出与归一化单元n6和下采样单元r5的输入分别连接,所述下采样单元r5的输出与归一化单元n5和下采样单元r4的输入分别连接,所述下采样单元r4的输出与归一化单元n4和下采样单元r3的输入分别连接,所述下采样单元r3的输出与归一化单元n3和下采样单元r2的输入分别连接,所述下采样单元r2的输出与归一化单元n2和下采样单元r1的输入分别连接,所述下采样单元r1的输出与归一化单元n1输入连接;

29.特征解耦单元l1的输入是图片的风格迁移特征,特征解耦单元l1与卷积c1的输入、卷积c2的输入、卷积c3的输入、卷积c4的输入、卷积c5的输入、卷积c6的输入、卷积c7的输入以及卷积c8的输入并行连接。

30.根据本技术一些实施例的基于深度学习的虚拟试衣系统,所述卷积c1与式样变换融合单元g1的归一化层的输入连接,所述式样变换融合单元g1的归一化层的输出与所述式样变换融合单元g1的卷积层的输入连接,所述式样变换融合单元g1的卷积层的输出与所述式样变换融合单元g1的融合层的第一输入连接,所述归一化层n1的输出与所述式样变换融合单元g1的融合层的第二输入连接,所述式样变换融合单元g1的融合层的输出与式样变换融合单元g2的归一化层的第一输入连接;

31.所述卷积c2与式样变换融合单元g2的归一化层的第二输入连接,所述式样变换融合单元g2的归一化层的输出与所述式样变换融合单元g2的卷积层的输入连接,所述式样变换融合单元g2的卷积层的输出与所述式样变换融合单元g2的融合层的第一输入连接,所述归一化层n2的输出与所述式样变换融合单元g2的融合层的第二输入连接,所述式样变换融

合单元g2的融合层的输出与式样变换融合单元g3的归一化层的第一输入连接;

32.所述卷积c3与式样变换融合单元g3的归一化层的第二输入连接,所述式样变换融合单元g3的归一化层的输出与所述式样变换融合单元g3的卷积层的输入连接,所述式样变换融合单元g3的卷积层的输出与所述式样变换融合单元g3的融合层的第一输入连接,所述归一化层n3的输出与所述式样变换融合单元g3的融合层的第二输入连接,所述式样变换融合单元g3的融合层的输出与式样变换融合单元g4的归一化层的第一输入连接;

33.所述卷积c4与式样变换融合单元g4的归一化层的第二输入连接,所述式样变换融合单元g4的归一化层的输出与所述式样变换融合单元g4的卷积层的输入连接,所述式样变换融合单元g4的卷积层的输出与所述式样变换融合单元g4的融合层的第一输入连接,所述归一化层n4的输出与所述式样变换融合单元g4的融合层的第二输入连接,所述式样变换融合单元g4的融合层的输出与式样变换融合单元g5的归一化层的第一输入连接;

34.所述卷积c5与式样变换融合单元g5的归一化层的第二输入连接,所述式样变换融合单元g5的归一化层的输出与所述式样变换融合单元g5的卷积层的输入连接,所述式样变换融合单元g5的卷积层的输出与所述式样变换融合单元g5的融合层的第一输入连接,所述归一化层n5的输出与所述式样变换融合单元g5的融合层的第二输入连接,所述式样变换融合单元g5的融合层的输出与式样变换融合单元g6的归一化层的第一输入连接;

35.所述卷积c6与式样变换融合单元g6的归一化层的第二输入连接,所述式样变换融合单元g6的归一化层的输出与所述式样变换融合单元g6的卷积层的输入连接,所述式样变换融合单元g6的卷积层的输出与所述式样变换融合单元g6的融合层的第一输入连接,所述归一化层n6的输出与所述式样变换融合单元g6的融合层的第二输入连接,所述式样变换融合单元g6的融合层的输出与式样变换融合单元g7的归一化层的第一输入连接;

36.所述卷积c7与式样变换融合单元g7的归一化层的第二输入连接,所述式样变换融合单元g7的归一化层的输出与所述式样变换融合单元g7的卷积层的输入连接,所述式样变换融合单元g7的卷积层的输出与所述式样变换融合单元g7的融合层的第一输入连接,所述归一化层n7的输出与所述式样变换融合单元g7的融合层的第二输入连接,所述式样变换融合单元g7的融合层的输出与式样变换融合单元g8的归一化层的第一输入连接;

37.所述卷积c8与式样变换融合单元g8的归一化层的第二输入连接,所述式样变换融合单元g8的归一化层的输出与所述式样变换融合单元g8的卷积层的输入连接,所述式样变换融合单元g8的卷积层的输出与所述式样变换融合单元g8的融合层的第一输入连接,所述归一化层n8的输出与所述式样变换融合单元g8的融合层的第二输入连接,所述式样变换融合单元g8的融合层的输出是所述输出图像。

38.根据本技术一些实施例的基于深度学习的虚拟试衣系统,风格融合器h输出的风格融合后的结果h(e1(s),e2(f))

[0039][0040]

其中,σ()函数为求取均值操作,μ()函数为计算标准差操作,∈为任意正小数,风格编码器e1输出的风格编码结果e1(s),风格编码器e2输出的风格编码结果e2(f);

[0041]

风格译码器d输出图片的风格迁移特征t

[0042]

t=d(h(e1(s),e2(f)))。

[0043]

根据本技术一些实施例的基于深度学习的虚拟试衣系统,式样编辑合并b

′

[0044]b′

=t

′

+w

′

[0045]

其中:式样分块编辑w

′

,式样编辑参考t

′

;

[0046]

式样编辑合并b

′

输入三层卷积组成的第二卷积神经网络,每层为3

×

3卷积核,输出为所述式样编辑分块建议特征b。

[0047]

根据本技术一些实施例的基于深度学习的虚拟试衣系统,y表示输出图片,其中:

[0048]

g1=g1(c1(l1(t)),n1(r1(r2(...r8(l2(b))))))

[0049]

g2=g2(c2(l1(q2)),n2(r2(r3(...r8(l2(b))))))

[0050]

g3=g3(c3(l1(q3)),n3(r3(r4(...r8(l2(b))))))

[0051]

g4=g4(c4(l1(q4)),n4(r4(r5(...r8(l2(b))))))

[0052]

g5=g5(c5(l1(q5)),n5(r5(r6(...r8(l2(b))))))

[0053]

g6=g6(c6(l1(q6)),n6(r6(r7(r8(l2(b))))))

[0054]

g7=g7(c7(l1(q7)),n7(r7(r8(l2(b)))))

[0055]

y=g8=g8(c8(l1(q8)),n8(r8(l2(b))))。

[0056]

有益效果:在本发明所述的系统中,本发明使用了基于卷积神经网络编码解码器来提取纹理特征,使用了融合器以概率融合方式来合成新的风格特征。本发明使用试穿者图片作为底板,利用风格参考来生成统一风格的风格迁移结果,并通过式样控制字进一步编辑生成结果,形成最终的套装输出。本发明的解决风格和式样的分阶段参考问题,重点解决了自定义套装式样编辑问题。本发明衣着分块及其衣着子块的存在,能够更精准地编辑衣着的式样结果。

[0057]

(1)适用于虚拟试穿的衣着整体或部分更换应用:本发明整体系统可以完成单人的套装虚拟试穿应用,同时,以腰部为衣着界线,对上衣或者下衣单独进行虚拟试穿,完成衣着整体或者部分更换。

[0058]

(2)适用于虚拟试穿中套装衣服的更换和编辑应用:本发明可以完成虚拟试穿中套装衣服的更换应用,且该套装能够保持风格纹理一致性。更进一步,式样还可以根据输入式样控制字对其进行样式、款式的编辑修改,形成定制虚拟试穿套装衣服的结果。

[0059]

(3)适用于视频平台主播的衣着更换应用:本发明可以为视频平台的主播在节目中,随时更换衣服使用。同样可以成为各类短视频的插件,完成更换衣服的娱乐目的。

[0060]

(4)适用于购物平台服装搭配的衣着更换应用:本发明可以为购物平台的服装搭配提供衣着更换操作,方便用户自己观察要买的衣服穿搭后的效果,从而为购买衣服提供直观的可视化辅助功能。

附图说明

[0061]

图1是发明整体框架示意图;

[0062]

图2是式样控制字与衣着分开编辑模板的对应关系图;

[0063]

图3是式样信息提取网络;

[0064]

图4是实施例1中风格迁移情况示意图;

[0065]

图5是实施例2中式样编辑示意图;

[0066]

图6是实施例3中套装生成示意图。

具体实施方式

[0067]

下面通过参考附图详细描述本技术的实施例,所述实施例的示例在附图中示出。

[0068]

1.本发明技术名词约定:

[0069]

(1)待虚拟试穿者:虚拟试穿的服务对象,即为本发明中涉及的套装试穿主体人物目标。

[0070]

(2)待虚拟试穿参考模特:虚拟试穿的参考人物对象和服装对象,即为本发明中,为待虚拟试穿者提供参考虚拟试穿衣服的模特或服装图像信息。

[0071]

(3)上衣:上半身着装,即上身穿的服装统称。

[0072]

(4)下衣:下半身着装,即下身穿的服装统称。

[0073]

(5)风格特征:衣着服装的色彩纹理、布料材质等非结构性特征信息的总称。

[0074]

(6)式样特征:通过计算机视觉技术计算出的虚拟试穿服装,特指服装的外观、轮廓、剪裁、造型等非色彩和纹理部分的结构性特征。

[0075]

(7)虚拟试穿:通过计算机软件算法辅助,将人物的半身或者全身照片作为模板,将其他照片中的衣着服装迁移到当前人物身上,无需人物亲自试穿衣服,仅利用计算机视觉技术为人物进行衣着更换,实现可视化虚拟条件下的试穿效果。

[0076]

(8)试穿者:一般为虚拟生成结果的试穿对象,作为系统的目标出现,一切生成的衣服最终都要在这个输入的试穿者身上进行服装展示。

[0077]

(9)风格参考:风格的参考,为1张图片,负责为试穿者提供色彩、纹理等参考信息。

[0078]

(10)式样控制字:式样控制字目的是为编辑套装提供必要的编辑需求。包括:领子、袖子、长短等进行合理控制,已生成更丰富多样的套装输出结果。

[0079]

(11)衣着界线:人的着装,通常以腰部为分界线,形成上衣、下衣两部分服装,腰部附近的这个上衣、下衣着装界线,即为衣装界线。

[0080]

(12)式样分块:是为人物衣着式样分块编辑提供式样建议,以衣着界线为分水岭,上衣、下衣分别采用均一尺寸大小的16个衣着分块进行处理,共计32个衣着分块,涵盖全部人体上衣、下衣的衣着区域。

[0081]

(13)式样分块编辑模板:以衣着界线为界,上衣16个衣着分块,根据上衣的服装特点,分为随机编辑模板、领子编辑模板、袖子编辑模板、前襟编辑模板;下衣16个衣着分块,根据下衣的服装特点,分为随机编辑模板、短裤编辑模板、短裙编辑模板、长裙编辑模板、长裤编辑模板。

[0082]

(13)式样编辑建议:式样编辑建议是根据上衣16个衣着分块、下衣16个衣着分块。根据上衣的领子、袖子、前襟,下衣的短裤、短裙、长裙、长裤来进行式样编辑建议。建议结果,分为式样自定义编辑区和式样随机编辑区两部分。

[0083]

(14)风格迁移:将一幅服装图片中的衣着风格等色彩纹理,包含上衣、下衣的一个或者两者同时,通过算法变换到另一幅图像中的人物模特身体上,这种衣着服装,从一幅图像变换到另一幅图像的过程,称之为风格迁移。

[0084]

(15)式样编辑:将一幅服装参考图片中的衣服式样等外观样式,包含上衣或者下衣的其中一个,通过算法变换到另一幅待迁移图像中的人物模特身体上。式样迁移,只保留

了衣服的结构性框架信息,而不包含衣服的材质和纹理信息。

[0085]

(16)双阶段:第一阶段为下衣和上衣的风格迁移,第二阶段为下衣和上衣的式样迁移。

[0086]

(17)套装:与非套装相比,套装的主要特征为,上衣、下衣通过风格参考生成具有风格一致性的一组(或一件)服装。该套装既可以分为上衣、下衣两部分服装,也可以是一件独立的服装。

[0087]

(18)搭配:式样和风格上协调统一的套装,给人整体上大方、得体的观感。

[0088]

(19)套装生成:经双阶段联合生成计算后,形成具有一定搭配关联的套装生成输出结果。

[0089]

2.技术方案

[0090]

虚拟试穿是一种利用计算机视觉算法,在计算机图像处理手段的支持下,为试穿者更换不同衣服的虚拟技术。可以无需试穿者前往实体店面,利用互联网来实现远程试穿衣服的目的。虽然达不到真人亲自去试穿的实际效果,但是对于网络购物盛行的今天,这种技术可以在购买衣服前,通过视觉感官获取自己穿着此件衣服后的虚拟效果,切身感受试穿后的搭配程度,为购买商品和选购提供必要的直观的、可视化的辅助。在处理虚拟试穿方向上的研究与应用角度看,几乎都采用了风格和款式分别进行处理的一般性常用处理手段,区别在于各自采用的深度学习网络不同,生成的虚拟试穿结果也会因此而产生差异。同时,在目前文献中,对于成套服装的编辑问题,基本上从大数据分析的角度给出搭配建议,而急需解决以虚拟试穿的可视化方式给出并编辑出合适的搭配结果,且具有统一材质面料的、风格统一的套装输出。

[0091]

本发明的是技术方案是利用双阶段方式,逐步完成套装服装的风格与式样生成的方法。旨在利用深度学习网络架构,对风格参考和式样参考图片进行特征解耦处理,以待虚拟试穿参考模特身上的衣服结构为借鉴,以风格参考图片的色彩纹理信息为依据,为待虚拟试穿者,提供套装生成虚拟试穿结果的方法。该方法分为两个计算阶段,试穿者输入s图片、风格参考f图片为色彩纹理参考和式样控制字w管理套装式样编辑需求,各自经特征解耦计算后,将风格参考f的均值和标准差,与试穿者s的特征进行概率方式融合,得到第一阶段的风格迁移结果;第二阶段,则利用第一阶段得到的风格迁移结果为基础,根据式样控制字w进行式样编辑,形成统一风格的套装结果输出。

[0092]

在一种实施例中,一种虚拟试穿中双阶段套装风格生成与式样编辑方法,包括根据试穿者输入图片,获取输入风格特征;

[0093]

根据风格参考图片,获取参考风格特征;

[0094]

将所述参考风格特征与所述输入风格特征融合,获取图片的风格迁移特征;

[0095]

根据所述图片的风格迁移特征,获取式样编辑参考;

[0096]

根据式样控制字获取所述样控制字对应的式样分块编辑模板;

[0097]

根据所述式样分块编辑模板获取式样分块编辑,所述式样分块编辑包括对应的式样分块编辑模板的式样自定义编辑区域和式样保持区域;

[0098]

将所述式样编辑参考与所述取式样分块编辑进行特征融合,得到式样编辑分块建议特征;

[0099]

将所述式样编辑分块建议特征与所述试穿者输入图片的风格迁移特征进行特征

融合,得到输出图像。

[0100]

在进一步的方式中,式样控制字包括上衣高位数及下衣低位数,所述上衣高位数的数字对应上衣模板中的一个编辑模板,所述下衣低位数的数字对应下衣模板中的一个编辑模板。

[0101]

在进一步的方式中,所述上衣模板包括随机编辑模板、领子编辑模板、袖子编辑模板、前襟编辑模板;所述下衣模板包括随机编辑模板、短裤编辑模板、短裙编辑模板、长裙编辑模板、长裤编辑模板。

[0102]

在进一步的方式中,所述对应的式样分块编辑模板的式样自定义编辑区域根据模板所规定的编辑区域进行式样生成操作,所述操作通过所述式样编辑网络进行,其中,式样编辑网络包括

[0103]

编码网络,所述编码网络包括3层卷积神经网络,卷积核分别为1

×

1、3

×

3和1

×

1;

[0104]

融合网络,所述译码网络包括3层卷积神经网,卷积核分别为1

×

1、3

×

3和1

×

1;

[0105]

译码网络,所述络融合网络包括4层全连接网络,卷积核均为1

×

1。

[0106]

在进一步的方式中,所述样控制字对应的式样分块编辑模板输入3层卷积组成的第一卷积神经网络,每层为3

×

3卷积核,所述第一卷积神经网络输出式样分块编辑;

[0107]

所述图片的风格迁移特征输入4层全连接层组成的全连接网络,每层为1

×

1卷积核,所述全连接网络输出式样编辑参考;

[0108]

所述式样编辑参考与所述取式样分块编辑进行特征融合所得式样编辑合并,所述式样编辑合并输入3层卷积组成的第二卷积神经网络,每层为3

×

3卷积核,所述第二卷积神经网络输出式样编辑分块建议特征。

[0109]

在进一步的方式中,所述步骤将所述式样编辑分块建议特征与所述试穿者输入图片的风格迁移特征进行特征融合,其中,所述进行特征融合操作由所述式样变换融合单元进行,所述式样变换融合单元包括归一化单元、卷积单元以及融合单元。

[0110]

在进一步的方式中,包括8个式样变换融合单元。

[0111]

所述方法由所述基于深度学习的虚拟试衣系统所实施,该所述系统包括风格迁移模块,输出图片的风格迁移特征;

[0112]

式样编辑模块,根据所述图片的风格迁移特征和式样控制字,获取式样编辑分块建议特征,并根据式样编辑分块建议特征获取虚拟试衣图片。

[0113]

在进一步的方式中,所述风格迁移模块包括

[0114]

风格编码器e1,所述风格编码器e1的输入是试穿者输入图片;

[0115]

风格编码器e2,所述风格编码器e2的输入是风格参考图片;

[0116]

风格融合器h,包括第一输入端和第二输入端,所述风格编码器e1的输出与风格融合器h的第一输入连接,所述风格编码器e2的输出与风格融合器h的第二输入连接;

[0117]

风格译码器d,所述风格融合器h的输出与所述风格译码器d的输入连接,所述风格译码器d输出图片的风格迁移特征。

[0118]

在进一步的方式中,所述式样编辑模块包括

[0119]

式样分块编辑单元,用于根据所述图片的风格迁移特征和式样控制字,获取式样编辑分块建议特征;

[0120]

上采样单元r0,对所述式样编辑分块建议特征进行上采样;

[0121]

特征解耦单元l2,对上采样后的特征进行解耦;

[0122]

下采样单元,对解耦后的特征上进行采样;

[0123]

归一化单元,对归一化的特征进行归一化;

[0124]

特征解耦单元l1,对图片的风格迁移特征进行解耦;

[0125]

卷积,对解耦后的特征进行卷积;

[0126]

式样变换融合单元,将卷积后的特征归一化及卷积,并将卷积后的特征与所述归一化单元归一化后的特征融合,得到输出图像。

[0127]

在进一步的方式中,所述式样分块编辑单元,包括

[0128]

三层卷积组成的第一卷积神经网络,每层为3

×

3卷积核;

[0129]

四层全连接层组成的全连接网络,每层为1

×

1卷积核;

[0130]

三层卷积组成的第二卷积神经网络,每层为3

×

3卷积核。

[0131]

在进一步的方式中,式样变换融合单元包括归一化单元、卷积单元以及融合单元;

[0132]

所述下采样单元包括下采样单元r1~r7;

[0133]

所述归一化单元包括归一化单元n1~n8;

[0134]

所述式样变换融合单元包括式样变换融合单元g1~g8;

[0135]

所述卷积包括卷积c1~c8。

[0136]

在进一步的方式中,上采样单元输入是分块建议特征,上采样单元r0与特征解耦单元l2的输入连接,所述特征解耦单元l2的输出与归一化单元n8的输入和下采样单元r7的输入分别连接,所述下采样单元r7的输出与归一化单元n7和下采样单元r6的输入分别连接,所述下采样单元r6的输出与归一化单元n6和下采样单元r5的输入分别连接,所述下采样单元r5的输出与归一化单元n5和下采样单元r4的输入分别连接,所述下采样单元r4的输出与归一化单元n4和下采样单元r3的输入分别连接,所述下采样单元r3的输出与归一化单元n3和下采样单元r2的输入分别连接,所述下采样单元r2的输出与归一化单元n2和下采样单元r1的输入分别连接,所述下采样单元r1的输出与归一化单元n1输入连接;

[0137]

特征解耦单元l1的输入是图片的风格迁移特征,特征解耦单元l1与卷积c1的输入、卷积c2的输入、卷积c3的输入、卷积c4的输入、卷积c5的输入、卷积c6的输入、卷积c7的输入以及卷积c8的输入并行连接。

[0138]

在进一步的方式中,所述卷积c1与式样变换融合单元g1的归一化层的输入连接,所述式样变换融合单元g1的归一化层的输出与所述式样变换融合单元g1的卷积层的输入连接,所述式样变换融合单元g1的卷积层的输出与所述式样变换融合单元g1的融合层的第一输入连接,所述归一化层n1的输出与所述式样变换融合单元g1的融合层的第二输入连接,所述式样变换融合单元g1的融合层的输出与式样变换融合单元g2的归一化层的第一输入连接;

[0139]

所述卷积c2与式样变换融合单元g2的归一化层的第二输入连接,所述式样变换融合单元g2的归一化层的输出与所述式样变换融合单元g2的卷积层的输入连接,所述式样变换融合单元g2的卷积层的输出与所述式样变换融合单元g2的融合层的第一输入连接,所述归一化层n2的输出与所述式样变换融合单元g2的融合层的第二输入连接,所述式样变换融合单元g2的融合层的输出与式样变换融合单元g3的归一化层的第一输入连接;

[0140]

所述卷积c3与式样变换融合单元g3的归一化层的第二输入连接,所述式样变换融

合单元g3的归一化层的输出与所述式样变换融合单元g3的卷积层的输入连接,所述式样变换融合单元g3的卷积层的输出与所述式样变换融合单元g3的融合层的第一输入连接,所述归一化层n3的输出与所述式样变换融合单元g3的融合层的第二输入连接,所述式样变换融合单元g3的融合层的输出与式样变换融合单元g4的归一化层的第一输入连接;

[0141]

所述卷积c4与式样变换融合单元g4的归一化层的第二输入连接,所述式样变换融合单元g4的归一化层的输出与所述式样变换融合单元g4的卷积层的输入连接,所述式样变换融合单元g4的卷积层的输出与所述式样变换融合单元g4的融合层的第一输入连接,所述归一化层n4的输出与所述式样变换融合单元g4的融合层的第二输入连接,所述式样变换融合单元g4的融合层的输出与式样变换融合单元g5的归一化层的第一输入连接;

[0142]

所述卷积c5与式样变换融合单元g5的归一化层的第二输入连接,所述式样变换融合单元g5的归一化层的输出与所述式样变换融合单元g5的卷积层的输入连接,所述式样变换融合单元g5的卷积层的输出与所述式样变换融合单元g5的融合层的第一输入连接,所述归一化层n5的输出与所述式样变换融合单元g5的融合层的第二输入连接,所述式样变换融合单元g5的融合层的输出与式样变换融合单元g6的归一化层的第一输入连接;

[0143]

所述卷积c6与式样变换融合单元g6的归一化层的第二输入连接,所述式样变换融合单元g6的归一化层的输出与所述式样变换融合单元g6的卷积层的输入连接,所述式样变换融合单元g6的卷积层的输出与所述式样变换融合单元g6的融合层的第一输入连接,所述归一化层n6的输出与所述式样变换融合单元g6的融合层的第二输入连接,所述式样变换融合单元g6的融合层的输出与式样变换融合单元g7的归一化层的第一输入连接;

[0144]

所述卷积c7与式样变换融合单元g7的归一化层的第二输入连接,所述式样变换融合单元g7的归一化层的输出与所述式样变换融合单元g7的卷积层的输入连接,所述式样变换融合单元g7的卷积层的输出与所述式样变换融合单元g7的融合层的第一输入连接,所述归一化层n7的输出与所述式样变换融合单元g7的融合层的第二输入连接,所述式样变换融合单元g7的融合层的输出与式样变换融合单元g8的归一化层的第一输入连接;

[0145]

所述卷积c8与式样变换融合单元g8的归一化层的第二输入连接,所述式样变换融合单元g8的归一化层的输出与所述式样变换融合单元g8的卷积层的输入连接,所述式样变换融合单元g8的卷积层的输出与所述式样变换融合单元g8的融合层的第一输入连接,所述归一化层n8的输出与所述式样变换融合单元g8的融合层的第二输入连接,所述式样变换融合单元g8的融合层的输出是所述输出图像。

[0146]

在进一步的方式中,风格融合器h输出的风格融合后的结果h(e1(s),e2(f))

[0147][0148]

其中,σ()函数为求取均值操作,μ()函数为计算标准差操作,∈为任意正小数,风格编码器e1输出的风格编码结果e1(s),风格编码器e2输出的风格编码结果e2(f);

[0149]

风格译码器d输出图片的风格迁移特征t

[0150]

t=d(h(e1(s),e2(f)))。

[0151]

在进一步的方式中,式样编辑合并b

′

[0152]b′

=t

′

+w

′

[0153]

其中:式样分块编辑w

′

,式样编辑参考t

′

;

[0154]

式样编辑合并b

′

输入三层卷积组成的第二卷积神经网络,每层为3

×

3卷积核,输出为所述式样编辑分块建议特征b。

[0155]

在进一步的方式中,y表示输出图片,其中:

[0156]

g1=g1(c1(l1(t)),n1(r1(r2(...r8(l2(b))))))

[0157]

g2=g2(c2(l1(q2)),n2(r2(r3(...r8(l2(b))))))

[0158]

g3=g3(c3(l1(q3)),n3(r3(r4(...r8(l2(b))))))

[0159]

g4=g4(c4(l1(q4)),n4(r4(r5(...r8(l2(b))))))

[0160]

g5=g5(c5(l1(q5)),n5(r5(r6(...r8(l2(b))))))

[0161]

g6=g6(c6(l1(q6)),n6(r6(r7(r8(l2(b))))))

[0162]

g7=g7(c7(l1(q7)),n7(r7(r8(l2(b)))))

[0163]

y=g8=g8(c8(l1(q8)),n8(r8(l2(b))))。

[0164]

本发明正是基于这样的套装生成需求——能生成、能编辑,提出一个具有双阶段风格生成和式样编辑的套装生成深度学习神经网络。该网络针对风格统一、材质面料一致的套装生成,采用试穿者输入、风格参考、式样控制字作为系统的输入参考,将风格参考的颜色和纹理等信息施加到试穿者的衣着上,并利用式样控制字,实现最终衣着套装的编辑结果,使得该方法可以在完成风格迁移的基础上,再完成相关的式样编辑合成输出。

[0165]

为进一步理解上述实施例,本实例中将上述技术方案以数据流处理为依据,给出一个从输入到输出的处理流程说明。

[0166]

(1)整体技术方案

[0167]

该发明方案,涉及一个虚拟试穿中双阶段的套装风格生成与式样编辑方法。

[0168]

该方法的输入为试穿者输入s图片、风格参考f图片,均为图像信息。式样控制字w为控制式样的具体结构信息,为数值型变量。除输入和输出外,其核心处理环节分为两个处理模块:风格迁移模块、式样编辑模块。

[0169]

两个输入端试穿者输入s和风格参考f,一个输出端套装输出t,三者的图像分辨率尺寸,均为(3,w0,h0),其含义代表rgb图像的3通道信息红色、绿色、蓝色分量,宽度、高度分别为(w0,h0),输入图像大小和输出图像大小保持一致。

[0170]

(2)风格迁移

[0171]

风格迁移模块的主要工作是,利用风格参考f,对试穿者输入s的衣着风格进行概率变换,生成新的上衣和下衣结果。为保证风格迁移前后的衣着结构不发生变化或像素特征漂移,上衣和下衣的结构性参数保持不变,即上衣、下衣在经历风格迁移变换前后,其式样不发生改变,仅风格信息,包括颜色、纹理等发生改变。

[0172]

(3)式样分块编辑模板

[0173]

在本发明中,式样分块编辑模板,是为服装的式样迁移提供式样编辑建议,其目的是给出分块的式样编辑建议,解决衣着服装纹理和颜色的精细匹配问题。

[0174]

式样分块编辑模板,上衣对应于5个模板,下衣对应于6个模板。对模特人体图片进行均匀分块,以衣着界线为上下分界,上衣、下衣分别划分为16个区域块,称为式样分块。以衣着界线为界,上衣16个衣着分块,根据上衣的服装特点,分为保持编辑模板、领子编辑模板、袖子编辑模板、前襟编辑模板、随机编辑模板;下衣16个衣着分块,根据下衣的服装特

点,分为保持编辑模板、短裤编辑模板、短裙编辑模板、长裙编辑模板、长裤编辑模板、随机编辑模板。式样分块编辑模板,其需要自定义编辑的区域部分,与实际衣着的对应区域相一致,譬如:上衣的领子编辑模板,领子在人体的相对位置保持对应的空间关系。其中,需要编辑的部分为式样自定义编辑区域,领子之外的其他区域为式样保持区域,即该处的式样不做处理,维持原有式样形式。

[0175]

(4)式样编辑建议

[0176]

式样分块编辑模板,每个模板的式样自定义编辑区域会根据模板所规定的编辑区域进行式样生成操作。该操作由一个式样编辑网络所构成,该网络有三个模块组成,编码、融合、译码三部分卷积神经网络。其中,编码网络、译码网络均为一个3层卷积神经网络,卷积核分别为1

×

1、3

×

3和1

×

1组成;融合网络为4层全连接网络,卷积核均为1

×

1。

[0177]

编码网络输入为风格迁移的结果,融合网络一个输入是式样分块编辑模板给出的模板初始化结果,另一个输入是编码网络的风格迁移结果特征,融合后送入译码网络,得到式样编辑建议b。

[0178]

(5)式样编辑

[0179]

式样编辑模块的主要工作是,对风格迁移模块处理的结果t,与式样编辑建议b进行式样迁移处理,经过8次式样变换融合单元的计算,得到最终的套装输出结果y。

[0180]

4.约束条件

[0181]

(1)输入为试穿者输入s图片、风格参考f图片,输出为套装输出结果t,均为图像信息,均为(3,w0,h0),其中图像的宽度和高度固定,均为512像素,即w0=512,h0=512,单位为图像像素点。

[0182]

(2)式样控制字w为控制式样的具体结构信息,该控制字由上衣高位数wh、下衣低位数w

l

组成。两位数值来决定一个控制字,其中,高位数wh取值分别是(0,1,2,3,4),共5个数值,对应于上衣部分,分别为随机编辑模板、领子编辑模板、袖子编辑模板、前襟编辑模板;低位数w

l

的取值分别是(0,1,2,3,4,5),共6个数值,对应于下衣模板,分别为随机编辑模板、短裤编辑模板、短裙编辑模板、长裙编辑模板、长裤编辑模板。譬如:上衣需要编辑前襟,对应于数字3,下衣需要编辑短裙,对应于数字2,那么式样编辑控制字w=32。

[0183]

(3)式样变换融合单元,一共有8个。其中,8个式样变换融合单元的内容功能完全一致,仅处理图像的特征尺寸不同,从4

×

4、8

×

8到512

×

512,单位为图像像素点,尺寸变化规律为2n×2n

,其中n∈[2,9]。

[0184]

(3)式样分块编辑模板,上衣、下衣分别有16个区域块,共计32个分块,其尺寸为(w0/16,h0/16),单位为图像像素点。

[0185]

有益效果:

[0186]

(1)适用于虚拟试穿的衣着整体或部分更换应用:本发明整体系统可以完成单人的套装虚拟试穿应用,同时,以腰部为衣着界线,对上衣或者下衣单独进行虚拟试穿,完成衣着整体或者部分更换。

[0187]

(2)适用于虚拟试穿中套装衣服的更换和编辑应用:本发明可以完成虚拟试穿中套装衣服的更换应用,且该套装能够保持风格纹理一致性。更进一步,式样还可以根据输入式样控制字对其进行样式、款式的编辑修改,形成定制虚拟试穿套装衣服的结果。

[0188]

(3)适用于视频平台主播的衣着更换应用:本发明可以为视频平台的主播在节目

中,随时更换衣服使用。同样可以成为各类短视频的插件,完成更换衣服的娱乐目的。

[0189]

(4)适用于购物平台服装搭配的衣着更换应用:本发明可以为购物平台的服装搭配提供衣着更换操作,方便用户自己观察要买的衣服穿搭后的效果,从而为购买衣服提供直观的可视化辅助功能。

[0190]

在一种具体实例中,所述虚拟试穿中双阶段套装风格生成与式样编辑方法,包括:

[0191]

第1步:风格迁移。输入试穿者输入s图片、风格参考f图片,输入式样控制字w。

[0192]

为保证试穿者输入图片,可以获得风格参考图片中的风格信息,需要将风格参考f的均值和标准差参数,迁移到试穿者输入s图片中去。首先,需要将两个输入信息,进行编码处理,试穿者输入s经风格编码e1处理,得到风格编码结果e1(s),且e1(s)结果的全部特征属性均与试穿者输入s保持一致。风格参考f,经风格编码e2处理,得到风格编码结果e2(f),且e2(f)结果的全部特征属性均与风格参考f保持一致。

[0193]

经风格融合h处理单元,其功能针对均值和标准差进行迁移处理计算,得到风格融合后的结果。

[0194][0195]

其中,σ()函数为求取均值操作,μ()函数为计算标准差操作,∈为任意正小数。经此公式计算,风格参考f的风格特征,就可以通过概率方式融合,迁移到试穿者输入s上。

[0196]

试穿者输入s与风格参考f进行风格融合后,需要经风格译码d处理,才能得到最终的风格迁移变换结果:

[0197]

t=d(h(e1(s),e2(f)))

[0198]

从而得到一幅完整的风格迁移处理后,输出结果图像t,其分辨率尺寸为(3,w0,h0),其含义代表rgb图像的3通道信息红色、绿色、蓝色分量,宽度、高度分别为(w0,h0)。

[0199]

第2步:式样分块编辑及式样编辑建议输出。将上衣式样分块编辑模板与下衣式样分块编辑模板进行合并,送入一组3层卷积神经网络,每层均为3

×

3卷积核,计算得到式样分块编辑w

′

。与此同时,风格迁移的输出结果t,经过一组4层全连接,每层均为1

×

1卷积核。则其融合结果为:

[0200]b′

=t

′

+w

′

[0201]

那么,b

′

再次送入一组3层卷积神经网络,每层均为3

×

3卷积核,则到的式样编辑建议b。

[0202]

第3步:式样变换融合。式样变换融合由8个式样变换融合单元组成,分别为:g1、g2、g3、g4、g5、g6、g7和g8。每一个式样变换融合单元的功能完全一致,均为归一化、卷积网络和融合网络构成,目的是要融合风格迁移特征与式样编辑建议特征,从而实现式样的编辑生成。其中,归一化网络为标准批归一化处理;卷积网络为一个3层卷积神经网络,卷积核分别为1

×

1、3

×

3、1

×

1;融合网络,采用的是加法融合方式。

[0203]

这里,特征解耦l1和特征解耦l2功能一致,网络一致,均为1层的全连接网络构成,相当于卷积核为1

×

1。卷积c

1-c8为8个卷积层,每个均为3

×

3卷积核。归一化n

1-n8,采用批归一化处理。上采样r0需要将式样编辑建议b的空间尺寸提升至512

×

512。下采样r

1-r8是要保证每一个式样变换融合单元拿到的式样编辑建议的尺寸是一致长宽分辨率的。

[0204]

g1=g1(c1(l1(t)),n1(r1(r2(...r8(l2(b))))))

[0205]

g2=g2(c2(l1(q2)),n2(r2(r3(...r8(l2(b))))))

[0206]

g3=g3(c3(l1(q3)),n3(r3(r4(...r8(l2(b))))))

[0207]

g4=g4(c4(l1(q4)),n4(r4(r5(...r8(l2(b))))))

[0208]

g5=g5(c5(l1(q5)),n5(r5(r6(...r8(l2(b))))))

[0209]

g6=g6(c6(l1(q6)),n6(r6(r7(r8(l2(b))))))

[0210]

g7=g7(c7(l1(q7)),n7(r7(r8(l2(b)))))

[0211]

y=g8=g8(c8(l1(q8)),n8(r8(l2(b))))

[0212]

其中,b为式样分块编辑的输出结果。于是,经过式样变换融合单元的计算,以y作为套装输出图像,获得最终套装输出的式样和风格可视化结果。

[0213]

本发明使用了基于卷积神经网络编码解码器来提取纹理特征,使用了概率融合方式来合成新的风格特征。本发明使用试穿者图片作为底板,利用风格参考来生成统一风格的风格迁移结果,并通过式样控制字进一步编辑生成结果,形成最终的套装输出。本发明的解决风格和式样的分阶段参考问题,创新点并非对语义的理解和处理,而是重点解决了自定义套装式样编辑问题。本发明利用图像的姿态估计结果作为对人体轮廓的识别和划分,衣着分块及其衣着子块也是仅仅针对人物所穿的衣着区域划分,而不是针对人体本身,衣着分块及其衣着子块的存在,能够更精准地编辑衣着的式样结果。

[0214]

实施例1:服装风格迁移

[0215]

输入试穿者输入s图片、风格参考f图片,给出式样控制字w=40,仅对上衣服装部分进行风格迁移。

[0216]

实施例2:服装式样编辑

[0217]

输入试穿者输入s图片、风格参考f图片,给出式样控制字w=10,仅编辑上衣服装。

[0218]

实施例3:套装生成

[0219]

给出输入试穿者输入s图片和套装生成结果,此时,式样控制字w=14。

[0220]

本领域内的技术人员应明白,本技术的实施例可提供为方法,系统,或计算机程序产品。因此,本技术可采用完全硬件实施例,完全软件实施例,或结合软件和硬件方面的实施例的形式。而且,本技术可采用在一个或多个其中包含有计算机可用程序代码的计算机可用存储介质上实施的计算机程序产品的形式。

[0221]

本技术是参照根据本技术的方法,设备,和计算机程序产品的流程图和/或方框图来描述的。应理解可由计算机程序指令实现流程图和/或方框图中的每一流程和/或方框,以及流程图和/或方框图中的流程和/或方框的结合。可提供这些计算机程序指令到通用计算机、专用计算机、嵌入式处理机或其他可编程数据处理设备的处理器以产生一个机器,使得通过计算机或其他可编程数据处理设备的处理器执行的指令产生用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的装置。

[0222]

这些计算机程序指令也可存储在能引导计算机或其他可编程数据处理设备以特定方式工作的计算机可读存储器中,使得存储在该计算机可读存储器中的指令产生包括指令装置的制造品,该指令装置实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能。

[0223]

这些计算机程序指令也可装载到计算机或其他可编程数据处理设备上,使得在计

算机或其他可编程设备上执行一系列操作步骤以产生计算机实现的处理,从而在计算机或其他可编程设备上执行的指令提供用于实现在流程图一个流程或多个流程和/或方框图一个方框或多个方框中指定的功能的步骤。

[0224]

显然,本领域的技术人员可以对本技术进行各种改动和变型而不脱离本技术的精神和范围。这样,倘若本技术的这些修改和变型属于本技术权利要求及其等同技术的范围之内,则本技术也意图包含这些改动和变型在内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1