基于空间注意力和可逆神经网络的多模态医学图像融合方法

1.本发明涉及医学图像处理技术领域,设计了一种基于空间注意力和可逆神经网络的多模态医学图像融合方法。

背景技术:

2.磁共振成像(magnetic resonance imaging,mri)是一种安全、高空间分辨率的非创伤性成像方法,被广泛应用于医学研究中。通过改变磁共振信号的采样参数,可以得到不同的图像序列,即多模态mr图像。不同的模态图像可能包含了特定的结构信息,如肿瘤位置、水肿面积、病变细节等。然而在实际的临床应用中,通常基于单一模态的mr图像评估肿瘤的位置、大小以及其他信息,这可能忽视了其它模态图像中的重要特征。结合不同序列模式mr图像,提取其包含的互补信息,生成新的融合图像是一个亟待解决的问题。

3.图像融合技术利用信息的互补性,使融合后得到的图像对场景有更全面、更清晰的描述,在各个领域受到了极大的关注。由于图像表示层次不同,图像融合一般可分为三个层次的融合:像素级融合、特征级融合和决策级融合。像素级作为这三个层次中最基本的操作,是图像融合领域的一个研究热点。该级别的图像融合算法直接对源图像的像素进行操作,其优点是可以保留图像的细节和大部分原始信息。前期的研究工作尝试探索了传统的基于空间域的方法来计算两幅源图像像素级显著性的加权平均,或将源图像变换到小波域以获得不同的频率分量。然而,人工设计的特征提取方法可能无法有效地保留源图像中的重要信息,从而在融合图像中产生伪影。此外,传统方法大部分局限于预先设计的融合规则,降低了算法的性能。

4.随着深度学习的发展,研究人员尝试将深度学习技术应用于图像融合,设计无融合规则的端到端模型。例如,基于卷积神经网络(convolution neural network,cnn)的图像融合方法通过卷积神经网络计算拉普拉斯系数得到融合图像。此外,提出的通用图像融合框架ifcnn根据输入图像类型选择合适的融合规则对特征图进行融合,最后使用两个卷积层重构特征图以获得输出图像。

5.虽然端到端模型已经取得了显著的进展,但现有的大多数方法更多地关注于最后阶段捕获的特征地图,忽略了在不同阶段从不同模态获取的空间特征之间的潜在联系,这可能会导致一些详细的解剖纹理信息的丢失。在这个过程中,来自不同模型的一些结构边缘细节可能会丢失。此外,大多数模型在融合特征时可能会产生丢失信息,图像融合算法也会陷入缺乏统一标准的困境。

技术实现要素:

6.本发明是为了解决现有方法存在的不足之处,提出一种基于空间注意力和可逆神经网络的多模态医学图像融合模型,以期能在融合图像中体现不同模态mr图像的特征,从而提升融合准确度并有利于后续的分割任务,为医学图像融合提供新的方法。

7.本发明为达到上述发明目的,采用如下技术方案:

8.本发明一种基于空间注意力和可逆神经网络的多模态医学图像融合方法的特点在于,是按如下步骤进行:

9.步骤1:对两张不同模态的磁共振图像分别进行预处理,得到预处理后的两种模态的医学图像i1和其中,c,h,w分别表示图像的通道数、高度及宽度;

10.步骤2:构建基于空间注意力和可逆卷积的图像融合网络,包括:初始映射层、特征提取模块、多阶段注意力模块和基于可逆神经网络的融合模块;

11.步骤2.1:所述初始映射层利用卷积核为n1×

n1的卷积层对两种模态的医学图像i1和i2进行处理,得到第一模态初始特征和第二模态初始特征

12.步骤2.2:所述特征提取模块由m个特征提取单元构成,每个特征提取单元包括2个残差连接模块及1个纹理分离模块,用于对第一模态初始特征和第二模态初始特征进行处理,得到不同阶段的第二模态结合特征;

13.步骤2.3:所述多阶段注意力模块由一个softmax层和一系列重塑操作和转置操作构成;

14.第一模态特征和第二模态结合特征沿新的维度进行连接后得到多阶段总特征后输入所述多阶段注意力模块中,所述多阶段注意力模块对多阶段总特征f先进行重塑操作,展开为特征矩阵再将特征矩阵进行转置操作后得到转置特征矩阵然后将所述特征矩阵与转置特征矩阵相乘后,再通过一个softmax层并输出注意力特征权重亲和矩阵

15.所述多阶段注意力模块将所述注意力特征权重亲和矩阵w与转置特征矩阵相乘后得到基于注意力机制的特征矩阵f'

att

,再对f'

att

进行重塑操作后与多阶段总特征f相加得到叠加的多阶段注意力特征最终将叠加的多阶段注意力特征重塑为空间注意力特征特征并作为多阶段注意力模块的输出结果;

16.步骤2.4:所述基于可逆神经网络的融合模块由3个hin模块和2个卷积核为n5×

n5的卷积层构成;每个hin模块由2个卷积核为n4×

n4卷积层构成;

17.将第m阶段第二模态结合特征和空间注意力特征f

att

输入所述基于可逆神经网络的融合模块中进行处理,其中,所述第m阶段第二模态结合特征先通过第1个hin模块的第1个n4×

n4的卷积层进行通道维度的变更后得到输入特征再将其沿通道维度平均划分为第一输入特征和第二输入特征所述第一输入特征f

in1

进行实例正则化操作后得到第一输入正则特征f

nor

,所述第二输入特征f

in2

进行标志映射操作后得到第二输入标志特征f

ide

;所述第1个hin模块将所述第一输入正则特征f

nor

和第二输入标志特征f

ide

沿通道维度拼接后,通过第2个n4×

n4的卷积层后得到聚合特征f

agg

,最后将聚合特征f

agg

与输入特征f

in

相加后得到第一hin特征f

hin1

;

18.所述第一hin特征f

hin1

与空间注意力特征f

att

相加后得到中间注意力特征再

依次输入第2、第3个hin模块中,并经过相同的处理后,分别输出第二hin特征f

hin2

和第三hin特征f

hin3

;

19.第二hin特征f

hin2

经过指数操作后与第m阶段第二模态结合特征相乘,再与第三hin特征f

hin3

相加后得到中间阶段结合特征

20.所述融合模块将所述中间注意力特征和中间阶段结合特征沿通道维度连接后,依次通过2个n5×

n5卷积层得到最终的输出图像if;

21.步骤3:利用构建总的损失函数l

total

:

22.l

total

=αl

content

+βl

texture

,

ꢀꢀꢀꢀꢀ

(2)

23.式(2)中,l

content

和i

texture

分别代表内容损失和纹理损失,α和β为权衡内容损失和纹理损失的权重,并由式(3)和式(4)得到:

[0024][0025][0026]

式(3)和式(4)中,为拉普拉斯算子,λ1,λ2为权衡融合图像if与输入图像i1、i2二范数差异的参数,μ1,μ2为权衡融合图像if与输入图像i1、i2的拉普拉斯算子二范数差异的参数;

[0027]

步骤4:将医学图像集合输入基于空间注意力和可逆神经网络的图像融合网络进行训练,并计算总体损失函数l

tptal

,当训练迭代次数达到设定的次数时,训练停止,从而得到最优的多模态医学图像融合网络,用于实现图像融合。

[0028]

本发明所述的基于空间注意力和可逆神经网络的多模态医学图像融合方法的特点也在于,所述步骤2.2是按如下步骤进行:

[0029]

步骤2.2.1:所述残差连接模块由4个卷积核为n2×

n2的卷积层,2个bn层,2个relu层,1个平均池化层和1个sigmoid层构成;

[0030]

所述初始第一模态特征输入到第1个特征提取单元中,并相应经过第1个残差连接模块中的第1个n2×

n2的卷积层、第1个归一化层bn和第1个relu层的处理后,得到中间特征所述中间特征再分别通过第2个n2×

n2的卷积层和第2个归一化层bn后得到中间深层特征所述中间深层特征分别依次通过平均池化层、第3个n2×

n2的卷积层、第2个relu层、第4个n2×

n2的卷积层以及sigmoid层后,相应得到通道注意力权值a1,最终利用式(1)得到第1个残差连接模块中输出的第一阶段第一模态特征

[0031][0032]

所述初始第二模态特征输入到第1个特征提取单元的第2个残差连接模块中,并经过相同的处理后,输出第一阶段第二模态特征

[0033]

步骤2.2.2:所述纹理分离模块包括2个n3×

n3的卷积层和一个sigmoid层;

[0034]

所述第一阶段第一模态特征和第一阶段第二模态特征输入所述纹理分离模

块中,其中,第一阶段第一模态特征经过第1个n3×

n3的卷积层和一个sigmoid层的处理后,得到前景高频权重矩阵再将与全“1”矩阵进行做差后得到后景低频权重矩阵

[0035]

所述第一阶段第一模态特征与第一阶段第二模态特征沿通道维度进行连接后,分别与前景高频权重矩阵和后景低频权重矩阵相乘,得到前景分离特征f

fore

和后景分离特征f

back

;

[0036]

所述前景分离特征f

fore

和后景分离特征f

back

沿通道维度进行连接后,与第一阶段第二模态特征相加,得到第一阶段第二模态结合特征

[0037]

所述第一阶段第一模态特征和第一阶段第二模态结合特征输入第2个特征提取单元,并经过相同的处理后,输出第二阶段第一模态特征和第二阶段第二模态结合特征

[0038]

第二阶段第一模态特征依次经过m个特征提取单元后,得到不同阶段的第一模态特征其中,表示第m个阶段的第一模态特征;

[0039]

第二阶段第二模态结合特征依次经过m个特征提取单元后,得到不同阶段的第二模态结合特征其中,表示第m个阶段的第二模态特征。

[0040]

本发明一种电子设备,包括存储器以及处理器,其特点在于,所述存储器用于存储支持处理器执行所述多模态医学图像融合方法的程序,所述处理器被配置为用于执行所述存储器中存储的程序。

[0041]

本发明一种计算机可读存储介质,计算机可读存储介质上存储有计算机程序,其特点在于,所述计算机程序被处理器运行时执行所述多模态医学图像融合方法的步骤。

[0042]

与现有的图像融合方法相比,本发明的优势体现在:

[0043]

1、本发明提出了一种用于多模态mr图像的端到端模型,msaif-net网络,它使用多级注意模块捕获每个图像中的远程上下文信息,同时对不同阶段分配注意权重,并探索每个阶段提供的前景和背景之间的结构细节,从而保留了不同模态的综合特征用于后续的融合,结合不同模态的图像的特点来生成清晰病灶的mr结构图像,以助于后续的医学任务。

[0044]

2、本发明通过可逆神经网络无损地结合了两种模态的跨尺度特征以重构融合体图像,有助于后续的语义分割分析,便于探究不同模态融合图像对分割任务的作用,弥补了传统基于端到端融合网络方法的不足,提高了图像融合的性能,对研究多模态医学图像具有重要意义。

附图说明

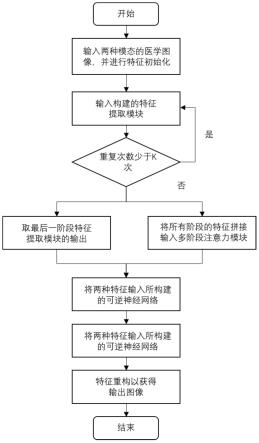

[0045]

图1为本发明实施例所提供的多模态医学图像融合方法的流程图;

[0046]

图2为本发明实施例所提供的多模态医学图像融合方法的原理框架图;

[0047]

图3为本发明实施例所提供的特征提取模块中的残差连接模块的结构示意图;

[0048]

图4为本发明实施例所提供的特征提取模块中的纹理分离模块的结构示意图;

[0049]

图5为本发明实施例所提供的多阶段注意力模块;

[0050]

图6为本发明实施例所提供的基于可逆神经网络的融合模块;

[0051]

图7为本发明实施例所提供的融合模块内部的hin模块;

[0052]

图8为本发明实施例所提供的在brats2019数据集上的视觉对比效果图。

具体实施方式

[0053]

本实施例中,一种基于空间注意力和可逆神经网络的多模态医学图像融合方法名为msaif-net,总体流程图如图1所示。一方面,利用一系列残差块从不同阶段的两幅源图像中捕获特征地图,然后将这些特征地图按通道连接起来,通过多级注意模块获取远程空间信息。另一方面,提出的特征提取模块来分离前景和背景,将一个模态中提取的细节纹理与另一个模态进行融合,从而可以保留不同模态的综合特征。特征融合模块的设计动机来自于可逆神经网络在计算机视觉中的应用,因此尝试以信息无损的方式将其作为融合策略引入。

[0054]

本发明实施例显式利用多阶段注意力模块探索各个阶段特征之间的潜在相关性,旨在捕获每个图象中的远程上下文信息,以及多个特征提取模块获得深度特征信息,且利用可逆卷积网络进行特征的融合。除此之外,本发明所提供的方法可以实现端到端的训练,且可以实现最佳的性能要求,为多模态医学图像融合提供了一个新的切实可行的思路。在实施例中,以miccai brats2019多模态医学数据集为例,结合附图来说明具体的实施方式,该方法主要包括:

[0055]

步骤1:对两张不同模态的磁共振图像分别进行预处理,得到预处理后的两种模态的医学图像i1和其中,c,h,w分别表示图像的通道数、高度及宽度;本实施例中,使用的是2019年miccai brats脑肿瘤分割挑战赛的公开数据集,数据包括t1,t2,t1ce,t2flair以及它们对应的脑部肿瘤分割图,对于每种数据采用分割图高于一定像素的标准选择,包含有3557张图片,读取两个不同模态的图像对,进行裁剪、归一化操作,得到对应的预处理之后的数据,大小为160

×

160

×

1,其中,160对应图像尺寸,1为通道数;

[0056]

步骤2:构建基于空间注意力和可逆卷积的图像融合网络,如图2所示。包括:初始映射层、特征提取模块、多阶段注意力模块和基于可逆神经网络的融合模块;

[0057]

步骤2.1:初始映射层利用卷积核为n1×

n1的卷积层对两种模态的医学图像i1和i2进行处理,得到第一模态初始特征和第二模态初始特征本实施例中,n1=3,即初始映射层中每层卷积的卷积核为3

×

3,卷积步长为1,填充补零,输出后特征图的通道数为32。

[0058]

步骤2.2:特征提取模块由m个特征提取单元构成,每个特征提取单元包括2个残差连接模块及1个纹理分离模块;本实施例中,m=4,网络结构如图2所示。

[0059]

步骤2.2.1:残差连接模块如图3所示,由4个卷积核为n2×

n2的卷积层,2个bn层,2个relu层,1个平均池化层和1个sigmoid层构成;

[0060]

初始第一模态特征输入到第1个特征提取单元中,并相应经过第1个残差连接模块中的第1个n2×

n2的卷积层、第1个归一化层bn和第1个relu层的处理后,得到中间特征中间特征再分别通过第2个n2×

n2的卷积层和第2个归一化层bn后得到中间深层

特征中间深层特征分别依次通过平均池化层、第3个n2×

n2的卷积层、第2个relu层、第4个n2×

n2的卷积层以及sigmoid层后,相应得到通道注意力权值a1,最终利用式(1)得到第1个残差连接模块中输出的第一阶段第一模态特征本实施例中,n2=3,即每层卷积的卷积核为3

×

3,卷积步长为1,填充补零,输出后特征图的通道数为32。

[0061][0062]

初始第二模态特征输入到第1个特征提取单元的第2个残差连接模块中,并经过相同的处理后,输出第一阶段第二模态特征

[0063]

步骤2.2.2:纹理分离模块如图4所示,包括2个n3×

n3的卷积层和一个sigmoid层;

[0064]

第一阶段第一模态特征和第一阶段第二模态特征输入纹理分离模块中,其中,第一阶段第一模态特征经过第1个n3×

n3的卷积层和一个sigmoid层的处理后,得到前景高频权重矩阵再将与全“1”矩阵进行做差后得到后景低频权重矩阵

[0065]

第一阶段第一模态特征与第一阶段第二模态特征沿通道维度进行连接后,分别与前景高频权重矩阵和后景低频权重矩阵相乘,得到前景分离特征f

fore

和后景分离特征f

back

;

[0066]

前景分离特征f

fore

和后景分离特征f

back

沿通道维度进行连接后,与第一阶段第二模态特征相加,得到第一阶段第二模态结合特征

[0067]

第一阶段第一模态特征和第一阶段第二模态结合特征输入第2个特征提取单元,并经过相同的处理后,输出第二阶段第一模态特征和第二阶段第二模态结合特征经过m个特征提取单元后,得到不同阶段的第一模态特征和第二模态结合特征:经过m个特征提取单元后,得到不同阶段的第一模态特征和第二模态结合特征:其中,表示第m个阶段的第一模态特征;表示第m个阶段的第二模态特征。本实施例中,n3=3,即每层卷积的卷积核为3

×

3,卷积步长为1,填充补零,输出后特征图的通道数为32。

[0068]

步骤2.3:多阶段注意力模块如图5所示,由一个softmax层和一系列重塑操作和转置操作构成;

[0069]

2m个不同阶段的模态特征沿新的维度进行连接后得到多阶段总特征将多阶段总特征f输入多阶段注意力模块。多阶段总特征f首先通过重塑操作展开为特征矩阵作展开为特征矩阵特征矩阵通过转置操作得到转置特征矩阵然后将特征矩阵与转置特征矩阵相乘,再通过一个softmax层输出注意力特征权重亲和矩阵注意力特征权重亲和矩阵w与转置特征矩阵相乘得到基于注意力机制的特征矩阵f'

att

,通过重塑操作后与多阶段总特征f相加得到叠加的多阶段注意力特征最终将叠加的多阶段注意力特征重塑为空间注意力特征作为多阶段注意力模块的输出结果。

[0070]

步骤2.4:基于可逆神经网络的融合模块如图6所示,由三个hin模块和2个n5×

n5卷积层构成。

[0071]

步骤2.4.1:hin模块如图7所示,由2个n4×

n4卷积层构成。

[0072]

将第m阶段第二模态结合特征和空间注意力特征f

att

输入基于可逆神经网络的融合模块,第m阶段第二模态结合特征首先通过第1个hin模块的第1个n4×

n4的卷积层进行通道维度的变更得到输入特征再将其沿通道维度平均划分为第一输入特征征和第二输入特征第一输入特征f

in1

进行实例正则化操作得到第一输入正则特征f

nor

,第二输入特征f

in2

进行标志映射操作得到第二输入标志特征f

ide

。将第一输入正则特征f

nor

和第二输入标志特征f

ide

沿通道维度拼接,通过第2个n4×

n4的卷积层后得到聚合特征f

agg

,将聚合特征f

agg

与输入特征f

in

相加得输出第一hin特征f

hin1

。本实施例中,n4=3,即两层卷积的卷积核均为为3

×

3,卷积步长为1,填充补零,两次输出后特征图的通道数均为16。

[0073]

第一hin特征f

hin1

与空间注意力特征f

att

相加得到中间注意力特征中间注意力特征输入第2和第3个hin模块中,并经过相同的处理后,分别输出第二hin特征f

hin2

和第三hin特征f

hin3

。

[0074]

第二hin特征f

hin2

经过指数操作后与第m阶段第二模态结合特征相乘,再与第三hin特征f

hin3

相加得到中间阶段结合特征中间注意力特征和中间阶段结合特征沿通道维度连接后,依次通过2个n5×

n5卷积层得到最终的输出图像if。本实施例中,n4=3,即两层卷积的卷积核均为为3

×

3,卷积步长为1,填充补零,第一次输出后特征图的通道数为32,第二次输出的通道数为1。

[0075]

本发明实施例中,特征融合阶段采用可逆神经网络(inn)的结构来进行实现,以可逆神经网络为基础框架,结合hinet中的hinblock模块结构实现,如图。近年来,作为可逆图像变换的一种有效方案,可逆神经网络(inn)引起了广泛关注,并被应用于各种图像任务。它具有三个重要性质:1)inn的输入输出映射是双射的;2)inn的正向映射和反向映射是有效的和可计算的;3)双射映射可以很容易地处理雅可比行列式来显式地计算后验概率。由于这些特性,inn在许多任务中都取得了成功。其中,基于inn的开创性研究可以nice和realnvp这两篇文章中找到。基于inn的网络能够以双射映射的方式将输入的特征进行结合,而不会丢失信息。

[0076]

步骤3:利用构建总的损失函数l

total

:

[0077]

l

total

=αl

content

+βl

texture

,

ꢀꢀꢀꢀꢀ

(2)

[0078]

式(2)中,l

content

和l

texture

分别代表内容损失和纹理损失,α和β为权衡内容损失和纹理损失的权重,本实施例中,α=β=1,并由式(3)和式(4)得到:

[0079][0080]

[0081]

式(3)和式(4)中,为拉普拉斯算子,λ1,λ2为权衡融合图像if与输入图像i1、i2二范数差异的参数,μ1,μ2为权衡融合图像if与输入图像i1、i2的拉普拉斯算子二范数差异的参数。本实施例中,μ1=μ2=λ1=λ2=1。

[0082]

步骤4:将多模态医学图像输入基于空间注意力和可逆神经网络的图像融合网络进行训练,并计算总体损失函数l

total

,当训练迭代次数达到设定的次数时,训练停止,从而得到最优的多模态医学图像融合网络。本实施例中,采用sgd优化器,学习率按迭代次数增加而递减,训练迭代了50次。最终与不同方法的效果对比如图8所示,从中可以看出本融合方法相较于其他方法能够更好的结合flair图像病灶内部清晰的结构和t2图像总体脑部结构,从而运用于后续医学相关任务。

[0083]

为了量化评估本发明的效果并验证本发明的有效性,为此将本发明方法与ifcnn等七种算法相比较。选择相关系数(correlation coefficient,cc)、结构相似性(structure similarity index measure,ssim)等图像融合领域常见的指标作为无监督评价标准。除此之外,将得到融合图像输入医学领域常见的分割网络模型u-net中以得到分割图,选择dice相似系数(dice similarity coefficient,dsc)、ppv以及hausdorff距离(hd,hd95即95%hd)三个性能指标作为有监督评价标准。

[0084]

本实施例中列举的七种对比方法以及本发明所提出的对多模态医学图像融合方法。其中七种对比方法分别为pmef、spd-mef、mefaw、u2fusion、ifcnn、pgmi和mmfal。这七种对比方法各自对应的论文标题为:perceptual quality assessment for multi-exposure image fusion、fast multi-scale structural patch decomposition for multi-exposure image fusion、a multi-exposure image fusion based on the adaptive weights reflecting the relative pixel intensity and global gradient、u2fusion:a unified unsupervised image fusion network、rethinking the image fusion:a fast unified image fusion network based on proportional maintenance of gradient and intensity和glioma segmentation-oriented multi-modal mr image fusion with adversarial learning。

[0085]

本实施例中,用于评价融合图像的指标,包括基于结构相似性的指标cc、ssim、qy和qw;基于图像特征的指标q

abf

和q

p

;基于人类感知的指标q

cb

和viff。

[0086]

本实施例中,一种电子设备,包括存储器以及处理器,该存储器用于存储支持处理器执行上述多模态医学图像融合方法的程序,该处理器被配置为用于执行该存储器中存储的程序。

[0087]

本实施例中,一种计算机可读存储介质,是在计算机可读存储介质上存储有计算机程序,该计算机程序被处理器运行时执行上述多模态医学图像融合方法的步骤。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1