基于空间-通道互相关和中心度引导的孪生目标跟踪方法

1.本发明涉及计算机视觉目标跟踪技术领域,尤其涉及一种基于空间-通道互相关和中心度引导的孪生目标跟踪方法。

背景技术:

2.目标跟踪是计算机视觉的一项基本任务,目标跟踪融合了来自机器学习、优化和图像处理等多个领域的知识,在自动监控、车辆导航、机器人传感、人机交互和增强实现等领域有着广泛的应用。虽然目标跟踪已经取得了长足的进展,但是复杂多变的实际场景中存在着光照变化、遮挡、快速运动、形变、尺度变化和相似物体干扰等诸多因素的影响,鲁棒视觉跟踪仍具有很大的挑战性。

3.近年来,基于孪生网络的深度跟踪器在精度和速度之间取得了较好的平衡,比如siamfc、siamrpn、dasiamrpn、siamrpn++、siamcar等,但仍然存在许多不足之处:siamfc使用的是简单的naive correlation操作,它本质上是一个卷积操作,直接将模版特征作为卷积核与搜索特征进行互相关操作,最后得到的特征图通道数为1;siamrpn+使用了深度互相关操作,这种运算对输入层的每个通道独立进行互相关运算,因此它得到的特征图的通道数与搜索特征的通道数相同,但是它没有利用不同的通道在相同的空间位置上的特征信息;一些跟踪器率先在孪生网络中使用了逐像素的互相关操作,与深度互相关相反,它没有利用不同的空间在相同的通道位置上的特征信息;而siamcar在分类子网络中引入了一个新的中心度分支,用来抑制远离中心位置的预测框,但是中心度分支如果与分类分支共享同一个特征图,预测的结果可能和分类预测的结果相似,不能很好区分这两个分支,而且中心度分支放在分类子网络是不合适的,如图1中的(a)图所示。因此,需要更有效地融合搜索区域特征和模版特征,更好地利用了中心度分支的特性,改善目标跟踪的高精度,高鲁棒性。

技术实现要素:

4.(一)要解决的技术问题

5.基于上述问题,本发明提供一种基于空间-通道互相关和中心度引导的孪生目标跟踪方法,通过更有效地融合搜索区域特征和模版特征,更好地利用了中心度分支的特性,解决目标跟踪的精度和鲁棒性有待提高的问题。

6.(二)技术方案

7.基于上述的技术问题,本发明提供一种基于空间-通道互相关和中心度引导的孪生目标跟踪方法,包括以下步骤:

8.s1、获取图像中的模板和搜索区域;

9.s2、分别将所述模板和搜索区域送入深度特征提取网络进行特征提取,得到模板特征和搜索区域特征分别为和宽度

×

长度

×

通道数大小分别为hz

×

wz

×

c,hx

×

wx

×

c;

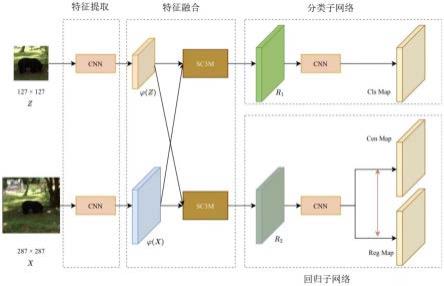

10.s3、将所述模板特征和搜索区域特征分别送入两个空间-通道互相关模块,得到适用于分类子网络的特征图r1和适用于回归子网络的特征图r2;

11.s4、将所述特征图r1送入分类子网络得到分类图,将所述特征图r2送入回归子网络得到中心度图和回归图;

12.s5、通过损失函数优化所述步骤s3-s4,根据优化后所述分类图、中心度图和回归图得到预测的目标边界框;

13.所述步骤s3包括:

14.s31、将所述模板特征从空间维度上分割成包括hz

×

wz个小核的空间核k1,每个小核的大小为1

×1×

c;将所述模板特征从通道维度上分割成包括c个小核的通道核k2,每个小核的大小为1

×1×

hzwz;

15.s32、将所述搜索区域特征与所述空间核k1进行逐像素的互相关操作,得到特征图f1:

★

表示逐像素互相关;

16.s33、将所述特征图f1与所述通道核k2进行逐像素的互相关操作,得到特征图f2:f2=f1

★

k2;

17.s34、将所述特征图f1和特征图f2拼接,进行1

×

1卷积降维,送入热插拔模块se-block;

18.s35、所述步骤s31-s34重复进行两次,分别得到大小均为hz

×

wz

×

c的适用于分类子网络的特征图r1和适用于回归子网络的特征图r2。

19.进一步的,所述步骤s1中,所述模板为将数据集或摄像头捕捉画面的第一帧图像以目标为中心裁剪出指定像素大小的图像;所述搜索区域为在跟踪过程中第i+1帧以第i帧目标位置为中心裁剪出指定大小的图像。

20.进一步的,所述步骤s4包括:

21.s41、将所述特征图r1送入分类子网络,所述分类子网络为cnn网络,只有一个分类分支,输出一个分类图分类图每个点预测的是该点位置是前景和背景的可能性。

22.s42、将所述特征图r2送入回归子网络,所述回归子网络为cnn网络,包括一个中心度分支和一个边界框回归分支,分别输出中心度图和回归图中心图每个点预测的是该位置是目标中心的可能性,回归图每个点预测的是该点离边界框上下左右的距离。

23.进一步的,步骤s5中,所述通过损失函数优化包括:用中心度损失来训练所述中心度分支,用中心度加权的回归损失来训练所述边界框回归分支,用分类损失来训练分类分支。

24.进一步的,所述分类损失:

[0025][0026]

所述中心度损失:

[0027][0028]

所述中心度加权的回归损失:

[0029][0030]

其中,i,j表示对应图的坐标位置,表示分类标签的真实值,代表中心度的真实值,代表网络预测的结果,n

pos

代表正样本的个数,代表正样本的集合,iou代表括号内两者的交并比,b

i,j

,分别代表预测边界框和真实边界框。

[0031]

进一步的,步骤s5中,所述根据优化后所述分类图、中心度图和回归图得到预测的目标边界框包括:

[0032]

所述分类图中的前景部分乘以所述中心度图得到响应最大的点,即预测的目标中心点;再根据所述回归图得到点到预测边界框四条边的距离,结合所述预测的目标中心点,得到预测的目标边界框。

[0033]

进一步的,所述模板裁剪的指定大小为287

×

287像素,所述搜索区域裁剪的指定大小为127

×

127像素。

[0034]

进一步的,所述模板特征的宽度

×

长度

×

通道数大小为13

×

13

×

256,所述搜索区域特征的宽度

×

长度

×

通道数大小为25

×

25

×

256。

[0035]

本发明也公开了一种基于空间-通道互相关和中心度引导的孪生目标跟踪系统,包括至少一个处理器;以及与所述处理器通信连接的至少一个存储器,其中:

[0036]

所述存储器存储有可被所述处理器执行的程序指令,所述处理器调用所述程序指令能够执行所述的基于空间-通道互相关和中心度引导的孪生目标跟踪方法,包括以下功能模块:

[0037]

数据获取模块,用于执行所述的步骤s1;

[0038]

特征提取模块,用于执行所述的步骤s2;

[0039]

空间-通道互相关模块,用于执行所述的步骤s3;

[0040]

分类回归模块,用于执行所述的步骤s4;

[0041]

预测模块,用于执行所述的步骤s5。

[0042]

本发明也公开了一种非暂态计算机可读存储介质,所述非暂态计算机可读存储介质存储计算机指令,所述计算机指令使所述计算机执行所述的基于空间-通道互相关和中心度引导的孪生目标跟踪方法。

[0043]

(三)有益效果

[0044]

本发明的上述技术方案具有如下优点:

[0045]

(1)本发明通过将搜索区域特征和模板特征送入空间-通道互相关模块进行特征融合,实现在空间和通道两个维度上融合特征,既利用不同通道在相同空间位置上的特征

信息,也利用不同空间在相同通道位置上的特征信息,实现更有效地融合搜索区域特征和模板特征,有利于提高目标跟踪的精度和鲁棒性;同时减少相似物体的干扰,有效减少计算量;

[0046]

(2)本发明的回归子网络包括中心度分支和回归分支,并用中心度分支指导整个回归子网络,除了用中心度目标来指导中心度的分支外,还将中心度目标加权乘到iou损失上,抑制距离中心点远的低质量的预测的目标边界框的权重,提高预测的目标边界框的准确性;

[0047]

(3)本发明由于所述空间-通道互相关模块进行特征融合的轻量性,使得能重复进行两次操作,得到两个具有不同适用性的特征图,分别作为分类子网络和回归子网络的输入来应对不同的子任务,在更好区分这两个任务的同时,提高目标跟踪的精度和鲁棒性。

附图说明

[0048]

通过参考附图会更加清楚的理解本发明的特征和优点,附图是示意性的而不应理解为对本发明进行任何限制,在附图中:

[0049]

图1为siamcar和本发明实施例方法的对比示意图;

[0050]

图2为本发明实施例的基于空间-通道互相关和中心度引导的孪生目标跟踪方法的整体原理示意图;

[0051]

图3为本发明实施例的步骤s3的空间-通道互相关模块部分的原理示意图;

[0052]

图4为本发明实施例的步骤s42中中心度引导的回归子网络部分的原理示意图;

[0053]

图5为本发明实施例方法与其它方法在otb100上的性能比较;

[0054]

图6为本发明实施例方法与其它方法在uav123上的性能比较。

具体实施方式

[0055]

下面结合附图和实施例,对本发明的具体实施方式作进一步详细描述。以下实施例用于说明本发明,但不用来限制本发明的范围。

[0056]

本发明实施例为一种基于空间-通道互相关和中心度引导的孪生目标跟踪方法,如图1中的(b)图和图2所示,包括以下步骤:

[0057]

s1、获取图像中裁剪成指定大小的模板和搜索区域:

[0058]

将数据集或摄像头捕捉画面的第一帧图像以目标为中心裁剪出指定像素大小的图像作为模板,在跟踪过程中第i+1帧以第i帧目标位置为中心裁剪出设定大小的图像作为搜索区域;模板和搜索区域裁剪的指定大小分别为287

×

287像素和127

×

127像素。

[0059]

s2、分别将所述模板和搜索区域送入深度特征提取网络进行特征提取,得到模板特征和搜索区域特征分别为和大小分别为hz

×

wz

×

c,hx

×

wx

×

c,表示模板特征或搜索区域特征的宽度

×

长度

×

通道数;

[0060]

本实施例中大小分别为13

×

13

×

256和25

×

25

×

256。

[0061]

s3、将所述模板特征和搜索区域特征分别送入两个空间-通道互相关模块,即sc3m,得到适用于分类子网络的特征图r1和适用于回归子网络的特征图r2,如图3所示,包括以下步骤:

[0062]

s31、将所述模板特征从空间维度上分割成包括hz

×

wz个小核的空间核k1,每个小核的大小为1

×1×

c;将所述模板特征从通道维度上分割成包括c个小核的通道核k2,每个小核的大小为1

×1×

hzwz;

[0063]

s32、将所述搜索区域特征与所述空间核k1进行逐像素的互相关操作,得到特征图f1,f1的大小为hx

×

wx

×

hzwz:

★

表示逐像素互相关;

[0064]

该步骤将搜索区域特征与模板特征在空间维度上充分融合;

[0065]

s33、将所述特征图f1与所述通道核k2进行逐像素的互相关操作,得到特征图f2,f2的大小为hz

×

wz

×

c:f2=f1*k2;

[0066]

该步骤将搜索区域特征与模板特征在通道维度上充分融合;

[0067]

s34、将所述特征图f1和特征图f2拼接,进行1

×

1卷积降维,送入热插拔模块se-block;

[0068]

该步骤的1

×

1卷积和热插拔模块se-block通过优化,能得到适用于不同偏向性的特征图;所述热插拔模块se-block不会改变输入特征的大小,作用是获得全局信息和通道之间的关联性;

[0069]

s35、所述步骤s31-s34重复进行两次,由于重复的两次训练优化的侧重点不同,分别得到适用于分类子网络的特征图r1和适用于回归子网络的特征图r2,r1和r2的大小均为hz

×

wz

×

c,和一样;

[0070]

由于步骤s31-s34的特征融合的轻量性,使得能重复进行两次操作;而在siamcar中由于特征融合计算量大,只能计算一次,得到一个特征图用于所有的子任务。

[0071]

s4、将所述特征图r1送入分类子网络得到分类图,将所述特征图r2送入回归子网络得到中心度图和回归图;

[0072]

s41、将所述特征图r1送入分类子网络,所述分类子网络为cnn网络,只有一个分类分支,输出一个分类图分类图每个点预测的是该点位置是前景和背景的可能性。

[0073]

s42、将所述特征图r2送入回归子网络,所述回归子网络为cnn网络,包括一个中心度分支和一个边界框回归分支,分别输出中心度图和回归图中心图每个点预测的是该位置是目标中心的可能性,回归图每个点预测的是该点离边界框上下左右的距离,如图4所示。

[0074]

其中,分类分支、中心度分支和边界框回归分支均为三层全卷积层,只是输出的通道数不同。

[0075]

s5、通过损失函数优化所述步骤s3-s4,根据优化后所述分类图、中心度图和回归图得到预测的目标边界框;

[0076]

s51、用中心度损失来训练所述中心度分支,用中心度加权的回归损失来训练所述边界框回归分支,用分类损失来训练分类分支,其中,所述分类损失采用ce(交叉熵,cross entropy)损失函数,所述分类损失:

[0077]

[0078]

所述中心度损失采用bce(二分类交叉熵,binary cross entropy)损失函数,所述中心度损失:

[0079][0080]

所述中心度加权的回归损失:

[0081][0082]

其中,i,j表示对应图的坐标位置,表示分类标签的真实值,代表中心度的真实值,代表网络预测的结果,n

pos

代表正样本的个数,代表正样本的集合,iou代表括号内两者的交并比,b

i,j

,分别代表预测边界框和真实边界框。我们用中心度的真实值加权到iou回归损失上,可以抑制那些远离中心点的低质量的预测的目标边界框的权重。

[0083]

s52、根据优化后所述分类图、中心度图和回归图得到预测的目标边界框:

[0084]

分类图每个点预测的是该点位置是前景和背景的可能性,中心图每个点预测的是该位置是目标中心的可能性,回归图每个点预测的是该点离边界框上下左右的距离;因此,所述分类图中的前景部分乘以所述中心度图得到响应最大的点,即预测的目标中心点;再根据所述回归图得到点到预测边界框四条边的距离,结合所述预测的目标中心点,得到预测的目标边界框。

[0085]

为验证本实施例的技术效果,将上述方法在vot2018,otb100,uav123,got-10k等多个权威性的数据集上进行了验证,图5展示了本发明的方法与其他方法在otb100上的性能比较,其中图5中的(a)图表示otb2015数据集上的精确图,图5中(b)图表示otb2015数据集上成功率图;图6展示了本发明的方法与其他方法在uav123数据集上性能的比较,其中图6中的(a)图表示本发明的方法与其他方法在uav123数据集上的精确图,图6中(b)图表示本发明的方法与其他方法在uav123数据集上成功率图;精确图的横坐标代表阈值,纵坐标表示跟踪算法估计的目标位置(bounding box)的中心点与人工标注(ground-truth)的目标的中心点的距离小于给定阈值的视频帧的百分比,成功率图的横坐标代表阈值,纵坐标表示os大于设定的阈值的帧占所有帧的百分比,本发明在精确图和成功率图上反应的性能均较好;本发明所述方法的表1展示了本发明的方法与其他方法在vot2018数据集上性能的比较,准确度的数值越大,准确度越高,鲁棒性的数值越大,稳定性越差,eao(expected average overlap的缩写)表示非重置重叠期望,数值越大,性能越好,由表中数值可知,本发明所述方法的准确度仅次于siamrcnn,eao反应的性能最佳,鲁棒性也较好,整体性能优秀;表2展示了本发明的方法与其他方法在got-10k数据集上性能的比较,ao表示所有估计边界框和地面真实框之间的平均重叠,sr0.5表示重叠超过0.5的成功跟踪帧的速率,sr0.75表示重叠超过0.75的帧,fps表示画面每秒传输帧数,本发明所述方法的ao值仅次于

siamgat++,sr

0.50

值仅次于siamgat++和rbo,sr

0.75

值最佳,fps值也较高,目标跟踪的整体表现较好。

[0086]

表1

[0087][0088]

表2

[0089][0090]

本发明实施例还提供了一种基于空间-通道互相关和中心度引导的的孪生目标跟踪系统,可实现所述基于空间-通道互相关和中心度引导的孪生目标跟踪方法,包括处理器及存储介质,所述所述存储介质用于存储指令;所述处理器执行所述的基于空间-通道互相关和中心度引导的孪生目标跟踪方法,包括以下功能模块:数据获取模块,用于执行所述的步骤s1;特征提取模块,用于执行所述的步骤s2;空间-通道互相关模块,用于执行所述的步骤s3;分类回归模块,用于执行所述的步骤s4;预测模块,用于执行所述的步骤s5。

[0091]

上述的孪生目标跟踪方法可以转换为软件程序指令,既可以使用包括处理器和存储器的孪生目标跟踪系统来运行实现,也可以通过非暂态计算机可读存储介质中存储的计算机指令来实现。上述以软件功能单元的形式实现的集成的单元,可以存储在一个计算机可读取存储介质中。上述软件功能单元存储在一个存储介质中,包括若干指令用以使得一

台计算机设备(可以是个人计算机,服务器,或者网络设备等)或处理器(processor)执行本发明各个实施例所述方法的部分步骤。而前述的存储介质包括:u盘、移动硬盘、只读存储器(read-only memory,rom)、随机存取存储器(random access memory,ram)、磁碟或者光盘等各种可以存储程序代码的介质。

[0092]

综上可知,通过上述的一种基于空间-通道互相关和中心度引导的孪生目标跟踪方法,具有以下有益优点:

[0093]

(1)本发明通过将搜索区域特征和模板特征送入空间-通道互相关模块进行特征融合,实现在空间和通道两个维度上融合特征,既利用不同通道在相同空间位置上的特征信息,也利用不同空间在相同通道位置上的特征信息,实现更有效地融合搜索区域特征和模板特征,有利于提高目标跟踪的精度和鲁棒性;同时减少相似物体的干扰,有效减少计算量;

[0094]

(2)本发明的回归子网络包括中心度分支和回归分支,并用中心度分支指导整个回归子网络,除了用中心度目标来指导中心度的分支外,还将中心度目标加权乘到iou损失上,抑制距离中心点远的低质量的预测的目标边界框的权重,提高预测的目标边界框的准确性;

[0095]

(3)本发明由于所述空间-通道互相关模块进行特征融合的轻量性,使得能重复进行两次操作,得到两个具有不同适用性的特征图,分别作为分类子网络和回归子网络的输入来应对不同的子任务,在更好区分这两个任务的同时,提高目标跟踪的精度和鲁棒性。

[0096]

最后应说明的是:以上实施例仅用以说明本发明的技术方案,而非对其限制;虽然结合附图描述了本发明的实施方式,但是本领域技术人员可以在不脱离本发明的精神和范围的情况下做出各种修改和变型,这样的修改和变型均落入由所附权利要求所限定的范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1