基于SPECT/CT检测甲状腺相关眼病活动性的深度学习方法与流程

基于spect/ct检测甲状腺相关眼病活动性的深度学习方法

技术领域

1.本发明涉及医学图像分类的技术领域,具体涉及一种基于spect/ct检测甲状腺相关眼病活动性的深度学习方法。

背景技术:

2.甲状腺相关眼病,也称为甲状腺眼病或格雷夫斯眼病,是成年人最常见的眼眶疾病。现在普遍认为,免疫介导的炎症是甲状腺相关眼病的主要发病机制,其特征是眼眶脂肪的眼外肌增厚、充血和水肿。大多数甲状腺相关眼病患者将经历炎症活跃阶段及非炎症活跃阶段。对于非活动性甲状腺相关眼病患者,支持性治疗,如润滑剂眼药水就足够了;而对于活动期甲状腺相关眼病患者,糖皮质激素或放射治疗被认为可以减少炎症后遗症。

3.临床活动评分(clinical activity score,cas)广泛地用于甲状腺相关眼病的活动性。然而,临床活动评分是主观的,在很大程度上取决于眼科医生的意见。眼眶计算机断层扫描是一种快速且经济的眼眶疾病成像方法,可提供准确的形态学信息,如眼外肌的变化。这些信息可以帮助诊断甲状腺相关眼病,但很难准确评估甲状腺相关眼病的炎症活性。放射性核素成像,例如使用99m锝标记的二乙烯三胺五乙酸的眼眶单光子发射计算机断层扫描,由于其经济、简单和准确,已被报道为诊断和进一步分期甲状腺相关眼病活动性的有用生物标记物。spect/ct是一种融合成像,由功能图像的spect和解剖图像的ct组成,从而提高了测试的诊断准确性。最近报道,ct和spect混合诊断成像有望通过对甲状腺相关眼病患者眼外肌的半定量图像分析来评估炎症活动。此外,在预测甲状腺相关眼病患者眼周糖皮质激素治疗的疗效方面,spect/ct可能优于cas。

4.近年来,深度学习已广泛应用于医学成像领域,包括眼部成像。许多研究表明,深度学习能够自动筛查和诊断各种眼部疾病,如白内障、糖尿病视网膜病变、青光眼、年龄相关性黄斑变性和早产儿视网膜病变。然而,使用眼眶成像的基于深度学习的技术在甲状腺相关眼病的诊断和活动性评估中很少被研究。有些研究者建立了甲状腺相关眼病诊断的深度学习模型,使用784(正常人:625,甲状腺相关眼病患者:168)组眼眶ct图像对模型进行训练,并以114组和227组眼眶ct作为验证集和测试集,该研究在甲状腺相关眼病的诊断任务中取得了良好的结果(准确度,87%;灵敏度,88%;特异性,85%)[参见:song x,liu z,li l,gao z,fan x,zhai g,et al.artificial intelligence ct screening model for thyroid-associated ophthalmopathy and tests under clinical conditions.international journal of computer assisted radiology and surgery.2021;16:323-30.]。然而,参与本研究的甲状腺相关眼病患者样本较少,同时对甲状腺相关眼病患者的活动性没有分期。

[0005]

另有研究者提出了一种基于深度卷积神经网络的算法,用于检测甲状腺相关眼病的活动性。使用160张甲状腺相关眼病患者的眼眶mri图像(50张活动性,110张非活动性)训练该模型,其中80%用于训练和验证,20%用于测试,得到的最佳模型的准确度、精确度、敏感性、特异性和f1评分分别为85.5

±

1.8%、64.0

±

3.3%、82.1

±

7.1%、86.5

±

4.0%和

0.72

±

0.04[参见:lin c,song x,li l,li y,fan x.detection of active and inactive phases of thyroid-associated ophthalmopathy using deep convolutional neural network.bmc ophthalmology.2021;21]。该研究者也承认其模型存在一定过拟合,同时该方法需要大量的人工参与辅助。

[0006]

实验证明,上述的这些方法在检测甲状腺相关眼病活动性的自动化程度和准确性上还有待提升。

技术实现要素:

[0007]

针对上述现有技术的不足,本发明提供一种基于spect/ct检测甲状腺相关眼病活动性的深度学习方法。

[0008]

为实现上述目的,本发明采用如下技术方案:

[0009]

一种基于spect/ct检测甲状腺相关眼病活动性的深度学习方法,包括眼外肌分割阶段和活动性分期的分类两个阶段,在眼外肌分割阶段,首先对眼部的ct图像进行三维重建,并训练眼外肌语义分割模型,最后使用训练好的眼外肌分割模型得到测试集中的眼外肌掩码;在判断甲状腺相关眼病是否处于活动期的分类阶段,将眼外肌掩码、spect和ct图像组成三通道数据,并使用三通道数据训练分类模型,将spect/ct图像和病人的眼外肌掩码结合成三通道图像输入分类模型,最终通过训练好的分类模型输出甲状腺相关眼病活动性,具体步骤如下:

[0010]

步骤(1):分别对spect图像和ct图像进行预处理,将spect图像和ct图像还原到真实大小;

[0011]

步骤(2):将ct图像划分为训练集、验证集和测试集,由多个有经验的操作人员手工勾画训练集和验证集ct图像中上直肌、下直肌、内直肌和外直肌轮廓,并由医生再次检查调整;

[0012]

步骤(3):构建用于眼外肌分割的sv-net语义分割网络,利用步骤(2)中的训练集和验证集对语义分割网络进行训练并评估,得到优化后的眼外肌分割模型;

[0013]

步骤(4):将测试集的ct图像输入到训练好的分割模型中,从而得到测试集ct图像的眼外肌掩码;

[0014]

步骤(5):利用步骤(1)中的spect、ct图像和步骤(4)中的眼外肌掩码组成三通道图像,并将数据划分为用于活动性分期的训练集、验证集和测试集;

[0015]

步骤(6):构建用于活动性分期的tao-net分类网络,利用活动性分期的训练集和验证集对分类网络进行训练并评估,得到优化后的活动性分期模型,最终得到甲状腺相关眼病患者的活动性分期。

[0016]

进一步地,步骤(1)中,首先,对spect图像和ct图像进行配准,统一spect图像和ct图像的像素间距,并将其统一在同一个三维坐标系下;其次,对spect和ct三维图像进行纵向切割,从而获得其冠状面。

[0017]

进一步地,步骤(3)中所述sv-net语义分割网络,是改进后的v-net网络,由解码器和编码器组成,编码器和解码器由卷积核大小为3

×3×

3的卷积层组成,不同层次的编码器从图像中获取到不同深度的特征,这些特征再由编码器还原到原始图像的大小,从而得到眼外肌的概率图,对概率图进行阈值为0.5的阈值分割,转化为二进制分割结果,二进制图

像是眼外肌的掩码。

[0018]

进一步地,步骤(6)中所述的tao-net分类网络是基于三维残差模块搭建的,tao-net包括卷积模块、残差模块和分类器模块,卷积模块,从图像中获取到浅层次的特征;残差模块,由两个三维残余块组成,在每个三维残余块中,三维特征图被传递到具有批处理规范层的三维卷积和包含三维卷积的残差连接中;分类器模块,包含三个三维卷积层和一个具有softmax激活函数的全连接层;残差模块获取到的特征图被送入到分类器模块中进行学习,为得到的特征重新分配权重,最终特征通过全连接层输出分类的结果。

[0019]

本发明的有益效果:

[0020]

(1)与现有技术相比,本发明使用了两阶段的深度学习方法,首先通过分割网络获取了患者的眼外肌二值图,并将其与spect/ct图像组成三通道图像输入到分类网络中。眼外肌掩码作为先验知识加入到模型的训练中,指导模型的优化,让模型更加关注患者眼外肌处的区域。

[0021]

(2)与现有技术相比,本发明使用了多模态的图像,相较于单种模态的图像,多模态的图像能够提供更多信息,具体来说,spect图像提供了患者功能特征,ct图像提供了患者的形态特征。

附图说明

[0022]

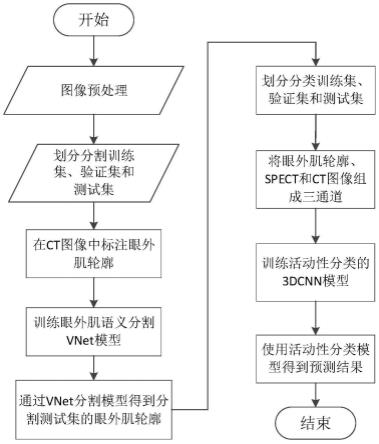

图1是本发明基于spect/ct检测甲状腺相关眼病活动性的深度学习方法;

[0023]

图2(a)是手动勾画ct图像中眼外肌轮廓的示意图;图2(b)是根据眼外肌轮廓生成的二值图;

[0024]

图3是sv-net网络的构造;

[0025]

图4是tao-net网络的构造。

具体实施方式

[0026]

下面将结合本发明实施例中的附图,对本发明实施例中的技术方案进行清楚、完整地描述。

[0027]

实施例:

[0028]

如图1所示,一种基于spect/ct检测甲状腺相关眼病活动性的深度学习方法,包括眼外肌分割阶段和活动性分期的分类两个阶段,在眼外肌分割阶段,首先对眼部的ct图像进行三维重建,并训练眼外肌语义分割模型,最后使用训练好的眼外肌分割模型得到测试集中的眼外肌掩码;在判断甲状腺相关眼病是否处于活动期的分类阶段,将眼外肌掩码、spect和ct图像组成三通道数据,并使用三通道数据训练分类模型,将spect/ct图像和病人的眼外肌掩码结合成三通道图像输入分类模型,最终通过训练好的分类模型输出甲状腺相关眼病活动性;具体步骤如下:

[0029]

步骤(1):分别对spect图像和ct图像进行预处理,将spect图像和ct图像还原到真实大小。

[0030]

首先,对spect图像和ct图像进行配准,统一spect图像和ct图像的像素间距,并将其统一在同一个三维坐标系下;其次,对spect和ct三维图像进行纵向切割,从而获得其冠状面。为了增强图像对比度,将每张冠状面图像灰度值变换到0-255区间范围内,使用标准

归一化公式:

[0031][0032]

其中,f(x,y)为输入图像的灰度值,g(x,y)指经过图像处理后图像的灰度值,i

max

表示图像的最大灰度值。

[0033]

步骤(2):将ct图像划分为训练集、验证集和测试集。由于手动勾画所有病人的眼外肌轮廓是十分耗时耗力的,因此从所有数据中随机挑选出20%的ct图像手动勾画眼外肌轮廓,剩余80%的ct图像作为分割测试集。由多个有经验的操作人员手工勾画训练集和验证集ct图像中上直肌、下直肌、内直肌和外直肌轮廓,如图2(a)所示,并由医生再次检查调整;根据这些眼外肌轮廓生成训练所需要的二值图,如图2(b)所示,其中背景为0,眼外肌处为1,这些二值图被作为分割金标准。

[0034]

步骤(3):构建用于眼外肌分割的sv-net语义分割网络,利用步骤(2)中的训练集和验证集对语义分割网络进行训练并评估,得到优化后的眼外肌分割模型。具体如下:

[0035]

使用基于python语言的pytorch框架搭建sv-net网络,输入为256

×

256

×

n的三维图像,其中n为冠状面图像的张数。sv-net详细结构如图3所示。sv-net语义分割网络,是改进后的v-net网络,由解码器和编码器组成,编码器和解码器由卷积核大小为3

×3×

3的卷积层组成,不同层次的编码器从图像中获取到不同深度的特征,这些特征再由编码器还原到原始图像的大小,从而得到眼外肌的概率图,对概率图进行阈值为0.5的阈值分割,转化为二进制分割结果,二进制图像是眼外肌的掩码。

[0036]

选用的损失函数和评估指标均为dice相似系数,用来评估预测结果与标签之间的差异。定义为:

[0037][0038]

其中p

ij

和q

ij

分别表示图像中像素点(i,j)的预测输出值和标签值。

[0039]

训练过程中学习率被设置为0.0001,迭代次数为600,批大小为8,利用步骤(2)中的分割训练集对sv-net模型进行训练,得到收敛后的权重,并将验证集中的样本输入训练好的sv-net模型进行评估,得到眼外肌分割的预测结果和金标准之间的平均dice系数为0.92。

[0040]

步骤(4):将测试集的ct图像输入到训练好的分割模型中,从而得到测试集ct图像的眼外肌掩码。

[0041]

步骤(5):利用步骤(1)中的spect、ct图像和步骤(4)中的眼外肌掩码组成三通道图像,并将数据划分为用于活动性分期的训练集、验证集和测试集。从所有数据中随机挑选20%的数据作为分类测试集,剩余数据通过五折交叉验证划分为分类训练集和验证集。

[0042]

步骤(6):构建用于活动性分期的tao-net分类网络,利用活动性分期的训练集和验证集对分类网络进行训练并评估,得到优化后的活动性分期模型,最终通过优化后的活动性分期模型得到得到甲状腺相关眼病患者的活动性分期。

[0043]

tao-net分类网络是基于三维残差模块搭建的,如图4所示,将spect、ct和眼外肌掩码作为输入的三维神经网络,tao-net包括卷积模块、残差模块和分类器模块。卷积模块

由一个普通的三维卷积(内核大小为5

×7×

7)、一个批处理规范层和一个池层组成,从图像中获取到浅层次的特征。内核大小5

×7×

7的设置遵循alexnet和resnet,这有助于保存丰富的本地视觉信息。残差模块,由两个三维残余块组成,在获取图像深层次特征的同时避免了梯度消失的出现;在每个三维残余块中,三维特征图被传递到具有批处理规范层的三维卷积和包含三维卷积的残差连接中。分类器模块,包含三个三维卷积层和一个具有softmax激活函数的全连接层。残差模块获取到的特征图被送入到分类器模块中进行学习,利用神经网络的学习能力,为得到的特征重新分配权重,最终特征通过全连接层输出分类的结果。

[0044]

为验证本发明所提出的方法的性能,将测试集中的样本输入训练好的tao-net模型,并采用准确度、灵敏度、f1评分和auc评估其结果,具体结果如下表所示。

[0045] 准确度(%)灵敏度(%)f1评分auc验证集85.01

±

2.3583.63

±

1.540.83

±

0.020.919

±

0.09测试集83.35

±

1.5384.63

±

0.840.83

±

0.010.923

±

0.10现有的方法64.00

±

3.3082.10

±

7.100.72

±

0.040.890

±

0.31

[0046]

由实验数据发现,本发明提出的方法在四项指标领先于其他方法,能够准确的对甲状腺相关眼病活动性进行评估。

[0047]

本发明不局限于上述最佳实施方式,任何人在本发明的启示下都可得出其他各种形式的产品,但不论在其形状或结构上作任何变化,凡是具有与本技术相同或相近似的技术方案,均落在本发明的保护范围之内。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1