自注意力路由胶囊网络的方面级情感分析方法

1.本发明涉及神经网络分类技术领域,具体涉及自注意力路由胶囊网络的方面级情感分析方法,适用于句子中一个或多个提到的实体的情感标签识别。

背景技术:

2.方面级情感分类(asc)任务旨在识别句子中一个或多个提到的实体的情感标签,这是基于方面的情感分析(absa)的关键细粒度变体子任务。例如,一句话写为“天气很好,但交通很拥挤。”在“天气”和“交通”两个实体,他们相应的情感极化分别是积极的和消极的。与文档级情感分类(dsc)相比,asc任务旨在预测特定方面而不是整个句子的情感极性。

3.传统的情感分类方法大多利用机器学习算法构造具有精心提取特征的情感分类器,这需要花费大量的时间和资源来收集。近年来,各种深度神经网络(dnn)由于其显著的结果,已经对asc任务进行了建模,主要包括基于注意力的方法、基于语法的方法和基于预训练bert的方法。例如,基于lstm的模型利用注意机制来建模方面特征和lstm隐藏单元之间的依赖关系。基于图的模型用于将语法邻域词信息传播到方面信息。基于bert的方法得益于预训练模型的强大表示能力。

4.此外,由于其capsule向量和用于适当存储和聚类特征的动态路由方法,capsule网络已被用于asc任务。与分布式神经网络相比,胶囊网络不仅可以用矢量输出胶囊代替标量输出特征检测器,而且可以保留额外的信息,如相位的频率和位置信息。例如,transcap将胶囊网络与归纳转移学习相结合,成功解决了asc任务中的数据稀缺问题。capsnet利用一种新的方面感知归一化方法来选择主胶囊,以避免特征丢失。然而,在通过胶囊网络的asc任务中仍然存在一个需要解决的问题。这是胶囊网络中原有的动态路由机制,由于路由的迭代过程,其训练效率低下。

技术实现要素:

5.本发明的目的在于针对现有技术存在的上述问题,提供自注意力路由胶囊网络的方面级情感分析方法。

6.为了实现上述的目的,本发明采用以下技术措施:

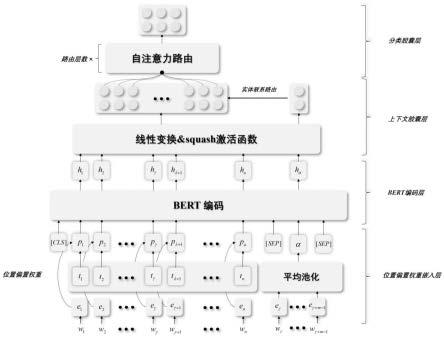

7.基于自注意力路由胶囊网络的方面级情感分析方法,包括以下步骤:

8.步骤1、选取基准数据集,对基准数据集进行预处理并生成训练集和测试集,训练集中的每个样本包括句子和句子中的一个实体;

9.步骤2、通过预训练的glove模型对句子和对应的实体进行词向量化,获得句子的词向量和实体的词向量;

10.步骤3、根据句子的词向量和实体的上下文之间的相对位置信息ti,计算实体的增强表示p={p1,p2,

…

,pn},n为句子的单词长度;

11.步骤4、通过预训练的bert encoder模型对实体的增强表示p={p1,p2,

…

,pn}和实体的词向量进行编码,获得上下文表示h=[h1,h2...,hn]和实体表示h

α

;

[0012]

步骤5、根据上下文表示h=[h1,h2...,hn]和实体表示h

α

构建上下文胶囊ci和实体胶囊a,根据上下文胶囊ci和实体胶囊a计算上下文胶囊的实体相关权重oi,i∈{1~n};

[0013]

步骤6、将得到的上下文胶囊ui作为第一层分类胶囊层中的各个分类胶囊,相邻层的分类胶囊层之间经过自注意力路由层连接,最后一层分类胶囊输出最终的情感标签分类结果。

[0014]

如上所述步骤3中,第i个单词相对于实体的位置偏差权重ti基于以下公式:

[0015][0016]

其中,m和n分别表示实体和句子的单词长度,γ是实体第一个单词的位置下标,

[0017]

pi=ti·ei

[0018]

其中,i∈{1~n},ei是句子的词向量e={e1,e2,

…

,en}中第i个单词的词向量。

[0019]

如上所述步骤5中,基于以下公式构建上下文胶囊ci和实体胶囊a:

[0020]ci

=squash(whhi+bh)

[0021]

a=squash(wah

α

+ba)

[0022]

其中,wh,bh,wa和ba均是学习参数,squash()是非线性挤压函数。

[0023]

如上所述步骤5中,基于以下公式计算上下文胶囊的实体相关权重oi:

[0024][0025]

其中,wo是学习参数,oi是上下文胶囊的实体相关权重,d是预定义的上下文胶囊层中胶囊的个数,d小于n,

[0026]

如上所述步骤5中与实体相关的上下文胶囊ui=ci·

oi。

[0027]

如上所述步骤6中,第l+1层分类胶囊u

l+1

基于以下公式:

[0028][0029]

其中,为第l层分类胶囊计算得到的预测结果,t为转置操作,c

l

是系数矩阵,b

l

为随机初始化得到的对数先验矩阵,

[0030][0031]

其中,a

l

为耦合系数,n

l

、n

l+1

分别为第l、l+1层分类胶囊的个数,

[0032]

[0033]

其中,为平衡系数。

[0034]

如上所述步骤6中最后一层的分类胶囊由分类胶囊组成,其中j为实体的情感标签yj的序号,分类胶囊的激活概率

[0035]

最后一层分类胶囊的损失为c为情感标签的总种类数,以优化得到最小损失l为目标,使用adam优化器对分类胶囊的网络参数进行优化,

[0036]

lj为最后一层分类胶囊的每个分类胶囊的损失函数:

[0037]

lj=tjmax(0,m

+-||vj||)2+λ(1-tj)max(0,||vj||-m-)2[0038]

其中,λ,m

+

和m-均为超参数,若最后一层的第j个分类胶囊的vj值最大值时,对应的tj=1,否则tj=0。

[0039]

本发明相对于现有技术,具有以下有益效果:

[0040]

1、通过位置偏差权重构建了实体的增强表示,这充分显示了该机制在限制实体和上下文之间的相关信息方面的有效性;

[0041]

2、提出了一种新的基于自注意力路由机制的分类胶囊,克服了训练效率低的缺点,可以更多地关注特定的实体特征;

[0042]

3、引入预训练的bert encoder模型,以利用大规模预训练的优势。实验结果和详细分析表明了本发明方法的机制的有效性。

附图说明

[0043]

图1是本发明的完整的原理以及系统架构;

[0044]

图2是本发明的自注意力机制原理图;

[0045]

图3是“hello”和“world”的300维glove词向量中截取前五维示例图;

[0046]

图4是本发明所使用的位置偏差权重在一个示例句子上的具体表示;

[0047]

图5是本发明的自注意力路由层数对效果的影响;其中(a)为层数-准确率acc.(accuracy)的影响示意图;(b)为层数-宏观平均f1分数(macro-averaged f1-score)的影响示意图。

具体实施方式

[0048]

为了便于本领域普通技术人员理解和实施本发明,下面结合实例对本发明作进一步的详细描述,此处所描述的实施示例仅用于说明和解释本发明,并非是对本发明的限制。

[0049]

自注意力路由胶囊网络的方面级情感分析方法,包括以下步骤:

[0050]

步骤1,选取基准数据集,对基准数据集进行预处理并生成训练集和测试集,训练集和测试集中的样本为基准数据集中的基准数据,每个基准数据对应一个情感标签,基准数据集涉及多种情感标签;

[0051]

本发明的相关实验基于python 3.6的pytorch环境,pycharm2020.2.2(professional edition),基准数据集为cuda v11.1,cudnn v8.0.4,pytorch v1.7。

[0052]

本实施例中的基准数据集为三个absa基准数据集,包括semeval2014笔记本电脑数据集、semeval2014餐厅数据集以及twitter数据集。本实施例中,基准数据集中涉及的情

感标签包括积极、中性和消极。这三个基准数据集的从大到的顺序是twitter数据集、semeval2014餐厅数据集和semeval2014笔记本电脑数据集。此外,严格遵循先前研究的数据集配置。数据集的统计数据见表1。这些数据集是在关系提取领域中广泛使用的基准。

[0053]

表1训练集中的样本对应的情感标签表

[0054][0055]

训练集中的样本对应的情感标签包括:积极positive,消极negative,中性neutral。训练集和验证集中的样本对应的情感标签如表1以及表2所示。

[0056]

表2测试集中的样本对应的情感标签表

[0057][0058]

在实验中使用的评估指标基于准确率acc.(accuracy)和宏观平均f1分数(macro-averaged f1-score),准确率acc.和宏观平均f1分数是基准数据集的官方评估指标,用来判断模型的优劣。

[0059]

其中餐厅数据集中一个样本如表3所示,在基准数据集中,一个样本是由一个句子和句子中某一个实体及其位置信息组成的,因为一个句子中存在多个实体,所以针对一个句子中的不同实体,每个实体与句子的组合都可以构成一个单独的样本,实体可能是一个单词,也可能是连续的多个单词组成的词。

[0060]

表3样本示例

[0061][0062]

在基准数据集每一个样本基准数据中,都用单独的一个位置下标数组记录了上下文(单词)和实体的相对位置。

[0063]

(2)数据预处理

[0064]

本发明将对semeval-2014restaurant&laptop和twitter标准数据集进行预处理以适配代码后续运行,将其转换为特殊的json文件格式进行标注。

[0065]

表4预处理数据样本示例

[0066][0067]

句子进行分词处理并去除句子中的无关符号、空格得到分词后的句子,对于分词后的句子,使用特定的json格式进行标注,具体操作为:1.将分词后的句子的各个单词作为对应的单词列表,其中分词后的句子中的每个单词作为列表中的每一个元素,分词后的句子的各个单词的位置下标作为对应的位置下标列表,与句子中的单词一一对应。而后并单独的抽取出句子中的实体,记录实体在分词后的句子中的起始位置下标与结束位置下标。处理结果如表4所示,经过了本步骤处理后的句子与其中一个实体,共同的组成了一个样本,多个实体与其属于的句子,共同组成了多个样本。预处理后得到的数据就是这样的句子、实体对组成的样本集合。

[0068]

步骤2,通过输入层的预训练的glove-300d模型对句子和对应的实体进行词向量化,获得句子的词向量和实体的词向量;

[0069]

输入层

[0070]

在输入层,将对上述预处理好的样本的句子和实体进行向量化。在预处理过程中,对实体在上下文中的位置进行了标注,其中实体是方面级情感分类任务分析的目标,它属于原始输入句子的一部分,通常由一个或多个单词组成,处理得到生成完整的句子映射表和实体映射表,用于后续程序处理,并将句子映射表和实体映射表编码修改为utf-8编码;同时也去除句子映射表和实体映射表中的重复句子,进一步生成对应的句子的词向量和实体的词向量。

[0071]

预训练的glove-300d模型旨在将输入句子的语义信息和实体信息转换为词向量,

[0072]

其中,输入句子用s={w1,w2,

…

,wn}表示,其中n为样本中构成句子的单词长度,w1,w2,

…

,wn为句子中的各个单词。

[0073]

a={w

γ

,w

γ+1

,

…

,w

γ+m-1

}表示句子中一个实体,其中γ为实体在输入句子中第一次出现时的单词的下标,m为该样本中构成实体的单词总数。

[0074]

为了使预训练的glove-300d模型能够捕捉到更准确的语义信息,本技术预训练的glove-300d模型采用了维度是dw的glove词嵌入预训练语言模型,glove的工作对自然语言的各项任务都有着很好的提升,其每个词对应一个向量,词向量是静止不变的。通过这层,可以分别得到句子的词向量e={e1,e2,

…

,en}和实体的词向量e

α

,其中,e1,e2,

…

,en分别为w1,w2,

…

,wn对应的词向量。

[0075]

其中值得注意的是,由于一个实体可能不仅仅只有一个单词构成,所以实体的嵌入表示e

α

的计算结果为构成实体的各个单词嵌入表示的平均池化后的指,这里嵌入表示是glove对实体中每个单词映射得到的词向量。。

[0076]

在实验过程中,本情感分析模型中的单词的维度要和glove的词向量的维度大小

一致,示例句子如图1所示。

[0077]

实验中glove词向量相关的参数如表5所示。

[0078]

表5词向量相关参数表

[0079]

超参数描述值de词向量维度大小300vocabs词表的大小2.2m

[0080]

步骤3,根据句子的词向量和实体的上下文之间的相对位置信息ti,计算实体的增强表示p;

[0081]

位置偏置权重

[0082]

为了获得胶囊网络的实体增强输入,利用相对位置信息来计算上下文单词的权重。利用一种新的位置偏差权重方法来表示实体及其上下文之间的相对位置信息ti。具体描述为,通过实体和上下文之间的相对位置信息来计算上下文词的位置偏差权重,其用于降低距离体相对较远的词的重要性,并提高距离实体较近的词的重要性:

[0083][0084]

其中m和n分别表示实体和句子的单词长度,γ是实体第一个单词的位置下标。ti表示第i个单词相对于实体的位置偏差权重。因此,可以细化并生成一个实体的增强表示p={p1,p2,

…

,pn},pi可以计算为:pi=ti·ei

,其中ei是句子的词向量e={e1,e2,

…

,en}中第i个单词的词向量。一个句子和一个实体构成单独的一个样本,所以一个样本只有一个γ。

[0085]

由于asc任务对实体特征抽取的必要性,实体与上下文单词之间的位置信息对整个模型效果来说至关重要,对于远离实体的上下文单词,其对实体的影响相对来说较小。而对于近距离的上下文单词,其对实体的情感标签起着相对来说更加重要的作用。

[0086]

位置偏置机制就是基于这样的事实,对实体以及其上下文单词进行权重计算,赋予相对距离实体近的上下文单词更大的权重,赋予相对实体远的上下文单词稍小的权重,以此在句子中添加了一定的位置信息,进一步提升模型的信息获取能力。图2为一个示例句子及其计算得到单词的相对于实体的位置偏差权重ti。

[0087]

根据公式(1),我们可以得知改示例句子的单词长度n为12,实体“food”的长度m为1,其起始下标γ为5,所以根据公式可得到如图2所示每个单词的相对于实体的位置偏差权重ti。

[0088]

位置偏置机制的参数描述如表6所示。

[0089]

表6位置偏置机制的参数描述

[0090][0091]

步骤4:通过预训练的bert encoder模型对实体的增强表示p={p1,p2,

…

,pn}和实体的词向量进行编码,获得上下文表示h=[h1,h2...,hn]和实体表示h

α

;

[0092]

bert-encoder模型

[0093]

基于大规模语料库训练的预训练模型显示出较强的语义表达能力。为了利用预训练模型,编码器层利用了预训练的bert编码层。在这种情况下,bert编码层将“[cls]+句子的嵌入表示+[sep]+实体的嵌入表示+[sep]”作为输入seg,其中,句子的嵌入表示是实体的增强表示p,实体的嵌入表示是实体的词向量e

α

,[cls]和[sep]分别表示开始和结束标记。因此,本发明可以利用预训练的bert encoder模型提供的额外知识来构建上下文表示h=[h1,h2...,hn]和实体表示h

α

:

[0094]

h,h

α

=bert(seg)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(2)

[0095]

本发明使用预训练bert对经过位置偏置增强信息的输出进行信息提取、编码,bert是基于transformer的双向编解码结构,以往的预训练模型的结构会受到单向语言模型(从左到右或者从右到左)的限制,因而也限制了模型的表征能力,使其只能获取单方向的上下文信息。而bert利用mlm进行预训练并且采用深层的双向transformer组件来构建整个模型,因此最终生成能融合左右上下文信息的深层双向语言表征。

[0096]

本发明中使用的预训练bert版本是bert-base,其相关的参数如下表所示:

[0097]

表7 bert-base参数

[0098]

超参数描述值ltransformer编码器数量12a多头注意力数量12h隐藏层维度762

[0099]

步骤5:根据上下文语义表示h=[h1,h2...,hn]和上下文胶囊的实体相关权重计算实体相关的上下文胶囊ui,根据实体表示h

α

计算实体胶囊a;

[0100]

上下文胶囊层

[0101]

在这一层中,利用线性变换和非线性挤压函数将前面通过bert encoder模型得到的上下文表示h=[h1,h2...,hn]转换为上下文胶囊。此外,为了构造与实体相关的上下文胶囊,利用与实体相关的路由方法通过实体胶囊选择重要的上下文胶囊。

[0102]

非线性挤压函数是一种非线性主动函数,可以将胶囊的长度限制在[0,1]中,可以表示为表示胶囊的当前输入语义的概率。非线性挤压函数的定义如等式(3)所示,其中z是非线性挤压函数的输入。

[0103]

[0104]

因此,可以分别按照等式(4)和等式(5)构建上下文胶囊ci和实体胶囊a,其中hi是通过步骤4的bert encoder得到的上下文表示h=[h1,h2...,hn]中每个单词的语义表示:

[0105]ci

=squash(whhi+bh)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(4)

[0106]

a=squash(wah

α

+ba)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(5)

[0107]wh hi+bh和wah

α

+ba分别整体的作为非线性挤压函数的输入z,其中,wh,bh,wa和ba均是可学习学习参数。利用融合卷积运算来计算上下文词的纵横比权重,这无法更新权重,导致训练过程不稳定。为了解决这个问题,本发明利用“方面相关路由方法”利用下面公式,修改相关路由的权重,来计算等式(6)中的上下文胶囊的实体相关权重oi:

[0108][0109]

其中wo是一个可学习的学习参数,oi是上下文胶囊的实体相关权重,d是预定义的上下文胶囊层中胶囊的个数,d小于输入的上下文表示的长度n,用来进一步抽取信息。据此,可以得到与实体相关的上下文胶囊ui=ci·

oi。

[0110]

在卷积神经网络中,其使用卷积核对图像进行卷积运算产生一个n*n的结果,可以看作是卷积核重复对图像每个局部的内容进行提取后得到的结果,之后通过池化得到神经元的活动(标量),实现视角不变性。在这个过程中,池化掉丢了数据中的大量信息,即使对图像进行一些调整,也可能产生相似的结果.胶囊网络是为了解决卷积神经网络存在的问题而提出的。不同于卷积神经网络用标量记录局部信息,胶囊网络使用向量特征状态的重要信息。上下文胶囊层通过公式(3)所示的squash激活函数,将输入数据转换为向量特征状态。有关上下文胶囊层的参数设置如表8所示。

[0111]

表8自注意力机制的相关参数以及特征参数设置

[0112]

超参数描述值n_epoch训练轮次数25n_stop提前结束训练的轮次数5dim_context上下文胶囊维度16

[0113]

步骤6:将得到的上下文胶囊ui作为第一层分类胶囊层中的各个分类胶囊,相邻层的分类胶囊层之间经过自注意力路由连接。最后一层分类胶囊输出最终的情感标签分类结果。

[0114]

分类胶囊层

[0115]

经典的胶囊网络中的原始动态路由机制与自我迭代过程一样工作,这使得训练效率低下。

[0116]

在这一层中,本发明利用一种新的自注意力路由机制将活动胶囊路由到它们应该属于的目标类。具体来说,自注意力路由可以保持多个胶囊层的存在不变,并堆叠在彼此的顶部,以创建更深层次。如图3所示,目标胶囊层的结构非常类似于全连接网络,关键点是通过自注意力算法获得的附加分支。为了对下一层进行预测,第l层的分类胶囊集合u

l

的每个分类胶囊与随机初始化的权重矩阵w

l

进行矩阵乘法计算得到第l层分类胶囊所能得到的预测结果其中l表示分类胶囊的层数序号,u

l

表示第l层的所有分类胶囊集合,在与上下

文胶囊层连接的第一层的分类胶囊中,第1层的分类胶囊即为各个上下文胶囊ui。w

l

表示用于第l层分类胶囊计算的权重矩阵,后文中l+1层的各项参数与之类似。:

[0117][0118]

其中,为第l层分类胶囊计算得到的预测结果,t为转置操作。此外,可以使用等式(8)计算下一层的分类胶囊u

l+1

:

[0119][0120]

其中b

l

是一个随机初始化得到的对数先验矩阵,包含所有权重作为其他可学习权重,这有助于创建对活动胶囊的偏好。c

l

是一个自注意力算法得到的系数矩阵,该自注意力算法可以动态地将检测到的实体特征分配给它们在特定传感器中表示的目标胶囊。使用等式(9)从自注意力张量开始计算耦合系数a

l

:

[0121][0122]

其中,平衡系数用于稳定训练并保持耦合系数和对数先验之间的平衡。每个自注意力张量a

l

包含每个分类胶囊预测组合的得分一致性,因此,它们可以用于计算所有耦合系数。等式(10)用于计算耦合系数c

l

,耦合系数可在等式(8)中使用,以获得第l+1层的所有胶囊u

l+1

。

[0123][0124]

其中n

l

、n

l+1

分别为第l、l+1层分类胶囊的个数。

[0125]

最后一层的分类胶囊集合u

last

,其由分类胶囊组成,其中j为实体的情感标签yj的序号,在最后一层用来表示最后一层的分类胶囊的序号。对应用非线性挤压函数以获得最终表示vj:

[0126][0127]

vj的长度限制在[0,1]之间,以表示分类胶囊的激活概率。

[0128]

综上,自注意力路由是一个可叠加多层的,类似全连接层的结构。其额外的分支就是一个自注意力权重的计算,它可以将重要的胶囊信息传输到下一层,同时也关闭不重要的胶囊传送的通道。

[0129]

对取得最优效果的自注意力路由参数设置,如表所示。

[0130]

表9自注意力路由参数设置

[0131]

超参数描述值dim_class分类胶囊维度24n_class分类胶囊数3attn_layer自注意力路由层数2

[0132]

自注意力层对模型效果的影响,具体实验结果如图所示。为了研究自注意力路由层数的影响,在推特、笔记本电脑和餐馆数据集上评估了一到六层的ascaps-bert模型。如图4所示,本实施例自注意力路由层数为2。很明显,当层数过多时,模型将变得不稳定,这是由信息冗余和消失梯度引起的。当层次较小时,体特征和句子表示不能传播很远,导致训练不完整。

[0133]

六、margin损失函数

[0134]

本实施例中采用的损失函数是marginloss损失函数,每个分类胶囊的长度用于表示情感标签的概率,因此可以得到最后一层分类胶囊的每个分类胶囊的损失函数lj,其中j为实体的情感极性yj的序号,在最后一层分类胶囊用来表示分类胶囊的序号:

[0135]

lj=tjmax(0,m

+-||vj||)2+λ(1-tj)max(0,||vj||-m-)2ꢀꢀ

(12)

[0136]

其中,情感标签缺失由超参数λ控制,若最后一层的第j个分类胶囊的vj值最大值时,对应的tj=1,否则tj=0。在本实施例中,超参数λ,m

+

和m-分别设置为0.5,0.9,0.1。此时,计算最后一层分类胶囊的损失为以优化得到最小损失l为目标,使用adam优化器对分类胶囊的网络参数进行优化。其中c为情感标签的总种类数,即yj的数量,在本实施例中为3,分别表示积极、消极、中性,将不重要的胶囊关闭的过程即计算最后一层分类胶囊的情感标签可能大小的过程,将最后一层分类胶囊的激活概率最大的情感标签的将作为预测结果。

[0137]

实验对比:

[0138]

本发明在实验过程中将以下分类方法与本发明进行比较。

[0139]

atae-lstm:

[0140]

atae-lstm在方面级情感分类中利用方面嵌入和注意机制,是一个基于注意力机制的神经网络模型,在几个基准数据集上中取得了顶尖的成绩。

[0141]

ian:

[0142]

ian采用两个lstm和一个交互式注意机制来生成体和句子的表示。

[0143]

ram:

[0144]

ram使用多注意力和记忆网络学习句子表示。

[0145]

mgan:

[0146]

mgan设计了一种多粒度注意机制来捕获方面和上下文之间的词级交互。

[0147]

asgcn:

[0148]

gcn首先提出使用gcn学习基于方面的情感分类的方面特定表示。

[0149]

bigcn:

[0150]

bigcn使用层次图结构来集成单词共现信息和依存类型信息。

[0151]

cdt:

[0152]

cdt利用依赖树上的gcn学习具有语法信息的方面表示.

[0153]

bert-spc:

[0154]

bert-spc在基础的bert模型上,设计了一个更为精细的预测分类层。

[0155]

bert-pt:

[0156]

bert-pt是通过输入句子体对并使用[cls]的表示进行预测的vanilla-bert模型。

[0157]

capsnet-bert:

[0158]

capsnet-bert首次将胶囊网络引入到方面级情感分类任务中。

[0159]

表10分类方法与本发明进行比较结果图

[0160][0161]

实验结果分析本发明提出的ascaps-bert模型在推特、餐馆和笔记本电脑数据集上的性能优于语法增强和基于注意力的方法。这些结果表明,ascaps-bert能够捕捉句子的位置偏差信息,并有效地选择重要的实体特征。此外,提出的ascaps-bert准确地拟合了包含正式、非正式或复杂审查的数据集。与基于注意力的方法(如mgan、ian、ram和atae-lstm)相比,ascaps-bert模型利用位置偏差信息建立方面和上下文之间的依赖关系,从而可以提供语法信息并克服注意力机制影响的噪声。此外,语法增强方法,如cdt、bigcn、asgcn,优于所有基于注意力的方法,但它们忽略了方面之间的语义相关性。然而,当考虑非正式或复杂句子时,仅使用句法知识会导致性能较差。在表3中,最后一组的结果表明,基本bert优于大多数基于rnn编码器和静态文字嵌入的模型。此外,基于bert,我们的ascaps bert实现了更好的性能。

[0162]

需要指出的是,本发明中所描述的具体实施例仅是对本发明精神作举例说明。本发明所属技术领域的技术人员可以对所描述的具体实施例作各种各样的修改或补充或采用类似的方式替代,但并不会偏离本发明的精神或超越所附权利要求书所定义的范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1