一种基于注意力网络的跨模态情感分析方法

本发明涉及自然语言处理、计算机视觉领域及情感分析,具体的说是涉及一种基于注意力网络的跨模态情感分析方法。

背景技术:

1、随着各类网络社交平台以及网络技术的发展,用户在网络上发表言论的方式更加多样化,越来越多的用户选择用视频、图片或者文章来表达自己的情感和观点。如何分析这些多模态信息当中蕴含的情感倾向、舆论导向成为情感分析领域所面临的挑战。然而,由于多模态数据的异构性和异步性,融合多模态信息并不容易。就异构性而言,不同模态存在不同的特征空间中。就异步性而言,不同模态的时间序列数据采样率不一致导致无法获得不同模态之间的最佳映射。现在已经有许多关于多模态分析的研究,具体方法可以归纳为以下两类:一种是采用跨模态注意力来提供不同模态之间的软映射,从而对多模式数据的异步性进行建模。然而,这类方法没有考虑多模态数据的异质性。另一类则考虑多模态数据异质性。这一类别中的方法将每个模态分为模态的共享部分和模态的私有部分,由不同的神经网络表示。这些方法的局限性在于它们没有考虑不同模式之间的异步性。

技术实现思路

1、为了解决多模态异构性和异质性的问题,本发明提出了一种基于注意力网络的跨模态情感分析方法,采用模态对齐模块以及模态更新模块,并利用注意力机制,进行跨模态交互,从而提高多模态情感分析的准确性。

2、为了达到上述目的,本发明是通过以下技术方案实现的:

3、本发明是一种基于注意力网络的跨模态情感分析方法,具体包括以下步骤:

4、步骤1:提取输入图片文本对应的图片特征和图片文本特征;

5、步骤2:提取的图片文本特征进入模态更新层,每个所述模态更新层包括一个用于对齐表示空间的模态对齐模块和两个模态更新模块,每个模态在所述模态对齐模块内对齐,对齐后进入所述模态更新模块,通过利用不同模态的相关性逐步补充,最终获得交互后的图片特征和文本特征;

6、步骤3:将步骤2中所获得的交互后的图片特征和文本特征采用自注意力机制进行多模态融合,得到多模态特征;

7、步骤4:将步骤1中的图片特征和图片文本特征与步骤3中的融合后的多模态特征进行concat操作,进行情感预测。

8、优选的:步骤2具体包括如下步骤:

9、步骤2.1:模态对齐模块在模态交互前对齐不同模态的特征空间,得到多模态信息;

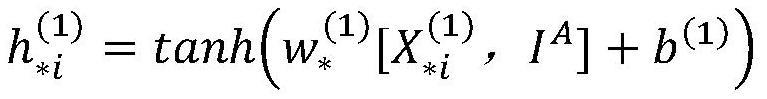

10、步骤2.2:对齐后的多模态信息进入模态更新模块,逐步增强每个模态,每个模态更新层包含两个模态更新模块和即文本更新模块和图片更新模块,为了使文本和视觉特征更专注于给定方面的信息部分并抑制不太重要的部分,在模态更新层的第一层采用了方面引导的注意力方法,具体过程如下:

11、

12、其中代表生成的目标模态的隐藏表征,ia代表方面特征向量,b(1)代表可学习参数,表示可变参数,表示模态向量;

13、计算归一化注意权重:

14、

15、使用注意力权重对目标模态的特征向量进行加权平均,得到新的目标模态向量

16、步骤2.3:为了捕捉不同模态间的双向交互,增强模态间的交互,模态更新模块引入了跨模态注意力机制以及自注意力机制,增强目标模态的具体过程如下:

17、

18、其中,*代表要增强的目标模态,α则代表补充模态,如果目标模态是文本,那补充模态则是图片,公式如下:

19、

20、

21、其中,samul,cmamul和att分表代表多头自注意力机制、多头跨模态注意力机制和归一化函数以及加性注意力机制,为了更好的融合图片和文本模态,本发明使用加性注意力机制,具体表示如下:

22、

23、

24、

25、其中g,wc,bc代表可学习参数,每个模态更新模块的权重都是通过加性注意力机制动态计算获得,从而达到两个模态间信息交互的目的,最终获得曾强后的多模态序列和

26、为了学习多模态特征的深度抽象表征,采用gru将交互注意力机制后的结果与当前层的输入结合起来,在第n层中首先使用跨模态注意力机制以及自注意力机制获得增强后的多模态序列,然后使用gru获得新的文本和图片特征,其中,n不包括第一层,第一层采用方面引导注意力机制,具体过程如下:

27、

28、其中:samul代表多头自注意力机制,为目标模态向量,n代表层数。

29、优选的:在所述步骤3,将步骤2中所获得的图片特征和文本特征采用自注意力机制进行多模态融合,具体表示如下:

30、

31、其中:均表示多模态序列,fc是融合多模态函数。

32、优选的:步骤4具体为:将步骤1和步骤3中的文本特征、图片特征和融合后的多模态特征进行concat操作得到包含三种特征表示emul作为输入数据:

33、emul=concat(xmul,xl,xv)

34、使用全连接网络对数据进行特征融合,并在最后一层使用softmax分类器进行情感预测,情感预测计算公式如下:

35、p=softmax(wme+bm)

36、其中wm代表全连接层的权重,bm代表偏置,p代表情感预测。

37、优选的:采用vgg16网络提取图片特征的具体过程如下:

38、步骤11:输入:输入224*224*3的图像像素矩阵;

39、步骤12:卷积池化:输入的图像像素矩阵经过5轮卷积池化操作,每轮卷积核大小均为3*3*w,w代表矩阵深度,卷积之后通过激活函数relu得到多个特征图,并且采用最大池化筛选局部特征,其中卷积计算公式如下:

40、fj=r(xi*kj+b)

41、其中r代表relu激活函数,*代表卷积操作,b代表偏置项,kj代表不同矩阵深度的卷积核;

42、步骤13:全连接:经过三次全连接得到1*1*1000的图像特征表示向量;

43、步骤14:最终通过预训练好的vgg16网络获取图片特征向量用xvp={xv1,xv2…xvn}表示。

44、优选的:步骤1中采用bert预训练模型获取图片文本特征,具体过程如下:

45、步骤21:文本预处理:针对网络用语中无意义的词汇、符号进行预处理,将不影响判断文本情感倾向的词汇作为停用词并删除;

46、步骤22:采用预训练好的bert模型提取输入文本的词向量序列,输入文本,经过分割标注后,以词序列为输入,并经过bert模型的词嵌入、段嵌入、位置嵌入,在堆栈中层层流动,最终生成文本特征的词向量,用xlp={xl1,xl2…xln}表示。

47、优选的:步骤1中给定方面短语的方面特征的提取方法如下:

48、给定方面短语a={a1,a2…an},首先使用词嵌入获得词嵌入向量aj,然后采用双向lstm模型学习每个方面词嵌入向量的隐藏表示vj:

49、

50、然后取所有隐藏表征vj的平均值作为最终的方面特征向量va:

51、

52、本发明的有益效果是:

53、(1)本发明的情感分析方法利用模态对齐模块以及模态更新模块,并采用注意力机制,进行跨模态交互,从而提高多模态情感分析的准确性。

54、(2)本发明的模态更新模层包括模态对齐模块和模态更新模块,模态对齐模块用于对齐不同模态的特征序列,有助于模态间的交互。

55、(3)模态更新模块利用多头自注意机制,跨模态注意力机制加强模态间的交互,充分融合不同模态的共享特性及私有特性。

56、(4)为了保存模态间的丰富特征,本发明将融合后的多模态特征与初始的模态特征再次进行融合,然后再进行情感分类。

57、(5)本发明充分利用了跨模态间的信息交互,有助于提高情感预测的准确性。

- 还没有人留言评论。精彩留言会获得点赞!