优化联邦学习训练系统开销的自动超参调整方法与流程

本发明属于人工智能模型训练,更具体地说,涉及一种优化联邦学习训练系统开销的自动超参调整方法。

背景技术:

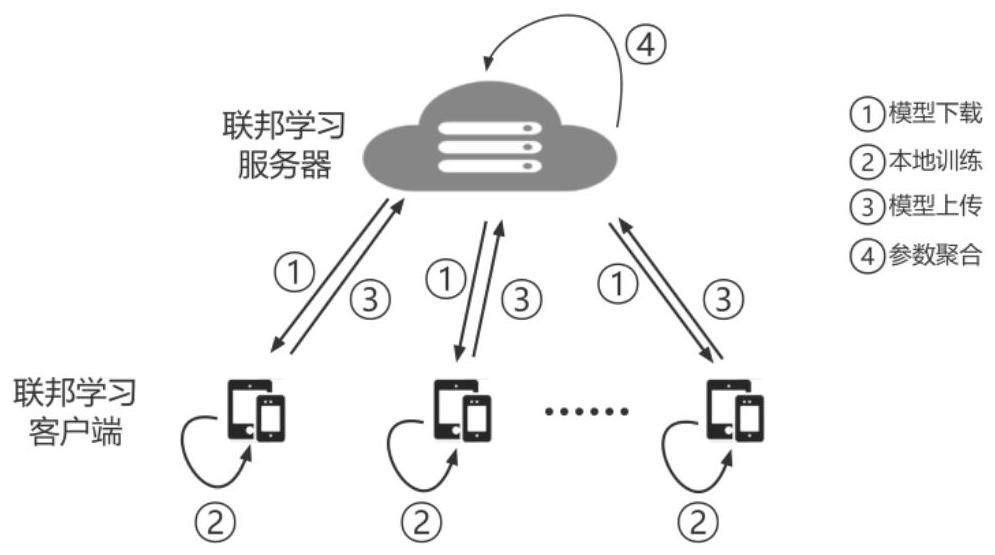

1、联邦学习(federated learning)是一种去中心化的人工智能模型训练方法,联邦学习往往需要多几个数量级的系统开销,阻碍了联邦学习的实际部署。因此,降低联邦学习的系统开销是件十分重要的研究问题。系统开销可由四个性能指标表示:(1)计算时间表示花在模型训练上的总时间;(2)传输时间表示传输模型参数所用的总时间;(3)计算负载表示训练模型所用的总运算量;(4)传输负载表示传输模型参数所用的总数据量。

2、现有技术中联邦学习设计人员在为不同应用场景决定联邦学习超参所面临的困境。这是因为不同的应用场景有不同的训练偏好(即,计算时间、传输时间、计算负载和传输负载)。考虑以下几个例子:1)计算机网络的攻击和异常检测因为要快速适应恶意流量,因此是时间敏感的(计算时间和传输时间);2)用于室内环境自动化的智能家居控制系统使用计算能力较弱的传感器设备,因此是计算敏感的(计算时间和计算负载);3)汽车流量监控系统通常使用蜂窝通信来提供城市级别的连通性,因此是通信敏感的(传输时间和传输负载);4)基于物联网感知的精准农业对于时间并不敏感,但是需要功耗低的解决方案(计算负载和传输负载);5)医疗系统,比如老年人摔倒检测,同时需要快速响应和低能量消耗(计算时间、传输时间、计算负载和传输负载);6)人类踩踏检测和预防需要时间、计算、通信都高效的系统。

3、对于不同的金融产品和应用,其联邦学习需要优化的系统指标有所不同。已有工作只针对某一项系统开销性能来优化联邦学习。比如,oort通过设计用户选择方法来减少联邦学习训练时间。fedpag通过梯度量化来减少联邦学习数据传输。fedex通过神经架构搜索(neural architecture search)技术来加速模型的收敛速度。然而,这些技术有如下不足之处:(1)这些技术只能优化系统的某一项性能(或相关的性能),无法统筹优化系统的所有四个性能指标。(2)这些技术与标准的联邦学习框架不兼容,无法被广泛使用。

技术实现思路

1、基于上述问题,本技术提供一种可根据不同的应用系统开销偏好,本方法可在联邦学习训练过程中,自动调节联邦学习的超参,从而减少相应的系统开销。本技术提出了结合训练偏好的比较函数。对于两个超参集合s1和s2,比较函数i(s1,s2)定义为:

2、我们用来近似其中(下标prv和prvprv分别表示一回合前和二回合前的联邦学习训练)。类似的,把t替换成q,z,v,就得出了和因此,我们可得

3、

4、如果δx>0,则增大x;反之,则减少x。

5、两个例子,当超参x为以下:

6、1)调整每回合用户数m。

7、因为m是整数,所以根据δx的符号,每一回合我们对m增大或者减少1。具体来说,

8、1.mcur=mnxt

9、2.选择mcur个用户用于模型训练和梯度聚合

10、3.每一回合计算δx。如果δx>0,mnxt=mcur+1;否者mnxt=mcur-1

11、4.更新θt、θq、θz和θv

12、2)调整每次本地更新数e

13、因为e是整数,所以根据δx的符号,每一回合我们对e增大或者减少1。具体来说,

14、5.ecur=enxt

15、6.每个用户本地训练ecur次数

16、7.每一回合计算δx。如果δx>0,enxt=ecur+1;否者enxt=ecur-1

17、8.更新θt、θq、θz和θv

18、以上就是调参算法解释。

19、为了解决上述技术问题至少之一,根据本发明的一方面,提供了一种优化联邦学习训练系统开销的自动超参调整方法,包括如下步骤:

20、s1、设置两个不同的联邦超参集合s1和s2,构建其联邦学习训练的系统开销比较函数i(s1,s2);

21、s2、给定当前的联邦学习超参集合scur,构建下一回合的超参集合snxt的最小化目标函数g(snxt);

22、s3.优化每回合选择的用户数,计算g(snxt)对用户数的偏导,求解最优用户数的变化趋势。

23、优选的,步骤s1中,

24、s11.构建系统开销比较函数i(s1,s2)

25、

26、其中,α、β、γ、δ分别为计算时间、计算负载、传输时间和传输负载的偏好系数,令α+β+γ+δ=1;t1、q1、z1、v1分别表示在超参集合s1下该应用所需的计算时间、计算复载、传输时间和传输负载;t2、q2、z2、v2分别表示在超参集合s2下该应用所需的计算时间、计算负载、传输时间和传输负载;

27、s12.如果超参集合s2比s1更优,即i(s1,s2)<0;如果一个超参集合加权的系统性能指标提升大于加权的其他系统性能指标下降,那么该超参集合更优。

28、优选的,步骤s2中,采用迭代方法,优化下一个回合的超参集合snxt,具体步骤为,

29、给定当前的联邦学习超参集合scur,下一回合的超参集合snxt可通过最小化以下目标函数获得

30、

31、其中,下标cur表示当前回合,下标nxt表示下一个回合;tcur、qcur、zcur、vcur分别表示在超参集合scur下该应用所需的计算时间、计算负载、传输时间和传输负载;tnxt、qnxt、znxt、vnxt分别表示在超参集合snxt下该应用所需的计算时间、计算负载、传输时间、和传输负载。

32、优选的,步骤s3中,

33、s31.通过计算g(snxt)对m的偏导,最优m的变化趋势δm可由以下公式表示

34、

35、s32.(跳转到这里)通过经验总结,可知计算时间和传输时间随着m变大而减小,而计算负载和传输负载随着m变大而变大;

36、求解和

37、用(+1)×|tnxt-tcur|近似获得,用(+1)×|qnxt-qcur|近似获得,

38、用(-1)×|znxt-zcur|近似获得,用(-1)×|vnxt-vcur|近似获得;

39、s33.引入当前决策参数θ,θ包括计算时间比率θt、计算负载比率θq、传输时间比率θz、和传输负载比率θv;

40、利用线性回归θt-1×|tcur-tprv|来预测|tnxt-tcur|,其中下标prv和prvprv分别表示一回合前和二回合前的联邦学习训练;

41、利用线性回归θq-1×|qcur-qprv|来预测|qnxt-qcur|,其中下标prv和prvprv分别表示一回合前和二回合前的联邦学习训练;

42、利用线性回归θz-1×|zcur-zprv|来预测|znxt-zcur|,其中下标prv和prvprv分别表示一回合前和二回合前的联邦学习训练;

43、利用线性回归θv-1×|vcur-vprv|来预测|vnxt-vcur|,其中下标prv和prvprv分别表示一回合前和二回合前的联邦学习训练;

44、s34.计算δm

45、

46、其中,θt-1、θq-1、θz-1、和θv-1参数由系统自动计算得出,通过计算δm,可知道下一回合m值的变化趋势。

47、优选的,根据δm的符号来增加或者减小m值,具体来说,如果δm>0,则mnxt=mcur+1;反之,mnxt=mcur-1;mprv、mcur和mnxt分别表示上一回合、当前回合和下一个回合的选择的用户数;如果mcur比mprv大,则更新θt-1和θq-1,因为计算时间和计算负载性能希望m值变大;反之,则更新θz-1和θv-1,因为传输时间和传输负载性能希望m值变小。

48、优选的,采用惩罚措施来降低错误决策带来的影响,对于上一回合的参数集sprv和当前的参数集scur,如果i(sprv,scur)>0,则表示上轮决策是错误的,采用对抵制当前决策参数θ乘以惩罚常数d(d>=1);具体来说,如果i(sprv,scur)>0且mcur>mprv,则θz-1和θv-1扩大d倍,这是因为传输时间和传输负载反对增大m值;反之,如果i(sprv,scur)>0且mcur<mprv,则θt-1和θq-1扩大d倍,因为计算时间和计算负载反对减小m值。

49、根据本发明的另一方面,提供了一种计算机可读存储介质,其上存储有计算机程序,该程序被处理器执行时实现本发明的优化联邦学习训练系统开销的自动超参调整方法中的步骤。

50、根据本发明的又一方面,提供了一种计算机设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述程序时实现本发明的优化联邦学习训练系统开销的自动超参调整方法中的步骤。

51、相比于现有技术,本发明至少具有如下有益效果:

52、本发明与标准联邦学习架构兼容,可方便地集成到现有的联邦学习系统中。通过对大量不同的应用(数据集)、联邦学习聚合算法实验,本发明可显著减少系统开销。

- 还没有人留言评论。精彩留言会获得点赞!