一种融合视觉情境的富语义对话生成方法

本发明属于深度学习,具体涉及一种融合视觉情境的富语义对话生成方法。

背景技术:

1、在人工智能飞速发展的今天,要实现机器与人类的自然交互仍是一项极具挑战性的任务,其中一个重要原因是现有的对话系统大多是基于单模态的文本来进行的,虽然文本是人类之间表达信息和相互交流的重要手段,但现实世界是自然多模态的,除了文本之外,人们会持续接收视频、音频、图像等多模态的信息,并针对这些特定的场景信息给出更加个性化和多样化的处理和交互方式。因此,视听说是智能系统实现自然交互的必备能力,基于多模态数据(文本、图像、视频等)的对话系统将是实现真正拟人化对话系统的重要途经。通过理解视觉情境信息,对话系统可以生成信息丰富且高质量的回复,以更加自然的方式与人类进行对话交互。未来多模态对话系统将是众多复杂的人工智能系统与应用中不可或缺的组成部分,例如盲人导航系统可以通过对话的方式帮助视力受损用户了解他们的周围情况或社交媒体内容,提高生活质量。

2、相比于基于文本或者语音的对话系统,视觉情境融合的人机对话系统目标是根据给定的输入视觉情境信息(视频内容)以及自然语言文本形式的对话内容(历史对话,视频摘要,当前问题)进行理解和推理,最后生成与问题相对应的自然语言形式的回复,整个过程不仅需要对复杂的视觉场景信息进行处理,还需要考虑历史上下文中的语言信息,并对两个模态的信息进行充分融合,才能生成符合当前视觉场景并且正确流畅的对话内容。挑战在于如何将这些侧重点不同的关键技术合为一体帮助对话系统获得情境敏感和认知推理能力,从而使对话系统能够更加深刻和全面的理解现实世界,实现更加和谐的人机交互。

技术实现思路

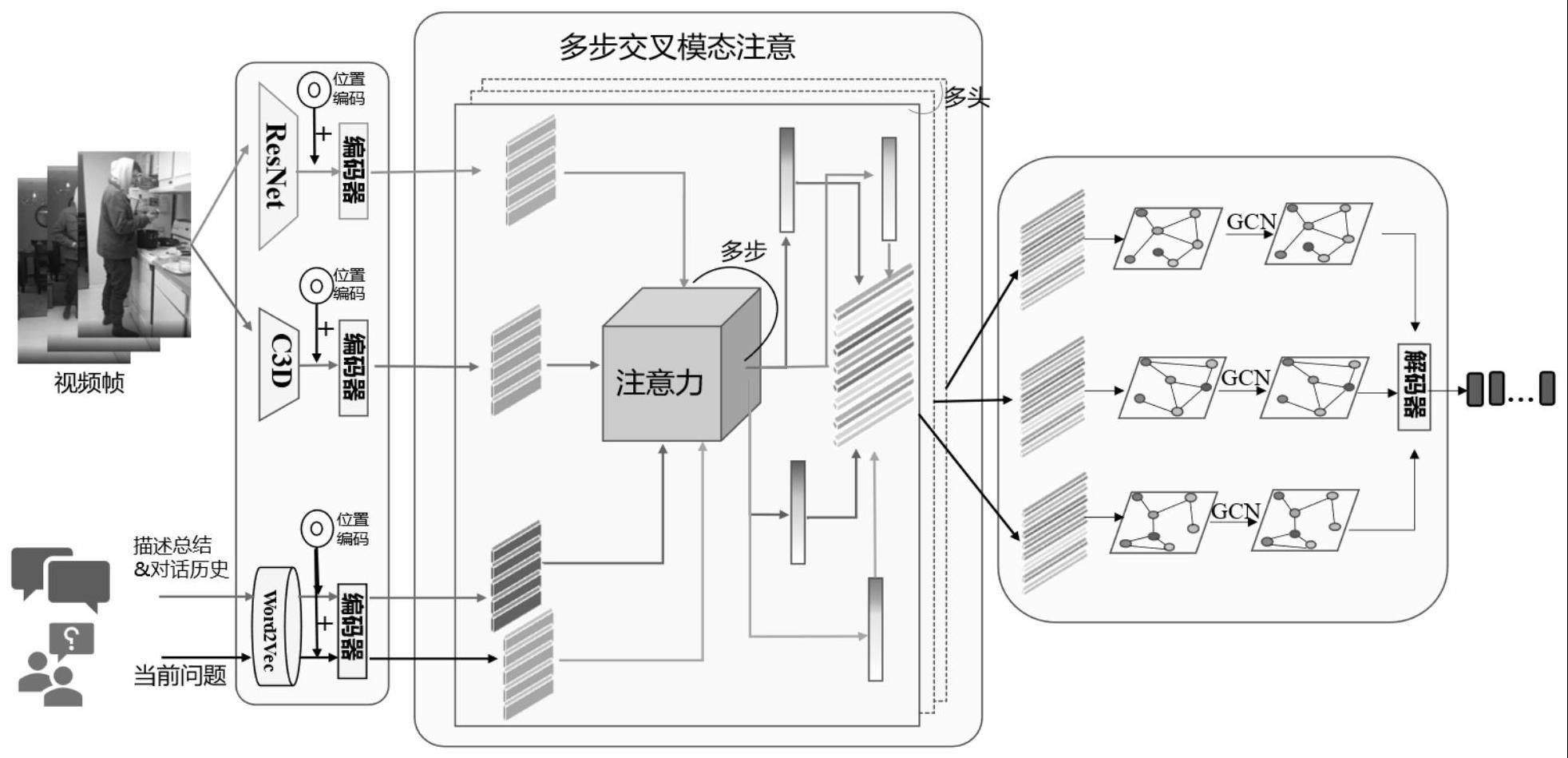

1、为了克服现有技术的不足,本发明提供了一种融合视觉情境的富语义对话生成方法,收集具有挑战性的视听场景感知数据集对模型进行训练,整体模型在transformer的基础上设计并实现了多步交叉模态注意力机制,细粒度捕捉时空维度上的不同模态间异构语义关联,而后将多模态特征表示联合构建成时空图结构并使用图卷积网络进行跨模态学习推理,最后解码生成符合当前情境,内容丰富准确的对话回复。本发明通过多模态数据的融合和跨模态交互捕捉多角度细粒度渐进式特征交互和模态间语义关联,实现视觉-语言跨模态语义对齐,提升模型语义理解和推理能力,最终生成信息丰富且高质量的回复。

2、本发明解决其技术问题所采用的技术方案包括如下步骤:

3、步骤1:收集视频对话相关开源数据集,并对数据进行预处理,划分训练集、验证集与测试集;

4、步骤2:数据预处理;

5、视频内容中存在四种类型的多模态特征表示,即视频静态特征、视频动态特征、当前问题特征和历史对话与总结信息拼接的文本特征;进行特征提取时加入位置编码,得到最终模型的输入表示,如下:

6、

7、

8、其中pe(pos,2i)代表句子序列中第pos个单词的第2i个维度上的值,pe(pos,2i+1)代表句子序列中第pos个单词的第2i+1个维度上的值;

9、步骤3:模型构建;

10、(1)首先构建基于编解码架构的对话系统,通过对视频中的帧信息使用预训练模型进行特征提取,获取到静态和动态的视频语义信息,然后将其与对话文本内容分别进行编码,并建模细粒度的模态内上下文语义信息;

11、(2)使用基于交叉模态的多步注意力机制进行多模态数据的融合和跨模态交互,捕捉多角度细粒度渐进式特征交互和模态间语义关联,实现视觉-语言跨模态语义对齐;

12、(3)将多模态特征表示联合构建成时空图结构,基于动态时空场景进行图推理得到跨模态融合特征后,解码生成对话回复;

13、步骤4:编码阶段;

14、对于编码部分,使用4个标准transformer编码器,对不同模态输入特征进行语义编码,包括视频静态特征、视频动态特征、历史对话与视频摘要特征和当前问题特征;其中,同属文本模态的历史对话与视频摘要特征和当前问题特征所使用的编码器将共享权重;

15、首先通过多头注意力模块根据上下文对句子序列中的单词向量进行更新,如下:

16、multihead(q,k,v)=concat(head1,head2,...headh)wo

17、headi=attention(qwiq,kwik,vwiv)

18、

19、其中q,k,v分别由三个不同的权重矩阵wiq、wik、wiv与模型输入向量相乘得到,三个权重矩阵维度均为dk,headi代表多头注意力机制中的一个注意力头;

20、然后经过前馈神经网络层得到编码阶段的输出,如下:

21、ffn(z)=max(0,z,w1+b1)w2+b2

22、其中z代表多头注意力层的输出内容,w1、w2分别表示前馈神经网络的学习权重;b1、b2分别表示偏置;

23、编码阶段中的多头注意力层和前馈神经网络层后都附加有残差连接和层归一化过程,如下:

24、sublayeroutput=layernorm(x+(sublayer(x))

25、其中sublayer指多头注意力层或前馈神经网络层,x表示输入;

26、步骤5:多步交叉模态注意机制;

27、将注意力机制从单步扩展到多步,在不同的注意力计算中,查询向量依次来源于其中一个模态类型数据,其余三个模态类型数据分别用于计算键向量和值向量,实现其中一个特征维度与其余三个维度之间的交叉注意;对于每一次的注意力机制计算,采用重复两次反复交互的策略,以三组六次的交叉模态注意力计算,多步交叉注意计算的具体更新和操作公式如下:

28、a(t)=softmax(qlm(t-1)t)

29、m(t)←(a(t)⊙m(t-1))w(t)+b(t)

30、其中,a(t)表示m(t-1)的注意权重,t为步数,←表示更新操作,w(t)和b(t)是线性fc层的可学习参数;q表示查询向量,l表示其余模态向量;

31、同理计算当前模态与其余模态之间的相互作用,将所有计算得到的相互作用进行拼接后经过线形层映射到同一维度,最后与当前模态特征相加,得到与其他模态的融合更新后的当前模态特征表示;

32、步骤6:跨模态推理;

33、采用图卷积网络gcn进行跨模态推理工作,在先前的特征表示和融合步骤中得到语言模态和视觉模态的交叉嵌入特征,对该特征构建无向异构图,即一个包含所有视觉和语言向量的异构输入矩阵,在异构图中进行基于图的对齐,得到基于语义相似度加权的跨模态对齐邻接矩阵,进一步使用gcn在图上执行关系推理;具体为,通过图中相邻节点和自身节点的线性变换进行节点值的更新,图中边的权值由对齐的邻接矩阵指定,将一层gcn表示如下:

34、x(f)=a(f)x(f-1)w(f)

35、其中x(f)是gcn第f层的隐藏特征,a(f)是由x(f-1)中节点特征的点积相似度计算出的邻接矩阵,w(f)是可学习的权重矩阵;

36、步骤7:解码阶段;

37、解码部分的输入经过多头掩码注意力机制和相同结构的编-解码注意力机制,最后经过前馈神经网络层生成最终的回复序列;解码阶段每个子层后同样附加有残差连接和层归一化过程;使用最小化生成序列的负对数似然函数损失来学习模型的参数,得到多轮对话内容生成模型,如下:

38、

39、其中t1,...,ti分别代表生成句子序列中的第i个单词,dkl表示kl散度,p(ti|t1,...,ti-1,x)表示当前时刻生成单词的概率,n表示最大生成长度。

40、优选地,所述数据集为audio visual scene-aware dialog数据集。

41、本发明的有益效果如下:

42、本发明基于transformer架构对视觉情境融合的对话系统进行建模,设计了多步交叉模态注意力机制对视频时空特征、音频、文本模态数据进行跨模态特征融合和交互,提升系统场景感知和定位关键信息的能力,而后使用gcn进行跨模态推理从而获取到细粒度的多模态图表征用于后续解码过程,促使系统生成信息丰富,语义准确的自然对话内容。实验结果表明本发明提出的视频对话模型在各大评估指标上取得了更加先进的性能,能够较好地捕捉到问题的核心,并且能够充分利用和结合多模态上下文信息,关联定位到其他模态中的相关内容,最终生成信息丰富准确,切合情境的对话用以回答问题。

- 还没有人留言评论。精彩留言会获得点赞!