一种多智能体协同强化学习方法、终端及存储介质

本发明涉及神经网络,尤其涉及的是一种多智能体协同强化学习方法、终端及存储介质。

背景技术:

1、强化学习是一种在线的学习方式。不同于一般的监督学习方法从事先处理好的离线数据样本中进行模型训练,强化学习的训练样本是由智能体与环境的实时交互获得,这种方式使得训练样本的数量及样本多样性都受到了限制。强化学习的训练十分依赖经验样本,样本数量的大小及多样性影响着智能体模型训练的效果及性能。基于以上的原因,诸多面向复杂环境的强化学习算法需要数千万甚至数十亿的经验样本去训练。

2、多智能体强化学习场景与环境的交互程度进一步复杂化。从局部视角看待,每个智能体依旧通过不断的试错改善自身的策略。而从全局视角看待,该场景下的多个智能体会同时与环境交互,由此产生联合动作,环境不因单个智能体的动作而作出反应,而是基于智能体的联合动作返回给智能体回报,同时进行相应的状态转移。当问题从单智能体扩增至多智能体时,强化学习训练对样本的需求量进一步扩大。样本数据匮乏会导致多智能体模型迭代速度降低及迭代的不稳定性加剧。

3、由于多智能体博弈对抗环境通常存在着非完全信息的问题,许多多智能体协同算法通过引入循环神经网络缓解非完全信息环境带来的部分可观测信息性问题。例如,单调值函数分解方法就在每个智能体的结构中引入循环神经网络解决非完全信息下的决策问题。但是,循环神经网络的训练需要序列化的数据,这使得多智能体协同算法在采集数据经验时必须收集一条完整的轨迹作为经验样本,即需要收集智能体从一局游戏开始直至一局游戏结束的完整经验轨迹,并存储到经验回放池中。模型需要等待智能体与唯一的环境完成数据采集工作后才能进行策略更新,使得模型的更新在大段时间轮空,整个训练过程进度缓慢,消耗了大量的训练成本。

4、因此,现有技术还有待改进。

技术实现思路

1、本发明要解决的技术问题在于,针对现有技术缺陷,本发明提供一种多智能体协同强化学习方法、终端及存储介质,以解决多智能体的强化学习过程中的样本利用率低及样本数量匮乏的问题。

2、本发明解决技术问题所采用的技术方案如下:

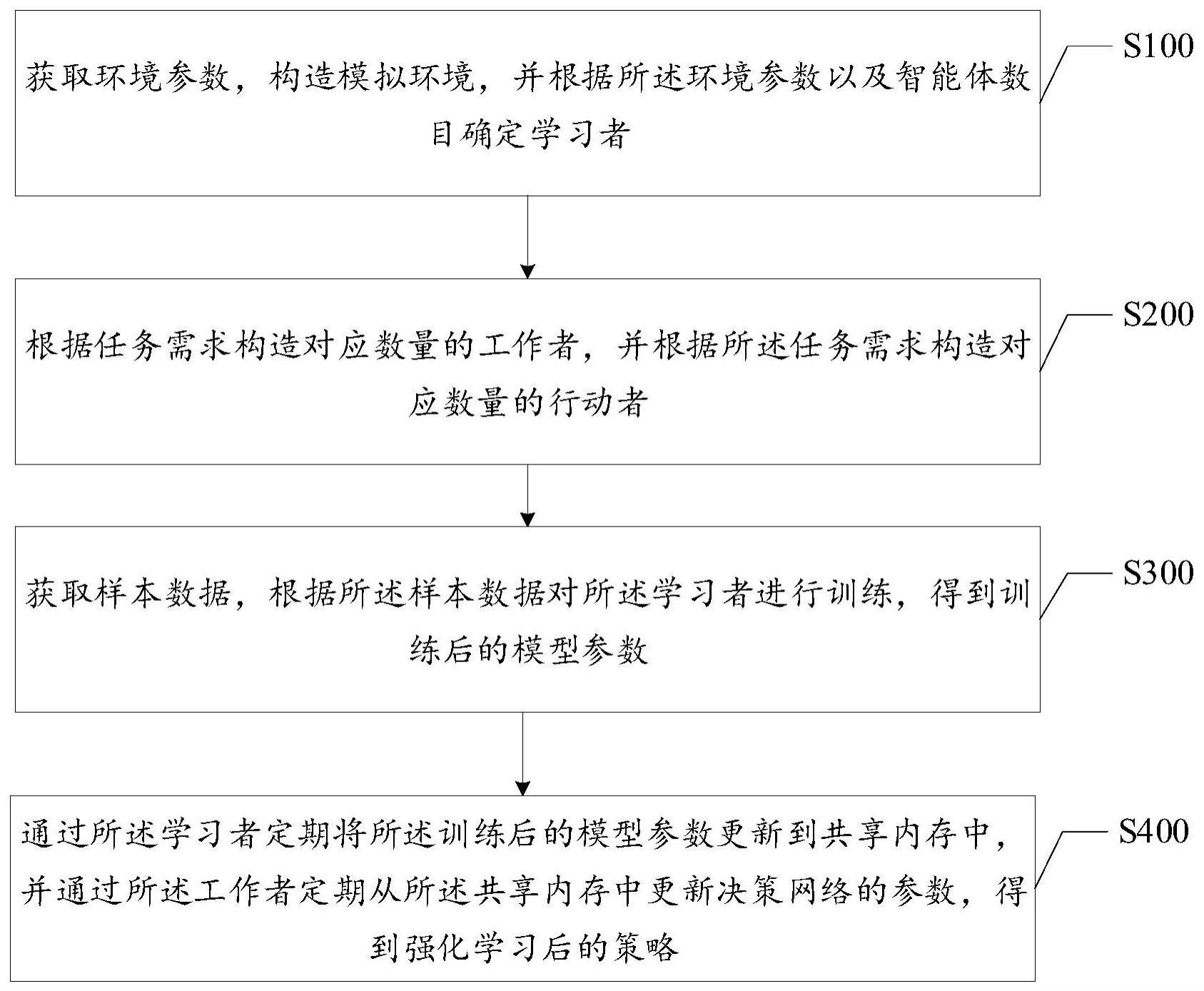

3、第一方面,本发明提供一种多智能体协同强化学习方法,包括:

4、获取环境参数,构造模拟环境,并根据所述环境参数以及智能体数目确定学习者智能体;

5、根据任务需求构造对应数量的工作者智能体,并根据所述任务需求构造对应数量的行动者智能体;其中,每个所述工作者智能体用于与多个所述行动者智能体进行交互,每个所述行动者智能体分别与一个独立的模拟环境交互;

6、获取样本数据,根据所述样本数据对所述学习者智能体进行训练,得到训练后的模型参数;

7、通过所述学习者智能体定期将所述训练后的模型参数更新到共享内存中,并通过所述工作者智能体定期从所述共享内存中更新决策网络的参数,得到强化学习后的策略。

8、在一种实现方式中,获取环境参数,构造模拟环境,并根据所述环境参数以及智能体数目确定学习者智能体,之前包括:

9、基于行动者智能体与工作者智能体的分布式训练算法进行训练,得到样本数据集。

10、在一种实现方式中,所述基于行动者智能体与工作者智能体的分布式训练算法进行训练,包括:

11、构造所述模拟环境、所述工作者智能体以及对应的多个所述行动者智能体;

12、构造多维隐藏变量,根据每个所述行动者智能体传输的观测信息在所述工作者智能体中做出决策,并将决策分别传输给对应的行动者智能体,利用训练数据进行训练。

13、在一种实现方式中,所述构造多维隐藏变量,包括:

14、将隐藏状态空间由单维拓展为多维,得到所述多维隐藏变量;

15、其中,每维分别对应智能体数目、环境数目及时间步个数,维护m个智能体在n个环境下进行长度为t的序列决策时的所有隐藏状态空间。

16、在一种实现方式中,所述根据每个所述行动者智能体传输的观测信息在所述工作者智能体中做出决策,并将决策分别传输给对应的行动者智能体,包括:

17、在每个时间步将新的环境状态经由所述行动者智能体传递给所述工作者智能体;

18、通过所述工作者智能体将所述新的环境状态送入主网络模型进行决策,并将输出的动作信息放回对应的观测信息及动作管道,传给对应的行动者智能体;

19、将各行动者智能体采集到的整条轨迹通过经验管道传到经验回放中;

20、从更新的经验回放池中随机采样经验样本,对所述工作者智能体进行策略的迭代更新,直至策略收敛。

21、在一种实现方式中,所述获取样本数据,根据所述样本数据对所述学习者智能体进行训练,得到训练后的模型参数,包括:

22、启动所述工作者智能体以及对应的多个行动者智能体,将所述工作者智能体的信息传递至对应的多个行动者智能体,并通过所述工作者智能体的策略网络指导每个所述行动者智能体维护一个独立的模拟环境,并与所述模拟环境进行交互,采集得到所述样本数据;

23、根据所述样本数据对所述学习者智能体进行训练,得到所述训练后的模型参数。

24、在一种实现方式中,所述启动所述工作者智能体以及对应的多个行动者智能体,将所述工作者智能体的信息传递至对应的多个行动者智能体,并通过所述工作者智能体的策略网络指导每个所述行动者智能体维护一个独立的模拟环境,并与所述模拟环境进行交互,包括:

25、通过所述工作者智能体部署多个所述行动者智能体,根据所述环境参数控制每个所述行动者智能体构造对应的模拟环境;

26、在每个所述行动者智能体得到环境的新状态时,将每个所述行动者智能体的观测信息传输至信息交互管道,并从所述信息交互管道中获取所述工作者智能体的策略决策的动作,控制每个所述行动者智能体与所述模拟环境进行交互;

27、通过每个所述行动者智能体存储与环境交互的每步信息,在轨迹结束时,将整局的经验传送到样本队列中,供学习者智能体使用。

28、在一种实现方式中,所述根据所述样本数据对所述学习者智能体进行训练,得到所述训练后的模型参数,包括:

29、通过所述学习者智能体维护经验回放池、共享内存池以及样本队列;

30、将多个环境交互产生的样本数据经由所述样本队列传输至所述经验回放池中;

31、通过所述学习者智能体训练及更新模型参数,并将更新后的模型参数同步至所述共享内存池。

32、第二方面,本发明还提供一种终端,包括:处理器以及存储器,所述存储器存储有多智能体协同强化学习程序,所述多智能体协同强化学习程序被所述处理器执行时用于实现如第一方面所述的多智能体协同强化学习方法的操作。

33、第三方面,本发明还提供一种存储介质,所述存储介质为计算机可读存储介质,所述存储介质存储有多智能体协同强化学习程序,所述多智能体协同强化学习程序被处理器执行时用于实现如第一方面所述的多智能体协同强化学习方法的操作。

34、本发明采用上述技术方案具有以下效果:

35、本发明将分布式强化学习与多智能体协同强化学习方法相结合,设计了面向多智能体的行动者-工作者分布式通信算法,通过部署多个交互环境,提高样本的采集速度和模型的训练速度,并在此基础上提出行动者-工作者-学习者分布式异步通信算法,将环境交互与模型迭代过程解耦,提高了多智能体的强化学习过程中的样本利用率及样本数量,进一步提升了样本收集速度、策略迭代速度及智能体的整体性能。

- 还没有人留言评论。精彩留言会获得点赞!