一种基于Transformer增强残差自编码网络的图像压缩感知重建方法

本发明涉及图像处理,具体是一种基于transformer增强残差自编码网络的图像压缩感知重建方法。

背景技术:

1、压缩感知cs(compressed sensing,简称cs)是一种新兴的图像信号采集和重建技术,它将采样和压缩过程结合起来,克服了奈奎斯特-香农采样定理的局限性,能够在远低于奈奎斯特采样率的情况下有效恢复和重建图像信息,为更好更快地传输海量数据提供了解决方案。

2、transformer是一种基于全局自我注意机制的编码器-解码器架构、可以捕获上下文信息之间的全局交互,并在几个视觉任务中显示出了良好的性能。swin transformer集成了卷积神经网络cnn和transformer的优势,在计算机视觉领域中显示出了巨大的前景。

3、近几年来,得益于深度学习技术强大的特征提取和表达能力,现有的基于深度学习的方法已经将深度卷积神经网络应用于图像压缩感知任务中,并显著地提高了图像重建性能。然而,深度卷积神经网络卷积层通常只有一个较小的接受域,因此采用cnn捕获长距离像素相关性具有挑战性,这限制了它们在cs任务中的重建性能。

技术实现思路

1、本发明的目的是针对现有技术的不足,而提供一种基于transformer增强残差自编码网络的图像压缩感知重建方法。这种方法能更好地捕捉局部和全局特征,有效增强特征信息,精确重建原始图像。

2、实现本发明目的的技术方案是:

3、一种基于transformer增强残差自编码网络的图像压缩感知重建方法,包括如下步骤:

4、1)对图像观测值y进行初始线性重建:采用卷积神经网络cnn中卷积层fin来学习上采样矩阵,生成一系列的向量i=fin*y,用reshape+concat操作将向量i重塑为b×b×1大小的图像块,拼接得到初始重建图像zin;

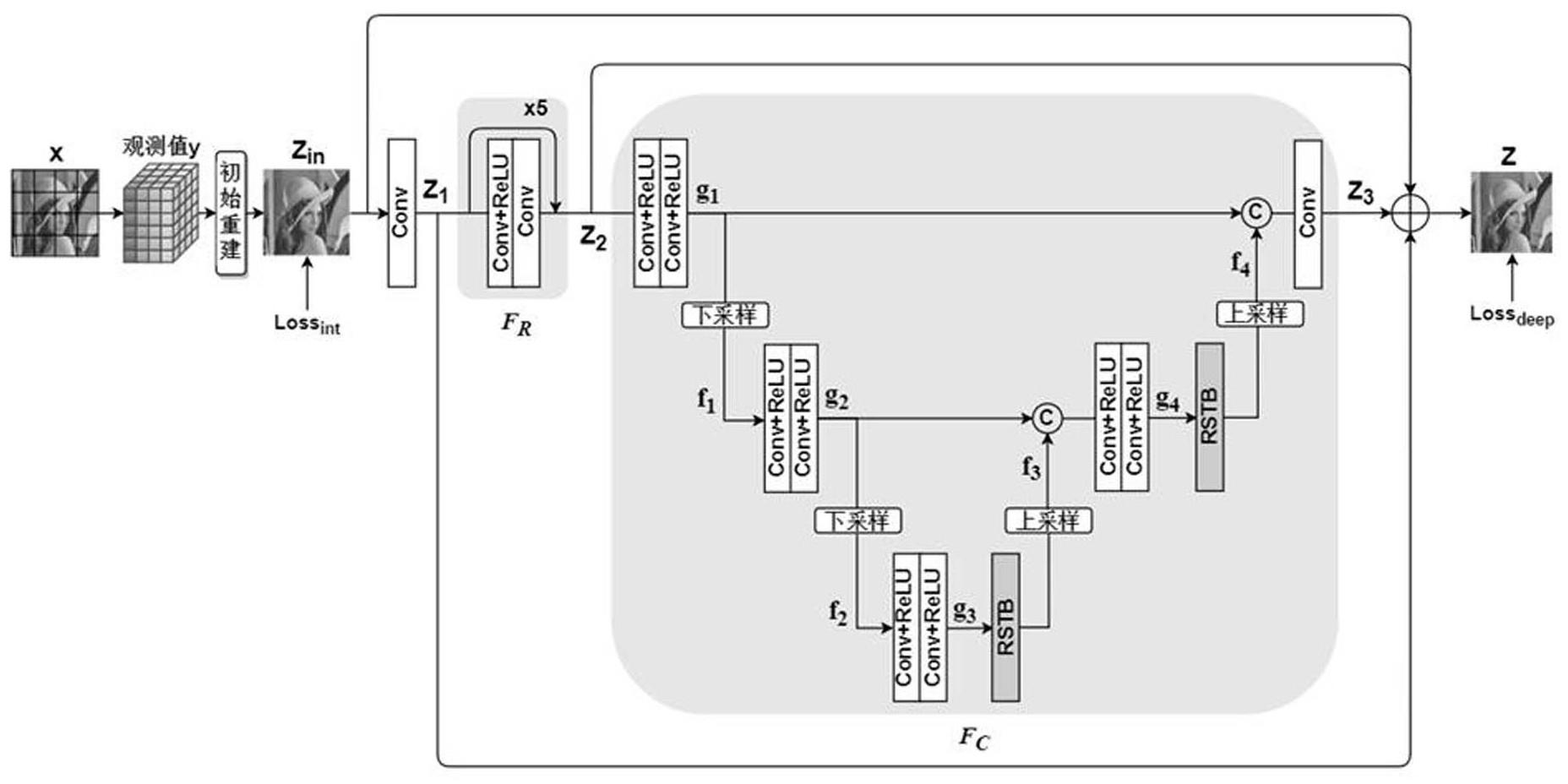

5、2)设计并采用基于transformer进行特征增强的残差自编码网络进行深度重建:对步骤1)得到的初始重建图像zin采用基于transformer进行特征增强的残差自编码网络进行深度重建,得到深度重建图像z:

6、首先,对初始重建图像zin采用核大小为3×3的卷积进行通道变换得到特征图z1,如公式(1)所示:

7、z1=conv(zin) (1);

8、其次,将特征图z1通过由5个残差块堆叠而成的残差网络fr得到浅层特征图z2,如公式(2)所示:

9、z2=fr(w1,z1) (2),

10、其中,w1表示网络参数;

11、然后将浅层特征图z2送入transformer增强自编码网络fc,得到增强特征图z3,如公式(3)所示:

12、z3=fc(w2,z2) (3),

13、其中,w2表示网络参数,fc表示的transformer增强自编码网络包括:用于对输入浅层特征图z2进行特征提取的编码网络fe、用于对特征进行增强的含有残差swintransformer模块rstb的解码增强网络fd、以及用于对特征信息进行补充融合的跨层连接;

14、最后,将特征图z1、z2、z3与初始重建图像zin相加融合,得到最终的深度重建图像z,如公式(4)所示:

15、z=(z1+z2+z3)+zin (4);

16、3)基于全局-局部联合损失函数进行网络训练:包括:

17、3-1)构造训练数据集,获取观测值y:采用bsds500数据集的200张训练图像和200张测试图像、将它们随机裁剪成大小为b×b×1的不重叠的图像块,对输入图像x采用卷积神经网络cnn中卷积层fs来实现基于块的采样过程,获得观测值y=fs*x;

18、3-2)构造联合损失函数loss对网络进行端到端训练,如公式(5)所示:

19、loss=lossint+lossdeep (5),

20、其中,lossint为对初始重建图像zin的损失项,如公式(6)所示:

21、

22、lossdeep为对深度重建图像z的损失项,如公式(7)所示:

23、

24、其中,xi为原始图像,zin为初始重建图像,z为深度重建图像。

25、步骤2)中所述的transformer增强自编码网络fc为:

26、2-1)将浅层特征图z2作为transformer增强自编码网络fc的输入,先经过编码网络fe进行特征提取得到输出特征f2;

27、编码网络fe由两个3×3卷积核和一个步长为2的下采样操作组成,每个卷积之后都有一个激活函数relu,如公式(8)、(9)、(10)、(11)所示:

28、g1=conv2(z2) (8),

29、f1=downsampling(g1) (9),

30、g2=conv2(f1) (10),

31、f2=downsampling(g2) (11),

32、其中,conv2为两个3×3卷积核和激活函数relu的组合,downsampling为步长为2的下采样操作;

33、2-2)将编码网络fe的输出特征f2送入解码增强网络fd,采用卷积层和残差swintransformer模块rstb对特征图f2进行特征增强,得到输出特征f4,解码增强网络fd由两个3×3卷积、上采样和一个残差swin transformer模块rstb组成,每个卷积后面都有一个激活函数relu,同时,将编码网络fe中的两次下采样之前得到的浅层特征g1和g2经过跨层连接到解码增强网络fd中的两次上采样之后得到的对应大小的深层特征f3和f4,将它们进行通道信息融合,最后,采用卷积将特征图转换到单通道,得到最终的输出特征z3,如公式(12)、(13)、(14)、(15)、(16)所示:

34、g3=conv2(f2) (12),

35、f3=upsampling(rstb(g3)) (13),

36、g4=conv2(concat(g2,f3) (14),

37、f4=upsampling(rstb(g4)) (15),

38、z3=conv(concat(g1,f4)) (16),

39、其中,conv2为两个3×3卷积核和激活函数relu的组合,upsampling为2×2反卷积的上采样操作,rstb表示一个残差swin transformer块rstb,concat为通道拼接,conv为3×3大小的卷积。

40、所述残差swin transformer模块rstb过程为:以步骤2-2)中所述的特征gi作为残差swin transformer模块rstb的输入,其中i=3,4,残差swin transformer模块rstb是由两个swin transformer层和一个卷积层组成的残差块,如公式(17)所示:

41、rstb=conv(hstl(hstl(gi)))+gi (17),

42、其中,gi表示输入特征,conv为3×3大小的卷积,hstl为swin transformer层。

43、本技术方案的有益效果是:

44、本技术方案采用深度学习技术进行压缩感知图像重建,采用端到端的训练方式对采样和重建网络进行联合优化、基于transformer增强的残差自编码网络在解码模块中充分利用残差swin transformer模块的全局自我注意机制对图像特征进行增强,在编码器和解码器之间采用一种跨层连接来实现各维度特征图的融合,以找回解码过程中丢失的边缘信息,有效提高图像压缩感知重建质量。

45、这种方法能更好地捕捉局部和全局特征,有效增强特征信息,精确重建原始图像。

- 还没有人留言评论。精彩留言会获得点赞!