一种眼底彩照图像分析方法与流程

1.本发明涉及一种眼底彩照图像分析方法。

背景技术:

2.深度学习已经在眼科图像领域取得了大范围的应用,其准确率常常能达到甚至超越人类专家的水平。目前,处理眼底彩照的深度学习研究通常采用计算机视觉领域面向自然图像的处理方法与分析模型,其中最为主流的方法多基于卷积神经网络构建。例如densenet,vggnet,inceptionv3,resnet等。其有别于传统基于模式识别的图像处理方法,广泛使用卷积、池化、批标准化等计算方式,并利用反向传播不断地更新参数,逐步向最优的效果迈进。此类卷积神经网络模型在图像特征提取方面具有良好的性能表现,提取的深度特征相比于手工特征,具有良好的表达丰富性和平移不变性。此外,此类方法具有良好的泛化能力,经过训练的权重参数可以迁移到不同任务中,只需要少量的训练即可达到良好的效果。通过这种方法可以大大减少训练时间和计算成本,因此在视网膜眼底彩照影像分析上,此类模型也被广泛使用。

3.现有技术存在的缺点:上述主流的基于卷积神经网络的模型为兼顾运算效率与准确率,其输入图像尺寸一般为长和宽在224-512像素之间。然而眼底彩照多为长宽在2000像素以上的高分辨率图像,若压缩至模型指定的输入尺寸,易造成细节信息丢失而不利于建模分析,图像细节压缩后有所失真,对图像分析的一致性和准确性有一定影响。

技术实现要素:

4.本发明的目的在于克服上述现有技术的不足,提供了一种眼底彩照图像分析方法。

5.为了实现上述目的,本发明采用的技术方案是:一种眼底彩照图像分析方法,该方法包括由计算机执行的两大步骤,分别为:步骤一、依次包括图像输入、图像块嵌入和图像特征提取步骤;其中图像输入步骤中判断输入图像是否为未经压缩的高分辨率图像,若非未经压缩的图像则需要重新输入图像;步骤二、图像特征处理;该步骤中,图像特征序列通过lst模型和多层感知机网络进行最终的图像特征分析与特征值提取;lst是transformer模型的一种变体,lst将transformer模型中的全注意力替换成短期注意力和长期注意力两者的聚合;经过lst模块图像特征处理,最终图像特征值被输出;其中,lst模型的基本单位是lst block,即lst单元,包括多头长短期注意力mhlsa层和mlp多层感知机,并在每一层前使用层归一化ln,最后通过残差连接的形式连接到下一层。

6.进一步地,所述步骤一中,输入的图像经过一个图像块嵌入模块,该图像块嵌入模

块将图像嵌入为n个图像块,其中;接着将所有图像块在第一维度级联后输入经过预训练的resnet-50模型的特征提取模块进行特征提取,resnet-50为卷积神经网络模型;图像块经过特征提取后得到n个维度为2048的特征向量所组成的图像特征序列集f。

7.进一步地,所述步骤二中,所述lst模型的基本lst block单元的计算过程为:block单元的计算过程为:block单元的计算过程为: 。

8.其中,是级联操作,表示mhlsa中的第i个长短注意力计算。

9.输入图像特征序列集f由8个图像特征序列组成,图像特征序列第一步经过层归一化操作,其步骤如下:其中,ln是层归一化,为输入的图像特征序列,μ为图像特征序列的特征值之和,σ为图像特征序列特征值的方差,计算方法为:为图像特征序列特征值的方差,计算方法为:经过层归一化后序列被输入到模块中,短期注意力的实现方式为:多头长短期注意力mhlsa中的短期注意力由滑动窗口实现,使用窗口宽度w=20以限制短期注意力的范围;输入的图像块特征所组成的图像特征序列被分成长度为w的不相交片段;一个窗口内所有标记与其归属段内所有其他标记之间计算短期注意力,在超出边缘的位置将由零矩阵进行填补;由此,短期注意力跨度共计超过2w个键值对;长期注意力的实现方式为:第i个注意力头上的低秩投影被参数化为,其中,为低秩尺寸,取决于输入序列的所有键,经此注意力头中高维的键嵌入和值嵌入被投影到了低秩,查询嵌入不变;原来的注意力矩阵通过低秩投影分解成两个更小的矩阵乘积;低秩注意力在i位置上的动态投影p表示为:其中,为可学习的参数,d为q和k矩阵的维度,softmax函数的作用是

将n个标记中第一维的投影参数标准化,让训练趋于稳定;ki和vi为投影后的低秩键嵌入与值嵌入;长短期注意力聚合的实现方式为:第i个注意力头,位置t的注意力h

i,t

表示为:其中,表示两个矩阵沿第一维级联,d为q和k矩阵的维度;经过长短期注意力聚合,长注意力和短注意力被聚合成长短期注意力矩阵,在级联操作后再次经过层归一化操作,输入到mlp多层感知机。

10.本发明的有益效果是:本方法聚焦于眼底图像中细微特征的识别与分析。为解决图像压缩而导致的细节丢失问题,本研究基于多实例学习,将未经压缩的图像分成数个图像块并分别提取特征,进而组成图像特征序列,继而引入lst模块对图像特征序列进行处理,依靠短期与长期注意力机制,能综合不同实例中图像特征进行特征进一步提取,比起现今先进的方法性能有所改善的同时又兼顾计算效率。本方法改良了传统模型处理图像细节特征能力并提升准度,提升了传统模型运算效率,缩短运算时间。

附图说明

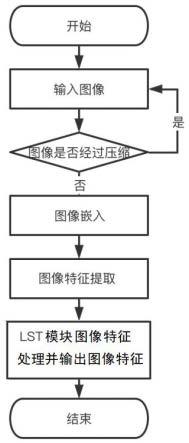

11.图1是本发明方法总体步骤图;图2是本发明方法流程图;图3是lst block示意图;图4是多层感知机示意图。

具体实施方式

12.下面结合实施例对本发明作进一步的详细说明,如图1至4所示,一种眼底彩照图像分析方法,此方法由两部分构成,方法的第一部分包括图像输入、图像块嵌入模块、图像特征提取模块。首先先确定图像为未经压缩的高分辨率图像,若非未经压缩的图像则需要重新输入图像。如图2所示,输入的图像经过一个图像块嵌入模块,图像块嵌入模块将图像嵌入为n个图像块,其中。接着将所有图像块在第一维度级联后输入经过预训练的resnet-50模型的特征提取模块进行特征提取,resnet-50为卷积神经网络模型。图像块经过特征提取后得到n个维度为2048的特征向量所组成的图像特征序列集f。

13.方法的第二部分为图像特征处理,通过lst模块实现。如图2所示,图像特征序列f通过lst模块和多层感知机网络进行最终的图像特征分析与特征值提取。lst是transformer模型的一种变体。lst将transformer模型中的全注意力替换成短期注意力和长期注意力两者的结合。如图2所示,lst模块的基本单位是lst block,包括多头长短期注意力层(multi-head long short attention, mhlsa)和mlp层,并在每一层前使用层归一化(layer normalization, ln),最后通过残差连接的形式连接到下一层。一个lst的基本lst block单元的计算过程如下:

。

14.其中,ln是层归一化,是级联操作,表示多头长短注意力,表示中的第i个长短注意力计算,mlp指多层感知机。

15.输入图像特征序列集f由8个图像特征序列组成,图像特征序列第一步经过层归一化操作,其步骤如下:。

16.其中为输入的图像特征序列,μ为图像特征序列的特征值之和,σ为图像特征序列特征值的方差。计算方法如下:特征值的方差。计算方法如下:经过层归一化后序列被输入到模块中,中的短期注意力由滑动窗口实现,使用窗口宽度w=20以限制短期注意力的范围。输入的图像块特征所组成的图像特征序列被分成长度为w的不相交片段。一个窗口内所有标记(token)与其归属段内所有其他标记之间计算短期注意力,在超出边缘的位置将由零矩阵进行填补。由此,短期注意力跨度共计超过2w个键值对。长期注意力的实现方式如下,第i个注意力头上的低秩投影被参数化为,其中,为低秩尺寸,取决于输入序列的所有键,经此注意力头中高维的键嵌入(key embeddings)和值嵌入(value embeddings)被投影到了低秩,但查询嵌入(query embeddings)不变。这样一来,原来的注意力矩阵就通过低秩投影分解成两个更小的矩阵乘积。低秩注意力在i位置上的动态投影p可以表示为:其中为可学习的参数,d为q和k矩阵的维度,softmax函数的作用是将n个标记中第一维的投影参数标准化,让训练趋于稳定。ki和vi为投影后的低秩键嵌入与值嵌入。下一步为聚合长短期注意力。以第i个注意力头为例,位置t的注意力h

i,t

表示为:

其中,表示两个矩阵沿第一维级联,d为q和j矩阵的维度。经过长短期注意力聚合,长注意力和短注意力被聚合成长短期注意力矩阵,在级联操作后再次经过层归一化操作,输入到mlp指多层感知机,其结构如图4所示。

17.经过多实例学习模块与lst模块,图像中信息被概括成图像特征值,临床医生可根据特征值辅助甄别眼底彩照检查报告中的可靠部分。

18.输入一张眼底图像,分辨率为2790*2350*3,本方法与现有方法的性能对比如下表:。

19.以上内容仅用以说明本发明的技术方案,本领域的普通技术人员对本发明的技术方案进行的简单修改或者等同替换,均不脱离本发明技术方案的实质和范围。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1