面向文本知识推理模型持续学习的样本选择方法和装置与流程

1.本发明涉及一种面向文本知识推理模型持续学习的样本选择方法和装置,属于自然语言推理的技术领域。

背景技术:

2.自然语言推理任务是指给定前提文本和假设文本,以前提文本为标准,去判断假设文本的正确、错误或无关等不同情况。文本知识推理是自然语言推理任务的一种特殊形式,其中前提文本是指专业领域的知识点或涉及专业领域知识点的事实描述,假设文本是指不同人员描述其对于前提文本中的知识点理解或认知结果。例如在经济法考试中,前提文本是指经济法领域的专业知识或涉及的事实描述,对应试题的参考答案,如“根据公司法律制度的规定,有限责任公司的自然人股东因继承发生变化时,其他股东主张行使优先购买权的,人民法院不予支持,但公司章程另有规定或者全体股东另有约定的除外。”假设文本是指不同人员对于上述知识点的理解结果,在上述案例中对应考生答案,如“钱某请求行使有限购买权,人民法院不予以支持。有限责任公司的股东去世的情况,股权由其继承人继承。”在本例中,文本知识推理任务是依据前提文本即参考答案判断假设文本即考生答案是否正确。文本知识推理在主观题评阅、专业知识问答、知识推理等领域具有重要应用价值。

3.在专业知识文本推理问题中,专业领域知识点的类别数量庞大、知识点描述形式多样,前提文本的内容和形式不断翻新,而假设文本因与个体专业知识水平和表达能力密切相关,其质量参差不齐、形式多样。前提文本和假设文本的这些问题使描述同一知识点的样本混淆度高、辨识困难,而低频使用的知识点对应的样本数量少,冷门专业知识点还存在缺少标注样本的问题。面对持续增加的知识点样本数据,尤其是历史样本数据中未曾涉及的知识点,智能模型不仅要解决少样本和噪音等样本挑战,而且要解决持续学习挑战,即在学习新知识点的同时不遗忘既有知识,达到增加模型的泛化能力和鲁棒性的目的。

4.引入持续学习是为了让文本知识推理智能模型不仅能很好地完成新问题,还能以良好的性能处理历史任务。在人工智能领域,记忆回放策略是最为有效的持续学习方法,例如,文献wang,hong等人于2019年发表的文章:"sentence embedding alignment for lifelong relationextraction."arxiv preprint arxiv:1903.02588。

5.通过保存之前任务的部分样本参与下一次训练以达到持续学习的目的,其中之前任务的部分样本构成的集合称为记忆集,记忆集中样本质量决定了推理模型在历史任务上的性能。

6.例如:中国专利文献cn114722892a提供一种基于机器学习的持续学习方法及装置,使用历史数据训练生成器,使用生成器生成对应任务的伪样本集作为记忆集,这种方法难以保证生成样本的质量,影响持续学习效果。

7.中国专利文献cn113688882a提出一种记忆增强的连续学习神经网络模型的训练方法及装置,受人脑记忆回放的启发,利用简单的数据回放方法,通过存储数据的均值和方差的方式构建可扩展的记忆模块,实现对原有任务的记忆增强效果,但是这种方案只考虑

数据集合的众数代表性样本,没有样本的困难性和多样性。

8.中国专利文献cn113590958a公开一种基于样本回放的序列推荐模型的持续学习方法,依据物品类别平衡策略对小部分具有代表性的范例样本进行采样,生成记忆集,这种方式并没有考虑样本的困难性和差异性。综上所述,现有工作难以满足文本知识推理模型的持续学习需求。

9.综上可知,现有技术存在的问题包括:针对描述同一知识点样本形式多样,质量参差不齐的问题;针对知识点类别覆盖和知识点类别上样本数量不均衡问题;选取加入记忆集的样本时,描述同一知识点的样本形式或质量重复性高的问题。

技术实现要素:

10.针对现有技术的不足,本发明公开一种面向文本知识推理模型持续学习的样本选择方法。

11.本发明还公开一种实现上述样本选择方法的装置。

12.针对上述问题,本发明针对描述同一知识点样本形式多样,质量参差不齐问题,提出代表性指标;针对知识点类别覆盖和知识点类别上样本数量不均衡问题,提出了平衡性指标;为了防止选取加入记忆集的样本中,描述同一知识点的样本形式或质量重复性高的问题,提出了差异性指标。基于此,本发明又提出了兼顾样本质量和样本特征分布的多种选择策略和样本选择技术,提升了专业知识文本推理持续学习的模型性能和鲁棒性,对于其他文本理解任务也具有理论意义。

13.专业术语解释1、专业知识:指专业领域如金融、法律、会计等,所涉及的理论、技术、概念、事实描述等文本,区别于通用知识和常识知识。

14.2、专业知识点:专业知识的最小组成单位,采用规范化文本描述形式,后文简称知识点,记为。

15.3、前提文本:是指专业领域知识点或涉及专业领域知识点的事实描述。同一个知识点可能有多个前提文本进行描述,记为。

16.4、假设文本:是指不同人员对于专业领域知识点的理解结果的文本描述。一个前提文本可能有多个对应的假设文本,记为。

17.5、任务:在模型持续学习的过程中,要从一系列任务中进行学习,这些任务具有时序关系,模型的学习在每个任务上是单独进行的。

18.6、数据集:每个任务都有自己的数据集,数据集的每个样本是形如的元组,其中为前提文本,为假设文本,,其中0、1、2分别表示样本标签为蕴含,矛盾或中立。任务与数据集的关系如图1所示。

19.7、sentence-bert模型:是指记载在文献reimers n, gurevych i. sentence-bert: sentence embeddings using siamesebert-networks[j]. arxiv preprint arxiv:1908.10084, 2019.中的模型。

[0020]

8、sentencetransformer:是使用python的pytorch框架对sentence-bert模型的代码实现,目前无中文翻译。

[0021]

本发明详细的技术方案如下:

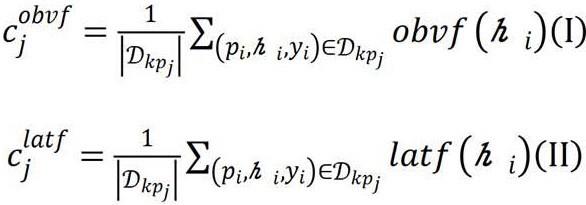

一种面向文本知识推理模型持续学习的样本选择方法,其特征在于,包括:历史任务样本选取和当前任务样本选取;(1)其中所述历史任务样本选取,包括:获取中心向量和选取样本,所述中心向量是指描述同一知识点的所有样本的中心向量,所述选取样本是选取合适的样本加入到记忆样本集合中;所述获取中心向量时:对于形如的有标签样本集合,使用公式(i)(ii)计算其表层特征中心向量和隐式特征中心向量,其中代表数据集中描述第个知识点的所有样本,分别为获取文本的表层特征和隐式特征的函数:公式(i)(ii)中和的表示表层特征中心向量和隐式特征中心向量的次序,意为第个表层特征中心向量和第个隐式特征中心向量;获取文本的表层特征(obvious feature)和隐式特征(latent feature):所述表层特征,使用词频和逆文档频率表示,记为,所述隐式特征,使用sentence-bert向量表示,记为,其中为被编码的文本;所述选取样本时,流程包括:(1-1)确定选取加入到记忆集中的样本个数:所述公式(iii)-(iv)是确定描述同一知识点的样本选取多少个加入到记忆集中,根据任务的先后顺序,记当前任务为第个任务,历史第个任务的数据集中选取的样本量为,如公式(iii),其中为模型训练需要选取的样本总量,即记忆集样本量和当前任务选取样本量之和:通过公式(iv)确定从第i任务的数据集的第个知识点的相关样本中选取的样本数量为,以使得抽取的每个知识点的样本的数量分布与原数据集的一致:其中表示第个数据集;表示第个数据集中描述第个知识点的数据集;(1-2)选取样本:通过代表性、差异性、平衡性指标衡量样本来选取记忆集,并在选取样本时,利用下述两种方案之一遍历样本;

方案

①

:根据样本向量与中心向量的距离升序进行遍历,其中向量包括表层特征向量和隐式特征向量;方案

②

:每个样本等概率随机进行遍历;若被遍历的样本满足代表性、差异性、平衡性,则加入记忆集;否则,舍弃被遍历的样本,继续进行下一个遍历,直至选取的样本数量满足要求;(2)其中,当前任务样本选取包括:样本代表性分析、样本困难性分析和样本采样;其流程;为了减少训练成本,针对当前任务,希望选取非常少量样本进行训练,但少量样本难以代表总体样本的特征,因此,需要从当前任务数据集中抽取具有代表性和困难性的样本,用于文本知识推理模型训练;鉴于筛选样本的目的是精细调优文本知识推理模型,一方面,需要在有限样本约束下最大程度地满足对于总体样本的代表性,另一方面需要挑选出困难样本,困难样本可携带更多可让模型受益的信息,为此,本发明联合代表性和困难性这两个指标进行当前任务上的样本筛选;(2-1)所述当前任务样本选取中的样本代表性分析,包括:对于当前任务(第个任务)数据集的第知识点的候选样本集中的样本的假设文本表层特征向量组成的集合进行聚类,指定聚类数为,可以根据既往任务的知识点个数来确定,即选取与既往任务的知识点个数相近的数量,根据公式(vi),得到个聚簇;当前任务中第个知识点需要抽取的样本数量为,针对每个聚簇,计算簇中样本方差以及簇中样本数量来分析样本代表性:方差大且样本数量多的簇,其中每个样本对该簇的代表性就低,需从该簇中采样更多的样本以维持对该簇的代表性,根据公式(v)确定簇中采样的样本数量,意为第个任务中,针对第个知识点的第个簇中选取的样本数:的样本数:(2-2)当前任务所述样本选取中的样本困难性分析,包括:借助预训练的专业文本推理模型,输入样本的前提文本和假设文本进行推理预测,得到类别集合上预测概率分布,,其中表示概率最大的类别标签,使用公式(vii)计算推理模型对样本所预测的概率分布中的最大输出概率与第二大输出概率的差值来衡量样本的困难性,,越小,表示推理模型对其预测结果不置信,故样本困难性越高,其中表示专业文本推理模型预测样本类别为的概率,表示由专业文本推理模型

预测样本类别为c的概率;(2-3)当前任务所述样本选取中的样本采样,包括:(2-3-1)对于当前任务数据集的第个知识点的候选样本集进行步骤(2-1)所述的样本代表性分析,得到从每个聚簇中的采样样本数量,以维持筛选出的样本集的代表性;(2-3-2)之后对样本进行步骤(2-2)所述的样本困难性分析,计算样本的困难性量化值;对于簇,从中采样困难性最高的个样本,即根据样本的值从小到大选取个样本,加入到筛选的小样本集中;对簇均进行上述采样过程,完成知识点样本的采样;对当前任务中的所有知识点经过上述采样过程,完成在当前任务上的数据筛选,最终筛选出当前任务的训练用样本集数量为。

[0022]

根据本发明优选的,在步骤(1)中,获取所述文本的表层特征具体方法:利用hanlp的粗粒度分词器对文本进行分词,分词结果中去除常见的中文停用词,并筛去只出现一次的词汇,得到所有文本的词典;最后计算每个文本的tf-idf特征向量作为样本的表层特征。

[0023]

根据本发明优选的,在步骤(1)中,获取所述文本的隐式特征具体方法:使用sentence-bert模型的具体实现sentencetransformer,并加载预训练模型paraphrase-multilingual-mpnet-base-v2,以对文本进行编码,使用编码后的sentence-bert特征向量表示文本的隐式特征。

[0024]

根据本发明优选的,在步骤(1-2)中,通过代表性、差异性、平衡性指标衡量样本来选取记忆集的方法,包括:对于一系列任务,每个任务上有对应的数据集,其中表示当前要学习的任务,表示其对应的数据集,数据集中每一个样本记为;文本知识推理模型在当前任务上进行学习时,使用记忆集进行记忆回放,其中,为集合并集操作,操作范围为当前任务之前的所有任务,即;表示数据集中加入到记忆集的样本构成的集合,为记忆集的简写;所述集合满足代表性、差异性和平衡性;所述代表性,使用局部离群因子(local outlier factor,lof)进行度量,所述代表性:因为个体专业知识水平和表达不同,所以描述同一知识点的样本质量参差不齐、描述形式多样,因此加入记忆集的样本,要能够对描述该样本对应知识点的所有样本的不同质量,形式进行代表;所述差异性,对于样本、之间的差异,使用表层特征向量和隐式特征向量的距离进行度量,为了实现模型鲁棒性目标,选择多样性样本放入记忆集,即样本特征之间要具有差异性;所述平衡性,是指原数据集中描述的所有知识点在记忆集中都要被涵盖,而且原数据集中描述同一知识点的样本数量与记忆集中描述同一知识点的样本数量要保持平衡。

[0025]

根据本发明优选的,所述代表性,使用局部离群因子(local outlierfactor,lof)进行度量的具体方法:公式(viii)用于计算两个向量之间的距离:所述是两个表层特征向量或两个隐式特征向量,简称向量、向量;公式(ix)用于得到向量到向量的第可达距离:其中,表示在向量空间中,向量与其第近的向量之间的距离;公式(x)用于计算第局部可达密度:其中,是指向量的第距离内的所有向量的集合,其中向量的第距离是指向量达到第个邻近向量的距离;公式(xi)用于计算第局部离群因子:当向量的值大于1时,表明在向量空间中,当前向量的局部可达密度越小于其周围向量的局部可达密度,值越大,则当前样本离群性越大;当向量的值小于等于1时,表明在向量空间中,当前向量的局部可达密度越大于其周围向量的局部可达密度,值越小,则表明当前样本聚集性大;综合样本在表层特征空间和隐式特征空间中的局部离群情况得到样本的代表度,当lof值越小时,越大,其代表性越强:lof值的范围(0,+∞),根据上述对lof值小于等于1和大于1的情况进行的说明可以得知,lof值越大,对应向量的离群程度越大,该向量越可能是异常的;lof值越小,对应向量的离群程度越小,该向量越可能是正常的;公式(xii)为样本的计算方式:其中,是可调参数,,用于表示表层特征相对重要度,若表层特征重要,则增大;若隐式特征重要,则减小,默认值为0.5;公式(xii)的除法是为了对于不同的样本分布,始终保持在相近的范围。

[0026]

根据本发明优选的,所述差异性,对于样本、之间的差异,使用表层特征向量和隐式特征向量的l2距离进行度量的具体方法:如公式(xiii)(xiv)所示,其中是差异性阈值,为可调参数,默认为所有样本之间距离的均值:本之间距离的均值:

候选样本满足公式(xiii)(xiv)时才入选记忆集,此步骤是判断其与记忆集中的样本是否存在差异性。

[0027]

根据本发明优选的,所述平衡性,被选取加入记忆集的样本集合的特征分布与原数据集特征分布近似:其中,代表参数为的记忆集样本概率分布,为的简写,应视为一个整体;为原数据集样本概率分布;,分别为原数据集样本概率分布和记忆集样本概率分布的参数;对于一个概率分布,伴随一个决定其分布状况的特定参数,所以表示为;是集合运算的基本操作;表示样本;代表描述知识点的样本;为知识点组成的集合;样本加入后,验证该公式是否成立,如果成立,则符合平衡性的定义。

[0028]

上述过程中,涉及的超参有用户可以使用默认值,也可自定义以满足实际的业务需求。本发明所述两部分均可以让用户选择适合自己的策略进行样本选取,用户给定样本集,样本集之间的时序关系,以及策略和可选超参,本发明可根据既定算法自动选取历史样本加入记忆集,用于后续的面向专业知识点自然语言推理模型训练。

[0029]

一种实现上述样本选择方法的装置,其特征在于,包括:计算中心向量模块、样本选取模型和训练模块;所述计算中心向量模块,用于根据样本的标签信息,计算表层特征和隐式特征的中心向量,用作后续样本选择;所述样本选取模型,利用可选的样本选择策略,根据样本需要满足的特点,选取合适的样本加入记忆集,最终得到完整的记忆集;所述训练模块,利用所述完整的记忆集,辅助当前任务训练。

[0030]

一种实现上述样本选择方法的计算机设备,其特征在于:包括处理器、存储装置以及存储在存储装置上并可在所述处理器上执行的计算机程序;所述处理器执行计算机程序时实现如下过程:在使用阶段,用户给定任务,任务之间的先后关系,以及策略和可选超参;再根据样本选择方法中选取历史样本加入记忆集,用于后续的专业文本推理模型训练,即面向专业知识点自然语言推理模型训练。

[0031]

本发明的技术优势在于:本发明所述面向文本知识推理模型的持续学习样本选择方法能够兼顾代表性、平衡性和差异性等样本性质,相比于既往技术基于聚类中心选取代表性样本的方法,能更好地适配复杂文本推理场景,有效地使用少量样本去近似原样本的分布,使模型记忆历史任务上学习到的知识。

[0032]

本发明根据实际问题提出的高质量记忆集样本应该具有的性质和筛选的样本,能够精细地调优文本知识推理模型,能够更好地帮助模型记忆既往的任务,同时帮助模型训练当前任务,有效地增加模型在实际使用中的健壮性。

[0033]

除此之外,本发明也可以在自然语言处理领域的其他类似任务上使用,如知识问答、文本分类等基于情景记忆回放的持续学习任务。

附图说明

[0034]

图1是本发明中面向文本知识推理中任务与数据集的关系示意图;图2是本发明中面向文本知识推理的持续学习历史样本选择方法流程示意图;图3是本发明中面向文本知识推理的持续学习历史样本选择方法的选取样本流程示意图;图4是本发明中面向文本知识推理的持续学习当前样本选择方法的流程示意图。

具体实施方式

[0035]

下面结合实施例和说明书附图对本发明做详细的说明,但不限于此。

[0036]

实施例1、如图1、图2所示,一种面向文本知识推理模型持续学习的样本选择方法,包括:历史任务样本选取和当前任务样本选取;(1)其中所述历史任务样本选取,包括:获取中心向量和选取样本,如图2所示,所述中心向量是指描述同一知识点的所有样本的中心向量,所述选取样本是将选取的样本加入记忆样本集合中;所述获取中心向量时:对于形如的有标签样本集合,使用公式(i)(ii)计算其表层特征中心向量和隐式特征中心向量,其中代表数据集中描述第个知识点的所有样本,分别为获取文本的表层特征和隐式特征的函数:公式(i)(ii)中和的表示表层特征中心向量和隐式特征中心向量的次序,意为第个表层特征中心向量和第个隐式特征中心向量;获取文本的表层特征(obvious feature)和隐式特征(latent feature):所述表层特征,使用词频和逆文档频率表示,记为,所述隐式特征,使用sentence-bert向量表示,记为,其中为被编码的文本;所述选取样本时,流程如图3所示,包括:(1-1)确定选取加入记忆集中的样本个数:所述公式(iii)-(iv)是确定描述同一知识点的样本选取多少个加入记忆集中,根据任务的先后顺序,记当前任务为第个任务,历史第个任务的数据集中选取的样本量为,如公式(iii),其中为模型训练需要选取的样本总量,即记忆集样本量和当前任务选取样本量之和:

通过公式(iv)确定从第任务的数据集的第个知识点的相关样本中选取的样本数量为,以使得抽取的每个知识点的样本的数量分布与原数据集的一致:其中表示第个数据集;表示第个数据集中描述第个知识点的数据集;(1-2)选取样本:通过代表性、差异性、平衡性指标衡量样本来选取记忆集,并在选取样本时,利用下述两种方案之一遍历样本;方案

①

:根据样本向量与中心向量的距离升序进行遍历,其中向量包括表层特征向量和隐式特征向量;方案

②

:每个样本等概率随机进行遍历;若被遍历的样本满足代表性、差异性、平衡性,则加入记忆集;否则,舍弃被遍历的样本,继续进行下一个遍历,直至选取的样本数量满足要求;(2)其中,当前任务样本选取包括:样本代表性分析、样本困难性分析和样本采样;其流程如图4所示;为了减少训练成本,针对当前任务,希望选取非常少量样本进行训练,但少量样本难以代表总体样本的特征,因此,需要从当前任务数据集中抽取具有代表性和困难性的样本,用于文本知识推理模型训练;鉴于筛选样本的目的是精细调优文本知识推理模型,一方面,需要在有限样本约束下最大程度地满足对于总体样本的代表性,另一方面需要挑选出困难样本,困难样本可携带更多可让模型受益的信息,为此,本发明联合代表性和困难性这两个指标进行当前任务上的样本筛选;(2-1)所述当前任务样本选取中的样本代表性分析,包括:对于当前任务(第个任务)数据集的第知识点的候选样本集中的样本的假设文本表层特征向量组成的集合进行聚类,指定聚类数为,可以根据既往任务的知识点个数来确定,即选取与既往任务的知识点个数相近的数量,根据公式(vi),得到个聚簇;当前任务中第个知识点需要抽取的样本数量为,针对每个聚簇,计算簇中样本方差以及簇中样本数量来分析样本代表性:方差大且样本数量多的簇,其中每个样本对该簇的代表性就低,需从该簇中采样更多的样本以维持对该簇的代表性,根据公式(v)确定簇中采样的样本数量,意为第个任务中,针对第个知识点的第个簇中选取的样本数:样本数:(2-2)当前任务所述样本选取中的样本困难性分析,包括:

借助预训练的专业文本推理模型,输入样本的前提文本和假设文本进行推理预测,得到类别集合上预测概率分布,表示概率最大的类别标签,使用公式(vii)计算推理模型对样本所预测的概率分布中的最大输出概率与第二大输出概率的差值来衡量样本的困难性,越小,表示推理模型对其预测结果不置信,故样本困难性越高:其中表示专业文本推理模型预测样本类别为的概率,表示由专业文本推理模型预测样本类别为c的概率;(2-3)当前任务所述样本选取中的样本采样,包括:(2-3-1)对于当前任务数据集的第个知识点的候选样本集进行步骤(2-1)所述的样本代表性分析,得到从每个聚簇中的采样样本数量,以维持筛选出的样本集的代表性;(2-3-2)之后对样本进行步骤(2-2)所述的样本困难性分析,计算样本的困难性量化值;对于簇,从中采样困难性最高的个样本,即根据样本的值从小到大选取个样本,加入筛选的小样本集中;对簇均进行上述采样过程,完成知识点样本的采样;对当前任务中的所有知识点经过上述采样过程,完成在当前任务上的数据筛选,最终筛选出当前任务的训练用样本集数量为。

[0037]

实施例2、如实施例1所述一种面向文本知识推理模型持续学习的样本选择方法,在步骤(1)中,获取所述文本的表层特征具体方法:利用hanlp的粗粒度分词器对文本进行分词,分词结果中去除常见的中文停用词,并筛去只出现一次的词汇,得到所有文本的词典;最后计算每个文本的tf-idf特征向量作为样本的表层特征。

[0038]

在步骤(1)中,获取所述文本的隐式特征具体方法:使用sentence-bert模型的具体实现sentencetransformer,并加载预训练模型paraphrase-multilingual-mpnet-base-v2,以对文本进行编码,使用编码后的sentence-bert特征向量表示文本的隐式特征。

[0039]

实施例3、如实施例1、2所述一种面向文本知识推理模型持续学习的样本选择方法,在步骤(1-2)中,通过代表性、差异性、平衡性指标衡量样本来选取记忆集的方法,包括:对于一系列任务,每个任务上有对应的数据集,其中表示当前要学习的任务,表示其对应的数据集,数据集中每一个样本记为;文本知识推理模型在当前任务上进行学习时,使用记忆集进行记忆回放,其中,为集合并集操作,操作范围为当前

任务之前的所有任务,即;表示数据集中加入记忆集的样本构成的集合,为记忆集的简写;所述集合满足代表性、差异性和平衡性;所述代表性,使用局部离群因子(local outlier factor,lof)进行度量,所述代表性:因为个体专业知识水平和表达不同,所以描述同一知识点的样本质量参差不齐、描述形式多样,因此加入记忆集的样本,要能够对描述该样本对应知识点的所有样本的不同质量,形式进行代表;所述差异性,对于样本之间的差异,使用表层特征向量和隐式特征向量的距离进行度量,为了实现模型鲁棒性目标,选择多样性样本放入记忆集,即样本特征之间要具有差异性;所述平衡性,是指原数据集中描述的所有知识点在记忆集中都要被涵盖,而且原数据集中描述同一知识点的样本数量与记忆集中描述同一知识点的样本数量要保持平衡。

[0040]

所述代表性,使用局部离群因子(local outlier factor,lof)进行度量的具体方法:公式(viii)用于计算两个向量之间的距离:所述是两个表层特征向量或两个隐式特征向量,简称向量、向量;公式(ix)用于得到向量到向量的第可达距离:其中,表示在向量空间中,向量与其第近的向量之间的距离;公式(x)用于计算第局部可达密度:其中,是指向量的第距离内的所有向量的集合,其中向量的第距离是指向量达到第个邻近向量的距离;公式(xi)用于计算第局部离群因子:当向量的值大于1时,表明在向量空间中,当前向量的局部可达密度越小于其周围向量的局部可达密度,值越大,则当前样本离群性越大;当向量的值小于等于1时,表明在向量空间中,当前向量的局部可达密度越大于其周围向量的局部可达密度,值越小,则表明当前样本聚集性大;综合样本在表层特征空间和隐式特征空间中的局部离群情况得到样本的代表度,当lof值越小时,越大,其代表性越强:lof值的范围(0,+∞),根据上述对lof值小于等于1和大于1的情况进行的说明可以得知,lof值越大,对应向量的离群程度越大,该向量越可能是异常的;lof值越小,对应向量的离群程度越小,该向量越可能是正常的;公式(xii)为样本的计算方式:

其中,是可调参数,,用于表示表层特征相对重要度,若表层特征重要,则增大;若隐式特征重要,则减小,默认值为0.5;公式(xii)的除法是为了对于不同的样本分布,始终保持在相近的范围。

[0041]

所述差异性,对于样本之间的差异,使用表层特征向量和隐式特征向量的l2距离进行度量的具体方法:如公式(xiii)(xiv)所示,其中是差异性阈值,为可调参数,默认为所有样本之间距离的均值:本之间距离的均值:候选样本满足公式(xiii)(xiv)时才入选记忆集,此步骤是判断其与记忆集中的样本是否存在差异性。

[0042]

所述平衡性,被选取加入记忆集的样本集合的特征分布与原数据集特征分布近似:其中,代表参数为的记忆集样本概率分布,为的简写,应视为一个整体;为原数据集样本概率分布;,分别为原数据集样本概率分布和记忆集样本概率分布的参数;对于一个概率分布,伴随一个决定其分布状况的特定参数,所以表示为;是集合运算的基本操作;表示样本;代表描述知识点的样本;为知识点组成的集合;样本加入后,验证该公式是否成立,如果成立,则符合平衡性的定义。

[0043]

上述过程中,涉及的超参有用户可以使用默认值,也可自定义以满足实际的业务需求。本发明所述两部分均可以让用户选择适合自己的策略进行样本选取,用户给定样本集,样本集之间的时序关系,以及策略和可选超参,本发明可根据既定算法自动选取历史样本加入记忆集,用于后续的面向专业知识点自然语言推理模型训练。

[0044]

实施例5、一种实现如实施例1-4所述样本选择方法的装置,包括:计算中心向量模块、样本选取模型和训练模块;所述计算中心向量模块,用于根据样本的标签信息,计算表层特征和隐式特征的中心向量,用作后续样本选择;所述样本选取模型,利用可选的样本选择策略,根据样本需要满足的特点,选取合适的样本加入记忆集,最终得到完整的记忆集;所述训练模块,利用所述完整的记忆集,辅助当前任务训练。

[0045]

实施例6、一种实现如实施例1-4所述样本选择方法的计算机设备,包括处理器、存储装置以及存储在存储装置上并可在所述处理器上执行的计算机程序;所述处理器执行计算机程序时实现如下过程:在使用阶段,用户给定任务,任务之间的先后关系,以及策略和可选超参;再根据样本选择方法中选取历史样本加入记忆集,用于后续的专业文本推理模型训练,即面向专

业知识点自然语言推理模型训练。

相关技术

网友询问留言

已有0条留言

- 还没有人留言评论。精彩留言会获得点赞!

1