基于自监督学习的联邦学习方法和系统与流程

本技术涉及深度学习领域,特别是涉及一种基于自监督学习的联邦学习方法和系统。

背景技术:

1、训练高精度、泛化性能强的深度神经网络模型通常需要大规模且多样化的数据集,但是当数据涉及到用户隐私和个人信息时这一要求变得难以满足。随着个人隐私保护意识的增强,用户会倾向于选择将自己的私人数据保存在本地而拒绝互联网公司收集数据的请求。在另一些场景如需要使用跨企业或跨部门的数据对模型进行训练时,法律会要求企业清晰的列出数据保护的责任方以及数据的使用范围,这些场景都为人工智能在现实生活中的发展提出了挑战。

2、为了克服这个问题,联邦学习(fl)为上述数据孤岛问题提供了一种解决方案。它要求所有参与方使用其私有数据集在本地训练深度模型,并通过特定的中心节点来对本地模型进行聚合从而得到一个目标一致的全局模型。虽然联邦学习被有效的应用在大规模私有数据集联合训练的场景下,但仍然存在一定的限性,以下两方面问题是传统的联邦学习亟待解决的问题。

3、(1):参与方数据非独立同分布问题:联邦学习假设每个参与方的私有数据是独立同分布(iid)的。此要求在小规模联邦学习上是较为满足的,多个参与方以同样的方式从相似的场景中收集数据。然而,当问题的范围扩展到多个地理位置或多种应用场景时,参与方的私有数据集往往是非独立同分布的(non-iid)。在这种情况下,各参与方所训练的本地模型在特征提取的能力上有着一定的参差,仅仅通过线性组合的方式得到的全局模型会有着较弱的全局性能。

4、(2)模型异构问题:传统的联邦学习要求每个参与方训练一个相同架构的本地模型。在参与方均配备相同硬件和软件的场景这个要求是适用的,但是当参与方涉及的跨度较大(从智能穿戴设备,到移动终端、再到数据中心的服务器)时,联邦学习只能做出模型性能和训练耗时之间的妥协,且由于内存的限制,往往会在训练时出现木桶效应,只能按照硬件条件最弱的参与方设置模型的大小。

5、现有的解决上述问题的研究思路是通过迁移学习将多个本地模型的知识聚合在全局模型中,以处理数据非独立同分布问题。具体为局部模型所学习到的知识被开放数据集进行统一的量化,随后在中心节点对这部分知识进行聚合从而将所有参与方的知识进行聚合。

6、这种基于知识蒸馏解决非独立同分步的方法需要一个共享的开放数据集作为知识传递的媒介,这对开放数据集的数据特征分布提出了很高要求,开放数据集和私有数据集在特征分布上的不一致会导致该参与方传递的知识具有误导性,从而对全局模型的泛化性能造成影响。

技术实现思路

1、基于此,有必要针对上述技术问题,提供一种基于自监督学习的联邦学习方法。

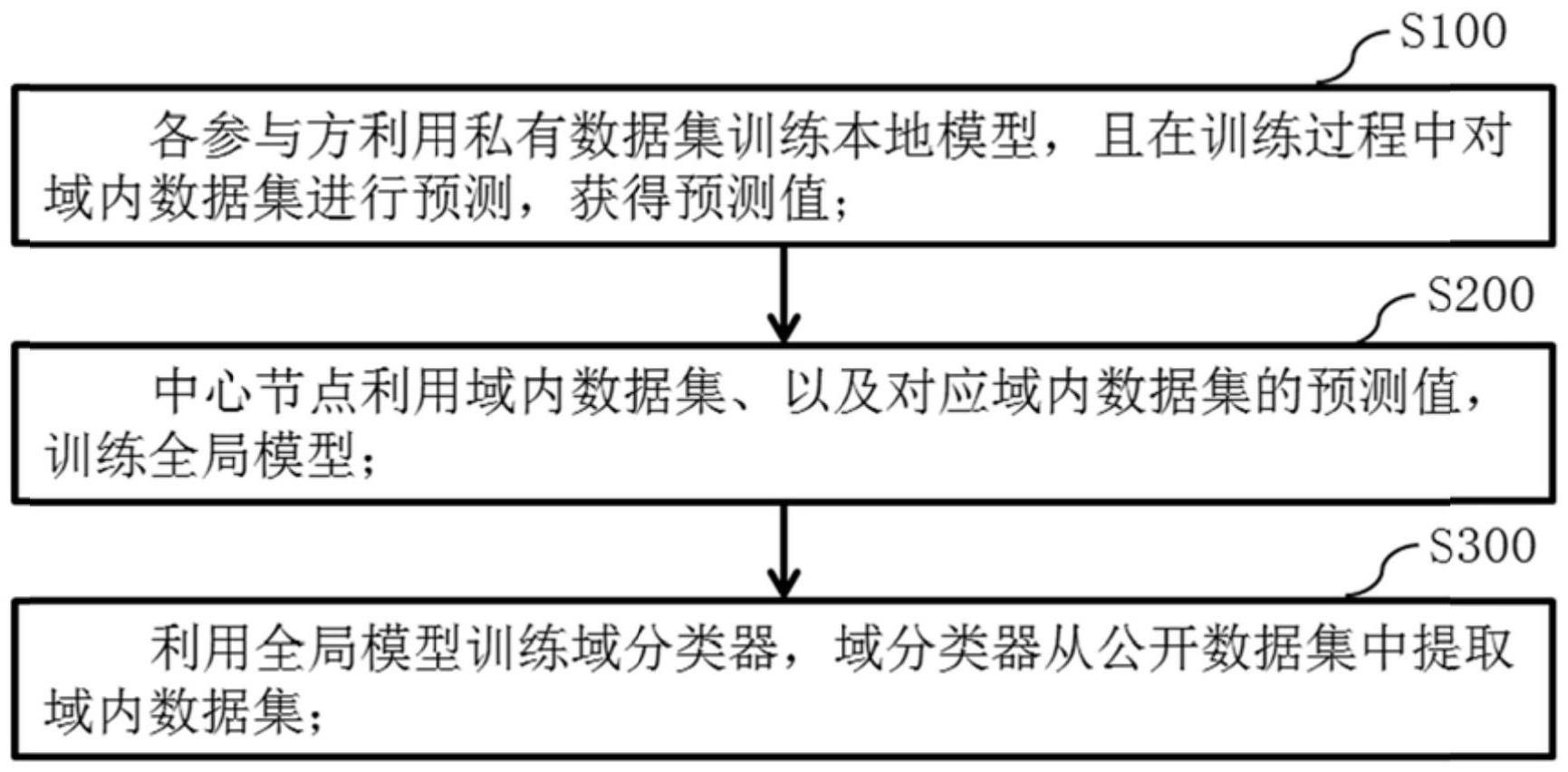

2、本技术基于自监督学习的联邦学习方法,实施在多个参与方和中心节点之间,包括:

3、各参与方利用私有数据集训练本地模型,且在训练过程中对域内数据集进行预测,获得预测值;

4、所述中心节点利用域内数据集、以及对应所述域内数据集的预测值,训练全局模型;

5、利用所述全局模型训练域分类器,所述域分类器从开放数据集中提取所述域内数据集。

6、可选的,所述全局模型、所述域分类器、以及各所述本地模型在训练过程中均迭代更新。

7、可选的,各所述本地模型在本轮对域内数据集进行预测时,使用上轮所述域分类器提取的域内数据集。

8、可选的,在首轮对域内数据集进行预测时,所述域内数据集随机提取于所述开放数据集。

9、可选的,各所述本地模型作为老师模型,所述全局模型作为学生模型,所述全局模型利用知识蒸馏的方式进行迭代更新;

10、各所述本地模型获得的预测值的均值,用于训练所述全局模型。

11、可选的,各所述本地模型为相同的结构类别,各所述本地模型的迭代,通过所述全局模型分发至各参与方的方式完成。

12、可选的,利用所述全局模型训练域分类器,包括:

13、所述全局模型产生输入样本的输出层信息;

14、所述域分类器获得所述输入样本、以及所述输入样本的输出层信息;

15、所述域分类器根据所述输出层信息得到评分,根据所述评分将符合预期的输入样本置入所述域内数据集。

16、可选的,根据所述评分将符合预期的输入样本置入所述域内数据集,具体包括:对所述评分排序后,按次序提取绝对数量或占比数量的对应的输入样本,置入所述域内数据集。

17、可选的,利用所述全局模型训练域分类器,包括:

18、利用所述全局模型的中间层信息,自监督地训练所述域分类器,所述中间层信息来源于所述全局模型中间层内在每个批量归一化层之前的特征图。

19、可选的,所述域分类器包括基底模型和多层感知机,所述基底模型为每轮迭代的所述全局模型,所述多层感知机作为检测头。

20、可选的,所述域分类器包括多层感知机,训练过程包括:

21、对输入样本进行数据增强,获得对比样本,所述输入样本和所述对比样本一一对应;

22、基于所述输入样本获得第一层次特征,基于所述对比样本获得第二层次特征,所述第一层次特征和所述第二层次特征一一对应;

23、利用所述第一层次特征、所述第二层次特征、以及二者的对应关系训练所述域分类器。

24、可选的,所述域分类器从开放数据集中提取所述域内数据集,包括:

25、所述域分类器接收所述第一层次特征、所述批量归一化层中的特征平均值串联,并输出二者的相对距离,所述相对距离用于将所述开放数据集划分为所述域内数据集和域外数据集。

26、可选的,所述域分类器从开放数据集中提取所述域内数据集,包括:

27、所述域分类器接收所述第一层次特征、所述批量归一化层中的特征平均值串联,并二者投影到嵌入空间中,所述相对距离为二者在投影在嵌入空间中的余弦距离,根据所述相对距离保留选择符合预期的、与所述第一层次特征相对应的输入样本,进而置入域内数据集。

28、可选的,基于所述对比样本获得第二层次特征,按照基于所述输入样本获得第一层次特征的方式进行;

29、基于所述输入样本获得第一层次特征,利用下式进行:

30、

31、式中,x为输入样本;

32、v(x)为输入样本的第一层次特征;

33、fi表示全局模型对于输入样本x在第i个批量归一化层之前的特征图;

34、gap表示将一张二维的特征图进行全局平均池化得到一个标量值;

35、为串联操作。

36、本技术还提供一种基于自监督学习的联邦学习系统,包括多个参与方和中心节点,实施有如本技术所述的基于自监督学习的联邦学习方法。

37、可选的,各参与方本地模型的结构类别至少包括两种,所述联邦学习方法包括:

38、所述全局模型的结构类别与其中一个参与方本地模型的结构类别相同,所述全局模型、所述域分类器、以及各所述本地模型在训练过程中均迭代更新,在每轮迭代更新的联邦聚合阶段中:

39、对于与所述全局模型的结构类别相同的本地模型,利用所述全局模型替换迭代所述本地模型;

40、对于与所述全局模型的结构类别不同的本地模型,利用所述域内数据集、以及对应所述域内数据集的预测值,以知识蒸馏的方式,更新迭代所述本地模型。

41、可选的,以知识蒸馏的方式,更新迭代所述本地模型,采用以下二者中的任意一种方式进行:

42、所述全局模型预测所述域内数据集,并根据预测值训练与所述全局模型结构类别不同的本地模型;

43、各所述本地模型获得的预测值的均值,用于训练与所述全局模型结构类别不同的本地模型。

44、本技术基于自监督学习的联邦学习方法和系统至少具有以下效果:

45、本技术并非通过简单地线性组合得到全局模型,使得全局模型具有更好的全局性能。此外,训练全局模型使用域内数据集,而非传统意义上的开放数据集,因此弱化了参与方对开放数据集的依赖,减小了开放数据集中的噪声对全局模型的负面影响。

46、本技术基于利用域分类器减少对开放数据集的基础上,既适用于各本地模型为相同的结构类别、还适用于各参与方本地模型的结构类别至少包括两种,这两种情况,不仅全局模型具有良好的全局性能,也能够解决本地模型异构的问题。

47、本技术域分类器采用自监督学习的方式进行训练,包括基底模型,基底模型为每轮迭代的全局模型,大大提高了域分类器的训练速度,加快了联邦学习方法。

- 还没有人留言评论。精彩留言会获得点赞!