本发明涉及人工智能,尤其涉及一种基于多类传感器信息的融合感知方法及系统。

背景技术:

1、多类传感器信息融合是利用计算机技术,依据一定的准则对来自多传感器的多源多模态信息和数据进行自动分析和综合,最终生成对观测环境的一致性解释。需要基于各传感器获得的分离观测信息,通过对信息多级别、多方面组合导出更多有用信息。不仅利用了多个传感器相互协同操作的优势,也综合处理了其它信息源的数据,以此来提高整个传感器系统的智能化。

2、近年来,融合感知任务发展迅速,从更高级的跨模态特征表示,到更复杂、健壮的深度学习模型和多模态融合技术,极大提高了融合感知算法的精度和鲁棒性。传统的融合方法可分为三大类:早期融合、深度融合和后期融合,无论是在数据级、特征级还是提案级,都侧重于深度学习模型中融合特征的阶段。

3、然而,现有方法大多需要待融合数据存在大片视野重合部分,难以实现大视差下的多源信息融合。在实际应用场景中,针对不同类型的传感器,往往有不同的数据采集需求,难以保证安装角度满足融合算法的要求。

技术实现思路

1、针对现有技术难以满足大视差下的多源信息融合需求的不足,本发明提出一种基于多类传感器信息融合的方法及系统。

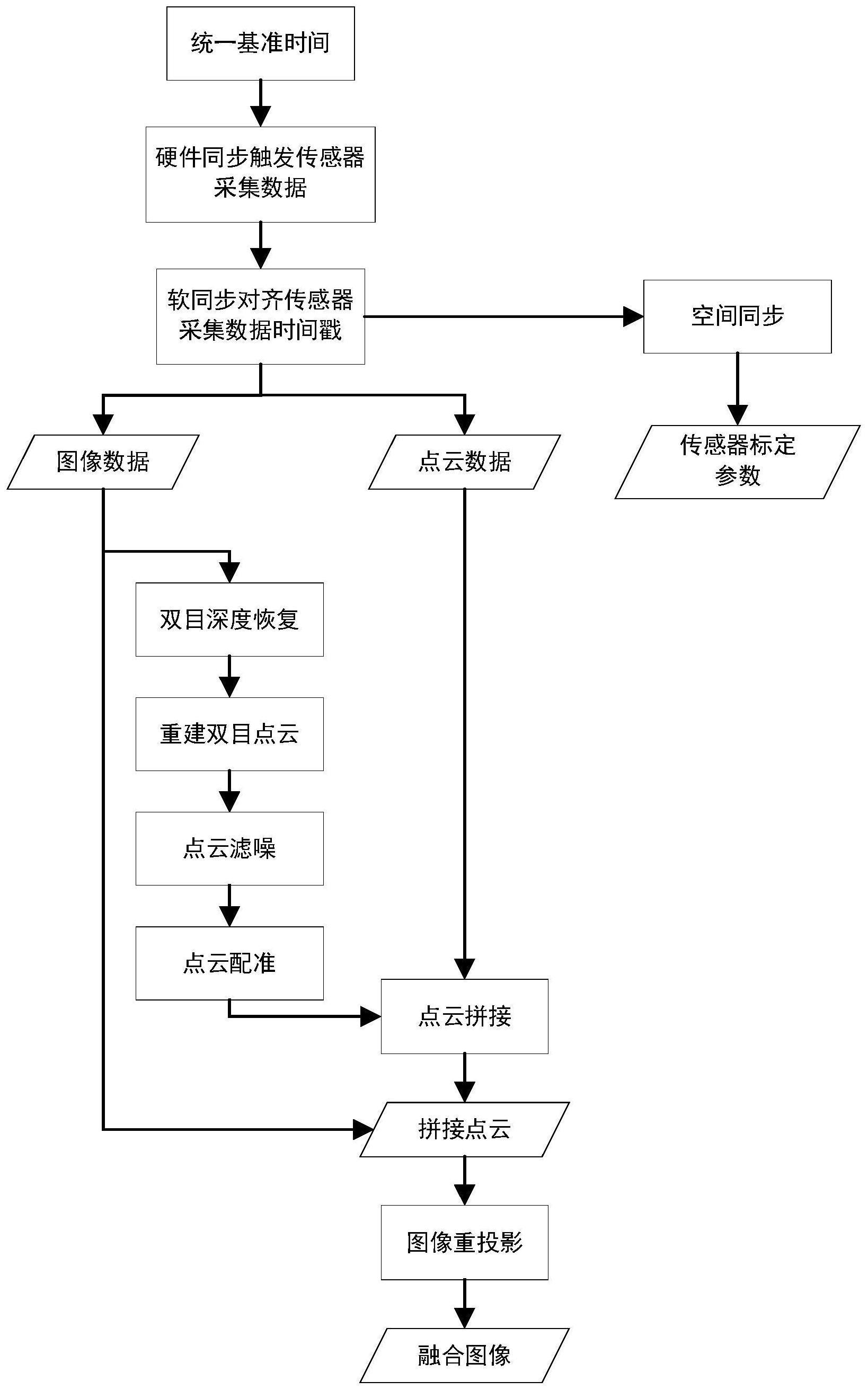

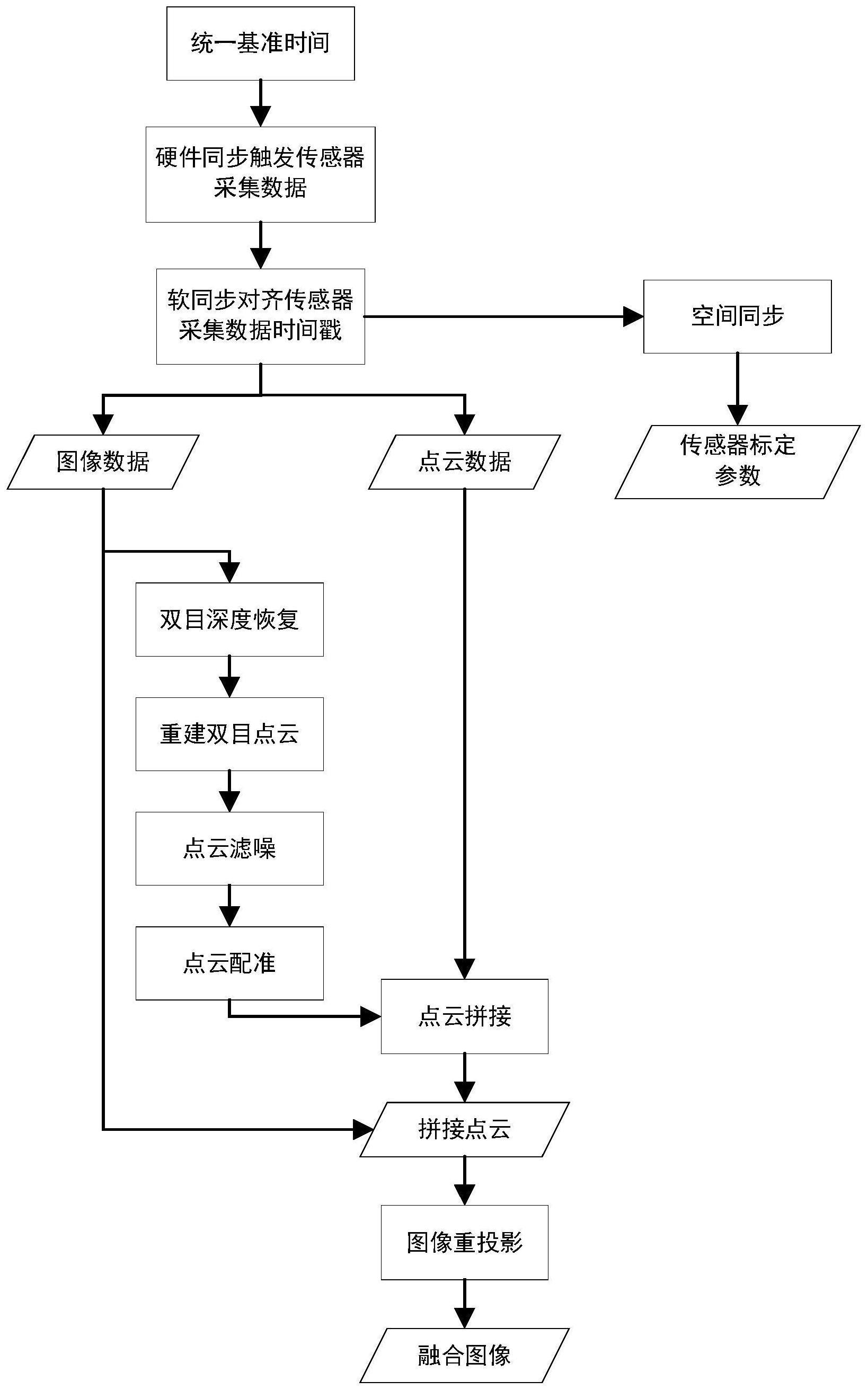

2、一种基于多类传感器信息的融合感知方法,包括以下步骤:

3、步骤一:通过唯一的时钟源给不同类型的传感器提供相同的基准时间,硬件同步触发不同类型传感器在同一时刻采集数据;

4、步骤二:获取不同类型传感器对应的多个输入信号,并通过时间软同步对齐不同类型传感器发布信息的时间戳,得到同一时刻来源于不同类型传感器的一组输入信号;

5、步骤三:控制图像传感器在同一时刻拍摄同一标定板,对拍摄到的图像分别提取特征点,根据特征点匹配结果,得到图像传感器的标定参数;

6、步骤四:利用可得到深度信息的传感器,如双目相机、tof、激光雷达,获取多组点云数据,根据传感器的标定参数,将多组点云投影到同一相机坐标系下,得到拼接点云;

7、步骤五:以拼接点云为中介,建立图像传感器部分二维像素点之间的对应关系,将不同传感器视野范围重合部分的信息投影到同一像素坐标系下;

8、步骤六:针对不同传感器视野范围不重合的部分,分别分割拼接点云与图像数据,利用分割结果计算得到多组单应性矩阵并分别投影,结合步骤五的投影结果,生成完整的融合图像。

9、进一步,步骤一具体包括:通过脉冲发生器矫正不同类型传感器的基准时间,所有传感器都被同一个脉冲触发,并在每次触发时都矫正传感器独立的时钟,以消除时钟源的累计误差。

10、进一步,步骤二具体包括:通过插值法将多组输入信号与采集频率最低的信号对齐,得到来源于不同传感器、采集于同一时刻的一组信号。

11、进一步,步骤三具体包括:先计算不同信号之间的信息损失函数,再利用优化算法求解相对位姿。

12、进一步,所述步骤四具体通过以下子步骤实现:

13、(4.1)双目相机深度恢复:将左右目图像输入到神经网络模型中进行视差图推理,得到稠密的视差图,根据双目相机的畸变参数,对稠密视差图进行畸变矫正,再依据双目相机的焦距和基线长度,通过矫正后的视差图生成深度图;

14、(4.2)重建双目点云:根据双目相机内参,得到二维像素坐标系与三维相机坐标系的投影关系,将深度图投影至相机坐标系,生成只有三维坐标信息、没有rgb信息的无色点云,再将左右目相机采集到的原始rgb图像投影至相机坐标系,为无色点云赋上颜色信息,得到rgb点云;

15、(4.3)点云滤噪:首先对原始点云进行下采样,将下采样后的点云输入到点云滤波器,输出需要滤掉的噪声点,在原始点云中找到噪声点,剔除噪声点及噪声点附近的点,得到滤噪后的点云;

16、(4.4)点云配准:以某一个点云为基准,利用点云配准算法重新计算其他点云的投影矩阵,以矫正其他点云投影时的外参;

17、(4.5)点云拼接:利用上述步骤矫正后的点云外参,将多组点云数据投影到同一相机坐标系下,得到保留最大视野信息的拼接点云。

18、进一步,所述步骤五具体通过以下子步骤实现:

19、(5.1)三维点云投影至二维平面:以所述步骤四得到的拼接点云为输入,分别将拼接点云投影至不同图像传感器的像素坐标系下,得到多组三维点云到二维像素坐标的映射关系;

20、(5.2)二维像素点配准:根据上述步骤得到的多组三维点云到二维像素坐标系的映射关系,找到同一个三维坐标在不同二维坐标系下的投影,建立不同二维坐标系之间的映射关系,根据映射关系将不同图像传感器采集到的二维图像投影至同一像素坐标系下,得到不同传感器视野重合部分的融合图像。

21、进一步,所述步骤六具体通过以下子步骤实现:

22、(6.1)三维点云分割:以所述步骤四得到的拼接点云为输入,运行三维点云语义分割网络,得到针对拼接点云的三维分割结果,即给每一个点云赋予类别标签;

23、(6.2)二维图像分割:以不同图像传感器采集到的图片为输入,运行二维图像语义分割网络,得到针对不同图像的二维分割结果,即给每一个像素坐标赋予类别标签;

24、(6.3)匹配分割结果:基于所述步骤五得到的三维点云到二维像素坐标的映射关系及不同二维坐标之间的映射关系,按照点云类别,给二维坐标系之间的映射关系分组,即通过同一类别的点云计算得到的二维坐标属于同一组,得到多组二维坐标映射关系,组数与分割得到的点云类别数相同;

25、(6.4)计算多组单应性矩阵:根据上述步骤的分组结果,分别根据每组二维坐标的映射关系计算单应性矩阵,得到多个单应性矩阵,个数与分割得到的点云类别数相同;

26、(6.5)根据分割结果,分组重投影:根据图像的二维分割结果,对同一类别的像素点使用同一个单应性矩阵,实现图像信息中视野不重合部分的投影,结合所述步骤五得到的视野重合部分的融合图像,生成完整的融合图像。

27、本发明还包括实现所述的基于多类传感器信息的融合感知方法的系统,包括:

28、硬件同步触发模块,通过唯一的时钟源给不同类型的传感器提供相同的基准时间,同步触发不同类型的传感器在同一时刻采集数据;

29、时间软同步模块,获取不同类型传感器对应的多个输入信号,并通过时间软同步对齐不同类型传感器发布信息的时间戳,得到同一时刻来源于不同类型传感器的一组输入信号;

30、空间同步模块,控制图像传感器在同一时刻拍摄同一标定板,对拍摄到的图像分别提取特征点,根据特征点匹配结果,得到图像传感器的标定参数;

31、点云拼接模块,利用可得到深度信息的传感器,如双目相机、tof、激光雷达,获取多组点云数据,根据传感器的标定参数,将多组点云投影到同一相机坐标系下,得到拼接点云;

32、重合视野图像重投影模块,以拼接点云为中介,建立图像传感器部分二维像素点之间的对应关系,将不同传感器视野范围重合部分的信息投影到同一像素坐标系下;

33、非重合视野图像重投影模块,针对不同传感器视野范围不重合的部分,分别分割拼接点云与图像数据,利用分割结果计算得到多组单应性矩阵并分别投影,结合步骤五的投影结果,生成完整的融合图像。

34、本发明还包括一种计算机可读存储介质,其上存储有程序,该程序被处理器执行时,实现本发明的基于多类传感器信息的融合感知方法。

35、一种计算设备,包括存储器和处理器,其中,所述存储器中存储有可执行代码,所述处理器执行所述可执行代码时,实现本发明所述的基于多类传感器信息的融合感知方法。

36、本发明的有益效果是:

37、(1)本发明可自适应配准多组点云数据,避免因运动时的震动导致的外参变化对融合精度的影响,提升算法鲁棒性。

38、(2)本发明使用先降采样再标记噪声点的方式对点云进行滤波,有效降低算法运行时间,提高融合帧率。

39、(3)本发明使用结合点云投影与语义分割的方式,将传统方法与深度学习网络相结合,实现大视差角度下非视野重合部分的融合。