一种基于多粒度的跨模态交互框架解决视频问答的方法及系统

本发明涉及计算机视觉和自然语言处理领域,具体涉及一种基于多粒度的跨模态交互框架解决视频问答的方法及系统。

背景技术:

1、多模态开放式的视频问答任务是一种结合计算机视觉和自然语言处理领域的多模态任务,该任务通过给定一个包含描述信息的视频和一个自然语言描述的问题,在理解视频内容和问题的基础上,自动地预测出问题的答案。

2、视频问答的目的是在理解多模态视频内容的基础上正确回答给定的问题。现有的解决视频问答任务的核心技术涉及图神经网络和注意力机制,图神经网络的思想是通过注意力机制来整合图结构中的邻域结点信息,实现对不同邻域结点权重的分配,获取视频信息来预测答案。注意力机制的思想是计算问题与视频信息之间的相似度,为与问题相关的视频信息分配较高的权重值,并基于此生成答案。

3、但是,现有的图神经网络仅关注视觉或语言的整体内容,有意义和细粒度的视觉或语言内容常常被忽略,这会导致视频问答模型遗漏了回答问题所需要的细节信息,从而影响了对于视频信息的理解,降低了答案预测的准确性。其次,目前的注意力模型难以有效整合同模态的视频、同模态的文本、以及跨模态视频和文本之间的信息。这会导致视频问答模型很难从大量的视频信息中找到正确答案的证据。因此,解决视频问答任务需要具有两个关键的功能:理解不同语义层次上的视频内容;灵活地整合不同模态的视频内容,来提取与问题相关的内容。

技术实现思路

1、为此,本发明提出一种基于多粒度的跨模态交互框架解决视频问答的方法及系统,以力图解决或者至少缓解上面存在的至少一个问题。

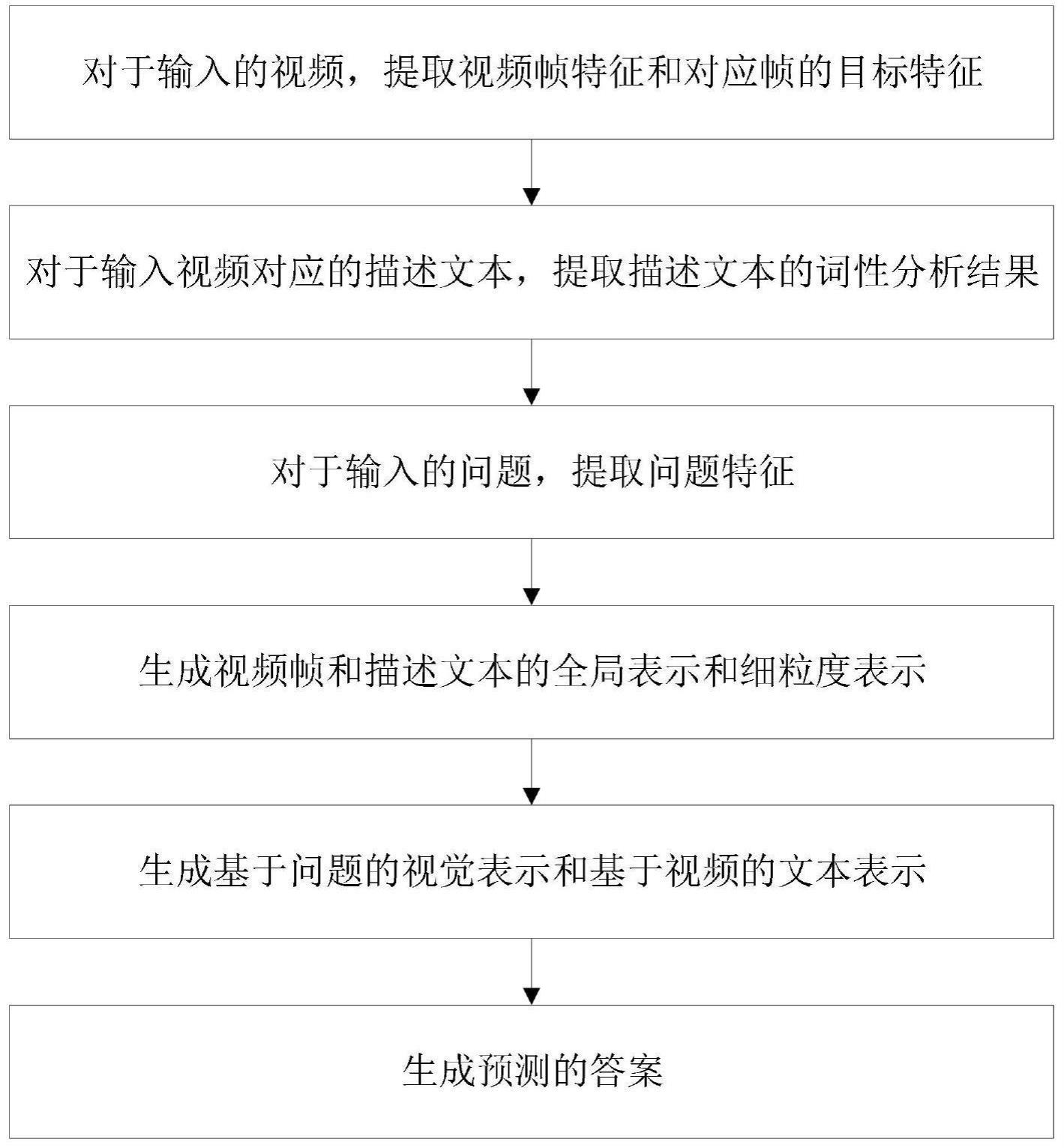

2、根据本发明的一方面,提供一种基于多粒度的跨模态交互框架解决视频问答的方法,该方法包括以下步骤:

3、s1、对于输入的视频,提取视频帧特征,所述视频携带对应的描述文本;同时对于视频帧中的目标,提取目标级特征,所述目标级特征包括目标特征、目标位置和类别标签;

4、s2、对于所述视频对应的描述文本,提取描述文本的词性分析结果;所述描述文本包括一个或多个;

5、s3、对于输入的有关视频内容的问题,提取所述问题的特征,即提取问题的词嵌入向量,获得问题中每个单词的语义信息;

6、s4、将提取的所述视频帧特征、所述目标级特征和所述词性分析结果输入到预训练的基于图神经网络的多粒度编码模块中,获得视频帧的全局表示和细粒度表示、描述文本的全局表示和细粒度表示;

7、s5、将视频帧的全局表示和细粒度表示、描述文本的全局表示和细粒度表示、问题的词嵌入向量一同输入到预训练的基于注意力机制的多模态注意力融合推理模块中,获得基于问题的视觉表示和基于视频的文本表示;

8、s6、根据基于问题的视觉表示和基于视频的文本表示获取预测的视频问答答案。

9、进一步地,s1中利用预训练的resnet模型提取视频帧特征,利用预训练的fasterr-cnn模型提取视频帧的目标特征。

10、进一步地,s2中利用srl工具包分析描述文本的词性,获取词性分析结果,所述词性分析结果包括每个描述文本对应的动词和实体。

11、进一步地,s3中利用预训练的wordembedding模型提取问题的特征。

12、进一步地,s4中获得视频帧的全局表示和细粒度表示的具体过程包括:

13、将提取的视频帧特征使用全连接层进行映射,得到视频帧的全局表示;

14、将视频帧中目标作为图结点,构建基于图神经网络的空间图gp=(vp,ep,rp)和语义图ge=(ve,ee);其中,vp和ve代表目标结点,ep代表空间图的边,ee代表语义图的边,rp代表视频帧中目标边框的相对位置;所述目标边框的相对位置是根据同一帧中目标位置计算获得的两个目标边框的iou值;

15、利用视频帧中目标位置和目标特征初始化空间图的结点;利用视频帧中目标类别标签和目标特征初始化语义图的结点;

16、利用视频帧中目标边框的相对位置和relu激活函数对空间图结点进行更新,计算公式如下:

17、

18、其中,表示空间图第i个结点在图神经网络第l层的更新;wp表示图神经网络的结点转换矩阵;bp(ri,j)表示目标边框的相对位置ri,j的学习向量;ni表示空间图中结点i的邻域;

19、对语义图的多个初始结点加权获得邻接矩阵,所述邻接矩阵包括每个结点的邻接点集合;根据邻接矩阵和relu激活函数对语义图结点进行更新,计算公式如下:

20、

21、其中,表示语义图第i个结点在图神经网络第l层的更新;ae,i表示第i个结点的邻接矩阵;表示利用邻接矩阵ae,i得到的与第i个结点相邻的结点;we表示变换矩阵;表示注意力系数;

22、利用图池将每一帧对应的更新后的空间图结点和语义图结点分别进行平均池化,分别获取帧级嵌入,并对多个视频帧的帧级嵌入进行堆叠,获得视频帧的细粒度表示。

23、进一步地,s4中获得描述文本的全局表示和细粒度表示的具体过程包括:

24、根据每个描述文本的词性分析结果构建角色图gr=(vr,er,tr),描述文本即句子,其本身作为全局结点,动词和实体分别作为动作结点和实体结点,每个动作结点直接连接全局结点,每个实体结点与不同的动作结点连接;其中,vr代表动词、实体、句子组成的结点,er代表角色图的边,tr代表每个结点的类型,类型包括动词、实体或句子;

25、对每个描述文本利用bert模型提取句子特征和词级特征,句子特征是将每个单词的语义信息按文本顺序拼接,得到有上下文的句子语义信息;词级特征是每个单词的语义信息;

26、对句子特征利用全连接层和双向长短期记忆网络得到句子级嵌入,对词级特征利用非线性投影初始化动词和实体结点;

27、基于描述文本的词性分析结果和relu激活函数更新角色图结点,计算公式如下:

28、

29、其中,表示角色图中第i个结点在图神经网络第l层的更新;wr1为嵌入矩阵,tr,i为tr中第i个结点的类型;ni表示角色图中第i个结点的邻域;wr2为变换矩阵;为注意力系数;表示角色图中第i个结点的邻域点在图神经网络第l层的更新;

30、在更新后,对多个描述文本的句子结点进行堆叠,得到描述文本的全局表示;使用图池对动作结点和实体结点进行平均池化,得到细粒度语言嵌入;

31、将多个描述文本的细粒度语言嵌入进行堆叠,得到描述文本的细粒度表示。

32、进一步地,s5中获得基于问题的视觉表示和基于视频的文本表示的具体过程包括:

33、将视频帧的全局表示和细粒度表示作为结点构造基于图神经网络的视觉图,将描述文本的全局表示和细粒度表示作为结点构造基于图神经网络的语言图,并对视觉图的结点进行编码,得到视觉图编码v′;对语言图的结点进行编码,得到语言图编码l′;

34、利用单层前馈网络将视觉图编码v′和问题的词嵌入向量q分别与语言图编码l′合并编码,得到编码后的视频表示v1和问题表示q1;

35、利用softmax函数对视频表示v1应用同模态注意力机制得到同模态下的视频编码vs,应用跨模态注意力机制得到跨模态下的视频编码vd;

36、利用softmax函数对问题表示q1应用同模态注意力机制得到同模态下的问题编码qs,应用跨模态注意力机制得到跨模态下的问题编码qd;

37、利用sigmoid激活函数将视频编码vs和vd融合,将问题编码qs和qd融合,得到视频表示v2和问题表示q2;

38、利用上下文注意力机制得到视频表示v2和问题表示q2的融合权重,根据融合权重和单层前馈网络得到基于问题的视觉表示vq和基于视频的文本表示qv。

39、进一步地,s6的具体过程包括:将基于问题的视觉表示vq和基于视频的文本表示qv进行拼接,得到问题参与的视觉表示h;对问题的词嵌入向量q通过双向长短期记忆网络得到问题表示q′,将视觉表示h和问题表示q′输入到分类器中计算每种答案的置信度;从答案中选择置信度最高的答案作为预测的答案。

40、根据本发明的另一方面,提供一种基于多粒度的跨模态交互框架解决视频问答的系统,该系统包括:

41、视频特征提取模块,其配置成对于输入的视频,提取视频帧特征,所述视频携带对应的描述文本;同时对于视频帧中的目标,提取目标级特征,所述目标级特征包括目标特征、目标位置和类别标签;

42、文本特征提取模块,其配置成对于所述视频对应的描述文本,提取描述文本的词性分析结果;所述描述文本包括一个或多个;

43、问题特征提取模块,其配置成对于输入的有关视频内容的问题,提取所述问题的特征,即提取问题的词嵌入向量,获得问题中每个单词的语义信息;

44、编码模块,其配置成将提取的所述视频帧特征、所述目标级特征和所述词性分析结果输入到预训练的基于图神经网络的多粒度编码模块中,获得视频帧的全局表示和细粒度表示、描述文本的全局表示和细粒度表示;

45、融合推理模块,其配置成将视频帧的全局表示和细粒度表示、描述文本的全局表示和细粒度表示、问题的特征一同输入到预训练的基于注意力机制的多模态注意力融合推理模块中,获得基于问题的视觉表示和基于视频的文本表示;

46、答案预测模块,其配置成根据基于问题的视觉表示和基于视频的文本表示获取预测的视频问答答案。

47、进一步地,所述编码模块中获得视频帧的全局表示和细粒度表示的具体过程包括:

48、将提取的视频帧特征使用全连接层进行映射,得到视频帧的全局表示;

49、将视频帧中目标作为图结点,构建基于图神经网络的空间图gp=(vp,ep,rp)和语义图ge=(ve,ee);其中,vp和ve代表目标结点,ep代表空间图的边,ee代表语义图的边,rp代表视频帧中目标边框的相对位置;所述目标边框的相对位置是根据同一帧中目标位置计算获得的两个目标边框的iou值;

50、利用视频帧中目标位置和目标特征初始化空间图的结点;利用视频帧中目标类别标签和目标特征初始化语义图的结点;

51、利用视频帧中目标边框的相对位置和relu激活函数对空间图结点进行更新,计算公式如下:

52、

53、其中,表示空间图第i个结点在图神经网络第l层的更新;wp表示图神经网络的结点转换矩阵;bp(ri,j)表示目标边框的相对位置ri,j的学习向量;ni表示空间图中结点i的邻域;

54、对语义图的多个初始结点加权获得邻接矩阵,所述邻接矩阵包括每个结点的邻接点集合;根据邻接矩阵和relu激活函数对语义图结点进行更新,计算公式如下:

55、

56、其中,表示语义图第i个结点在图神经网络第l层的更新;ae,i表示第i个结点的邻接矩阵;表示利用邻接矩阵ae,i得到的与第i个结点相邻的结点;we表示变换矩阵;表示注意力系数;

57、利用图池将每一帧对应的更新后的空间图结点和语义图结点分别进行平均池化,分别获取帧级嵌入,并对多个视频帧的帧级嵌入进行堆叠,获得视频帧的细粒度表示;

58、所述编码模块中获得描述文本的全局表示和细粒度表示的具体过程包括:

59、根据每个描述文本的词性分析结果构建角色图gr=(vr,er,tr),描述文本即句子,其本身作为全局结点,动词和实体分别作为动作结点和实体结点,每个动作结点直接连接全局结点,每个实体结点与不同的动作结点连接;其中,vr代表动词、实体、句子组成的结点,er代表角色图的边,tr代表每个结点的类型,类型包括动词、实体或句子;

60、对每个描述文本利用bert模型提取句子特征和词级特征,句子特征是将每个单词的语义信息按文本顺序拼接,得到有上下文的句子语义信息;词级特征是每个单词的语义信息;

61、对句子特征利用全连接层和双向长短期记忆网络得到句子级嵌入,对词级特征利用非线性投影初始化动词和实体结点;

62、基于描述文本的词性分析结果和relu激活函数更新角色图结点,计算公式如下:

63、

64、其中,表示角色图中第i个结点在图神经网络第l层的更新;wr1为嵌入矩阵,tr,i为tr中第i个结点的类型;ni表示角色图中第i个结点的邻域;wr2为变换矩阵;为注意力系数;表示角色图中第i个结点的邻域点在图神经网络第l层的更新;

65、在更新后,对多个描述文本的句子结点进行堆叠,得到描述文本的全局表示;使用图池对动作结点和实体结点进行平均池化,得到细粒度语言嵌入;

66、将多个描述文本的细粒度语言嵌入进行堆叠,得到描述文本的细粒度表示。

67、本发明的有益技术效果是:

68、本发明提出了一个基于多粒度的跨模态交互框架来解决视频问答任务。为了充分理解不同语义层次的视频内容,提出了基于图神经网络的多粒度编码模块。具体来说,利用基于图神经网络的视觉和语言编码器对提取的视频帧特征、目标特征以及描述文本进行编码,获取多粒度的视觉表示和语言表示。其次,为了有效捕获同模态的视频、同模态的文本,以及跨模态视频和文本之间的交互信息,提出了多模态注意力融合推理模块。具体来说,分别对多粒度视觉表示和语言表示进行编码融合,执行以问题为导向的注意力机制来捕获信息,将同模态的视频、同模态的文本分别与跨模态视频和文本之间的交互信息融合,获取与问题相关的视觉表示,并基于此预测答案。

69、本发明利用图神经网络处理视频的不同语义层次信息,并通过注意力模块捕获视觉信息和语言信息,推理出以问题为导向的视觉表示,并基于此来预测答案。其中,对视频提取视频帧和目标特征,对描述文本进行词性分析,获取不同单词的词性信息,提升了视频信息的获取能力;设计的基于图神经网络的多粒度编码模块,获取了视频与描述文本的全局表示和细粒度表示,从不同的语义层次上理解视频内容,提高了推理的准确性;设计的多模态注意力融合推理模块,捕获了视觉信息和语言信息,并将获取到的多模态信息与问题特征充分融合,灵活整合了不同层次的视频内容,提升了对视频信息的理解能力。

70、在msrvtt-qa数据集上的实验结果表明,本发明提出的基于多粒度的跨模态交互框架解决视频问答的方法优于其他方法。

- 还没有人留言评论。精彩留言会获得点赞!