一种2D图像目标检测框自动标注与缩边方法与流程

本发明涉及自动驾驶标注,尤其涉及一种2d图像目标检测框自动标注与缩边方法。

背景技术:

1、近年来,伴随着科学技术的发展与设备应用层面的更新迭代,自动驾驶已经逐步走进人类的生活当中。各大汽车主机厂、高校、研究所、高新科技企业都纷纷将自动驾驶相关的软硬件技术落地作为工作的重心。感知环节是自动驾驶中最重要的环节之一,它充当了自动驾驶的“眼睛”。感知环节主要涉及到激光雷达、毫米波雷达、摄像头等传感器设备的应用,它能够检测周围环境的信息,并送入后续的流程以供一系列分析和决策。自动驾驶场景中的感知环节离不开以深度学习为骨架的感知算法。深度学习是一项重度数据依赖的工作,训练一个效果好,精度高,泛化性强的感知模型往往需要大量的有标签数据。在这个环节中,如何高效、快速地获得大量有标签数据、提高数据标注的效率是一个至关重要的问题。对于进一步推进自动驾驶领域的发展,数据标注的重要性不言而喻。

2、视觉传感器是感知环节中最基本也是重要的传感器,视觉传感器能够采集到图像信息,通过对图像信息的理解,自动驾驶系统可以感知和判断车辆周边环境,并做出相应的决策。相比于激光雷达等其他传感器,视觉传感器中的摄像头的部署成本较低,处理图像的计算速度更快,而且所需计算资源较少,是一种经济高效的解决方案。摄像头不仅可以提供目标的位置信息,还可以提供其他信息,如颜色、形状、纹理等。这种信息对于识别目标对象至关重要,而其他传感器可能无法提供这些信息。例如,当一辆自动驾驶汽车在道路上行驶时,它需要识别和跟踪前方的障碍物、识别和判断交通信号灯的颜色、看到和读懂路牌标志和警告标志等等。这些都需要通过摄像头采集到的图像信息来实现,因此,摄像头在自动驾驶中扮演着至关重要的角色。在目前主流的自动驾驶解决方案中,有些采用纯视觉方案,有些采用视觉传感器加激光雷达的方案,有些计划采用4d毫米波雷达来代替激光雷达为视觉传感器提供辅助信息的方案。在这些方案中,无一例外都是以视觉传感器作为最重要和最基本的传感器,这也说明了视觉传感器在自动驾驶感知环节中不可被取代的重要性。

3、2d图像目标检测任务是计算机视觉领域中的一项任务,旨在从二维图像中自动识别出其中有意义的目标物体,并用目标框将其标志出来,例如在一张道路场景的图片上标志出车辆、行人、交通信号灯、障碍物等各个目标框。在技术实现上,2d图像目标检测任务细分为两个步骤,其一是获取目标框的位置,其二是对每个目标框进行类别的划分。这类任务通常由经过精心设计和大量数据训练后的深度神经网络模型来实现。在自动驾驶领域中,2d图像目标检测算法是环境感知、目标追踪等更高级任务的前置任务,它可以用于帮助自动驾驶车辆理解周围道路环境和交通状况,检测出视觉传感器捕获的图像中的各种交通对象,如车辆、行人、交通信号灯、障碍物等,并精确地定位它们的位置,在保证场景理解准确性的基础上为自动驾驶决策提供支持。

4、在进行自动驾驶应用开发中,需要大量的带标签的数据来训练计算机视觉模型。这是因为训练模型需要输入数据和相应的标签(比如所属类别、位置坐标等),从而使得模型能够通过学习提高其对于不同场景下视觉信息的抽象理解能力,获得更好的目标检测、分类、跟踪等能力。在模型训练的过程中,数据及其标注的质量至关重要。数据带有的标注信息需要准确描述目标的具体特征、位置信息等,以便计算机视觉模型能够学习和识别不同对象并正确地响应相应的行为和决策。如果数据集中标注信息有误或标注不规范,那么这些问题可能会传递到训练的计算机视觉模型中,导致其输出结果存在偏差、基础误差等问题。因此,数据标签的质量需要保证高度准确和一致性,才能够支撑计算机视觉模型的准确学习和应用。

5、以深度学习为基础的计算机视觉技术的发展为自动驾驶领域带来了前所未有的机遇,越来越多的汽车厂家开始将深度学习模型应用于自己的产品中。然而,这项技术所需要的大量优质的带标注数据却并不容易获取,目前数据需求量与供应量之间的差距仍在逐渐扩大,如何有效地提高标注效率、更快速地获得优质带标注数据成为了他们所必须面对的问题之一。过去,人工标注方法是最主流的方式,但这种方式的缺点却也十分明显,时间耗费较多,标注效率难以提高,人工标注的价格通常比较昂贵,并且标注质量难以控制。在这种背景下,近期市面上逐渐诞生出一系列标注系统,这些标注系统结合深度学习算法,提供了自动或者半自动的标注功能,但是这些方法的精确度仍不能满足最终交付需求,因此还需要结合人工质检以持续提高标注效果。结合深度学习算法的自动或者半自动标注系统,其设计的本意在于使用深度学习算法的预测功能代替一部分人工劳动力,从而达到降本增效的目的。然而在这个环节中,所能节省的人力成本和时间成本完全取决于其集成的深度学习算法能否准确地、有效地预测目标物体的位置和类别。若算法自动生成的目标框信息不够精确,则在后续的人工质检和微调部分仍需花费大量的成本,并可能造成额外的时间开销。时代背景和技术发展对数据的需要,催生出对一种高效率、高精度的自动标注方法的迫切需求。

6、因此,本领域的技术人员致力于开发一种2d图像目标检测框自动标注与缩边方法。

技术实现思路

1、有鉴于现有技术的上述缺陷,本发明所要解决的技术问题是减轻自动驾驶行业中高质量有标签数据获取过程成本昂贵、效率低下。

2、发明人分析了图像目标检测标注的现状,大部分图像目标检测标注仍采用全手动标注,没有算法作为预标,标注的质量只能依靠标注员工的熟练程度和专注度进行标注,标注的准确性不可控。其次,因为手动标注,所以成本难以得到控制,手动标注的用人成本会随着数据量增加成指数级增加。尽管现有技术已有诸多半自动或自动的图像目标检测标注系统搭载了深度学习算法,但其生成的标注框往往存在准确性低、对场景变化适应性低等问题,导致在后续人工质检和微调环节中仍需要大量的人工参与,难以做到真正的降本增效。另外,对于图像中存在的部分遮挡或截断程度高、算法预测难度大的目标物体,直接采用全图目标检测算法往往难以做到精确识别。对于这一部分目标物体,市面上的标注系统往往选择采用直接人工标注的方式,没有利用到深度学习算法。

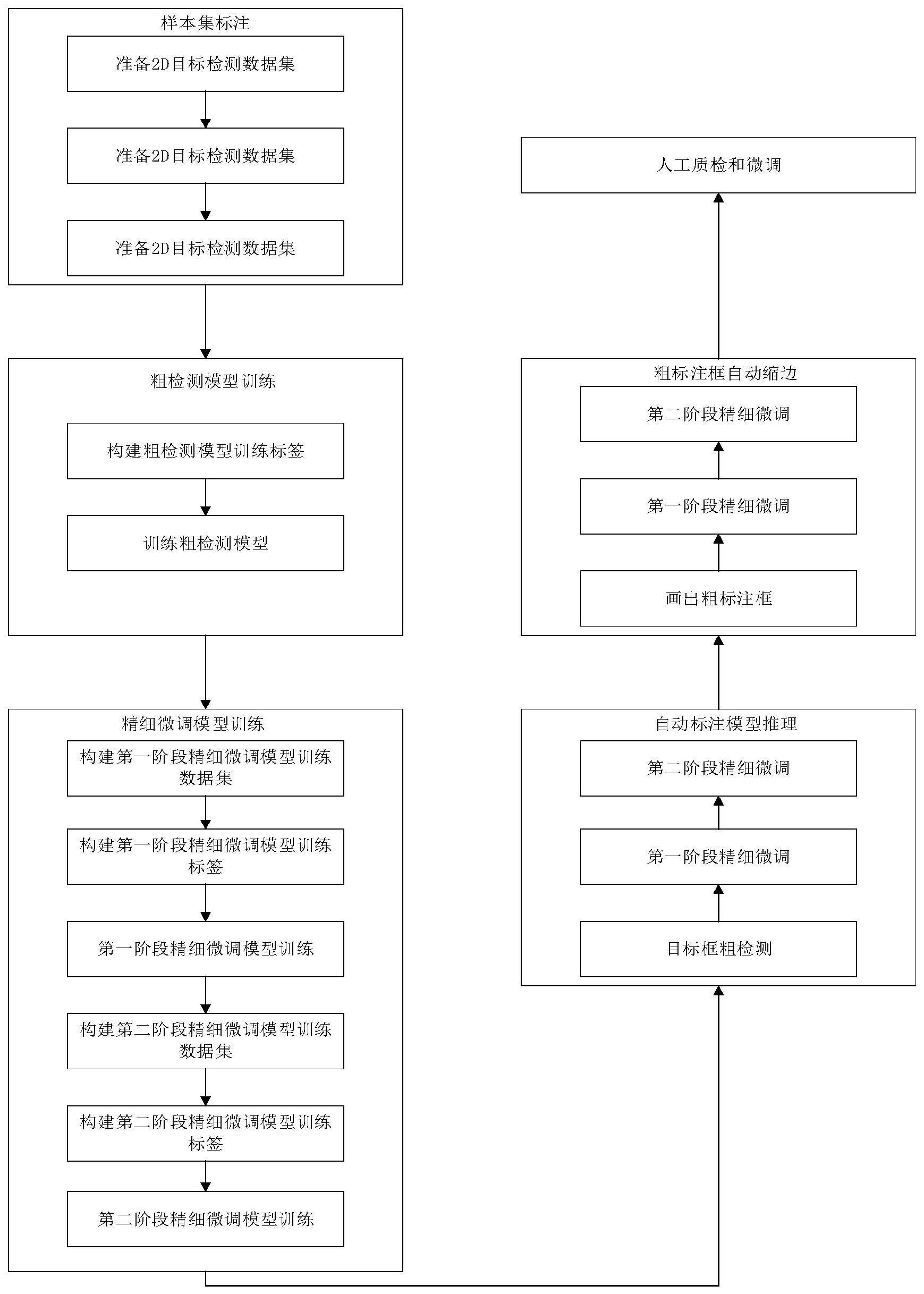

3、本发明的一个实施例中,提供了一种2d图像目标检测框自动标注与缩边方法,包括:

4、s100、样本集标注,从数据集划分样本集并进行标注;

5、s200、粗检测模型训练,训练粗检测模型;

6、s300、精细微调模型训练,训练精细微调模型;

7、s400、自动标注模型推理,使用粗检测模型和精细微调模型对数据集中所有图片数据进行推理;

8、s500、粗标注框自动缩边,使用精细微调模型对粗标注框进行缩边;

9、s600、人工质检和微调,人为对模型推理结果进行检查和精细修改。

10、可选地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,步骤s100包括:

11、s110、准备数据集,数据集包括全部的2d图像目标检测的图片数据:

12、s120、样本集划分,通过一定的采样方法从数据集中获取一定比例的图片数据作为样本集;

13、s130、样本集数据标注,根据检测的目标类别和标注规则来完成样本集中图片标注。

14、可选地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,一定的采样方法包括均匀采样。

15、可选地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,一定的采样方法包括随机采样。

16、进一步地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,一定比例优选20%。

17、可选地,在上述任一实施例中的2d图像目标检测框自动标注与缩边方法中,步骤s200包括:

18、s210、构建粗检测模型训练标签,对标注信息中的真实目标框做扩展,构建粗检测模型训练标签;

19、s220、训练粗检测模型,以样本集中图片和粗检测模型训练标签作为粗检测模型训练的输入进行训练,训练完成后,将粗检测模型权重进行保存。

20、进一步地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,s210还包括固定地生成与真实目标框同中心、按照交并比、并完全包含真实目标框的虚拟目标框作为粗检测模型训练标签。

21、进一步地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,粗检测模型为深度神经网络模型,样本集中图片首先输入骨干网络,提取出多尺度图像特征,多尺度图像特征被送入颈部网络进行特征融合,融合好的特征被送入头部网络预测粗检测目标框,并计算粗检测目标框和真实目标框之间的损失函数。

22、进一步地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,骨干网络采用swin-transformer,颈部网络采用upernet,头部网络采用deformable-detr。

23、进一步地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,交并比优选为0.7。

24、可选地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,步骤s300包括:

25、s310、构建第一阶段精细微调模型训练数据集,对标注信息中的真实目标框做扩展,构建第一阶段精细微调模型训练数据集;

26、s320、构建第一阶段精细微调模型训练标签,对标注信息中的真实目标框做扩展,构建第一阶段精细微调模型训练标签;

27、s330、第一阶段精细微调模型训练,以第一阶段精细微调模型训练数据集和第一阶段精细微调模型训练标签作为输入,进行第一阶段精细微调模型训练,训练完毕后,将第一阶段精细微调模型权重进行保存;

28、s340、构建第二阶段精细微调模型训练数据集,对标注信息中的真实目标框做扩展,构建第二阶段精细微调模型训练数据集;

29、s350、构建第二阶段精细微调模型训练标签,以标注信息中的真实目标框作为第二阶段精细微调模型训练标签;

30、s360、第二阶段精细微调模型训练,以第二阶段精细微调模型训练数据集和第二阶段精细微调模型训练标签作为输入,进行第二阶段精细微调模型训练,训练完毕后,将第二阶段精细微调模型权重进行保存。

31、进一步地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,步骤s310包括:

32、s311、随机生成与真实目标框交并比为0.5至0.8之间,并且包含真实目标框的虚拟裁剪框;

33、s312、使用虚拟裁剪框对样本集中图片进行裁剪,裁剪所得的图片作为第一阶段精细微调模型训练数据。

34、可选地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,s311中每个真实目标框随机构建大于等于1个虚拟裁剪框,进行数据增强,丰富第一阶段精细微调模型训练数据集。

35、进一步地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,步骤s320还包括固定生成与真实目标框同中心,交并比为0.9,并完全包含真实目标框的虚拟目标框作为第一阶段精细微调模型训练标签。

36、进一步地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,步骤s340包括:

37、s341、随机生成与真实目标框交并比为0.9、并且包含真实目标框的虚拟裁剪框;

38、s342、使用虚拟裁剪框对样本集中图片进行裁剪,裁剪所得的图片作为第二阶段精细微调模型训练数据。

39、可选地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,s341中每个真实目标框随机构建大于等于1个虚拟裁剪框,进行数据增强,丰富第一阶段精细微调模型训练数据集。

40、可选地,在上述任一实施例中的2d图像目标检测框自动标注与缩边方法中,第一阶段精细微调模型和第二阶段精细微调模型为深度神经网络模型,整体网络架构采用deformable-detr网络,第一阶段精细微调模型训练数据集和第二阶段精细微调模型训练数据集送入deformable-detr网络进行目标框的预测,并计算预测框和真实目标框之间的损失函数。

41、进一步地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,损失函数采用二分图匹配算法;

42、进一步地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,损失函数计算过程为:首先计算所有预测框和所有真实目标框之间的总体开销,总体开销是类别开销、目标框开销和交并比开销的加权和;假定有m个预测框和n个真实目标框,m和n为大于1的正整数,且m大于n,计算所得的总体开销为m*n的矩阵,采用匈牙利匹配算法对总体开销求解分配策略,使得所匹配的预测框和真实目标框之间的总体开销之和最小,剩余m-n个未匹配的预测框被分配至背景类,不参与损失函数的计算;最后对已匹配的n对预测框和真实目标框计算损失函数。

43、进一步地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,总体开销计算公式为:

44、costtot=α1×costcls+α2×costbbox+α3×costiou (1)

45、其中,costtot代表总体开销,

46、

47、costcls代表类别开销,probc代表所预测的预测框属于类别c的概率,ic(clstgt=c)指示真实目标框的类别是否为c,若其类别为c,则其指示值是1,若其类别不为c,则其指示值是0;

48、

49、costbbox代表目标框开销,其中的xywh分别代表预测框和真实目标框的中心点坐标和长宽;

50、

51、costiou代表交并比开销,其中的boxp和分别代表预测框和真实目标框;

52、α1,α2,α3分别为类别开销的权重、目标框开销的权重和交并比开销的权重,用于调整三种开销的重要程度。

53、进一步地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,匈牙利匹配算法对于总体开销求取一个最优分配策略,使得总体开销之和最小,公式如下:

54、

55、其中,m代表预测框总数,n代表真实目标框总数,xi,j为第i个预测框与第j个真实目标框之间的总体开销,ci,j为第i个预测框与第j个真实目标框的匹配结果,

56、

57、可选地,在上述任一实施例中的2d图像目标检测框自动标注与缩边方法中,步骤s400包括:

58、s410、目标框粗检测,用粗检测模型权重对数据集中的每一张图片做推理,得到粗检测目标框;

59、s420、第一阶段精细微调,使用粗检测目标框对样本集中图片进行裁剪,将裁剪所得的图片作为第一阶段精细微调的输入,用第一阶段精细微调模型权重来对第一阶段精细微调的输入做推理,得到第一阶段精细微调结果;

60、s430、第二阶段精细微调,使用第一阶段精细微调结果对样本集中图片进行裁剪,将裁剪所得的图片作为第二阶段精细微调的输入,用第二阶段精细微调模型权重来对第二阶段精细微调的输入做推理,将推理得到的预测目标框放回原图位置上,得到最终推理结果。

61、可选地,在上述任一实施例中的2d图像目标检测框自动标注与缩边方法中,步骤s500为可选步骤,对于数据集中存在的一些遮挡或截断程度高、算法直接预测难度大的目标物体的图片,选择使用此步骤进行辅助标注,用户只需画出一个包含目标物体的粗标注框,算法自动为粗标注框进行缩边贴合目标物体。

62、进一步地,在上述实施例中的2d图像目标检测框自动标注与缩边方法中,步骤s500包括:

63、s510、画出粗标注框,对于待标注的图片,画出包含目标物体的粗标注框;

64、s520、第一阶段精细微调,将画出的粗标注框作为虚拟裁剪框,使用虚拟裁剪框对待检测的图片进行裁剪,将裁剪所得的图片作为第一阶段精细微调的输入,用第一阶段精细微调模型权重来对第一阶段精细微调的输入做推理;

65、s530、第二阶段精细微调,将第一阶段精细微调输出的目标框作为虚拟裁剪框,使用虚拟裁剪框对待检测的图片进行裁剪,将裁剪所得的图片作为第二阶段精细微调的输入,用第二阶段精细微调模型权重来对第二阶段精细微调的输入做推理,将推理所得的预测目标框放回原图位置上,作为最终缩边结果。

66、本发明采用了多个神经网络、多阶段预测,利用一个较大的模型进行目标物体的粗检测,随后用多个微调模型对粗检测结果多阶段精细微调,生成的目标框具有更高的准确性;本发明采用多阶段的预测方式,既能够支持全图自动预标注,还应用到人工粗标注框的自动缩边任务上;在自动缩边任务中,将人工粗标注框视作粗检测模型所输出的粗检测目标框,直接送入多阶段精细微调模型,生成与目标物体精细贴合的目标框;对于图像中存在的一些遮挡或截断程度高、算法预测难度大的目标物体,利用自动缩边功能来辅助标注,显著缩短了标注时间;本发明采用高精度、多阶段的深度学习算法,生成的目标框精度高,较好地适应场景变化,目标框与真实目标框之间的交并比高于0.95,显著提升了标注效率,降低了人工标注所需时间和成本。

67、以下将结合附图对本发明的构思、具体结构及产生的技术效果做进一步说明,以充分地了解本发明的目的、特征和效果。

- 还没有人留言评论。精彩留言会获得点赞!