一种基于联合隐变量的变分自回归对话生成装置及方法

本发明属于自然语言处理,特别是涉及一种对话生成中融合外部非结构化知识、知识选择和知识感知的对话生成装置及方法。

背景技术:

1、序列到序列为代表的对话生成技术已经相对成熟,但倾向于生成短回复和普通回复,主要原因是对话系统缺少知识。而知识对于理解语言和生成语言是至关重要,外部知识如常识、背景知识是组织对话语句的重要信息来源,其中非结构化外部知识如百科文章、领域知识文档和社交媒体评论等,相比结构化知识(知识图谱)数量更多,更易获取。融合外部非结构化知识的对话系统能够识别用户谈及的实体或话题,并将它们与现实世界中的事实联系起来,例如检索相关的背景信息、引入新的对话话题,以积极主动的方式同用户交谈;还可通过不断增加知识来训练,具有极高的可拓展性。因此,有必要将外部非结构知识引入到对话系统中,以此来提高对话回复的质量,生成更有信息量和更具多样性的对话。

2、在融合非结构化外部知识的对话系统中,典型的任务框架包括知识选择和回复生成两个子任务。现有的研究工作中知识选择方法包括使用回复语句作为后验信息和标签知识作为后验信息。例如postks算法使用回复语句作为后验信息,不依赖标签知识,以此建模知识选择的后验分布,通过缩小知识选择先验分布与后验分布的差距,来提高知识的准确性,进而进行对话的回复生成,但知识选择是基于单轮对话。skls算法针对多轮对话场景中,将知识选择建模为序列隐变量,依赖对话上文和历史被选知识提高知识选择的准确性。pipm算法进一步改进skls算法,针对先验知识选择模块没有获取到后验信息,导致测试阶段可能选择不准确的知识,进而影响知识感知的回复生成的问题,提出预测回复语句的信息作为补充,但其知识选择的后验信息仍通过回复语句。有研究者提出差异感知的知识选择器,即考虑本轮和前一轮被选知识的差异,帮助知识选择的平滑过渡。此外,dukenet算法考虑知识追踪和知识漂移,基于对偶学习范式来提高两者的准确性;colv算法使用标签知识作为后验信息,并考虑知识选择和回复生成两者的联系,通过联合隐变量模型同时提高回复生成的多样性,但回复生成的隐变量是全局单一隐变量。

3、通过研究分析,发现现有技术仍存在以下挑战:(1)知识选择隐变量的后验分布是通过对话上文和标签知识计算的,先验分布仅通过对话上文计算。存在先验分布和后验分布的鸿沟,会导致知识选择阶段做出不合理的选择,进而影响生成回复语句的质量;(2)回复生成的隐变量是全局和句子级的单一隐变量,不足以建模复杂的语义和回复生成的多样性,可能导致在自回归解码生成的过程中忽略回复生成的全局隐变量。

技术实现思路

1、本发明的目的是为了克服现有技术中的不足,提供一种基于联合隐变量的变分自回归对话生成装置及方法,不仅利用补充的后验信息来提高知识选择的准确性,还通过条件变分自编码器建模知识选择的多样性和回复生成的多样性,同时使用变分自回归解码器在解码的每一步均建模回复隐变量,使得回复更多样和更有信息量。

2、本发明的目的是通过以下技术方案实现的:

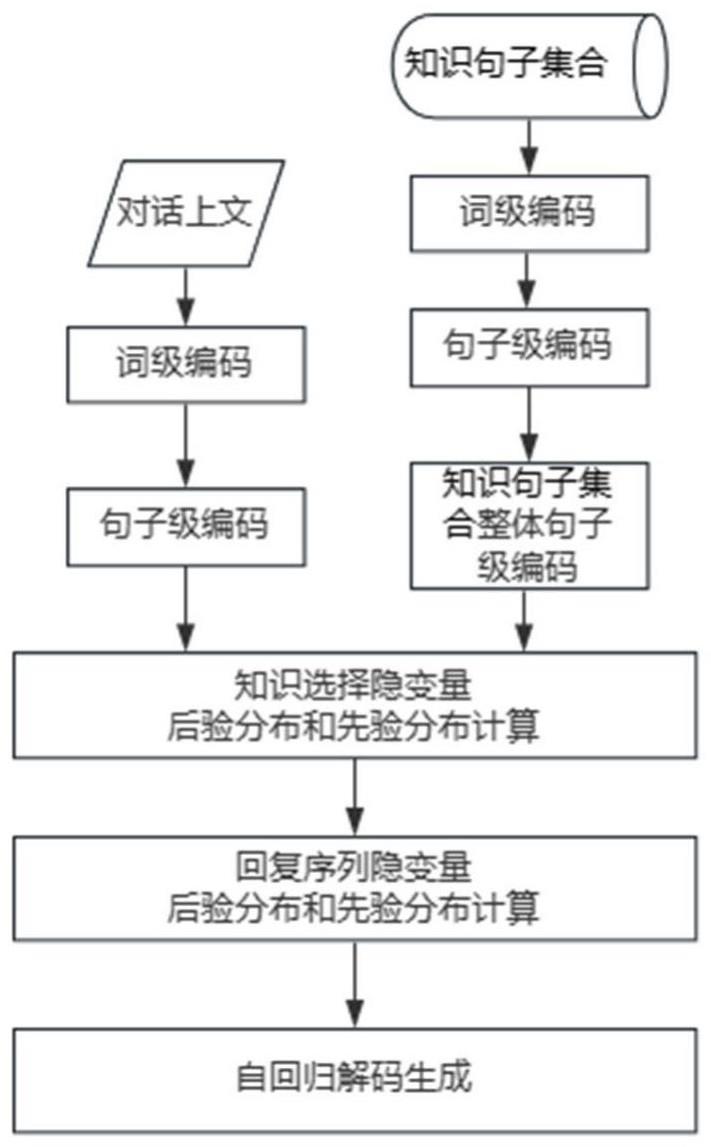

3、一种基于联合隐变量的变分自回归对话生成装置,包括编码器模块、知识选择模块和变分自回归解码器模块;

4、所述编码器模块用于将对话上文和知识句子集合分别编码成向量形式的特征表示,并设置有若干带标签的知识句;基于多层自注意力机制的预训练语言模型构建词级和句子级的编码表示;

5、所述知识选择模块基于对话上文和当前给定的知识句子集合,从知识句子集合中选择与对话上文语义最相关的知识句用于回复生成;具体分别建模知识选择隐变量的后验分布和先验分布,其中知识选择隐变量表示基于对话上文在知识句子集合上服从类别分布的隐变量,后验分布是通过带标签的知识句和对话上文来建模;先验分布使用预测后验信息和对话上文建模,其中预测后验信息是指预测的回复语句信息;在训练阶段使得先验分布和后验分布逼近,实现在测试阶段使用先验分布以选择知识句并送入变分自回归解码器模块;

6、所述变分自回归解码器模块包括变分层和堆叠解码层,变分层用于计算得到回复序列隐变量,在训练阶段,回复序列隐变量的计算包括后验和先验的序列隐变量,并将所选的回复序列隐变量和先验路径的解码隐状态融合传递给解码层,其中所选的回复序列隐变量在训练和测试阶段分别为后验和先验的回复序列隐变量,先验路径的解码隐状态指已生成的回复序列经过变分层得到的隐状态表示;最后通过堆叠解码层生成最终的回复语句。

7、进一步的,包括:

8、s1、基于自注意力机制的预训练语言模型bert编码对话上文和知识句子集合,构建词级和句子级的编码表示;

9、s2、建模知识选择隐变量的后验分布和先验分布;其中后验分布通过带标签的知识句和对话上文建模,先验分布使用预测后验信息和对话上文建模,并从先验分布中采样隐变量以选择知识句送入变分自回归解码器模块;

10、s3、通过变分自回归解码器模块生成回复语句;变分自回归解码器模块包括变分层和堆叠的解码层,变分层计算回复序列隐变量的后验分布和先验分布,并将所选的回复序列隐变量和先验路径的解码隐状态融合传递给解码层,其中所选的回复序列隐变量在训练和测试阶段分别为后验和先验的回复序列隐变量,先验路径的解码隐状态指已生成的回复序列经过变分层得到的隐状态表示;堆叠解码层基于变分层的输出、对话上文和被选知识生成回复语句。

11、进一步的,步骤s1中,给定当前轮对话上文ct和知识句子集合kt,使用bert模型编码获取对应的词级特征表示得到对话上文词级表示向量以及平均池化后的句子级表示向量对于知识句子集合kt中的任意句子kt,l,同样得到词级和句子级表示向量和知识句子集合kt整体的句子级表示记为l为知识句子集合大小,d表示隐状态维度。

12、进一步的,步骤s2包括:

13、s2.1、计算知识选择隐变量的后验分布:将对话上文和被选知识的表示向量拼接,即再与句子级表示做点积注意力计算,经过softmax归一化层获得后验隐变量表示

14、s2.2、计算知识选择隐变量的先验分布;使用预测的回复语句信息来补充知识选择的先验信息,将对话上文和句子级表示进行点积注意力计算,即表示对话上文感知的知识句子集合融合特征表示,attn表示计算注意力的方法;

15、将上述对话上文和知识句子集合融合特征表示拼接,即经过多层感知机预测回复语句在bert词表上的单词概率分布t,单词概率分布t与bert词表整体的嵌入表示e加权求和后再与对话上文特征表示拼接,得到再经过特征变换后获得再与句子级表示做点积注意力计算,经过softmax归一化层获得知识句子集合上的注意力分数并作为先验隐变量

16、s2.3、从知识选择隐变量的先验分布中采样先验隐变量以选择知识句kt,sel:即先从先验隐变量中采样,先验隐变量服从类别分布,再将对应的知识句送入变分自回归解码器模块,~表示服从概率密度函数;知识选择模块内知识选择任务的重构损失为其中kt,a表示标签知识,即

17、进一步的,步骤s3包括:

18、s3.1、通过变分层建模回复序列隐变量的后验分布:训练阶段,将输入的回复生成序列yt的词嵌入表示和位置编码按位相加,作为变分层的初始输入,记作s0;进一步通过变分层获得回复序列隐变量的后验分布参数:均值和方差向量,分别为和再通过重参数化技术采样得到时间步n的后验隐变量时间步n之前的回复序列隐变量记为同时下式简记为表示时间步n采样后验分布的回复序列隐变量

19、

20、其中,ct为当前轮对话上文,kt,sel为知识句,i表示单位矩阵;

21、s3.2、建模回复序列隐变量的先验分布;包括训练和测试阶段,同样通过变分层获得回复序列隐变量的先验分布参数:均值和方差向量,分别为和再通过重参数化技术采样得到时间步n的先验隐变量时间步n之前的回复序列记为yt,<n,同时下式简记为表示时间步n采样先验分布的回复序列隐变量

22、

23、s3.3、变分层中回复序列隐变量与先验路径的解码隐状态融合;将先验路径中的解码隐状态与所选的回复序列隐变量进一步融合,获得表示向量s1,所选的回复序列隐变量在训练和测试阶段分别为后验和先验的回复序列隐变量;再经过层归一化处理,送入解码层的隐状态向量为

24、s3.4、堆叠的解码层基于变分层输出、对话上文和被选知识生成回复语句:堆叠的解码层能够得到解码生成概率、拷贝被选知识概率和拷贝对话上文概率并对上述概率加权求和得到最终生成单词在bert词表上的概率分布;通过argmax函数得到bert词表上最高概率的单词,进一步通过对上述最高概率的单词进行拼接得到最终的回复语句。

25、优选的,堆叠解码层基于transformer解码器层架构,记作trs_decs,获得最后一层的隐状态表示

26、

27、堆叠的解码层使用带拷贝机制的解码层,最终生成单词的概率分布为解码层生成、拷贝被选知识和拷贝对话上文概率分布的三者加权和。已生成的单词序列经过解码器处理后,得到最后位置的隐状态以及在bert词表上的生成概率分布。最后位置的隐状态分别与被选知识的词级向量表示和对话上文的词级向量表示进行对应的计算处理,均获得相应的拷贝单词的概率分布、相关性分数。将相应的相关性分数分别于被选知识的词级向量表示和对话上文的词级向量表示加权求和,得到被选知识和对话上文的注意力表示。将最后位置的隐状态、被选知识和对话上文的注意力表示经过多层感知机获得以上三个概率分布的权重系数。最后,将权重系数与对应概率分布加权求和,得到所生成单词在bert词表上的最终概率分布。

28、本发明还提供一种电子设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述程序时实现所述基于联合隐变量的变分自回归对话生成方法的步骤。

29、本发明还提供一种计算机可读存储介质,其上存储有计算机程序,该计算机程序被处理器执行时实现所述基于联合隐变量的变分自回归对话生成方法的步骤。

30、与现有技术相比,本发明的技术方案所带来的有益效果是:

31、1)本发明使用知识句子集合和对话上文来预测回复语句信息,进而作为计算知识选择隐变量的先验分布的补充信息,通过知识选择隐变量来建模知识选择任务,在训练阶段知识选择隐变量的先验分布逼近后验分布,能够选择与对话上文语义更相关的知识句子,使得测试阶段知识选择任务的准确率更高。

32、2)本发明使用变分自回归解码器建模回复序列隐变量,即在每个解码时间步都建模回复隐变量,因此生成的回复语句更多样和更有信息量,更接近人类回复。

- 还没有人留言评论。精彩留言会获得点赞!