基于多尺度双向卷积的压缩视频感官质量增强方法及系统

本发明涉及视频编解码领域,特别涉及一种基于多尺度双向卷积的压缩视频感官质量增强方法及系统。

背景技术:

1、如今,视频内容已经成为数字网络流量的主要部分,并且仍在增长。为了在有限带宽下传输视频,必须对视频进行压缩,以显著减低比特率。但是,主流的压缩方法如h.264/avc和h.265/hevc,经常在压缩视频中引入各种伪影,特别是在低比特率的情况下,这些伪影的存在极大影响了人们的视觉感官以及一些图像处理任务,如图像识别、目标检测等。因此,有必要对压缩视频进行增强。

2、视频编解码标准中对编解码过程信息丢失的主要处理方法是环路滤波处理。但是传统的环路滤波处理受到计算复杂度的限制,并不能很好的改善最后重建视频的质量。近年来,人们在不改动编解码框架的前提下,对于解压后的低质量视频进行基于深度学习的后处理来提高视频质量。遗憾的是,现有的基于深度学习的增强方法主要是增强压缩视频的客观质量,而忽略了感官质量。实际上,人类视觉系统(hvs)才是压缩视频的最终目的,所以,感官质量的增强比客观质量更重要。因此,如何设计出符合人类视觉系统的压缩视频增强网络具有重要意义和应用价值。

技术实现思路

1、本发明的主要目的在于克服现有技术中的上述缺陷,提出一种基于多尺度双向卷积的压缩视频感官质量增强方法及系统,能够从低质量的解压缩视频中重建出符合人类视觉系统的高质量视频帧。

2、本发明采用如下技术方案:

3、一方面,一种基于多尺度双向卷积的压缩视频感官质量增强方法,包括:

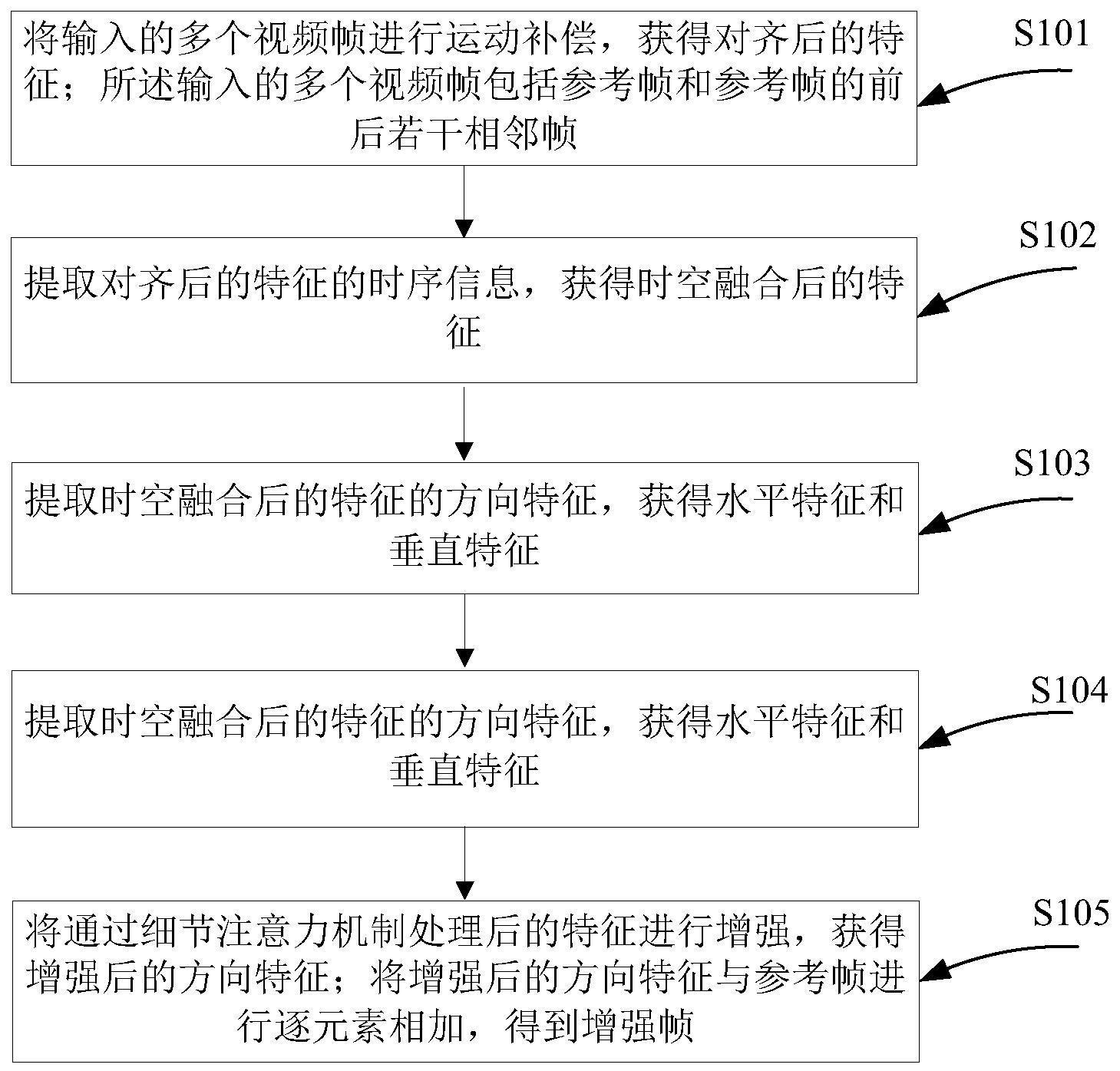

4、将输入的多个视频帧进行运动补偿,获得对齐后的特征;所述输入的多个视频帧包括参考帧和参考帧的前后若干相邻帧;

5、提取对齐后的特征的时序信息,获得时空融合后的特征;

6、提取时空融合后的特征的方向特征,获得水平特征和垂直特征;

7、基于参考帧和相邻帧来指导水平特征和垂直特征的恢复,获得细节注意力机制处理后的特征;

8、将通过细节注意力机制处理后的特征进行增强,获得增强后的方向特征;将增强后的方向特征与参考帧进行逐元素相加,得到增强帧。

9、优选的,将输入的多个视频帧进行运动补偿,获得对齐后的特征,具体包括:

10、输入参考帧vt和参考帧的相邻帧其中,n为自然数,表示前/后相邻帧的数量;

11、通过u-net网络把多个视频帧转换为多个高维特征向量,向量中的每个维度都代表着视频帧的一个特征或属性,所述u-net网络输出运动偏移offset;

12、把输入帧vt和在通道维度进行拼接,并把拼接的信息与运动偏移offset送入可变形卷积网络中;

13、所述可变形卷积网络将运动偏移量offset和多个视频帧进行融合,使得多个视频帧的像素朝着对应的偏移量offset移动,以得到对齐后的多帧信息。

14、优选的,设运动偏移offset为o,融合后对齐的特征为f,运动补偿的过程表示如下:

15、

16、

17、其中,[·,·]表示在通道维度进行拼接,u(·)表示u-net操作,dcn(·)表示可变形卷积操作。

18、优选的,提取对齐后的特征的时序信息,获得时空融合后的特征,具体包括:

19、使用两个3d卷积层提取对齐特征的时空信息;其中,每个卷积层都包含多个卷积核,每个卷积核都在时空维度上滑动,提取多个视频帧的时空信息;在第一个3d卷积层中,每个卷积核将从多个视频帧中提取特征,这些特征在时空维度上进行平均或汇总后,生成一组新的特征;新的特征被送入下一个3d卷积层中,进一步提取时空信息;

20、具体的,时空融合后的特征表示为:

21、f3d=con3d(conv3d(f))

22、其中,f3d表示时空融合后的特征;f表示融合后对齐的特征;conv3(·)表示3d卷积操作。

23、优选的,提取时空融合后的特征的方向特征,获得水平特征和垂直特征,具体包括:

24、以包括时空融合后的特征的视频帧作为输入;

25、通过双向卷积,提取水平方向特征和垂直方向特征;所述双向卷积包括mx1和1xm的卷积;其中,mx1的卷积提取出水平方向特征,1xm的卷积提取出垂直方向特征;将mx1的卷积1xm的卷积堆叠在一起,提取出输入视频帧的水平方向特征和垂直方向特征;

26、把mx1卷积提取的水平方向特征和1xm卷积提取的垂直方向特征在通道维度进行拼接,并把拼接的信息送入多尺度卷积,用不同大小的卷积核来捕获视频帧的几何变化,输出方向特征。

27、优选的,基于参考帧和相邻帧来指导水平特征和垂直特征的恢复,获得细节注意力机制处理后的特征,具体包括:

28、通过细节注意力机制,把参考帧、相邻帧、水平方向特征和垂直方向特征在通道维度进行拼接;

29、把拼接的信息在通道维度上分别取最大值和求和;

30、把取最大值之后的特征图和求和后的特征图在通道维度进行拼接,并通过1x1的卷积进行特征融合;

31、把融合的特征图通过sigmoid激活函数输出,最后把输出结果与方向特征进行逐元素相加,获得通过细节注意力机制处理后的特征。

32、优选的,所述水平特征、垂直特征、通过多尺度卷积融合后的方向特征为及通过细节注意力机制处理后的特征分别表示如下:

33、fh=ch(f3d)

34、fv=cv(f3d)

35、ff=m([fh,fv])

36、

37、在公式中,f3d表示时空融合后的特征;fh表示水平特征;fv表示水平特征;fv表示通过多尺度卷积融合后的方向特征;fa表示通过细节注意力机制处理后的特征;ch(·)表示1xm的卷积操作,cv(·)表示mx1的卷积操作,m(·)表示多尺度卷积操作,dfa(·)表示细节注意力机制操作;vt表示参考帧;表示参考帧的相邻帧。

38、优选的,将通过细节注意力机制处理后的特征进行增强,获得增强后的方向特征;将增强后的方向特征与参考帧进行逐元素相加,得到增强帧,具体包括:

39、将通过细节注意力机制处理后的特征送入包括多个密集残差块的网络,输出增强后的方向特征;

40、把增强后的方向特征与参考帧进行逐元素相加,得到增强帧;

41、所述增强帧表示如下:

42、fe=res(fa)+vt

43、其中,fe表示增强帧;fa表示通过细节注意力机制处理后的特征;vt表示参考帧;res(·)表示稠密残差卷积操作。

44、另一方面,一种基于多尺度双向卷积的压缩视频感官质量增强系统,基于生成式对抗网络,包括生成器和判别器;所述生成器包括运动补偿网络、时空融合网络、多尺度双向网络和稠密残差重建网络;

45、所述运动补偿网络,用于将输入的多个视频帧进行运动补偿,获得对齐后的特征;所述输入的多个视频帧包括参考帧和参考帧的前后若干相邻帧;

46、所述时空融合网络,用于提取对齐后的特征的时序信息,获得时空融合后的特征;

47、所述多尺度双向网络,用于提取时空融合后的特征的方向特征,获得水平特征和垂直特征;还用于基于参考帧和相邻帧来指导水平特征和垂直特征的恢复,获得细节注意力机制处理后的特征;

48、所述稠密残差重建网络,用于将通过细节注意力机制处理后的特征进行增强,获得增强后的方向特征;将增强后的方向特征与参考帧进行逐元素相加,得到增强帧。

49、与现有技术相比,本发明的有益效果如下:

50、(1)本发明能够提高重建视频帧的感官质量,相比传统的压缩视频客观质量增强方法,该网络恢复的重建帧更符合人类视觉系统,可以明显改善压缩带来的质量下降问题;

51、(2)本发明的运动补偿过程包括u-net网络和可变形卷积网络,能够使视频帧之间的运动更加平滑,并降低压缩视频噪声和伪影的影响,从而提高视频质量;

52、(3)本发明的两个3d卷积能够很好的捕获视频帧与帧之间的时序信息;

53、(4)本发明的利用双向卷积可以有效地提取视频帧的水平和垂直特征,并且利用多个不同长、宽的卷积核可以控制双向卷积的纹理特征,从而获得更精细的纹理信息;与双向卷积相结合的多尺度卷积,能够用不同大小的卷积核捕获出视频帧的几何变化。具体来说,使用较小的卷积核能够帮忙捕获一些局部的几何变化,例如物体的细微移动或形态变化,而使用较大的卷积核能够帮助捕获更广泛的几何变化,例如物体的整体移动或缩放,通过组合不同大小的卷积核,能够更全面地捕获视频中的几何变化,从而更好地理解视频中的运动和变化;

54、(5)本发明将细节注意力机制处理后的特征送入包括多个密集残差块的网络,能够输出增强后的方向特征,把增强后的方向特征与参考帧进行逐元素相加,重建高质量视频帧;具体来说,密集残差是指在重建视频帧时,将每个像素的重建误差都作为残差输入到下一层网络中,这样可以更好地保留图像的细节和纹理信息;相比不使用密集残差的方法,密集残差可以更好地重建出高质量的视频帧,从而提高视频的视觉效果和观感质量。

- 还没有人留言评论。精彩留言会获得点赞!