一种基于多阶段对齐网络的图像拼接方法

本发明涉及图像处理以及深度学习领域,尤其涉及一种基于多阶段对齐网络的图像拼接方法。

背景技术:

1、作为获得高分辨率宽视场全景图像的关键技术,图像拼接旨在通过旋转相机获得具有重叠区域的多幅图像,并通过特征匹配和图像融合拼接图像。但是,当图像采集设备旋转角度较大或拍摄场景不共面时,可能会导致拼接图像出现视觉伪影和错位。因此,如何确保宽视场全景图像准确对齐和自然平滑是图像拼接中的挑战性问题。

2、近年来,研究人员提出了大量的图像拼接方法。传统图像拼接方法分为全局对齐方法和空间变化变形方法。全局对齐方法利用不变的局部特征匹配图像,并通过单应性矩阵建立映射关系对齐图像,例如:双-单应性估计方法、平滑变化仿射方法等。空间变化变形方法是将图像划分为均匀网格,并通过优化基于内容的网格变形函数获得最佳网格坐标,包括尽可能投影方法、尽可能自然的自适应方法等。近年来,研究人员提出了基于深度学习的图像拼接方法以提高拼接性能。例如,nie等人提出了一种基于全局单应性的图像拼接网络,并通过构建结构拼接阶段和内容修改阶段消除图像伪影。考虑到边缘保留的重要性,dai等人提出了一种基于边缘引导融合方法用于图像拼接。jong等人设计了一种深度图像矩形化解决方案,用于保持图像的线性和非线性结构。然而,这些图像拼接方法的性能仍需要进一步改进。

3、发明人在实现本发明的过程中,发现现有技术中至少存在以下缺点和不足:

4、现有技术中的方法通常通过估计单个深度映射变换来对齐图像,不能有效地处理大视差场景,可能扭曲全景图像的全局结构;现有方法忽略了图像拼接过程中的图像内容和拼接接缝的重要性,容易导致图像内容不一致和拼接接缝不连续问题。

技术实现思路

1、本发明设计了一种基于多阶段对齐网络的图像拼接方法。本发明利用基于内容保持的深度单应性估计模块预对齐输入图像对并减少内容伪影,采用基于边缘辅助的网格变形模块进一步对齐图像对并避免接缝失真,构建内容一致性损失和接缝平滑度损失保持图像对的几何结构并减少重叠区域的接缝不连续,进而预测高质量的图像拼接结果。该图像拼接方法实现了对图像的高质量拼接,避免内容伪影的同时减少了接缝失真。

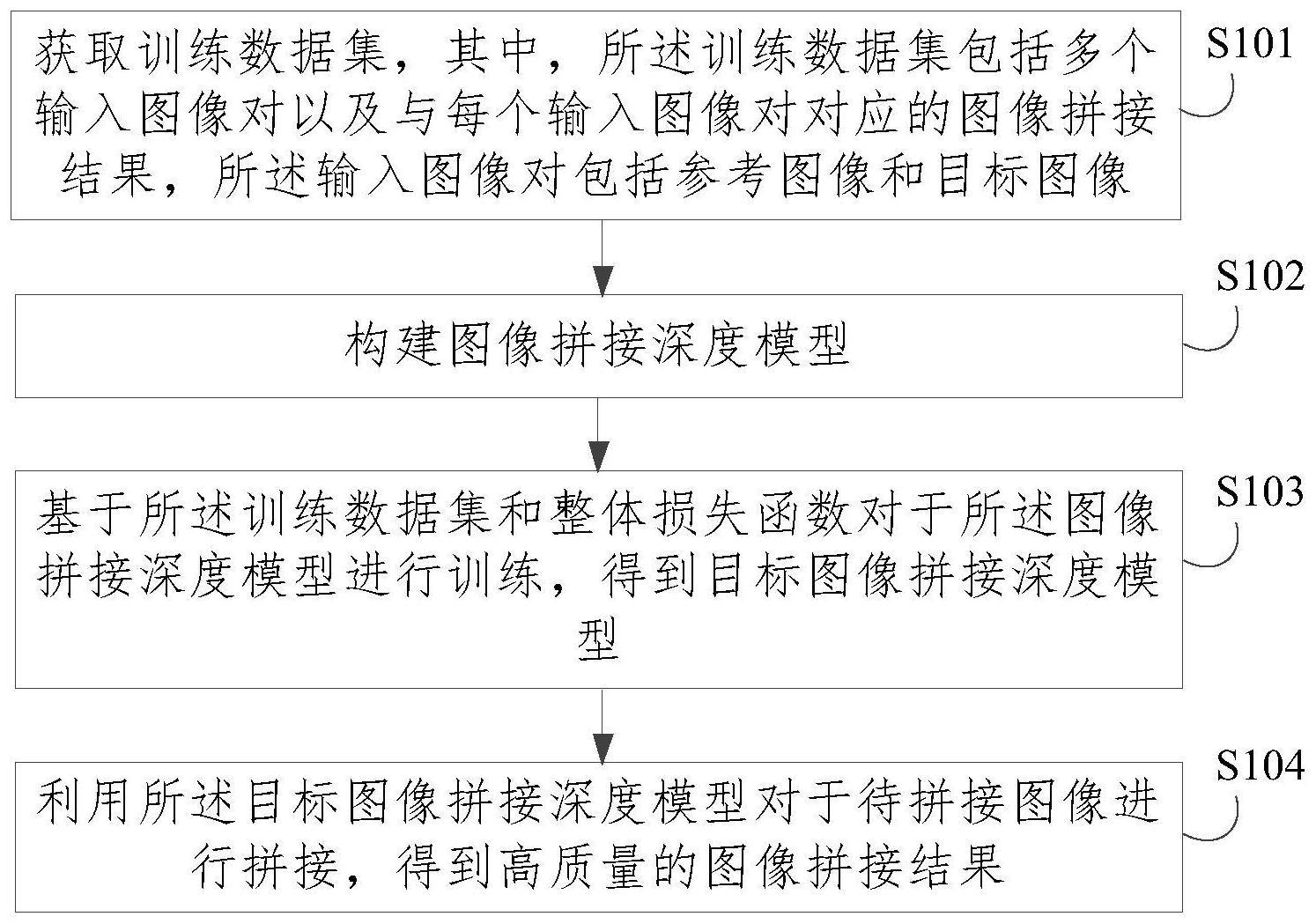

2、本发明提出的一种基于多阶段对齐网络的图像拼接方法包括以下步骤:

3、步骤s1,获取训练数据集,其中,所述训练数据集包括多个输入图像对以及与每个输入图像对对应的图像拼接结果,所述输入图像对包括参考图像i1和目标图像i2;

4、步骤s2,构建图像拼接深度模型;

5、步骤s3,基于所述训练数据集和整体损失函数对于所述图像拼接深度模型进行训练,得到目标图像拼接深度模型;

6、步骤s4,利用所述目标图像拼接深度模型对于待拼接图像进行拼接,得到图像拼接结果。

7、可选地,所述图像拼接深度模型包括图像预对齐子模型和图像对齐子模型,其中,所述图像预对齐子模型用于利用基于内容保持的深度单应性估计模块,对于所述输入图像对进行预对齐,所述图像对齐子模型用于利用边缘辅助网络,对于所述预对齐输入图像对进行进一步对齐。

8、可选地,所述深度单应性估计模块由多个对称卷积层单元和相应数量的内容保持注意力模块交错连接而成,其中,所述对称卷积层单元包括两个卷积层和一个最大池化层;所述内容保持注意力模块包括空间注意力模块和多个交叉运算模块,所述空间注意力模块包括两个最大池化层,两个平均池化层,一个共享全连接层和一个激活函数层。

9、可选地,所述边缘辅助网络包括卷积层、三个多尺度残差块、上采样层和瓶颈层。

10、可选地,在利用所述图像预对齐子模型对于输入图像对进行预对齐时:

11、将所述输入图像对输入至所述深度单应性估计模块中,得到与所述输入图像对中的参考图像i1和目标图像i2对应的输出特征图fir和fit;

12、基于所述输出特征图fir和fit,利用直接线性变换方法获取单应性矩阵;

13、利用空间变形网络分别将参考图像i1和目标图像i2进行变形,实现参考图像i1和目标图像i2重叠区域的像素位置的预对齐,其中,预对齐的输入图像对表示为:

14、

15、

16、其中,e表示单位矩阵,h表示单应性矩阵,wstn(·,·)表示空间变形网络的输出。

17、可选地,在利用所述图像对齐子模型对于预对齐输入图像对进行对齐时:

18、利用所述边缘辅助网络中的卷积层获得预对齐参考图像和目标图像的基础特征图;

19、利用所述边缘辅助网络提取得到所述预对齐参考图像和目标图像的边缘特征图;

20、将得到的所述预对齐参考图像和目标图像的边缘特征图与相应的基础特征图分别进行级联,得到所述预对齐参考图像和目标图像的融合特征图;

21、基于所述预对齐参考图像和目标图像的融合特征图,利用上下文相关方法计算得到所述预对齐参考图像和目标图像的特征流;

22、将所述预对齐参考图像和目标图像及其对应的特征流送入深度网格变形网络,得到对齐的参考图像和目标图像其中,对齐的参考图像和目标图像表示为:

23、

24、

25、其中

26、

27、其中,f1conv和f2conv分别表示预对齐图像对的基础特征图,f1edge和f2edge分别表示预对齐图像对的边缘特征图,f1c和f2c分别表示预对齐图像对的融合特征图,[·,·]表示级联操作,ccl(·,·)表示上下文相关方法,wmesh(·,·)表示深度网格变形网络,表示预对齐的参考图像,表示预对齐的目标图像。

28、可选地,所述整体损失函数包括内容一致性损失和接缝平滑度损失,所述整体损失函数lall表示为:

29、lall=αlcont+βlseam

30、其中,lcont表示内容一致性损失,lseam表示接缝平滑度损失,α和β分别是内容一致性损失和接缝平滑度损失的权重。

31、可选地,所述内容一致性损失由光度损失项和结构损失项组成。

32、可选地,所述光度损失项lphoto表示为:

33、lphoto=||if-ig||1

34、其中,if和ig分别表示最终图像拼接结果和真实值,||·||1表示l1范数;

35、所述结构损失项lstruc表示为:

36、

37、其中,表示vgg-16网络中conv1i的函数,||·||2表示l2范数。

38、可选地,所述接缝平滑度损失lseam表示为:

39、lseam=||e1-e1g||1+||e2-e2g||1

40、其中

41、

42、其中,e1和e2是对齐图像对的边缘图像,e1g和e2g是利用曲率公式获得的对齐图像对的边缘图像的真实值,enet(·)表示边缘辅助网络的输出,表示对齐的参考图像,表示对齐的目标图像,m和n表示水平方向和垂直方向,和div(·)分别表示梯度运算和散度运算。

43、本发明提供的技术方案的有益效果是:

44、1.本发明可以准确对齐图像,减少图像内容失真的同时保持接缝平滑,获得高质量的图像拼接结果。

45、2.本发明利用深度学习技术解决图像拼接问题,通过多阶段对齐方式减少图像对齐伪影,并利用边缘信息辅助和接缝平滑度损失减少接缝不连续。

- 还没有人留言评论。精彩留言会获得点赞!