一种基于参数化互近邻的车辆限高场景识别方法与流程

本发明属于无人驾驶系统的图像感知识别领域,尤其是涉及一种基于参数化互近邻的车辆限高场景识别方法。

背景技术:

1、近年来,随着深度学习技术的不断进步,人工智能迎来了一个全新的高速发展时期。得益于各种涌现的先进技术,人工智能中的计算机视觉、自然语言处理等领域都在各自的方向上取得了极具突破性的进展。在现在的人类社会中,已经可以随处看见人工智能技术的应用场景。应用在无人驾驶系统中的目标检测、路径规划等卓越的技术,为无人驾驶车辆的安全运行提供了保障。

2、无人驾驶的感知系统是通过提取输入系统的实时图像的特征来判断车辆周围的环境信息,比如识别障碍物。在这一过程中,深度学习领域的神经网络系统技术发挥了很大的作用。深度神经网络系统是通过复杂的模型架构和很多轮次的训练来拟合训练数据,从而使得系统模型学习并记住了这些数据的特征,在后续的实际应用中表现出很好的效果。虽然当前一些先进的深度神经网络系统在图像分类、目标检测等视觉领域中取得了突出的成就,但是训练出一个优秀的系统模型在很大程度上需要一个包含了丰富种类、样本数量充足的大规模有标签数据集,这一点在真实场景中很难被满足。

3、大型车辆在行驶过程中偶尔会遇到一些限高的行驶场景,比如限高杆、桥洞、隧道等。在这些场景中,驾驶员需要时刻注意并且判断自己驾驶的车辆能否安全通过。由于车速过快和驾驶员的反应不足等原因,车辆需要借助无人驾驶系统来实时分析车辆是否处于限高场景中。但是相比于车辆识别、车道线识别等无人驾驶场景,限高场景的识别面临了限高图像样本较少的困境。一方面,在城市道路中,限高杆和限高桥洞比较少,因此能够获取的此类限高场景图像样本的难度较大,系统无法从极少量的限高场景图像中学习到足够的网络模型参数。另一方面,一些乡镇道路上虽然设置了限高杆,但是却没有设置具体的限高标识。这两方面的因素给传统的借助视觉图像的无人驾驶系统带来了困扰。

4、目前主流的目标检测工作主要分为双阶段目标检测和单阶段目标检测。双阶段目标检测的主要步骤是先利用网络模型计算出待检测物体在图像上的大致位置,随后在此基础上利用另外一个网络得到更为精确的物体位置、大小和类别。例如,ross girshick等人在2014年国际计算机视觉与模式识别会议(the conference on computer vision andpattern recognition)收录的文章《rich feature hierarchies for accurate objectdetection and semantic segmentation》提出的r-cnn的网络模型首先在待检测图像上利用第一阶段的网络筛选出数个区域,随后利用二阶段的网络对这几个区域进行单独的计算和分类,并在此过程中逐渐优化各个区域的边界,使得边界值逐渐趋近真实的物体在图像上的位置,最终得到得到图像上物体的具体类别和位置。

5、双阶段目标检测由于需要对图想进行两次的计算,耗费了大量的计算资源,因此,近年来目标检测领域的优秀成果主要集中在单阶段目标检测领域。单阶段目标检测就是只需要一次的计算便可以直接得到图片上物体的精确位置和物体的类别,不再需要选取待定区域。例如,wei liu等人在2016年欧洲计算机视觉国际会议(european conference oncomputer vision)收录的文章《ssd:single shot multibox detector》提出的单阶段目标检测网络模型ssd首先利用神经网络对图像进行特征提取,随后抽取特征提取过程的中间结果特征图,并对中间结果特征图上的每个特征点计算该点所代表的原图范围内是否含有物体、物体的种类。chien-yao wang等人在2023年国际计算机视觉与模式识别会议(theconference on computer vision and pattern recognition)收录的文章《yolov7:trainable bag-of-freebies sets new state-of-the-art for real-time objectdetectors》提出的yolov7利用了金字塔网络结构和叠加的上下采样实现了多尺度的特征提取,并且引入了模型结构重参化和动态标签分配增强了网络的学习能力。与其它单阶段目标检测工作类似,yolov7这样的一次流程便完成了双阶段目标检测工作的全部任务,是当前目标检测领域内较为先进的工作。

6、虽然以上先进工作在目标检测领域取得了很好的成果,但是当这些工作具体落实到限高场景识别任务中时,它们的效果并不好。一方面是因为这些工作需要大量的图像样本来进行优化,但是现实中限高场景的图像数据样本较少。另一方面则是在限高场景识别中,系统只需要判断无人驾驶车辆是否进入限高环境,这些工作在关注待检测物体类别的同时还关注了物体的位置,会进行大量无意义的计算。

技术实现思路

1、本发明提供了一种基于参数化互近邻的车辆限高场景识别方法,只需要很少的计算资源就可以对现实中数据量较少的限高场景进行识别。

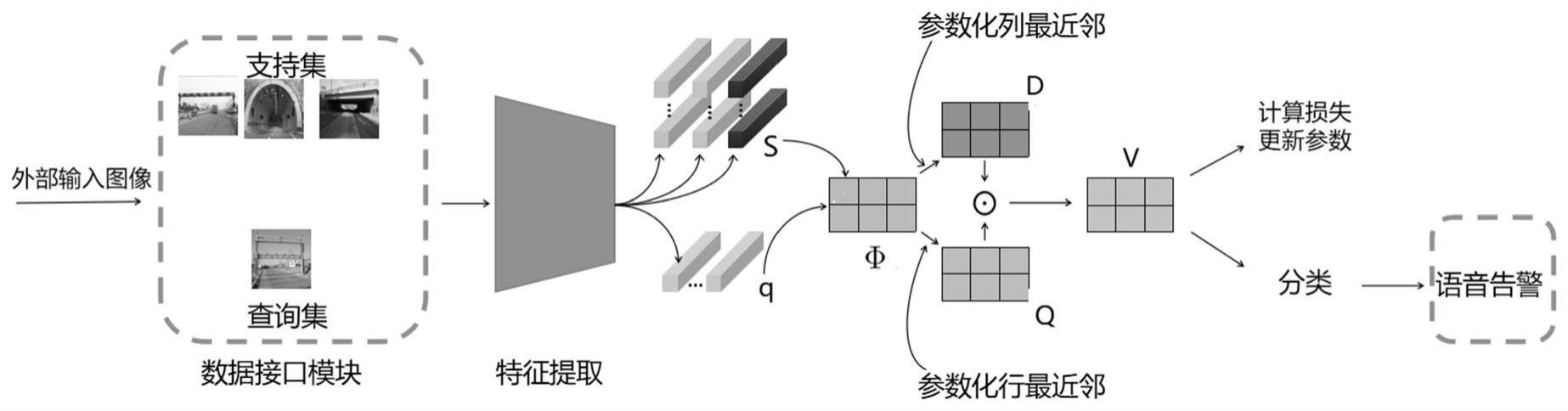

2、一种基于参数化互近邻的车辆限高场景识别方法,包括:

3、(1)准备训练用的图像数据集,将数据集随机采样为若干个任务子集;每个任务子集中包含n个类别的限高场景,每个场景k张图片,将n×k张图片组成支持集,并抽取其中一张作为查询图像;

4、(2)构建限高识别模型,所述的限高识别模型包含特征提取模块、空间余弦相似度计算模块和互近邻计算模块;

5、其中,所述的特征提取模块用于提取图像像素特征,把每个任务子集中的支持集图像和查询图像输入到特征提取模块进行特征提取计算,得到局部特征矩阵;

6、所述的空间余弦相似度计算模块用于计算查询图像的局部特征和支持集图像的局部特征之间的余弦相似度矩阵;

7、所述的互近邻计算模块用于根据查询图像和支持集各个类别之间余弦相似度计算互近邻概率矩阵;

8、(3)使用损失函数对限高识别模型进行训练;

9、(4)训练完毕后,输入待查询的图像,计算其与支持集各个类别的互近邻相似度得分,并根据得分高低判定该查询图像的具体类别;如果当前车辆所处环境被判定为限高场景,则播报语音告警信息。

10、步骤(2)中,特征提取模块的工作过程如下:

11、将查询图像输入特征提取模块,得到特征矩阵θ∈rc×h×w,将θ转化为查询图像的局部特征集合q={q1,...,qm};其中,m=h×w表示一张图像的局部特征块的数量,qi表示查询图像的第i个局部特征向量,c、h、w分别为特征矩阵θ的通道数、高度、宽度;

12、将支持集图像输入特征提取模块,将所有来自同一类别c的共k张支持图像的局部特征矩阵取平均,得到类别c的平均局部特征矩阵进一步将其转化为类别c的局部特征集合其中,θc,k为第c类第k张限高场景图像的特征矩阵,表示类别c的第i个局部特征向量。

13、空间余弦相似度计算模块的工作过程如下:

14、首先构建支持集中所有类的局部特征集合s:

15、

16、其中,sc是类别c的局部特征集合,对于每一个查询图像的局部特征向量qi∈q和每一个支持集的局部特征向量sj∈s;计算它们的空间余弦相似度矩阵φ∈rm×nm,公式如下:

17、

18、互近邻计算模块的工作过程如下:

19、(i)对于查询图像的任一局部特征向量qi∈q,找到它在集合s中的最近局部特征向量sj:

20、sj=nns(qi)

21、其中,nns(q)表示在集合s中关于局部特征向量qi的最近邻函数;采用参数化的方法寻找最近邻向量,具体操作为:

22、在步骤(3)得到的空间余弦相似度矩阵φ中,计算每个qi∈q,它的最近邻为sj∈s的概率,公式为:

23、

24、式中,γ表示表示控制概率分布尖锐程度的温度参数。

25、(ii)对于一个支持集的局部特征向量sj∈s,找到它在集合q中的最近局部特征向量qi:

26、qi=nnq(sj)

27、其中,nnq(sj)表示在集合q中关于局部特征向量sj的最近邻函数;具体操作为:

28、在步骤(3)得到的空间余弦相似度矩阵φ中,计算每个sj∈s,它的最近邻为qi∈q的概率,公式为:

29、

30、式中,β表示表示控制概率分布尖锐程度的温度参数。

31、(iii)如果qi×nnq(sj)、sj=nns(qi)同时满足,则qi与sj为互近邻对。

32、具体操作为:

33、将步骤(i)和(ii)中得到的概率矩阵q与d点乘得到互近邻概率矩阵v,公式如下:

34、v=q*d

35、vij作为两个局部特征qi和sj之间为互近邻对的概率,对应的值越接近1,它们之间互为互近邻对的可能性越高。

36、步骤(3)中,损失函数为:

37、

38、式中,α=0.5,是一个提前定义好的间隔超参数,若正样本和负样本在对比损失中的距离大于这个间隔则忽略这个小样本任务,认为模型已经具备足够区分正负样本的能力。max(a,b)函数是选出逗号前后a,b两个表达式中的较大者,这里是为了让最终的损失函数l大于0。

39、与现有技术相比,本发明具有以下有益效果:

40、1、本发明提供了一种非常直观简便的方法对现实中数据量较少的限高场景进行识别,实现时只需要少量的计算资源,易于使用。

41、2、本发明提出的车辆限高场景识别方法中,模型易于训练,将局部特征的比较引入了图像特征对比,专注于对图像样本识别是否为限高场景,摒弃了传统目标检测的位置计算。

- 还没有人留言评论。精彩留言会获得点赞!