一种基于跨模态边缘引导的RGB-D显著性目标检测方法

:本发明涉及计算机视觉和图像处理领域,尤其涉及一种基于跨模态边缘引导的rgb-d显著性目标检测方法。

背景技术

0、

背景技术:

1、rgb-d显著性目标检测是一种利用rgb图像和深度图像(即depth表示深度)进行目标检测的技术。相比于仅使用rgb图像,rgb-d显著性目标检测可以通过深度信息获取更加准确的场景信息。

2、尽管当前涌现很多方法在rgb-d sod领域已经取得了一定的进展,但就目前来说,有两个主要的挑战阻碍rgb-d sod的发展:(1)跨模态信息的融合。rgb图像和depth图像分别基于光学成像和结构光等原理进行成像,因此具有不同的成像原理和噪声特征,这种不同可能导致跨模态信息的融合存在一定误差,并且直接使用某些传统的多模态融合算法会导致特征信息的损失或关键信息的遗漏。因此需要探索更有效的融合算法,并充分利用它们之间的联系和互补性。(2)显著目标边缘的分割。在rgb-d sod中,边缘质量的关注是因为边缘通常是图像中不同物体或背景之间的界限,因此对于目标的准确定位和分割至关重要。而边缘质量的好坏会直接影响到显著性目标的检测的准确度。一些现有的算法会通过边缘信息来判断图像中的显著性目标并将其从背景中区分出来。因此,在进行显著性目标检测的时候,需要考虑提取边缘的质量,以保证能够更精准地定位和分割显著性目标。

3、因此,亟需设计一种基于跨模态边缘引导的rgb-d显著性目标检测方法,实现更好地融合跨模态特征并保留边缘细节,以解决上述问题。

技术实现思路

0、

技术实现要素:

:

1、本发明所需要解决的技术问题是提供一种基于跨模态边缘引导的rgb-d显著性目标检测方法,更好地融合跨模态特征并保留边缘细节。

2、本发明具体采用的技术方案如下:

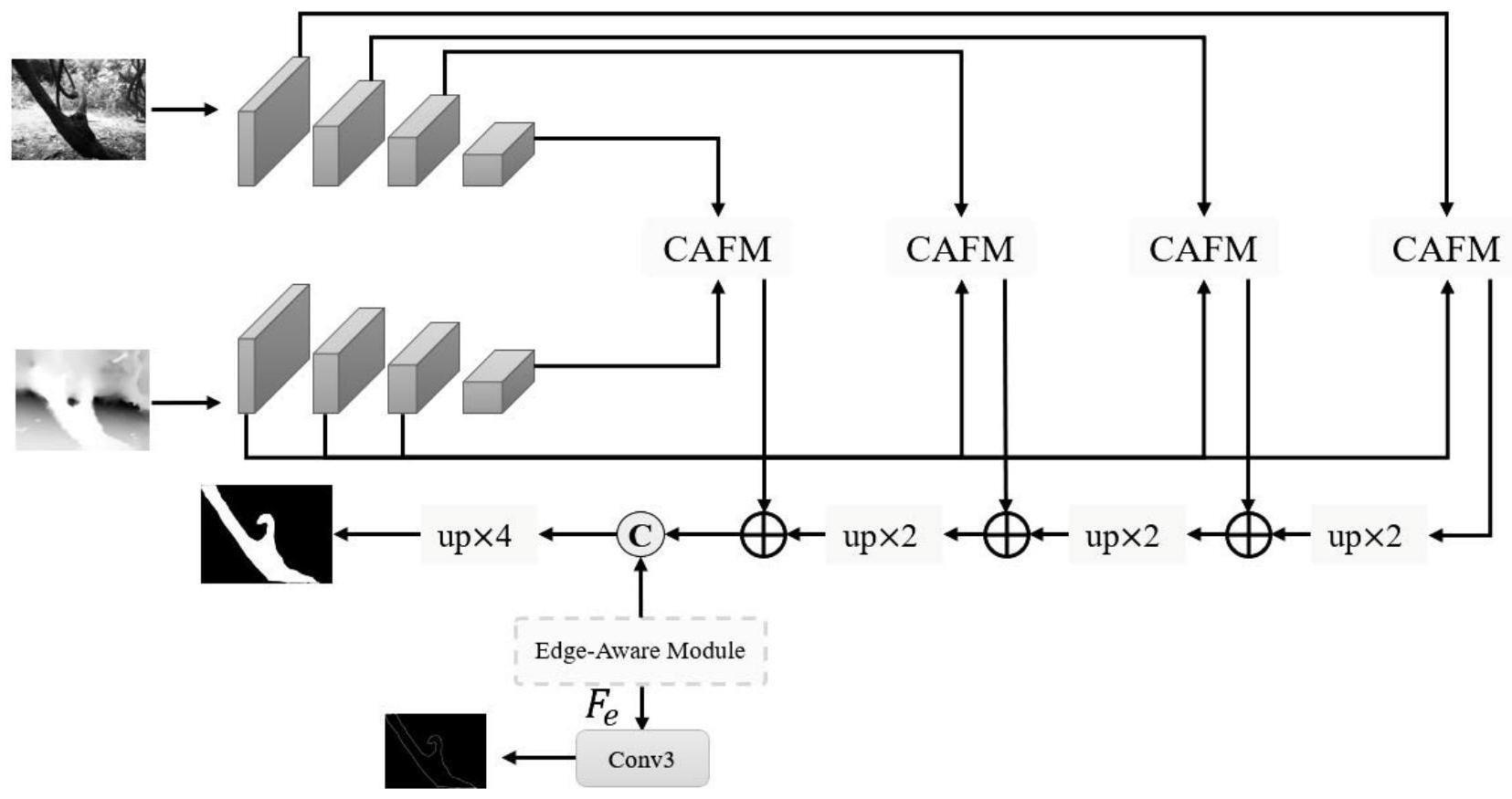

3、一种基于跨模态边缘引导的rgb-d显著性目标检测方法,该方法包括以下步骤:

4、1.获取训练和测试该任务的rgb-d数据集;

5、2.分别建立用于提取rgb图像特征和depth图像特征的显著性目标检测模型网络;

6、3.建立用于跨模态注意力融合的网络结构;

7、4.建立用于边缘感知的网络结构;

8、5.构建用于边缘指导融合解码器,从高到低解码多尺度融合特征并和边缘特征拼接融合,获取显著图。

9、进一步地,在所述步骤1中,将nju2k数据集、nlpr数据集作为训练集,将剩余部分的nju2k数据集、剩余的nlpr数据集、rgbd135数据集、ssd数据集和stere数据集作为测试集。

10、进一步的,所述步骤2包括以下子步骤:

11、2.1)利用swin transformer作为本发明的模型的主干网络,用于提取rgb图像特征和对应的depth图像特征,分别表示为和其中i表示层数,对应于swin transformer的每层输出。

12、2.2)采用预训练的参数权重初始化本发明用于构建主干网络的swintransformer权重。

13、进一步的,所述步骤3用于跨模态注意力融合的网络结构如下:

14、3.1)通过使用通道注意力筛选出最具表达性和相关性的特征通道,减少了过程中非相关信息的干扰,分别对和的通道特征进行通道注意力处理,得到rgb通道注意力向量和深度通道注意力向量

15、

16、

17、其中,和分别表示第i级rgb特征全连接层的参数和偏置,和分别表示第i级深度特征全连接层的参数和偏置,avg(·)表示全局平均池化操作,σ(·)表示softmax激活函数,+表示元素感知的矩阵加操作。

18、3.2)通过加法运算聚合步骤3.1)获得的和得到rgb-d图像在通道维度上更具区分度和代表性的特征表征,然后,将聚合注意向量进行归一化操作,从而得到跨模态通道注意力向量为了强化重要的特征通道并减少对预测结果没有贡献的通道,基于作为rgb特征和深度特征的权重分别与和进行通道相乘,得到rgb加权增强特征和深度加权增强特征

19、

20、

21、

22、其中,表示逐元素相乘操作,n(·)用于将结果归一化到0到1之间。

23、3.3)进一步对步骤3.2)获得的和的空间特征进行空间注意力处理,得到rgb空间注意力向量和深度空间注意力向量然后对和再次执行乘法操作,其目的是保留原始特征图的信息,避免注意力机制过度强调局部特征,随后,将处理过的特征串接在一起,以获得rgb空间加权特征和深度空间加权特征

24、

25、

26、其中,max(·)表示全局最大池化操作,c表示级联操作。

27、3.4)对于步骤3.1)获得的和通过乘法操作生成rgb通道加权特征和深度通道加权特征

28、

29、

30、3.5)对于步骤3.4)获得的和与步骤3.3获得的和分别进行逐元素相加操作,得到rgb通道空间增强特征和深度通道空间增强特征

31、

32、

33、3.6)对步骤3.5)获得的和应用了基于元素的乘法和元素加法,然后将结果级联在一起,再将其输入一个3×3卷积层,以获得其平滑表示,最终得到跨注意力融合特征

34、

35、其中,bconv(·)是一种序列操作,它结合了3×3卷积后的批归一化和relu函数。

36、进一步的,所述步骤4中用于边缘感知的网络结构具体构成如下:

37、4.1)对于从步骤2提取的特征,将和分别通过加法得到rgb边缘特征和深度边缘特征

38、

39、

40、其中up2(·)表示2×upsampling操作。

41、4.2)对步骤4.1)得到的和分别进行通道注意和空间注意力,然后将得到的结果进行残差连接生成更清晰的边缘信息和

42、

43、

44、其中,sa表示空间注意力操作,se是一种通道类型的注意力机制。

45、4.3)将步骤4.2)得到的和进行聚合,生成边缘感知特征fe:

46、

47、更近一步的,所述步骤5包括以下子步骤:

48、5.1)使用对于步骤3获得的为输入,通过逐元素相加获得多尺度特征融合结果

49、

50、5.2)将步骤4.3)获得的边缘特征fe与步骤5.1)获得的多尺度融合特征相结合,生成边缘引导的显着图s:

51、

52、其中,sig(·)表示sigmoid激活函数。

53、与之前的rgb-d显著性目标检测方法相比,本发明有益效果体现在:

54、首先,利用深度学习技术,通过编码器和解码器结构构建rgb-d图像对和图像显著目标之间的关系,并通过跨模态特征的提取和融合,得到显著性预测。其次,通过边缘感知更好地保留边缘细节信息。最后,通过构建边缘引导的解码器进行多尺度的多模态特征融合,预测最终的显著图。

- 还没有人留言评论。精彩留言会获得点赞!