基于时空解耦与自注意力差分LSTM的视频预测方法、系统

本发明属于电子通讯与信息工程领域,具体涉及基于时空解耦与自注意力差分lstm的视频预测方法、系统。

背景技术:

1、视频数据的高维特性和各种时序运动演化的复杂性,给视频预测工作带来了极大的挑战,现有的预测方法存在空间上的细节丢失和时序上的运动预测不一致的问题,且生成的结果过于平滑,未能充分地保留高频细节信息,因此预测准确率低、预测图像外观模糊以及预测图像不真实等。

2、当前视频预测的主流方法有基于卷积神经网络、基于循环神经网络和基于生成对抗式神经网络。卷积神经网络具有强大的表征学习能力,但是感受野有限,无法构建远距离的空间依赖关系,且对时间维度信息的刻画能力有限,而循环神经网络是为了处理具有时间维度的数据而专门设计,对于数据内部空间特征刻画不充分,因此,近几年,考虑到对空间结构信息和时间维度信息的学习,大量学者将卷积神经网络和循环神经网络结合应用在时空序列预测任务中。作为近年来的研究热点,使用生成式神经网络的对抗损失函数已经被证明比使用 l2损失函数能得到更准确的视频预测结果,但是模式崩塌问题是生成式神经网络的一大弱点,在训练过程中会收敛到单一的模式状态。另外,由于视频序列作为高维时空序列数据往往具有复杂的时空耦合性,该特性在某种程度上增大了预测学习的难度。

技术实现思路

1、本发明所要解决的技术问题是:提出了基于时空解耦与自注意力差分lstm的视频预测方法、系统,基于卷积自编码器结构,引入时空解耦网络、动态差分模型和全局自注意力模型,构建用于视频帧预测的网络模型,降低高维视频数据给预测工作带来的复杂程度,提高网络短期依赖和长期关联的特征表达。

2、本发明为解决上述技术问题采用以下技术方案:

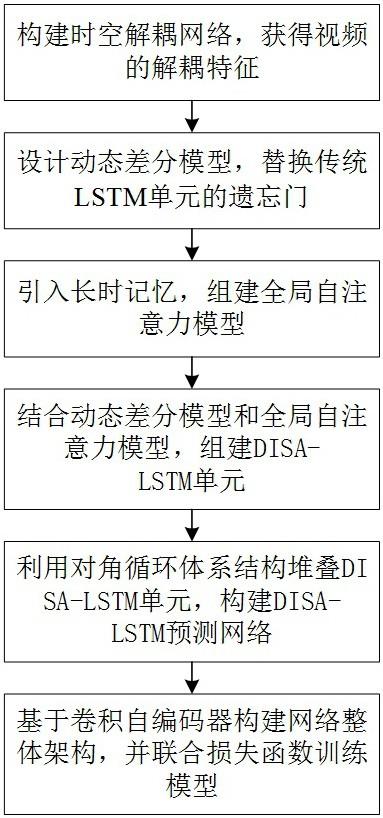

3、本发明提出的基于时空解耦与自注意力差分lstm的视频预测方法,包括以下步骤:

4、s1、构建时空解耦网络,解耦视频的时间动态特征和空间静态特征,以降低高维视频数据给预测工作带来的复杂程度。

5、s2、利用差分运算,设计包含遗忘门、输入门、更新门和输出门的动态差分模型,取代lstm单元的遗忘门,从而提高网络捕获高维动态复杂特征的能力。

6、s3、为了提高网络拟合全局时空相关性的能力,在注意力基础上设计一个门控机制,将长时记忆与被注意的特征深度融合,组建新的全局自注意力模型。

7、s4、将动态差分模型和全局自注意力模型嵌入lstm单元,组成新的disa-lstm单元,并使用对角循环体系结构堆叠该单元构建disa-lstm预测网络。

8、s5、基于卷积自编码器构建网络整体架构,并联合对抗性损失函数、相似性损失函数、重构损失函数和预测损失训练视频预测模型。

9、进一步的,步骤s1中,时空解耦网络由动态编码器和静态编码器组成,解耦视频的时间动态特征和空间静态特征的具体内容为:

10、(1)解耦视频时间动态特征的具体内容

11、构建动态编码器:使用6个步长为2、大小为4×4的卷积核构建动态编码器,并在前5层卷积后使用一个批归一化处理操作和 leaky relu激活函数;在最后的输出层使用tanh激活函数,将输出的时间动态特征向量规范化到-1到1之间。

12、提取时间动态特征:在动态编码器中引入对抗性损失函数,利用动态编码器和特征鉴别器的对抗训练使得时间动态特征从空间静态中完全解耦,具体公式为:

13、;

14、;

15、其中, l adversarial表示对抗性损失函数, e d表示动态编码器, t表示特征鉴别器,表示第 m段视频的第 t帧视频序列,表示第 m段视频的第 t+ k帧视频序列,表示第 n段视频的第 t帧视频序列,表示第 n段视频的第 t+ k帧视频序列。

16、包含外观信息的静态特征在同一段视频中不会随时间发生变化,而在不同视频中会存在差别,因此当特征鉴别器判断不出动态特征是否来自同一段视频时,完全解耦时间动态特征任务就得以完成。

17、特征鉴别器使用三层1×1卷积和 relu激活函数,并在最后一层使用 sigmoid函数将鉴别器输出的概率向量映射到0-1区间。

18、(2)解耦视频空间静态特征的具体内容

19、空间静态特征表现为视频的背景、颜色、外观细节,使用与动态编码器 e d相同的架构构建静态编码器,并引入相似性损失函数,利用平方差最大化相邻时间步的空间静态特征的相似性,具体公式为:

20、;

21、其中, l similarity表示相似性损失函数, e s表示静态编码器, x t表示第 t帧视频序列, x t+k表示第 t+ k帧视频序列。

22、进一步的,步骤s1中,将解耦得到的视频的时间动态特征和空间静态特征进行融合,具体内容为:

23、;

24、其中,表示第 t到 t+ k帧的视频序列解耦后的时间动态特征,;表示第 t到 t+ k帧的视频序列解耦后的空间静态特征,; x t: t+ k表示第 t到 t+ k帧的视频序列; h t: t+ k表示第 t到 t+ k帧视频序列的时间动态特征和空间静态特征融合后的解耦特征。

25、进一步的,步骤s2中,动态差分模型的具体设计内容为:

26、将传统lstm单元的遗忘门替换成动态差分模型,该模型接受相邻时间步隐藏状态的差分信息,并在经过遗忘门、输入门和更新门后与上一时间步的长时记忆细胞融合,组成差分特征。之后利用输出门生成当前时间步的长时记忆细胞,并参与到之后的信息的信息更新。具体公式如下:

27、

28、;

29、其中,σ和tanh分别表示 sigmoid和tanh激活函数;*表示卷积操作,⊙表示哈达玛乘积,为二维卷积核,为偏置, t表示时刻, l表示层,分别表示用于筛选差分信息的遗忘门、输入门和更新门,表示相邻时间步隐藏状态的差分信息,表示上一时间步的长时记忆细胞,表示差分特征。

30、进一步的,步骤s3中,组建新的全局自注意力模型的具体步骤为:

31、s301、给当前时间步的隐藏状态分配不同的1×1权重,将其映射到查询向量、键向量和值向量的三个不同空间,利用计算第 j个键向量和第 e个查询向量的相似度分数,并利用 softmax()激活函数对该分数进行归一化处理,得到各个点的相似分布,将相似分布乘以对应值向量得到注意力特征,具体公式为:

32、

33、;

34、其中, q表示查询向量, k表示键向量, v表示值向量, w q、 w k和 w v表示给隐藏状态分配的三个不同的权重,表示隐藏状态, z表示注意力特征, c× h× w表示通道的数×高×宽, n= h× w, e, j表示查询向量和键向量的位置索引, q e表示第 e个查询向量,表示第 j个键向量的转置, d k表示键向量的维度, t表示转置。

35、s302、将长时记忆与注意力特征、隐藏状态深度融合,具体公式如下:

36、

37、;

38、其中, i、 g和 o分别表示全局自注意力模块中的输入门、更新门和输出门,表示二维卷积核,表示偏置,表示更新后的长时记忆和隐藏状态,表示当前时间步经过全局注意力模块的隐藏状态。

39、进一步的,步骤s4中,构建disa-lstm预测网络的具体步骤为:

40、s401、将动态差分模型替换lstm单元中的遗忘门,并将当前时间步的隐藏状态和上一时刻的长时记忆输入到全局自注意力模型中,组成新的disa-lstm单元。

41、s402、由三层记忆单元堆叠组成disa-lstm预测网络,由于第一层没有先前特征,因此使用st-lstm单元,其他两层为disa-lstm单元;采用对角循环结构构建disa-lstm预测网络,其中差分信息在网络中对角层级传递,经过全局自注意力模型的隐藏状态在时间维度传递。

42、进一步的,步骤s5中,视频预测模型的具体内容为:

43、基于卷积自编码器构建的网络整体架构主要包括编码器、disa-lstm预测网络和解码器三个部分,其中:

44、编码器由时空解耦网络组成,该网络包含动态编码器和静态编码器,用于解耦视频的时间动态特征和空间静态特征,并将视频数据编码成较小维度的潜在向量表示。

45、经过编码器的特征向量表示,进一步融合后进入disa-lstm预测网络,通过学习内部潜在关系生成未来帧。

46、解码器由反卷积组成,为了增强预测图像的外观细节表达,未来帧序列与解耦的空间静态特征融合并经过解码器重构回原始像素。

47、通过解耦损失和预测损失训练视频预测模型,其中解耦损失包含对抗损失、相似性损失和重构损失;解耦损失用于鼓励视频数据完全解耦并确保未来帧能够与空间静态特征重构,预测损失用来最大化预测结果和实际结果间的相似度。利用反向传播算法优化模型,以提高预测图像的质量。具体公式为:

48、;

49、;

50、其中, l reconstruction是重构损失函数; l mse是预测损失,使用均方误差作为模型的损失回传; d表示解码器;是用于平衡不同损失函数的收敛速度的超参数。

51、进一步的,本发明还提出了基于时空解耦与自注意力差分lstm的视频预测系统,包括:

52、视频特征解耦模块,用于构建时空解耦网络,解耦视频的时间动态特征和空间静态特征。

53、动态差分模型设计模块,用于利用差分运算,设计包含遗忘门、输入门和更新门的动态差分模型,取代lstm单元的遗忘门。

54、深度融合特征模块,用于在注意力基础上设计一个门控机制,将长时记忆与被注意的特征深度融合,组建新的全局自注意力模型。

55、视频预测模型训练模块,用于基于卷积自编码器构建网络整体架构,并联合对抗性损失函数、相似性损失函数、重构损失函数和预测损失训练视频预测模型。

56、进一步的,本发明还提出了一种电子设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述计算机程序时实现基于时空解耦与自注意力差分lstm的视频预测方法的步骤。

57、进一步的,本发明还提出了一种计算机可读的存储介质,所述计算机可读的存储介质存储有计算机程序,所述计算机程序被处理器运行时执行所述基于时空解耦与自注意力差分lstm的视频预测方法。

58、本发明采用以上技术方案与现有技术相比,具有以下技术效果:

59、1.本发明通过引入时空解耦网络,解耦时间动态特征和包含外观信息空间静态特征,从而降低高维视频数据给预测工作带来的复杂程度。

60、2.结合动态差分和全局自注意力改进的disa-lstm预测网络,具有处理非平稳序列的功能,且有效提高了捕获高维动态复杂特征的能力。加入的全局自注意力模型,可以存储具有长时依赖的历史信息,并与当前状态信息相互作用,生成新的隐藏状态,提高网络短期依赖和长期关联的特征表达。

61、3. 本发明整体基于卷积自编码器构建,预测网络生成的未来帧与解耦后的静态特征融合,并利用解码器网络生成外观清晰的未来帧,最终解决视频预测任务复杂度高且预测图像外观模糊、准确率低的问题。

- 还没有人留言评论。精彩留言会获得点赞!