一种基于张量和互信息的多模态数据融合方法和设备与流程

本发明属于机器学习领域,特别是涉及一种基于张量和互信息的多模态数据融合方法和设备。

背景技术:

1、在现实世界中,数据天然是多源异构的,并且以多模态的形式存在,多模态数据已成为近年来数据资源的主要形式。“模态”是一个更为细粒度的概念,同一媒介下可存在不同的模态。概括来说,“多模态”可能有三种形式:①描述同一对象的多媒体数据,如互联网环境下描述某一特定对象的视频、图片、语音、文本等信息;②来自不同传感器的同一类媒体数据,如物联网背景下不同传感器所检测到的同一对象数据等;③具有不同的数据结构特点、表示形式的表意符号与信息,如描述同一对象的结构化、非结构化的数据单元,描述同一语义的词向量、词袋、知识图谱以及其它语义符号单元等。因此,从语义感知的角度切入,多模态数据涉及不同的感知通道如视觉、听觉、触觉、嗅觉所接收到的信息;在数据层面理解,多模态数据则可被看作多种数据类型的组合,如图片、数值、文本、符号、音频、时间序列,或者集合、树、图等不同数据结构所组成的复合数据形式,乃至来自不同数据库、不同知识库的各种信息资源的组合。人类的认知过程也是多模态的,个体对场景进行感知时往往能快速地接受视觉、听觉乃至嗅觉、触觉的信号,进而对其进行融合处理和语义理解。多模态数据分析与处理方式更贴近人类认识世界的形式。为了探索实现通用人工智能的路径,人工智能从单模态走向多模态已是大势所趋。以前,siri等语音助手只有声音没有脸,搜索只能依靠输入文字,机器看不懂照片的深层含义。如今,借助多模态技术,人工智能可以实现图像、视频、音频、文本等多维度资源的融合互补,不仅决策更加精准,还在行为和智商上更接近人类,多模态技术赋予了计算机深层次理解大数据的能力。

2、多模态数据融合负责将多个模态的信息进行有效的整合,汲取不同模态的优点,完成对信息的整合。自然现象具有十分丰富的特征,单一模态很难提供某个现象的完整信息。面对保持融合后具有各个模态信息的多样性以及完整性、使各个模态的优点最大化、减少融合过程造成的信息损失等方面的融合要求,如何对各个模态的信息进行融合成为了多个领域广泛存在的一个新挑战。

3、根据多模态融合的阶段,多模态融合方法可分为早期融合、晚期融合和混合融合。早期融合,又称为特征融合,是指对模态进行特征提取之后立刻进行的一种融合方式。特征融合的优势在于可以在早期利用来自不同模态的多个特征之间的相关性,适用于模态之间高度相关的情况。这种方法很难表示多模态特征之间的时间同步。由于各种模态的表征、分布和密度可能有所不同,只进行简单的属性之间的连接可能会忽视各个模态独有的属性和相关性,并可能会产生数据之间的冗余和数据依赖。随着特征数量的增加,很难获得这些特征之间的交叉相关性。后期融合,也称为决策层融合,指的是在每种模态都做出决策(分类或回归)之后才进行的融合。进行后期融合,需要使用相应的模型对不相同的模态进行训练,再对这些模型输出的结果进行融合。与之前的早期融合作比较,该融合方式可以处理简单的数据异步性。另一个优势是允许使用最适合分析每种单一模态的方法。但是晚期融合忽视了多个模态之间的低水平的相互作用,并且融合起来难度较高。由于不同的分类器需要不同的决策,学习过程变得既耗时又费力。混合融合综合了早期融合与后期融合的优点,但也使得模型的结构变得复杂并加大了训练的难度。由于深度学习模型所具有的灵活性和多样性的结构特点,比较适合使用混合融合方法。

4、根据模态融合方式,多模态融合方法可分为三大类:基于张量的方法、基于注意力的方法、以及基于图神经网络(gnn)的方法。基于张量的方法采用外积运算融合多模态输入特征,可以有效地建模模态内和模态间的动态。基于注意力的方法关注重要特征,或特征中的重要区域,并对关键部分赋予更高的权重。基于图神经网络的方法采用异构图来建模不同模态特征之间的时间关系,可以捕获模态内和模态间的较长距离依赖关系。

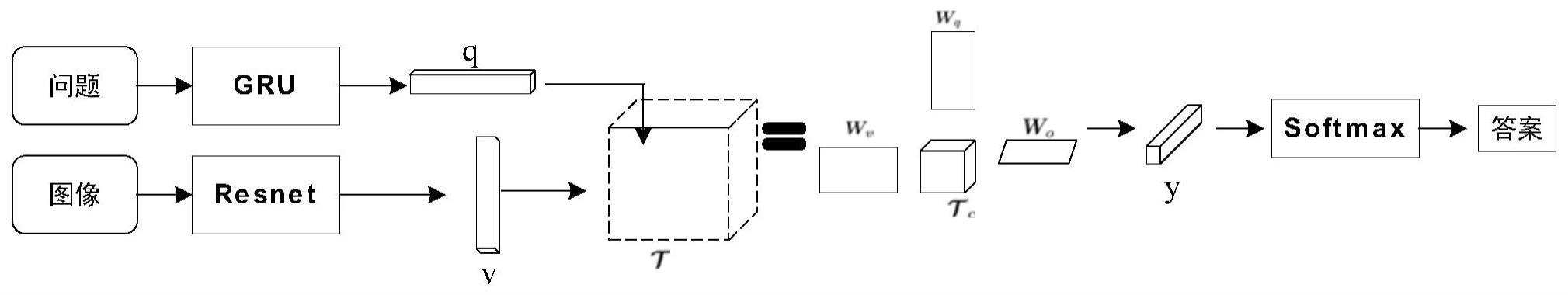

5、多模态tucker融合(mutan):基于多模态tucker张量数据融合方法,能够有效的在视觉和文本的双线性交互(bilinear models)的模型中进行参数化,还设计了基于矩阵的低秩分解来明确限制交互等级。它是一种基于模态之间的双线性相互作用的多模态融合方案,在控制参数的数量上,mutan采用减少单模态嵌入的大小,同时使用完整的双线性融合方法来尽可能精确模拟它们之间的相互作用。mutan应用于视觉问答问题中,其模型结构如附图1所示。

6、模型采用gru递归网络提取问题(文本)特征,采用全卷积神经网络resnet来提取图像特征,再用进行融合,产生向量y后再用softmax函数进行答案预测。经过张量t的tucker融合方程参数化张量t的权重时,y的输出可以表示为

7、

8、这完全等同于将q和v的投影的完整双线性交互编码为一个潜在对表示z,并使用该潜在代码预测答案,如下所示:

9、

10、将z再投影到预测空间获得y,如下所示:

11、y=ztwo

12、通过softmax后预测答案,如下所示:

13、p=softmax(y)。

14、多模态tucker融合模型在视觉问答应用中能取得较好的性能,但是仍然存在以下问题和不足:一是只能处理双模态输入,因为在视觉问答应用中,输入的数据只包含问题(文本)和图像两种模态的数据,其参数约简的过程也是针对双模态输入设计的,难以拓展到多个模态输入的情况中。二是在特征提取和数据融合的过程仍然存在较多的冗余信息和噪声,这些任务无关信息严重影响了数据融合的效果,降低了模型的性能,需要对这些噪声和冗余信息进行过滤。

技术实现思路

1、本发明要解决的技术问题是现有技术中的只能处理双模态输入和数据融合中存在冗余及噪声的问题。本发明采用张量融合和互信息来设计一个新的多模态表示及融合模型。张量作为向量和矩阵的高阶扩展形式,能够有效地对数据中的各类关系进行建模和表示对齐,而互信息用来辅助抽取不同模态数据中的不变特征,过滤数据融合过程中产生的冗余和噪声信息,学习任务相关的多模态融合表示形式。本发明提出一种新的mtfmif框架来处理多模态异构数据,可以接受任意种模态数据的输入,以端到端的方式学习多模态融合表示;本发明还提出一种新的多模态tucker融合方法,将多模态数据映射到统一的张量空间,实现多线性融合;其次利用互信息约束模态内、模态间和融合特征的学习过程,消除特征中与任务无关的噪声和冗余信息。

2、为了达到上述目的,本发明提供的技术方案是:一种基于张量和互信息的多模态数据融合方法,包括以下步骤:

3、(1)数据预处理模块:获取多模态视频语料库,对语料库中视频片段进行预处理,得到文本、视觉、语音三种模态的特征序列数据;

4、(2)单模态表示学习模块:学习更细粒度的单模态的特征嵌入,利用互信息过滤单模态特征中的任务无关的噪声和冗余信息,对齐模态之间的表示;

5、(3)多模态融合学习模块:学习紧凑的多模态融合表示,利用多模态tucker融合方法融合多种模态输入特征,利用互信息提升单模态输入特征和多模态融合特征的相关性,进一步过滤单模态中无关信息,减少融合过程产生的噪声信息;

6、(4)训练及预测:设计训练所使用的损失函数,训练步骤(1)-(3)构成的模型,并进行最终的预测。

7、进一步的,步骤(1)中每个视频都被分割成三种模态的语料库,文本特征提取过程为使用预训练的bert作为文本特征提取器,最终输出的句子特征是所有维数为768的词项的平均表示;

8、语音特征提取过程为使用covarep语音分析工具提取74维的语音特征;视觉特征提取过程为:利用facet面部表情分析工具提取35维的面部表情特征;对于语料库,提取完的特征组成三种模态的序列:文本t、视觉v和语音a模态的特征序列表示分别为其中lm,m∈{t,v,a}为序列的时间长度,dm,m∈{t,v,a}表示每个模态的特征维数,最后将预处理后的数据集按照7:3的比例分割成训练集和测试集。

9、进一步的,步骤(2)中学习更细粒度的单模态的特征嵌入具体包括:

10、在文本模态方面,利用预训练的ber直接通过提取文本表示,将最后一层bert隐藏状态的表示作为话语级特征表示

11、

12、其中θt为预训练bert模型的参数,dt'为预训练bert模型的输出维数;

13、对于视觉和语音模态,采用双向长短期记忆网络对视觉和语音输入序列进行编码;bilstm的最终状态隐藏层的输出作为视觉和语音序列的全局特征表示:

14、

15、

16、其中,分别为文本t、视觉v和语音a的特征序列,其中lm,m∈{t,v,a}为序列的时间长度,dm,m∈{t,v,a}表示每个模态的特征维数;表示视觉和语音bilstm编码器的输出特征,θv,θa分别表示视觉和语音bilstm编码器的参数,dv'和da'分别是视觉和语音bilstm编码器的输出特征维度;

17、此外,为了进一步细化视觉和语音特征,将和输入到多层感知器,用于提取更高级别的单模态特征,视觉和语音模态的最终单模态表示如下:

18、

19、

20、式中,表示视觉、语音两种mlp编码器的输出特征,表示视觉、语音两种mlp编码器的参数。

21、进一步的,步骤2中利用互信息过滤单模态特征中的任务无关的噪声和冗余信息,对齐模态之间的表示,具体实现方式如下;

22、利用互信息神经估计mine进一步提取任务相关的特征,即最大化两个mlp编码器的输入和输出之间的互信息,通过定义一个模态内损失,将其作为一个训练目标:

23、

24、其中,表示模态内损失,和分别表示根据mine计算出的语音和视觉的模态内互信息;

25、然后通过利用文本模态中包含的语义信息来指导视觉和听觉模态的学习,有效提高视觉、语音和文本模态之间的相关性,以同样的方式,以上的处理过程可以通过一个跨模态损失表示如下:

26、

27、其中,表示模态间损失,和分别表示根据mine计算的语音与文本、视觉与文本的模态间互信息;

28、对于模态内损失和模态间损失,单模态表示学习通过最小化总的模态损失函数来约束:

29、

30、其中,表示总的模态损失。

31、进一步的,步骤(3)具体包括:

32、在单模态表示学习部分之后,需要融合来自三个模态的特征,并基于融合后的特征进行预测,采用三线性tucker融合方法ttf将三个模态输入视为因子矩阵,并与训练参数的核心张量执行张量积运算,获得紧凑的融合表示,有效地弥合模态之间的语义鸿沟;ttf表示为:

33、

34、其中表示可学习的核心张量参数,表示输出的融合表示,do是融合表示的维数,×i,i∈{1,2,3}表示张量的n模积;

35、进一步分解核心张量来减少参数的数量,根据blockterm分解,秩为(ht,ha,hv,ho)的的blockterm分解形式为:

36、

37、其中表示分解后更小的核心张量,为分解后的因子矩阵,r∈{1,2,…,r},根据分解后的改写为:

38、

39、为方便起见,设根据这些变换,利用全连接层将输入嵌入投影到一个更小的嵌入中,将和整合成一个新的项,即通过上述分析,将公式简化为:

40、

41、为了更好地利用多模态的互补性和一致性,利用mine估计融合表示和单模态表示之间的互信息,并通过最大化互信息来提高它们之间的相关性,优化目标是将更多特定于模式的信息传递给融合表示,多模态融合学习部分的损失函数定义为:

42、

43、其中和分别表示根据mine计算的融合表示与文本、语音和视觉输入特征之间的互信息。

44、进一步的,步骤(4)具体包括:

45、为了对情感强度进行预测,将融合后的表示输入一个mlp中,得到最终的预测结果:

46、

47、其中θo为预测网络mlp的参数,表示预测的标签;

48、与真实标签一起对比,任务损失函数被定义为

49、

50、其中b是批大小,i代表一个批次中的第i个样本,表示预测的第i个样本的标签,yi表示第i个样本的真实标签;

51、最后,通过所有损失函数的加权和来计算总损失函数:

52、

53、其中α和β是平衡模态损失函数和融合损失函数影响的超参数。

54、进一步的,步骤(4)中采用反向传播算法训练模型,采用adam优化器对模型进行端到端的训练。

55、进一步的,还包括步骤(5),使用加权f1分数,二分类准确率和七分类准确率来评估模型的优劣。

56、第二方面,本发明提供一种基于张量和互信息的多模态数据融合设备,包括:

57、一个或多个处理器;

58、存储装置,用于存储一个或多个程序,当所述一个或多个程序被所述一个或多个处理器执行时,使得所述一个或多个处理器实现如权利要求1至8中任一项所述的方法。

59、本发明提供了一种基于张量和互信息的多模态数据融合方法,可带来以下有益技术效果:

60、(1)提出一种新的mtfmif框架来处理多模态异构数据,可以以端到端的方式学习多模态融合表示;

61、(2)提出多模态tucker融合方法,将多模态数据映射到统一的张量空间,实现多线性融合;

62、(3)利用互信息约束模态内、模态间和融合特征的学习过程,消除特征中与任务无关的噪声。

- 还没有人留言评论。精彩留言会获得点赞!