一种基于Fast-SCNN与Deepfillv2的同时定位与建图方法

本发明属于移动机器人自主导航领域,特别是一种基于fast-scnn语义分割网络与deepfillv2背景修复网络的同时定位与建图方法。

背景技术:

1、slam技术在机器人领域扮演着重要角色,它使得机器人具备了自主感知,理解和导航环境的能力,大大提升了机器人的自主性和适应性。而利用摄像头作为传感器的视觉slam也得到了广泛发展,视觉slam系统在静态环境下取得了非常优秀的效果。

2、但传统的视觉slam以静态环境为前提,在面对具有大量动态对象的环境时,视觉slam算法的性能将显著降低。传统slam的应用范围被现实动态对象限制。

3、随着计算机视觉与深度学习的发展,越来越多的学者尝试将语义分割网络添加到slam系统中,通过赋予环境物体语义信息,来剔除潜在的动态目标。但剔除动态区域会带走图像中有效的背景信息,导致系统稳定性变差甚至跟踪失败。

4、cn11351664a,一种基于语义分割动态点的视觉slam方法,该专利采用mask r-cnn分割网络结合多视图几何算法剔除图像动态特征点,提高系统在动态环境下的精度。但是上述方法只使用剩余的静态特征点进行后续跟踪建图,在特征点数较少时会出现跟踪丢失的情况。

5、cn115187614a,一种基于stdc语义分割网络的实时同时定位与建图方法,该专利采用stdc分割网络剔除图像动态区域,使用静态区域进行跟踪建图。该方法同样未对缺失的区域进行修复,仍然存在跟踪轨迹丢失的问题。

6、cn112435262a,基于语义分割网络和多视图几何的动态环境信息检测方法,包括以下步骤:标定相机,去除图像畸变;获取环境图像并输入;通过语义分割网络对输入图像进行分割,获得各物体掩码,实现初步动态分割;对输入图像提取orb特征点,然后计算描述子;使用多视图几何和语义信息结合的方法检测并剔除动态特征点;对orb特征点进行匹配以获得机器人的位姿信息;判断并插入关键帧,通过局部建图线程进行点云处理,获得稀疏点云地图;利用回环检测来优化位姿,更正漂移误差。该专利剔除了动态特征点,只保留了静态区域进行跟踪建图,在动态区域较多的环境中存在静态特征点过少,跟踪易丢失的问题。本发明则可以将丢失的背景区域进行修复,从而增加可供于系统跟踪的信息,提高跟踪成功率。

技术实现思路

1、本发明旨在解决以上现有技术的问题。提出了一种基于fast-scnn与deepfillv2的同时定位与建图方法。本发明的技术方案如下:

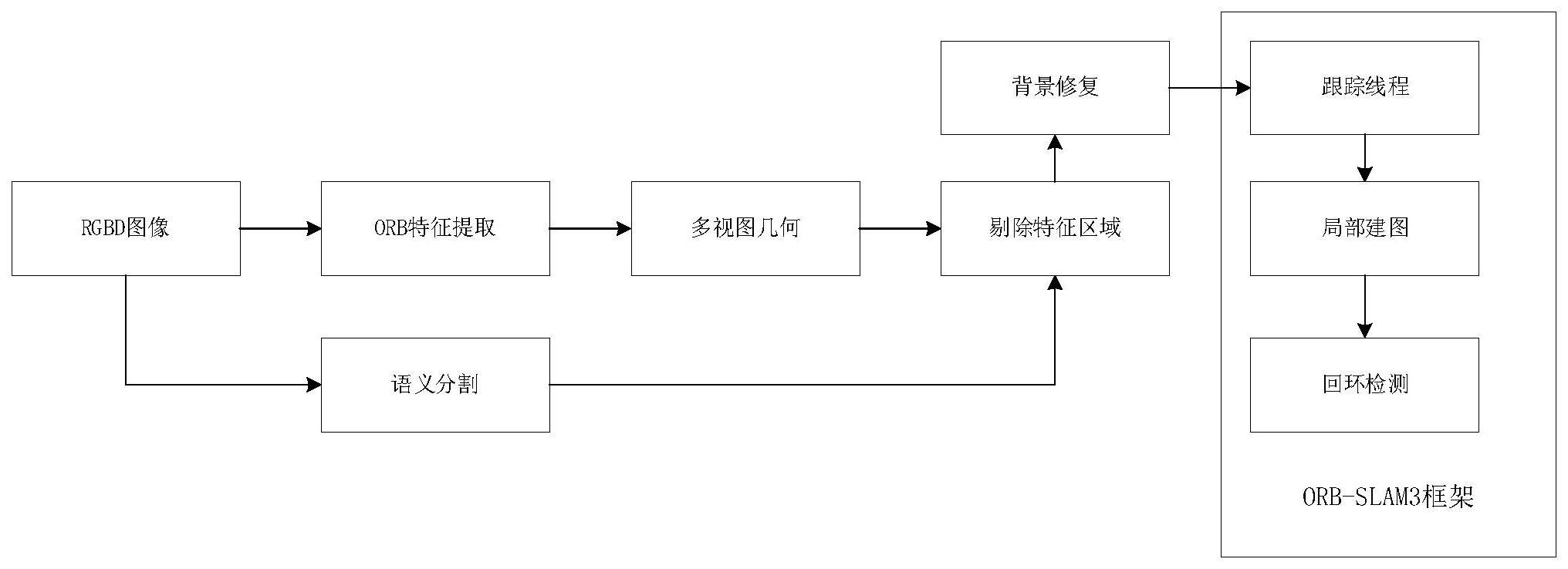

2、一种基于fast-scnn与deepfillv2的同时定位与建图方法,其包括以下步骤:

3、s1、利用rgb-d相机获取环境信息;

4、s2、利用orb特征提取算法对rgb-d图像信息进行特征点提取;

5、s3、利用多视图几何法,通过两帧图像之间特征点的差值,将超过阈值的点判定为动态特征点;

6、s4、利用fast-scnn双分支倒残差连接网络获取图像语义信息,并利用语义信息将潜在动态区域标记;

7、s5、将多视图几何法判定的动态特征点与fast-scnn网络标记的潜在动态区域相结合相结合,判断并剔除真正的动态区域;

8、s6、使用deepfillv2背景修复网络将图像剔除部分的背景信息补全;

9、s7、将补全的图像利用orb-slam3算法进行定位与导航,orb-slam3是一个实时的slam算法,该算法包括跟踪线程、局部建图线程以及回环检测线程。

10、进一步的,所述步骤s2利用orb特征提取算法对rgb-d图像信息进行特征点提取,具体包括:

11、使用fast算法获得关键点;

12、然后利用图像块的灰度质心为特征点添加旋转描述;

13、最后,使用brief描述子对特征点进行描述。

14、进一步的,所述步骤s3利用多视图几何法,通过两帧图像之间特征点的差值,将超过阈值的点判定为动态特征点,具体包括:

15、空间点p在历史帧l1的空间坐标为:

16、p=[x,y,z]t

17、历史帧l1到当前帧l2之间的相机运动表示为:

18、s1x1=kp

19、s2x2=k(rp+t)

20、式中:k表示相机内参,s1和s2表示p的深度值,r和t是历史帧l1到当前帧l2之间相机的旋转和平移运动;

21、用齐次坐标表示为:

22、p1=kp

23、p2=k(rp+t)

24、取:

25、x1=k-1p2

26、x2=k-1p2

27、式中:p1和p2分别表示空间点p在l1与l2上的投影坐标,x1和x2分别表示p1和p2在归一化坐标系下的坐标,带入得:

28、x2=rx1+t

29、为x2的转置,左右两边同时乘得:

30、

31、与x2做内积可得:

32、

33、代入p1、p2:

34、

35、则本质矩阵e和基础矩阵f可以表示为:

36、e=t^r

37、f=k-tek-1

38、

39、p1、p2在归一化平面的坐标x1和x2可以表示为:

40、x1=[u1,v1,1]t

41、x2=[u2,v2,1]t

42、式中:u、v为像素坐标,那么极线l1表示为

43、

44、p2到极线l2的距离d表示为:

45、

46、设置距离阈值g,如果p2到极线l2的距离d大于g,则判定该投影点为动态特征点,若距离d小于g,则判定该投影点为静态特征点。

47、进一步的,所述步骤s4的fast-scnn语义分割网络是一种高效的实时性语义分割网络,其结构包括了下采样模块和特征提取模块。其中,fast-scnn在下采样模块采用深度可分离卷积对图像进行编码,在特征提取模块利用倒残差网络引导低层学习空间细节的特征。

48、进一步的,所述下采样模块具体为,利用三个深度可分离卷积获取不同感受野的特征图,三个卷积层步长均为2,其计算量为:

49、c_depthwise=(k×k×n×h×w×n)+(1×1×n×h×w×m)

50、式中:c为计算量,k为卷积核大小,h为输入特征长,w为输入特征宽,n为输入特征通道数,m为输出通道数。

51、进一步的,所述特征提取模块采用了倒残差网络提取图像细节特征,并采用相同的两个步长为1倒残差卷积加深网络深度。倒残差网络是一种采用倒残差连接方式的网络,它通过对输入特征模块通道数进行收缩、扩张、再收缩的倒残差连接方式,提取细节特征并减少计算量。

52、进一步的,所述步骤s5结合多视图几何法与语义分割网络剔除动态特征区域具体为:首先将语义分割图中的潜在动态区域标记;然后计算动态区域中由多视图几何法判断的动态特征点占总特征点的比例;设置阈值,若比例超过该阈值则将该区域进行剔除,否则保留;设置阈值为0.3。

53、进一步的,所述步骤s6的deepfillv2背景修复网络网络具体为:deepfillv2网络结构包括图像修复器和鉴别器。图像修复器采用一种门控卷积进行修复,门控卷积用于提取输入的特征和纹理信息,通过自动学习掩码,来控制特征的选择和组合,进而完成图像的背景修复。鉴别器是一种基于条件生成对抗网络的判别器结构,生成对抗网络包括生成和判别两个模块,通过互相博弈学习拟合相应的生成,并帮助模型更好地判断生成图片和真实图片的差异,从而提高生成图片的质量和可信度。

54、进一步的,所述步骤s7将补全的图像利用orb-slam3算法进行定位与导航,具体包括:

55、跟踪线程:寻找局部地图特征并匹配,利用光束平差优化ba算法来最小化重投影误差,确定相机在每一帧的位置;

56、局部建图线程:运用局部ba算法优化相机位姿;

57、回环检测线程:通过位姿优化消除累计误差;在位姿优化后启动全局ba算法线程,计算整个系统最优结构和运动结构。

58、一种电子设备,包括存储器、处理器及存储在所述存储器上并可在所述处理器上运行的计算机程序,所述处理器执行所述程序时实现如任一项所述基于fast-scnn与deepfillv2的同时定位与建图方法。

59、本发明的优点及有益效果如下:

60、1、本发明针对融合了语义分割网络的slam系统在动态环境下不能准确剔除动态区域,且跟踪成功率低的问题,提出了一种基于fast-scnn语义分割网络与deepfillv2背景修复网络的同时定位与建图方法,本发明一方面采用fast-scnn语义分割网络对潜在动态物体进行标注,如步骤4、5,利用三个深度可分离卷积获取不同感受野的特征图,并采用倒残差网络提取图像的细节特征;另一方面,由于语义分割网络只能识别潜在的动态物体,无法判断物体是否处于运动状态,本发明采用了多视图几何结合语义分割网络的方法剔除动态物体,利用多视图几何法判定动态特征点,再将语义分割标注的区域中的动态特征点与该区域所有特征点进行比较,若超过阈值则剔除该区域。该方法比只使用语义分割网络剔除动态区域更加准确;最后,本发明使用背景修复网络deepfillv2对被剔除动态区域的图像进行修复,使用门控卷积网络将图像丢失的背景区域补全,该方法可以提高系统的跟踪成功率。

- 还没有人留言评论。精彩留言会获得点赞!