双目立体视觉匹配网络构建方法及双目立体视觉匹配方法

本发明属于双目立体视觉匹配领域,更具体地,涉及双目立体视觉匹配网络构建方法及双目立体视觉匹配方法。

背景技术:

1、立体视觉在计算机视觉中扮演了重要角色,在实际应用中,双目立体视觉技术成为了当前现有的重点和热点。双目立体视觉的本质就是通过两个摄像机在同一个环境下获取物体的二维平面图像,即左图和右图,并通过二维平面图像信息提取空间三维信息,实现对物体形状、大小和位置等方面的理解,因此广泛地应用于机器人导航、非接触式测量,医学影像处理、三维重建等领域。

2、立体视觉匹配的主要目的是对双目相机拍摄的两张图像找到一对一的对应点,对其进行匹配,从而得到对应点的视差,在匹配过程中,通常会把左图当做参考图像,将右图作为待匹配图像对其进行搜索匹配出对应关系。

3、传统立体匹配采用特征提取算法通常只能识别简单的形状和纹理特征,不能很好地处理复杂的场景和光照变化等问题,导致在实际应用中的性能表现不佳。随着深度学习的发展和大数据的支撑,立体匹配的性能有了很大提升。但是,在复杂多变的实际场景下,当前的立体视觉技术往往难以准确实现边缘和遮挡区域的匹配,因此存在着精度和可靠性方面的不足。

技术实现思路

1、针对现有技术的缺陷和改进需求,本发明提供了双目立体视觉匹配网络构建方法及双目立体视觉匹配方法,其目的在于,引入视差边缘信息指导双目立体视觉匹配,使得在复杂多变的实际场景下也能准确实现边缘和遮挡区域的匹配,提高匹配精度和可靠性。

2、为实现上述目的,按照本发明的一个方面,提供了一种双目立体视觉匹配网络构建方法,包括:

3、收集左图、右图及相应的视差图构建数据集,建立待训练的立体匹配网络后,利用数据集对待训练的立体匹配网络进行训练和测试,得到用于估计左图和右图间视差图的双目立体视觉匹配网络;

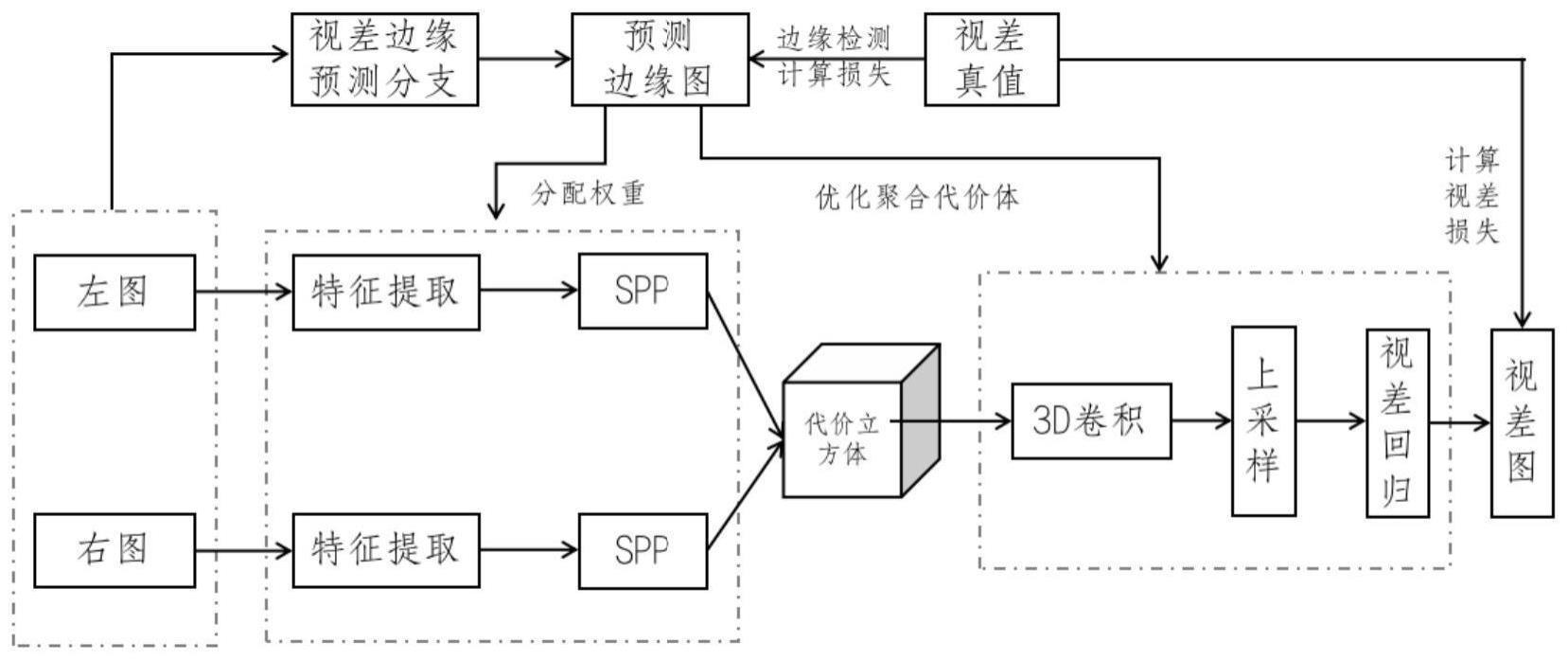

4、立体匹配网络包括:视差边缘预测分支和视差估计主干网络;

5、视差边缘预测分支用于对图像进行视差边缘预测,得到相应的视差边缘预测图;

6、视差估计主干网络包括:

7、代价立方体构建子网络,用于构建待匹配的左图和右图之间的代价立方体;待匹配的左图和右图中,一幅为参考图像,另一幅为待匹配图像;

8、代价聚合模块,用于对代价立方体进行正则化,得到聚合代价体;

9、聚合代价优化模块,用于按照视差边缘预测分支预测输出的参考图像的视差边缘预测图识别聚合代价体的边缘区域并进行抑制,得到优化后的聚合代价体;

10、以及视差回归模块,用于将优化后的聚合代价体上采样至与参考图像尺寸一致后对其进行回归,得到视差图。

11、进一步地,聚合代价优化模块按照如下公式对聚合代价体的边缘区域进行抑制:

12、cnew(x,y)=c(x,y)×(2-p(x,y))

13、其中,cnew为优化后的聚合代价体,c为聚合代价体,p为参考图像的视差边缘预测图,(x,y)表示像素坐标。

14、进一步地,代价立方体构建子网络包括:

15、左图低尺度特征提取模块,用于对左图进行原尺度特征提取,得到左图的低尺度特征;

16、左图高尺度特征提取模块,用于对左图的低尺度特征进行空间金字塔池化操作,得到左图的高尺度特征;

17、左图特征融合模块,用于将左图的低尺度特征和高尺度特征进行加权融合,得到左图的融合特征;融合时,低尺度特征在边缘区域具有较高的权重,高尺度特征在非边缘区域具有较高的权重,边缘区域和非边缘区域依据视差边缘预测分支预测输出的左图的视差边缘预测图确定;

18、右图低尺度特征提取模块,用于对右图进行原尺度特征提取,得到右图的低尺度特征;

19、右图高尺度特征提取模块,用于对右图的低尺度特征进行空间金字塔池化操作,得到右图的高尺度特征;

20、右图特征融合模块,用于将右图的低尺度特征和高尺度特征进行加权融合,得到右图的融合特征;融合时,低尺度特征在边缘区域具有较高的权重,高尺度特征在非边缘区域具有较高的权重,边缘区域和非边缘区域依据视差边缘预测分支预测输出的右图的视差边缘预测图确定;

21、以及代价体构建模块,用于按照预定的最大视差值,在每个视差水平上将左图的融合特征和右图的融合特征进行连接,得到左图和右图之间的代价立方体。

22、进一步地,左图特征融合模块按照如下公式将左图的低尺度特征和高尺度特征进行加权融合:

23、

24、右图特征融合模块按照如下公式将右图的低尺度特征和高尺度特征进行加权融合:

25、

26、其中,fnew_l和fnew_r分别表示左图和右图的融合特征,flow_l和flow_r分别表示左图和右图的低尺度特征,fhigh_l和fhigh_r分别表示左图和右图的高尺度特征,pl和pr分别表示左图和右图的视差边缘预测图,(x,y)表示像素坐标。

27、进一步地,视差边缘预测分支包括:

28、2d卷积模块,用于提取输入图像的浅层特征;

29、多尺度特征提取模块,用于对浅层特征执行不同尺度的空间金字塔池化操作,得到多个尺度的深层特征;

30、上采样模块,用于将各个尺度下的深层特征上采样至与输入图像尺寸一致;

31、特征融合模块,用于将上采样模块输出的各个特征图级联后进行卷积操作,得到单通道的边缘特征;

32、以及边缘回归模块,用于将边缘特征中的像素值回归到[0,1]范围内,得到视差边缘预测图。

33、进一步地,利用数据集对待训练的立体匹配网络进行训练和测试,包括:

34、对数据集中的视差图进行边缘检测,得到视差边缘图,与对应左图和右图构成边缘检测样本集;

35、利用边缘检测样本集对立体匹配网络中的视差边缘预测分支进行训练和测试;

36、冻结立体匹配网络中视差边缘预测分支的参数,利用数据集对立体匹配网络进行训练和测试,得到双目立体视觉匹配网络。

37、进一步地,利用边缘检测样本集对立体匹配网络中的视差边缘预测分支进行训练时,采用加权交叉熵损失函数。

38、进一步地,冻结立体匹配网络中视差边缘预测分支的参数,利用数据集对立体匹配网络进行训练时,采用基于视差的smooth l1损失函数。

39、按照本发明的又一个方面,提供了一种双目立体视觉匹配方法,包括:

40、将待匹配的左图和右图输入至双目立体视觉匹配网络,由双目立体视觉匹配网络输出左图和右图之间的视差图;

41、将左图和右图之间的视差图转换为深度图,完成匹配;

42、其中,双目立体视觉匹配网络由本发明提供的上述双目立体视觉匹配网络构建方法建立所得。

43、按照本发明的又一个方面,提供了一种计算机可读存储介质,包括存储的计算机程序,计算机程序被处理器执行时,控制计算机可读存储介质所在设备执行本发明提供的上述双目立体视觉匹配网络构建方法,和/或,本发明提供的上述双目立体视觉匹配方法。

44、总体而言,通过本发明所构思的以上技术方案,能够取得以下有益效果:

45、(1)本发明所建立的双目立体视觉匹配网络,在视差估计主干网络的基础上引入了视差边缘预测分支,用于预测边缘信息,并基于所预测的边缘信息引导视差估计主干网络的代价聚合阶段,削弱边缘处的代价体,以减少由于遮挡而造成的错误匹配计算,改善了边缘和遮挡区域匹配困难的问题,使得在复杂多变的环境下也能准确实现包括边缘和遮挡区域在内的匹配,有效提高双目立体视觉匹配的精度和可靠性。

46、(2)在本发明的优选方案中,本发明进一步基于视差边缘预测分支所预测的边缘信息引导视差估计主干网络的特征提取阶段,具体地,基于边缘信息对低尺度和高尺度特征分配权重进行融合,使得低尺度特征在边缘区域具有较高的权重,高尺度特征在非边缘区域具有较高的权重,由此加强边缘处的低尺度特征和非边缘处的高尺度特征,充分利用低尺度特征所携带的丰富的边缘信息,进一步提高边缘处的匹配精度。

47、(3)在本发明的优选方案中,对立体匹配网络进行训练时,先对其中的视差边缘预测分支进行训练,之后在训练好的视差边缘预测分支的基础上,完成视差估计主干网络的训练,由此能够利用准确的边缘信息指导视差估计主干网络的训练过程,提高训练效率。

- 还没有人留言评论。精彩留言会获得点赞!