一种基于先验知识的可控有损压缩后门攻击方法

本发明属于深度学习安全领域,具体涉及一种基于先验知识的可控有损压缩后门攻击方法。

背景技术:

1、深度学习(deep learning,dl)或机器学习(machine learning,ml)模型在近十年内被大量部署,代替人类在关键任务中做出决策,如计算机视觉,自然语言处理和访问控制等方面[1]。然而,已部署的ml系统存在现实的安全威胁问题,其中对输入的样本实施难以察觉的中毒操作可能会误导ml模型进行错误的分类[2]。

2、中毒攻击方法主要通过在数据集中嵌入隐含的触发器实现将后门植入到原始模型中,进而操纵模型的输出结果。最早的机器学习中毒攻击可以追溯到newsome等人[3]设计的用于误导恶意软件检测系统中的生成签名。该系统在训练阶段植入包含正面词汇的垃圾邮件,该操作成功误导了分类系统,使其在预测阶段将有效邮件错误地分类为垃圾邮件。

3、后门中毒攻击分为可见触发器与不可见触发器:可见与不可见的区别相对的主体是人类肉眼而不是机器视觉,一般定义为当两张图片放在一起时或出现一张自然图片时,通过人类肉眼不能或很难判断图像存在明显的异常像素块。现有的触发器研究趋势主要是由可见的、具有相同像素块的触发器到不可见的、样本特定像素块的触发器发展。

4、gu等人[2]提出了经典的badnets方法,这是第一个后门攻击,它揭示了外包训练可能会带来新的安全风险,即攻击者可以控制训练过程并创建一个恶意的训练模型。blended方法[4]是第一个不可见的攻击方法,其研究的中毒策略可以在弱威胁模型中应用,即攻击者可以不知道受害者使用的模型和数据集,且攻击者仅注入少量的中毒样本。turner等人[5]聚焦于后门中毒中的清洁标签问题,在基于badnets方法的基础上探究仅针对单个标签的中毒。

5、以上可见触发器虽然具有良好的攻击性能,但由于其可见性所以易被后门检查出,不具备隐蔽性。且turner[5]提出的清洁标签攻击在提高攻击性能的同时在隐蔽性上做出了极大牺牲。refool方法[6]提出了一种应用反射作为后门植入受害者模型,这是第一个具有可见但由自然触发的隐蔽性攻击。

6、参考文献如下:

7、[1]li y,jiang y,li z,et a1.backdoor learning:a survey[j].ieeetransactions on neural networks and learning systems,2022.

8、[2]gu t,dolan-gavitt b,garg s.badnets:identifying vulnerabilities inthe machine learning model supply chain[j].arxiv preprint arxiv:1708.06733,2017.

9、[3]newsome j,karp b,song d.paragraph:thwarting signature learning bytraining maliciously[c]//recent advances in intrusion detection:9thinternational symposium,raid 2006hamburg,germany,september 20-22,2006proceedings9.springer berlin heidelberg,2006∶81-105.

10、[4]chen x,liu c,li b,et a1.targeted backdoor attacks on deep learningsystems using data poisoning[j].arxiv preprint arxiv:1712.05526,2017.

11、[5]turner a,tsipras d,madry a.label-consistent backdoor attacks[j].arxiv preprint arxiv:1912.02771,2019.

12、[6]liu y,ma x,bailey j,et al.reflection backdoor:a natural backdoorattack on deep neural networks[c]//computer vision-eccv 2020∶16th europeanconference,glasgow,uk,august 23-28,2020,proceedings,part x 16.springerinternational publishing,2020:182-199.

技术实现思路

1、基于上述问题,本发明提出一种基于先验知识的可控有损压缩后门攻击方法,通过预训练干净模型得到每个样本的损失值作为先验知识,基于先验知识对干净图像样本进行有损压缩的后门植入,并将有损压缩作为图像后门攻击方法,使模型训练被中毒的数据集,达到了在干净的图像上正常工作,而在具有触发器的图像上产生预设的行为,具有后门不会干扰原始任务性能并能够准确的被触发,使模型按照攻击者设定的目标输出的优势,和得到一种灵活且不易被发现的深度学习攻击方法。

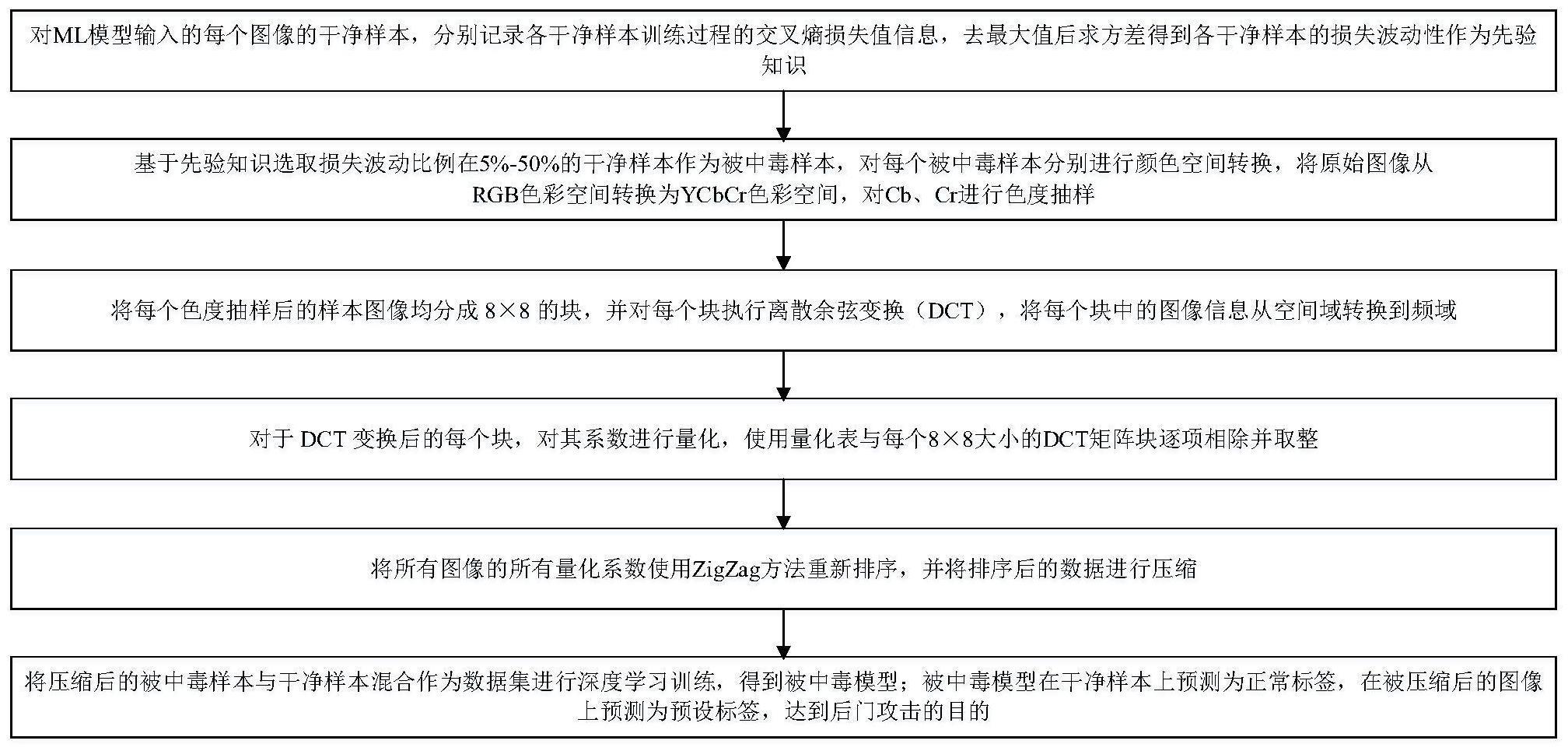

2、所述基于先验知识的可控有损压缩后门攻击方法,分以下步骤:

3、步骤一、对ml模型输入的每个图像的干净样本,分别记录各干净样本训练过程的交叉熵损失值信息,去最大值后求方差得到各干净样本的损失波动性作为先验知识。

4、交叉熵损失值为:

5、

6、其中c代表类别数,pi为第i类的真实概率,qi为第i类的预测概率。

7、第k个样本的方差为:

8、

9、训练过程的损失值数据为l1,l2,l3…ln;n为损失值个数;μ为损失值的平均数;

10、步骤二、基于先验知识选取损失波动比例在5%-50%的干净样本作为被中毒样本,对每个被中毒样本分别进行颜色空间转换,将原始图像从rgb色彩空间转换为ycbcr色彩空间,对cb、cr进行色度抽样。

11、对于三维通道rgb,将rgb值的范围从[0,255]转换为[0,1]:

12、r=r/255 g=g/255 b=b/255

13、其中y、cb、cr分量分别为:

14、y=0.299*r+0.587*g+0.114*b

15、cb=(b-y)/(2*(1-0.114))

16、cr=(r-y)/(2*(1-0.299))

17、步骤三、将每个色度抽样后的样本图像均分成8×8的块,并对每个块执行离散余弦变换(dct),将每个块中的图像信息从空间域转换到频域。

18、根据dct ii的公式,计算出每个块dct变换后的系数xk:

19、

20、n是所有8×8的块所有像素点的个数;xn是第n个点的像素值;k是dct变换的频率索引,取值范围是0到n-1的整数。对应于输出的频率系数,k=o代表直流分量(低频信息),k=1到n-1代表交流分量(高频信息)。

21、步骤四、对于dct变换后的每个块,对其系数进行量化,使用量化表与每个8×8大小的dct矩阵块逐项相除并取整。

22、标准亮度量化表qy和色度量化表qc如下:

23、

24、步骤五、将所有图像的所有量化系数使用zigzag方法重新排序,并将排序后的数据进行压缩;

25、压缩方法如下两种:

26、jpeg算法使用霍夫曼编码将数据压缩;

27、webp使用算术编码将数据压缩。

28、步骤六、将压缩后的被中毒样本与干净样本混合作为数据集进行深度学习训练,得到被中毒模型;被中毒模型在干净样本上预测为正常标签,在被压缩后的图像上预测为预设标签,达到后门攻击的目的。

29、本发明的优点在于:

30、(1)本发明一种基于先验知识的可控有损压缩后门攻击方法,利用先验知识来设计有损压缩后门,使得后门在未触发时难以被察觉。通过精心选择和设计有损压缩算法,后门可以在各种图像数据集中隐藏得非常隐蔽,从而提高攻击的成功率。

31、(2)本发明一种基于先验知识的可控有损压缩后门攻击方法,允许攻击者对后门进行精确控制。通过先验知识的应用,攻击者可以确定后门的触发条件和效果,这使得攻击者能够更好地控制后门的行为;例如,选择选定的压缩质量决定后门的输出结果。

32、(3)本发明一种基于先验知识的可控有损压缩后门攻击方法,由于基于先验知识的有损压缩后门攻击方法在设计上更精细,因此其攻击成功率相对较高。通过针对特定的应用场景和模型设计后门,攻击者可以有效地绕过模型的防御措施,成功地触发后门并实施攻击。

33、(4)本发明一种基于先验知识的可控有损压缩后门攻击方法,可以适用于多种类型的深度学习模型和数据。不同于一些依赖于模型结构或特定输入数据的后门攻击方法,基于先验知识的有损压缩后门攻击可以灵活地适用于各种应用场景和数据类型,增强了攻击的适用性和可扩展性。

- 还没有人留言评论。精彩留言会获得点赞!