一种基于不确定度的视点估计方法

本发明涉及计算机视觉领域,尤其涉及一种基于不确定度的视点估计方法。

背景技术:

1、人类视线蕴含着丰富的信息,视点是人体视线与所关注物体的相交点。视点估计是计算机视觉领域一个重要的研究课题,包含对人类注意力及场景信息的理解。视点估计在科学研究及商业应用都有着重要的应用价值,可应用于分析孤独症患儿的视觉注意力、在多人社交场景分析多人的视线行为活动、嵌入在机器人设备中分析用户的人机交互意图。

2、视点估计方法是一种对一张包含受试者和其所在场景的图像中估计受试者的注视点位置的方法。现有的视点估计方法主要流程为整张图像和受试者头部图像为输入数据,以受试者在图像中的二维坐标注视点为输出数据,以神经网络为映射模型,并利用梯度反向传播算法优化所建立的神经网络模型。现有的视线估计方法主要分为两类,一类是基于单帧图像的视点估计方法,即仅提取以单帧图像为单位提取特征,以预测受试者在当前帧图像中的视点输出,参考文献recasens,a.,khosla,a.,vondrick,c.,&torralba,a.(2015).where are they looking?.advances in neural information processingsystems,28.;另一类是基于多帧图像的视点估计方法,即以连续多帧图像为单位提取特征,以预测受试者在多帧图像中的视点输出,参考文献chong,e.,wang,y.,ruiz,n.,&rehg,j.m.(2020).detecting attended visual targets in video.in proceedings of theieee/cvf conference on computer vision and pattern recognition(pp.5396-5406)。

3、近年来,视点估计方法越来越成熟,但是只能输出预测值,不能输出预测值的不确定度,缺乏可解释性。

4、因此,本领域的技术人员致力于开发一种基于不确定度的视点估计方法

技术实现思路

1、有鉴于现有技术的上述缺陷,本发明所要解决的技术问题是现有技术中的视点估计方法只能输出预测值,不能输出预测值的不确定度。

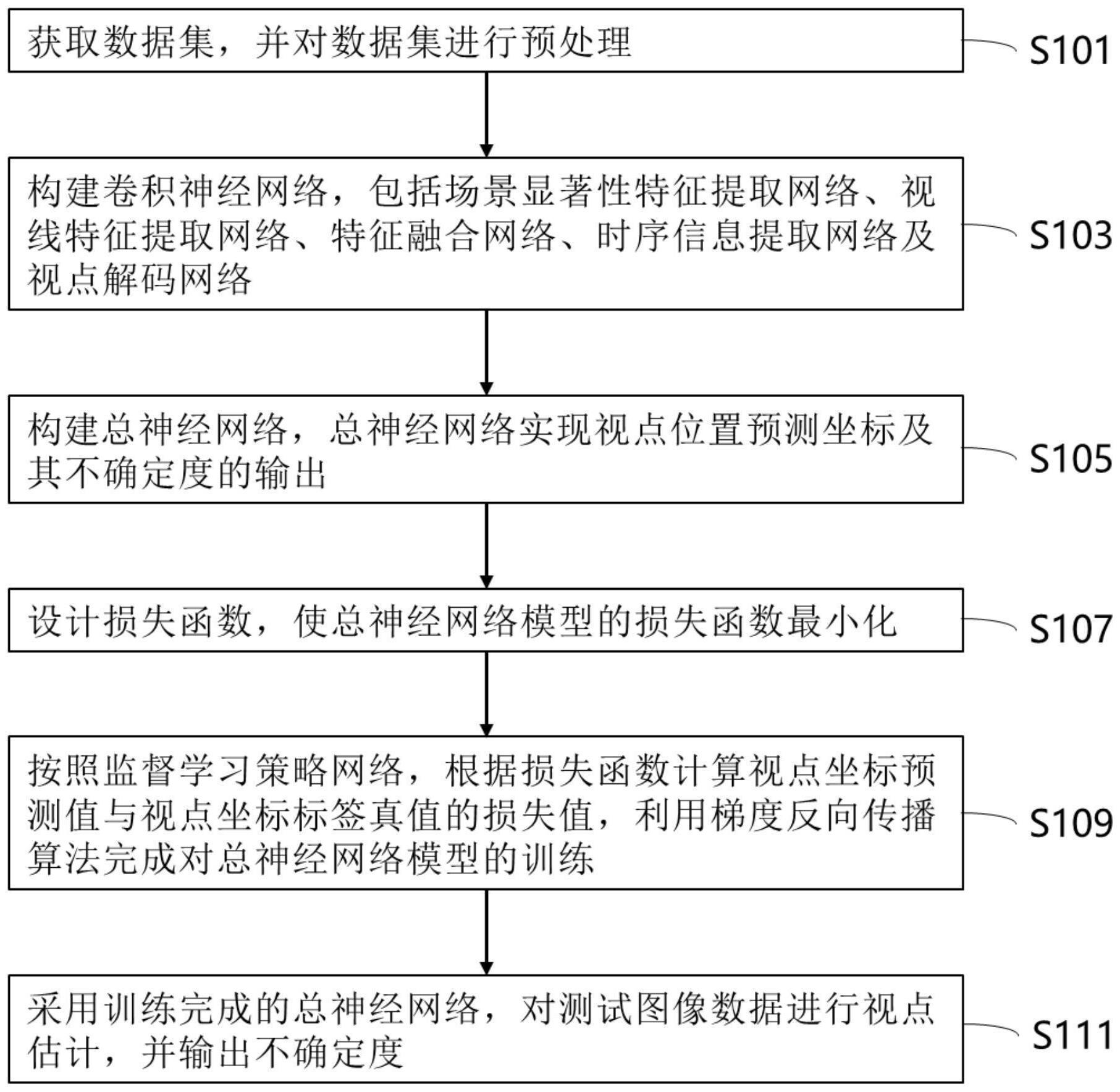

2、为实现上述目的,本发明提供了一种基于不确定度的视点估计方法,其特征在于,所述方法包括以下步骤:

3、s101:获取数据集,并对所述数据集进行预处理;

4、s103:构建卷积神经网络,所述卷积神经网络包括场景显著性特征提取网络、视线特征提取网络、特征融合网络、时序信息提取网络及视点解码网络;

5、s105:构建总神经网络,所述总神经网络实现视点位置预测坐标及其不确定度的输出;

6、s107:设计损失函数,使所述总神经网络模型的所述损失函数最小化;

7、s109:按照监督学习策略网络,根据所述损失函数计算视点坐标预测值与视点坐标标签真值的损失值,利用梯度反向传播算法完成对所述总神经网络模型的训练;

8、s111:采用训练完成的所述总神经网络,对测试图像数据进行视点估计,并输出不确定度。

9、进一步地,在所述步骤s101中,所述数据集包括训练数据,所述训练数据包括包含受试者的场景图像和标注信息,根据所述标注信息,对单帧整张场景图像中受试者人脸进行裁剪,并根据所述受试者人脸在所述整张场景图像中的位置,生成人脸位置二值掩码图像。

10、进一步地,所述步骤s101中对所述数据集进行预处理包括如下子步骤:

11、s1011:根据所述受试者人脸外接矩形框标注信息,对所述场景图像中的人脸图像进行裁剪;

12、s1012:根据所述受试者人脸在所述场景图像中的位置,生成人脸位置二值掩码图像;

13、s1013:将所述场景图像、所述人脸图像及所述人脸位置二值掩码图像的尺寸调整,并对图像像素值进行归一化处理。

14、进一步地,在步骤s1013中,所述场景图像、所述人脸图像及所述人脸位置二值掩码图像的尺寸调整至224×224,对图像像素值归一化至范围[-1,1]。

15、进一步地,所述步骤s103包括如下子步骤:

16、s1031:构建所述场景显著性特征提取网络,所述场景显著性特征提取网络由一个第一resnet-50卷积神经网络和两个瓶颈层构成;

17、s1032:构建所述视线特征提取网络,所述视线特征提取网络由一个第二resnet-50卷积神经网络和两个瓶颈层构成;

18、s1033:构建所述特征融合网络,所述特征融合网络由两个卷积层、两个批归一化层和relu激活函数构成;

19、s1034:构建不确定度提取网络,所述不确定度提取网络由两个池化层、一个线性层、一个sigmoid激活函数构成,所述不确定度提取网络的输出为不确定度;

20、s1035:构建所述视点解码网络,所述视点解码网络由两个池化层、一个线性层、一个sigmoid激活函数构成,所述视点解码网络的输出为视点位置预测坐标。

21、进一步地,所述场景显著性特征提取网络的输入数据为预处理后的所述场景图像与所述人脸位置二值掩码图像沿通道方向叠加后的数据,所述输入数据先经过所述第一resnet-50卷积神经网络的处理,然后再依次由两个瓶颈层处理,所述场景显著性特征提取网络的输出为场景显著性特征fs,所述第一resnet-50卷积神经网络的输入维度为224×224×4。

22、进一步地,所述视线特征提取网络的输入数据为预处理后的所述人脸图像数据,所述输入数据先经过所述第二resnet-50卷积神经网络的处理,然后再依次由两个瓶颈层处理,所述视线特征提取网络的输出为视线特征fg,所述第二resnet-50卷积神经网络的输入维度为224×224×3。

23、进一步地,所述特征融合网络的输入为所述场景显著性特征fs与所述视线特征fg沿通道方向叠加后的特征向量,所述特征融合网络的输出为融合特征ff。

24、进一步地,所述总神经网络包括所述场景显著性特征提取网络、所述视线特征提取网络、所述特征融合网络、所述不确定度提取网络和所述视点解码网络,所述总神经网络将所述特征融合向量ff分别输入所述不确定度提取网络和所述视点解码网络,分别获得所述不确定度和所述视点坐标预测值

25、进一步地,所述损失函数为:

26、

27、其中,i为样本序号,n为样本个数,yi为第i个样本的视点坐标标签真值,为总神经网络对第i个样本的视点坐标预测值,为总神经网络输出的第i个样本的不确定度,为yi与的欧几里得范数。

28、在本发明的较佳实施方式中,本发明和现有技术相比,具有如下有益效果:

29、1、本发明提出了不确定度提取网络,输出模型对样本的不确定度,以表示模型对该样本的视点坐标预测值的确定程度;

30、2、本发明通过提出的不确定度提取网络,以融合特征为输入,输出不确定度。所设计损失函数添加了优化不确定度提取网络;

31、3、对于给定的一张包含人及周围信息的场景图片,本发明可以输出该人的注视点坐标,并且可以输出不确定度。

32、以下将结合附图对本发明的构思、具体结构及产生的技术效果作进一步说明,以充分地了解本发明的目的、特征和效果。

- 还没有人留言评论。精彩留言会获得点赞!