基于全局一致性与WGAN-GP的自适应纹理增强方法

本发明涉及图像处理领域,具体涉及基于全局一致性与wgan-gp的自适应纹理增强方法。

背景技术:

1、纹理在图像处理领域具有重要的应用价值,纹理能够提供额外的信息,丰富图像内容,使图像更具视觉吸引力和表现力,为了提升图像中的纹理细节和质量,研究人员提出了各种纹理增强方法,纹理增强是一项重要的任务,旨在提升图像中的纹理细节和质量,使图像更加清晰、自然和具有良好的视觉效果。

2、目前基于深度学习的纹理增强方法大多采用生成对抗网络(gan),gan是一种无监督学习方法,不需要事先标注的训练数据,而是通过最大化生成器和判别器之间的对抗目标函数来进行训练。生成器负责生成逼真的数据样本,而判别器则用于评估生成样本与真实样本之间的差异。通过迭代训练生成器和判别器,gan能够逐渐提高生成器生成逼真样本的能力。

3、现有技术中存在训练卷积神经网络来提取和增强图像中的局部纹理特征的方法,网络结构采用了多层卷积和池化层,以捕捉不同尺度和层次的局部特征。通过对训练数据进行大规模的学习,网络能够自适应地学习和增强图像中的局部纹理,但这种纹理增强方法往往只关注图像中的局部纹理特征,而忽视了全局上下文信息,这导致增强后的图像可能出现纹理不连贯或不自然的情况,特别是在存在纹理重复或纹理边缘处。

4、现有技术中还存在采用gan进行水下图像增强的方法,通过多尺度密集块(msdb)与残差学习相结合可以提高网络性能,且多项损失函数可以产生视觉上令人愉悦的增强效果,但这种方法缺乏对不同类型纹理的自适应性,这导致它们无法有效处理不同类型的纹理,限制了其应用的广泛性,且gan方法在训练过程中还存在梯度消失和模型崩溃等问题。

5、目前纹理增强的方法仍有缺陷,本发明旨在设计基于全局一致性与wgan-gp的自适应纹理增强方法,通过考虑全局信息和使用wgan-gp方法,以提高纹理增强效果的连贯性、自然性和适应性,该方法克服传统纹理增强方法的局限性,并在实际应用中具有广泛的应用潜力。

技术实现思路

1、本发明目的:在于提供基于全局一致性与wgan-gp的自适应纹理增强方法,以提高纹理增强效果的连贯性、自然性和适应性。

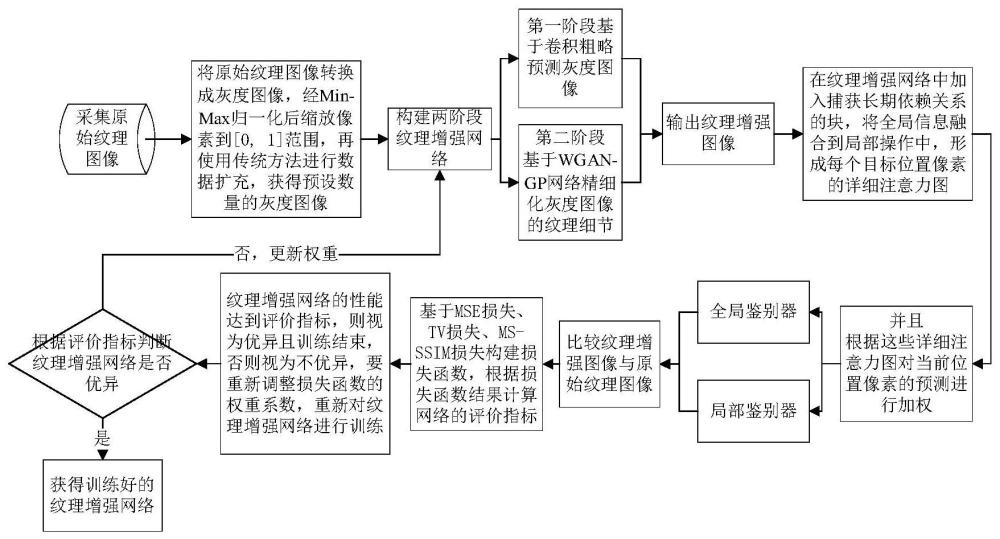

2、为实现以上功能,本发明设计基于全局一致性与wgan-gp的自适应纹理增强方法,执行如下步骤s1-步骤s5,构建并训练纹理增强网络,完成对输入纹理图像的增强:

3、步骤s1:采集原始纹理图像,将原始纹理图像转换成灰度图像,经min-max归一化后缩放像素到[0,1]范围,再使用传统方法进行数量扩充,获得预设数量的灰度图像;

4、步骤s2:构建两阶段的纹理增强网络,第一阶段基于卷积粗略预测灰度图像,第二阶段基于wgan-gp网络精细化灰度图像的纹理细节;纹理增强网络以步骤s1所获得的灰度图像为输入,输出纹理增强图像;

5、步骤s3:在纹理增强网络中加入捕获长期依赖关系的块,将全局信息融合到局部操作中,形成每个目标位置像素的详细注意力图,并且根据这些详细注意力图对当前位置像素的预测进行加权,使用全局鉴别器和局部鉴别器比较纹理增强图像与原始纹理图像;

6、步骤s4:对纹理增强网络进行训练,基于mse距离、tv损失、ms-ssim损失构建损失函数,根据损失函数的结果计算纹理增强网络的评价指标;

7、步骤s5:纹理增强网络的性能达到评价指标,则视为优异且训练结束,否则视为不优异,要重新调整损失函数的权重系数,重新对纹理增强网络进行训练;根据评价指标判断纹理增强网络是否优异,是则获得成功的纹理增强网络,否则更新权重系数。

8、作为本发明的一种优选技术方案:步骤s1中数量扩充的方法为分别将各灰度图像以90°、180°、270°旋转,然后逐个翻转,以将灰度图像数量增加8倍,获得输入纹理增强网络的训练样本。

9、作为本发明的一种优选技术方案:步骤s2中所述的两阶段的纹理增强网络,第一阶段经过下采样层卷积及池化以捕获全局特征,多个中间卷积层来处理特征图,上采样层转置卷积或最近邻插值以提高空间分辨率,得到粗略预测的纹理增强图像;第二阶段wgan-gp网络的函数方程如下式:

10、

11、其中,l是函数输出结果,e表示对应的期望值,sr是真实样本,pg是生成器生成分布,d(sr)是判别器对sr的输出,sf是虚假样本,pr是真实数据分布,d(sf)是判别器对sf的输出,λ是正则化的系数,是真实分布和生成分布中的样本,是对sr的梯度,||·||2是的范数。

12、作为本发明的一种优选技术方案:步骤s3中向纹理增强网络的第一阶段加入两个nl块,nl块计算目标位置像素与所有其他位置像素的相似性的注意力图,然后根据相似性的大小对重要性进行加权,nl块的具体计算如下:

13、

14、其中,yi表示nl块在目标位置像素i的计算结果,c(x)表示归一化因子,x表示纹理增强图像处理的特征图,j表示xi所有可能关联到位置的索引,f是位置间的类同标量函数,xi为目标位置像素i的特征值,xj为可能关联位置像素j的特征值,g是位置输入信号函数,对输入的特征进行赋权,g(xj)为用于计算xj的函数;

15、向纹理增强网络的第二阶段加入两个gc块构成判别器,gc块的具体计算如下:

16、

17、其中,zi表示gc块在目标位置像素i的计算结果,f(.,.)表示fusion函数,x表示纹理增强图像处理的特征图,i表示目标位置像素,δ(·)表示瓶颈变换模块,np表示全局空间,j表示xi所有可能关联到位置的索引,αj表示全局注意力池的权重,用于对上下文建模中的xj进行加权,xj为可能关联位置像素j的特征值。

18、作为本发明的一种优选技术方案:步骤s4中对纹理增强网络的训练分为两个训练步骤,第一训练步骤只训练纹理增强网络,第二训练步骤训练纹理增强网络和对抗性网络;在第一训练步骤中,损失函数选择mse损失和tv损失来联合约束结果的准确性,第二训练步骤涉及纹理增强网络和对抗性网络,纹理增强网络的损失函数采用l1距离和ms-ssim损失,对抗性网络的损失函数采用带梯度惩罚的wasserstein距离作为规范;第一训练步骤中使用的损失函数为:

19、loss_cn1=λ1×l2+(1-λ1)×ltv

20、其中,loss_cn1表示第一训练步骤损失的值,λ1是用于分配loss_cn1两个损失函数l2和ltv权重的系数,是[0,1]之间的一个随机数,l2是mse损失,ltv是tv损失;

21、第二训练步骤中,纹理增强网络的损失函数的计算公式为:

22、loss_cn2=λ2×l1+(1-λ2)×lms-ssim

23、其中,loss_cn2是第二训练步骤损失的值,λ2是用于分配loss_cn2两个损失函数l1和lms-ssim权重的系数,是[0,1]之间的一个随机数,l1是l1范数损失函数,lms-ssim为多尺度结构相似性。

24、作为本发明的一种优选技术方案:步骤s4中对纹理增强网络的训练采用adam优化器。

25、作为本发明的一种优选技术方案:步骤s5中的评价指标包括ssim、psnr。

26、有益效果:相对于现有技术,本发明的优点包括:

27、1.提出了一种新的基于非局部操作的全局上下文建模模型,该模型能够更好地捕捉图像中的全局信息,有效地利用全局上下文来指导纹理增强过程;

28、2.将wgan-gp应用于纹理增强中,比原始gan模型更稳定的训练过程,并采用了多种形式的损失函数来获得更快速的收敛。

- 还没有人留言评论。精彩留言会获得点赞!