一种基于知识辅助的对话文本关系抽取方法

本发明涉及人工智能,特别地,涉及一种基于知识辅助的对话文本关系抽取方法。

背景技术:

1、近年来,随着互联网、智能手机以及通信技术的普及,现代社会已经进入信息化时代。互联网产生了海量的信息与数据,人们希望快速且准确地获取重要的信息,因此知识图谱技术应运而生。知识图谱是一种信息检索技术,其中关系抽取则是知识图谱构建的重要组成。文献调研表明,现有关系抽取技术大多基于句子以及书面文档中的实体进行关系抽取,而针对对话文本的关系抽取研究不多。实际上,对话文本的数量远超于句子以及书面文档。随着人工智能技术的演进,基于chatgpt及相关大模型的人机交互将产生大量的对话文本。对话文本包含大量的关系事实。因此对话文本关系抽取将有助于知识图谱构建、人机问答、思维链(chain-of-thought)、多轮人机对话等智能系统的提升。

2、目前,对话文本存在信息密度低,口语化程度高等特点。因此,对话文本关系抽取模型往往捕获无关的信息,难以关注有效的信息,最终导致模型性能低。该问题难以解决。近年来,有很多研究工作尝试解决,但是均为取得良好的效果。关系抽取的目的是从一段文本中抽取两个指定实体之间的关系,这段文本可以是一个句子、一篇文章或一段对话等等。在对话文本关系抽取中,假设输入的对话文本表示为d=s1:u1,s2:u2…sm:um,其中si和ui分别表示第i轮对话的说话人和对应的语句,m是对话的轮数,给定对话中的两个实体为a=(a1,a2),对话关系抽取的任务是从预定义的关系集合r中预测实体对(a1,a2)之间的关系r。

3、如图2所示,对话文本关系抽取旨在从对话文本中判断两个实体之间的关系类型。例如,实体“弗兰克”和实体“s2”是兄弟姐妹关系,实体“s2”和实体“菲比”是别名关系。由图2可以发现,对话文本的信息密度上述对话一共有7轮,只有2轮对关系抽取有帮助。而在这2轮对话中,最重要的信息则是触发词。比如在“弗兰克”和s2的关系抽取中,其中“弟弟”是触发词,表明了两个实体是兄弟姐妹的关系。因此,触发词信息量丰富,为实体之间的关系类型预测提供了重要的线索,起到了决定性的作用。在实际应用中,只有训练集才能获取触发词信息。因此,如何充分利用训练集中的触发词信息对于对话文本的关系抽取非常重要。

4、对此,lin等人[1]提出了一种基于触发词增强的对话关系抽取模型trend,如图3所示。该模型的流程如下:1)采用图中的explicit trigger gate(显式触发词门控模块)来预测对话文本是否存在触发词;2)若存在触发词,则通过trigger prediction(触发词文本预测模块)来预测触发词在文本中的位置,并将预测到的触发词特征与上下文特征(context vector)融合,3)最后使用融合后的特征来进行关系预测。

5、背景技术存在的主要问题是:现有的触发词辅助的对话关系抽取模型具有三个缺点:1)现有技术在利用触发词时,需要使用触发词抽取模块来识别对话文本中的触发词,然后再将触发词与上下文特征融合,使用融合后的特征辅助关系抽取。该方法无法确保触发词抽取结果完全准确,而错误的触发词会带来噪声,影响模型的性能。2)该方法在推理阶段也需要使用触发词抽取模块来抽取触发词,而这个模块需要大量计算时间,导致模型整体推理效率低。3)该方法忽略了标签语义知识。

6、解决上述问题的困难为:现有技术一般将标签编码为独热(one hot)向量,然后通过模型得到关系类别的概率分布,最后计算二者的交叉熵损失。该方式将每一种类别看作相互独立的向量,没有考虑到类别之间的相关性。比如说“校友”与“同学”含有相似的语义,在语义空间的距离较近,而“校友”与“父母”的关系较远。这些关系的相关性反映出每一种关系的标签文本都蕴涵丰富的语义知识,这类方法忽略了这些知识,造成模型性能受限。

7、解决上述技术问题的意义为:可以提升了对话关系抽取的性能以及推理效率,满足了构建特定领域的知识图谱以及提升对话系统性能的需求。

技术实现思路

1、本发明提供了一种基于知识辅助的对话文本关系抽取方法,本发明方法提升了模型对于触发词知识和标签语义知识的利用率,提升了对话关系抽取的性能以及推理效率,满足了构建特定领域的知识图谱以及提升对话系统性能的需求。

2、本发明的技术方案如下:

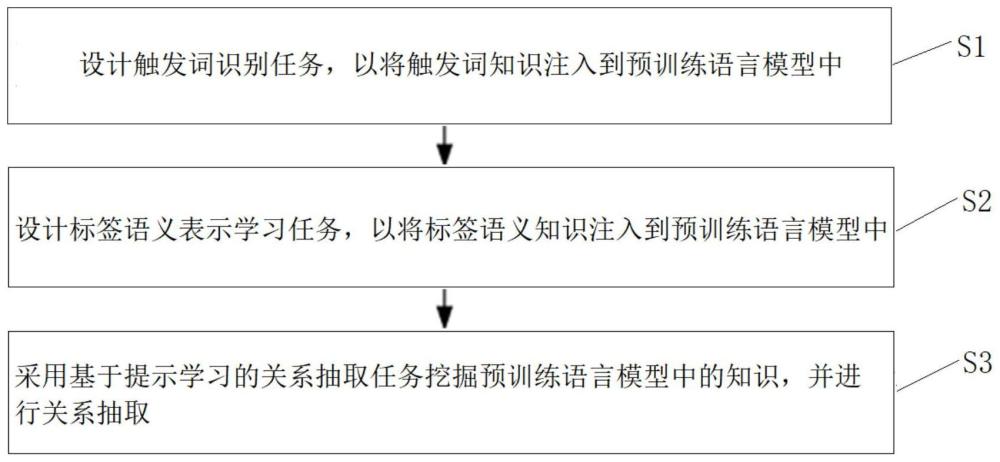

3、本发明的基于提示学习的知识增强对话关系抽取方法,包括以下步骤:s1.设计触发词识别任务,以将触发词知识注入到预训练语言模型中;s2.设计标签语义表示学习任务,以将标签语义知识注入到预训练语言模型中;以及s3.采用基于提示学习的关系抽取任务挖掘预训练语言模型中的知识,并进行关系抽取。

4、可选地,在上述基于提示学习的知识增强对话关系抽取方法中,在步骤s1中,触发词识别任务在训练阶段将对话文本中的触发词使用[mask]符号代替,并预测真实的触发词,使模型学习触发词的知识。

5、可选地,在上述基于提示学习的知识增强对话关系抽取方法中,首先对输入文本进行预处理:若训练样本实体对(a1,a2)存在触发词,则将触发词单词用[mask]符号替代;若该实体对不存在触发词,则随机选择输入的对话文本d中的10%的单词用[mask]符号代替,

6、按上述方法处理对话文本d,得到dmlm,得到掩码语言模型输入2:

7、xmlm=[[cls],dmlm,[sep],a1,ytext,a2]

8、其中,ytext表示关系标签文本,在训练时,使用预训练语言模型预测[mask]位置的真实词语,并使用负对数似然损失函数作为该任务的损失函数:

9、

10、其中m是被遮蔽的词的集合,|v|是词表大小,θ为预训练语言模型的参数,m表示[mask]字符的概率分布。

11、可选地,在上述基于提示学习的知识增强对话关系抽取方法中,在步骤s2中,使用预训练语言模型中的未使用词作为标签词,使用标签文本的特征进行初始化。

12、可选地,在上述基于提示学习的知识增强对话关系抽取方法中,在步骤s2中,对于每一种关系类型r,假设其文本为t,则该关系的标签词初始权重计算方式如下:

13、

14、其中,w表示预训练语言模型的词嵌入层的权重,k表示标签文本的长度,

15、标签语义表示学习任务的的输入由对话文本以及模板拼接构成,模板如下:

16、z=[t1]a1[t2][mask][t3]a2[t4]

17、其中,a1和a2表示有语义关系的两个实体,而[t1]、[t2]、[t3]和[t4]为可训练的提示字符,[mask]是遮蔽符号。

18、可选地,在上述基于提示学习的知识增强对话关系抽取方法中,对于监督对比学习,给定输入样本x={x1,x2,…,xn}以及对应的标签y={y1,y2,…,yn},n表示批大小,监督对比学习的损失函数如下式所示:

19、

20、其中,hi(i∈{1,2,…,n})是输入文本xi的[mask]字符在投影空间的嵌入向量,hi·hj表示hi和hj的内积,hi(i∈{1,2,…,n})是被标准化的特征,内积相当于向量的余弦相似度;τ表示温度系数,用于控制训练时的平滑度和困难样本的区分性。

21、可选地,在上述基于提示学习的知识增强对话关系抽取方法中,在步骤s3中,基于提示学习的关系抽取任务,包括以下步骤:

22、1)文本预处理:假设输入的对话文本为d=s1:u1,s2:u2,…,sm:um,其中si和ui分别表示第i轮对话的说话人和对应的语句,m是对话的轮数,实体对为a=(a1,a2),首先根据对话文本d构建文本

23、

24、其中,[s1]和[s2]是两个新引入的特殊标记,表示说话人实体;

25、2)模板构建:在对话文档的基础上添加提示文本z,其构建方式如下:

26、z=[t1]a1[t2][mask][t3]a2[t4]

27、其中,a1和a2表示有语义关系的两个实体,而[t1]、[t2]、[t3]和[t4]为可训练的提示字符,[mask]是在掩码语言模型中常用的遮蔽符号,在此处用于关系抽取任务;

28、3)输入构建:最终预训练语言模型的输入序列由对话文本和提示文本z拼接得到:

29、x1=[cls]d[sep][t1]a1[t2][mask][t3]a2[t4][sep]

30、其中,[cls]和[sep]分别为预训练语言模型的开始符和分隔符;

31、4)标签词映射:当提示文本x1输入到预训练语言模型后,预训练语言模型可以通过[mask]的概率分布计算关系类型的概率分布:

32、p(r|x1)=softmax(p([mask]=vi|x1)))(1≤i≤n)

33、其中,vi是关系类型i的标签词,n是关系类型数量。

34、根据本发明的技术方案,产生的有益效果是:

35、本发明的基于提示学习的知识增强对话关系抽取方法,提升了模型对于触发词知识和标签语义知识的利用率,提升了对话关系抽取的性能以及推理效率,满足了构建特定领域的知识图谱以及提升对话系统性能的需求;本发明方法也可以迁移至其他关系抽取领域,比如文档关系抽取;本发明的监督对比学习可以扩展为对比学习。

36、为了更好地理解和说明本发明的构思、工作原理和发明效果,下面结合附图,通过具体实施例,对本发明进行详细说明如下:

- 还没有人留言评论。精彩留言会获得点赞!