模型训练方法、下游任务的处理方法及装置、和电子设备与流程

本技术涉及自然语言处理,具体涉及一种模型训练方法、下游任务的处理方法及装置、和电子设备。

背景技术:

1、相关技术中,在nlp(natural language processing,自然语言处理)领域中,预训练语言模型在多项nlp任务上都表现出极佳的效果,例如,roberta模型通过自我监督的方式,在大规模文本语料上进行预训练,从中学习得到丰富的上下文表示。然而,对于一些存在多义词、上下文语义不完整等的语料,模型的识别准确度并不高,影响用户的体验。

技术实现思路

1、本技术的目的之一在于提供一种模型训练方法,以解决相关技术中模型对存在多义词、语义不完整的语料的识别准确度不高的问题;目的之二在于提供一种下游任务的处理方法;目的之三在于提供一种模型训练装置;目的之四在于提供一种下游任务的处理装置;目的之五在于提供一种电子设备;目的之六在于提供一种计算机可读存储介质。

2、为了实现上述目的,本技术提供一种模型训练方法,采用的技术方案如下:

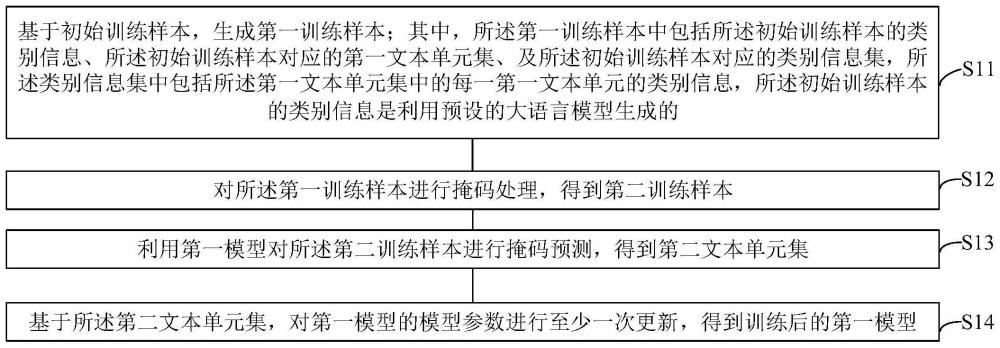

3、基于初始训练样本,生成第一训练样本;其中,所述第一训练样本中包括所述初始训练样本的类别信息、所述初始训练样本对应的第一文本单元集、及所述初始训练样本对应的类别信息集,所述类别信息集中包括所述第一文本单元集中的每一第一文本单元的类别信息,所述初始训练样本的类别信息是利用预设的大语言模型生成的;

4、对所述第一训练样本进行掩码处理,得到第二训练样本;

5、利用第一模型对所述第二训练样本进行掩码预测,得到第二文本单元集;

6、基于所述第二文本单元集,对第一模型的模型参数进行至少一次更新,得到训练后的第一模型。

7、根据上述技术手段,一方面,通过大语言模型生成初始训练样本的类别信息,在提升了类别信息的准确度的同时还提升了生成效率;另一方面,通过在样本中引入各个文本单元的类别信息对模型的整体网络结构进行训练,不仅可以增强模型的鲁棒性和提高模型的性能,而且可以学习到文本单元的类别信息和上下文之间的关联,能够更好地理解文本单元的语义,使得训练后的模型能够对各种语料(例如,存在多义词、语义不完整的语料)进行精准识别,从而提升用户的体验。

8、进一步,所述基于所述第二文本单元集,对第一模型的模型参数进行至少一次更新,得到训练后的第一模型,包括:基于所述第一文本单元集和所述第二文本单元集,确定损失值;基于所述损失值,对所述第一模型的模型参数进行更新,得到更新后的第一模型;在不满足训练结束条件的情况下,基于所述更新后的第一模型,确定所述训练后的第一模型;在满足所述训练结束条件的情况下,将所述更新后的第一模型作为所述训练后的第一模型。

9、根据上述技术手段,通过第二文本单元集确定损失值后对模型进行更新,可以提高训练后的模型对于同一样本预测的一致性,使得训练后的模型能够更加准确的对各种语料(例如,存在多义词、语义不完整的语料)进行精准识别。

10、进一步,所述基于初始训练样本,生成第一训练样本,包括:利用包含预设的信息集的分词模型,对所述初始训练样本进行分词处理,得到所述第一文本单元集和所述类别信息集;其中,所述信息集中包括至少一个文本单元及每一所述文本单元的类别信息,所述信息集是利用所述大语言模型生成的;基于所述第一文本单元集、所述初始训练样本的类别信息及所述类别信息集,生成所述第一训练样本。

11、根据上述技术手段,一方面,通过大语言模型生成信息集,在提升了信息集的准确度的同时还提高了生成效率;另一方面,通过将信息集作为分词模型的词典库,不仅提升了分词结果的准确度,而且使得分词后的每个文本单元均具有类别信息,缩短了文本单元的类别信息的确定时长和提升了类别信息的准确度。

12、进一步,所述对所述第一训练样本进行掩码处理,得到第二训练样本,包括:按照预设的掩码策略,分别对所述第一文本单元集和所述类别信息集进行掩码处理,得到所述第二训练样本;其中,所述第一文本单元集的掩码策略不同于所述类别信息集的掩码策略。

13、根据上述技术手段,一方面,通过文本单元集的掩码策略对文本单元集进行掩码处理,让模型学习理解语料中的上下文信息;另一方面,通过该掩码策略对类别信息集进行掩码,以增强模型对短语类别的识别能力,从而可以让模型学习到文本单元的类别信息和上下文之间的关联。

14、进一步,所述第一文本单元集的掩码策略包括以下至少之一:随机掩码第二文本单元集中的部分第一文本单元、将所述第二文本单元集中的部分第一文本单元替换为对应的短语,其中,所述第二文本单元集是从所述第一文本单元集中选择的;所述类别信息集的掩码策略包括以下之一:掩码所述类别信息集、掩码所述第二文本单元集中的部分第一文本单元的类别信息。

15、根据上述技术手段,通过不同的掩码策略对文本单元集和类别信息集进行掩码,可以增强模型的短语理解能力,防止模型过度依赖该类别,从而达到让模型学习到文本单元的类别信息和上下文之间的关联的目的。

16、进一步,所述利用第一模型对所述第二训练样本进行掩码预测,得到第二文本单元集,包括:利用所述第一模型的嵌入层对所述第二训练样本进行词嵌入处理,得到所述第二训练样本的嵌入向量表示;其中,所述嵌入向量表示包括词嵌入表示、类别嵌入表示和位置嵌入表示;利用所述第一模型的编码层对所述嵌入向量表示进行编码处理,得到具有上下文表示的编码向量;利用所述第一模型的输出层,基于所述编码向量,确定所述第二文本单元集。

17、根据上述技术手段,通过对嵌入层进行结构修改以嵌入文本单元的类别信息,使得模型可以学习到文本单元的类别信息和上下文之间的关联,从而使得训练后的模型能够更加准确的对各种语料(例如,存在多义词、语义不完整的语料)进行精准识别。

18、进一步,所述方法还包括:基于初始语料库,生成预训练语料库;其中,所述初始语料库包括基础类别的第一语料库和车载类别的第二语料库;基于所述预训练语料库,构建训练样本集;其中,所述训练样本集中包括所述初始训练样本。

19、根据上述技术手段,一方面,通过构建不同类别的语料库,可以提升语料的全面性;另一方面,通过该预训练语料库构建训练样本集,使得训练样本集中包括正负样例,从而可以提升模型的泛化能力。

20、进一步,所述基于初始语料库,生成预训练语料库,包括:针对所述第二语料库中的每一第一语料,利用所述大语言模型,基于第一语料,生成至少一条第二语料,将每一所述第二语料分别作为所述第二语料库中的一条语料,每一所述第二语料与所述第一语料之间的相似度满足预设条件。

21、根据上述技术手段,通过大语言模型在车载数据的基础上构建了一批数据,不仅增加了数据的多样性和全面性,而且还提升了数据的构建效率。

22、进一步,所述基于所述预训练语料库,构建训练样本集,包括:针对所述预训练语料库中的每一语料,利用所述大语言模型,基于预设的语料类别提示信息集,确定所述语料的类别信息,基于预设的短语类别提示信息集,确定所述语料中每一文本单元的类别信息,并基于所述语料的类别信息和所述语料中每一文本单元的类别信息,确定所述语料的标签类别信息;按照预设的选取比例,将所述预训练语料库划分为第一预训练语料库和第二预训练语料库;对所述第二预训练语料库中的每一语料的标签类别信息进行修改,得到修改后的第二预训练语料库;基于所述第一预训练语料库和所述修改后的第二预训练语料库,构建训练样本集。

23、根据上述技术手段,一方面,通过大语言模型对语料进行预处理,得到语料的标签类别信息,缩短了标签类别信息的获取时长,提升了准确度;另一方面,通过构建正负样例的语料,可以提升模型的泛化能力。

24、进一步,所述对所述第二预训练语料库中的每一语料的标签类别信息进行修改,得到修改后的第二预训练语料库,包括:按照预设的修改比例,将所述第二预训练语料库划分为第三预训练语料库和第四预训练语料库;对所述第三预训练语料库中的每一语料的标签类别信息进行修改,得到修改后的第三预训练语料库;删除所述第四预训练语料库中的每一语料的标签类别信息,得到修改后的第四预训练语料库;基于所述修改后的第三预训练语料库、及所述修改后的第四预训练语料库,得到所述修改后的第二预训练语料库。

25、根据上述技术手段,通过随机修改或删除语料的标签类别信息以得到预设数量的负样例,以提升模型的泛化能力。

26、进一步,所述方法还包括:基于所述预训练语料库中的每一语料中每一文本单元的类别信息,构建信息集。

27、根据上述技术手段,一方面,通过大语言模型对语料的各个文本单元进行标注,不仅缩短了标注时长、提升了标注效率,而且还降低了标注成本;另一方面,通过预先构建信息集,以将该信息集作为分词模型的词典库,不仅可以提高后续分词结果的准确度,而且使得分词后的每个文本单元均具有类别信息。

28、一种下游任务的处理方法,该方法包括:

29、基于目标模型,确定处理下游任务的初始的第二模型;其中,所述下游任务包括以下之一:分类、实体识别,所述目标模型是通过上述任一项所述的方法得到的第一模型;

30、通过所述下游任务对应的训练样本集,对所述第二模型进行微调,得到训练后的第二模型;

31、利用所述训练后的第二模型,对待处理语料进行处理,得到处理结果。

32、根据上述技术手段,首先,通过大语言模型生成初始训练样本的类别信息,在提升了类别信息的准确度的同时还提升了生成效率;其次,通过在样本中引入各个文本单元的类别信息对模型的整体网络结构进行训练,不仅可以增强模型的鲁棒性和提高模型的性能,而且可以学习到文本单元的类别信息和上下文之间的关联,能够更好地理解文本单元的语义,使得训练后的模型能够对各种语料(例如,存在多义词、语义不完整的语料)进行精准识别,从而提升用户的体验;最后,根据下游任务的需求对训练后的模型进行适应性调整,使得调整后的模型可以根据类别信息更好地识别不同类别的实体,从而提升任务的准确性,使得模型具有更高的可扩展性和可维护性。

33、一种模型训练装置,该装置包括:

34、生成模块,用于基于初始训练样本,生成第一训练样本;其中,所述第一训练样本中包括所述初始训练样本的类别信息、所述初始训练样本对应的第一文本单元集、及所述初始训练样本对应的类别信息集,所述类别信息集中包括所述第一文本单元集中的每一第一文本单元的类别信息,所述初始训练样本的类别信息是利用预设的大语言模型生成的;

35、掩码模块,用于对所述第一训练样本进行掩码处理,得到第二训练样本;

36、预测模块,用于利用第一模型对所述第二训练样本进行掩码预测,得到第二文本单元集;

37、更新模块,用于基于所述第二文本单元集,对第一模型的模型参数进行至少一次更新,得到训练后的第一模型。

38、一种下游任务的处理装置,所述装置包括:

39、确定模块,用于基于目标模型,确定处理下游任务的初始的第二模型;其中,所述下游任务包括以下之一:分类、实体识别,所述目标模型是通过上述任一项所述的方法得到的第一模型;

40、微调模块,用于通过所述下游任务对应的训练样本集,对所述第二模型进行微调,得到训练后的第二模型;

41、处理模块,用于利用所述训练后的第二模型,对待处理语料进行处理,得到处理结果。

42、一种电子设备,包括处理器和存储器,所述存储器存储有可在处理器上运行的计算机程序,所述处理器执行所述计算机程序时实现上述任一项所述方法。

43、一种计算机可读存储介质,其上存储有计算机程序,该计算机程序被处理器执行时实现上述任一项所述方法。

44、本技术的有益效果:

45、(1)本技术通过大语言模型,基于真实数据集构建预训练语料库,不仅降低了人工标注的成本,而且由于真实数据包含了多种类别的语料,因此,提升了语料的准确度和全面性。

46、(2)本技术通过构建正负样例的训练样本集,可以提升模型的泛化能力。

47、(3)本技术通过大语言模型生成初始训练样本的类别信息及每一初始训练样本中各个文本单元的类别信息,在提升了类别信息的准确度的同时还提升了生成效率。

48、(4)本技术通过将大语言模型生成的信息集作为分词模型的词典库,不仅提升了分词结果的准确度,而且使得分词后的每个文本单元均具有类别信息,缩短了文本单元的类别信息的确定时长和提升了类别信息的准确度。

49、(5)本技术通过不同的掩码策略对文本单元集和类别信息集进行掩码,可以增强模型的短语理解能力,防止模型过度依赖该类别,从而达到让模型学习到文本单元的类别信息和上下文之间的关联的目的。

50、(6)本技术通过在样本中引入各个文本单元的类别信息对模型的整体网络结构进行训练,不仅可以增强模型的鲁棒性和提高模型的性能,而且可以学习到文本单元的类别信息和上下文之间的关联,能够更好地理解文本单元的语义,使得训练后的模型能够对各种语料(例如,存在多义词、语义不完整的语料)进行精准识别,从而提升用户的体验。

51、(7)本技术根据下游任务的需求对训练后的模型进行适应性调整,使得调整后的模型可以根据类别信息更好地识别不同类别的实体,从而提升任务的准确性,使得模型具有更高的可扩展性和可维护性。

- 还没有人留言评论。精彩留言会获得点赞!