一种自动驾驶场景中的三维空间占据识别方法和系统

本发明涉及一种三维空间占据识别方法和系统,特别是一种自动驾驶场景中的三维空间占据识别方法和系统。

背景技术:

1、在自动驾驶领域中,三维占据预测是自动驾驶感知任务中的一个重要任务。三维占据预测指的是在三维空间中预测出每个体素的占据状态和所述的语义类别。预测占据相比于预测三维包围盒的算法更加鲁棒和精准,可以为自动驾驶规划任务提供更为丰富的感知信息,从而保障行车安全。但是当前的占据识别方法均为预测四周360度范围内的占据信息,由于预测范围太大,模型计算开销高,推理速度慢,不利于实际行车环境中的快速推理。并且相当一部分范围内的占据信息对当前时刻的下游任务如轨迹规划是不必要的。因此需要一种更加高效的算法进行占据预测。

技术实现思路

1、发明目的:本发明所要解决的技术问题是针对现有技术的不足,提供一种自动驾驶场景中的三维空间占据识别方法和系统。

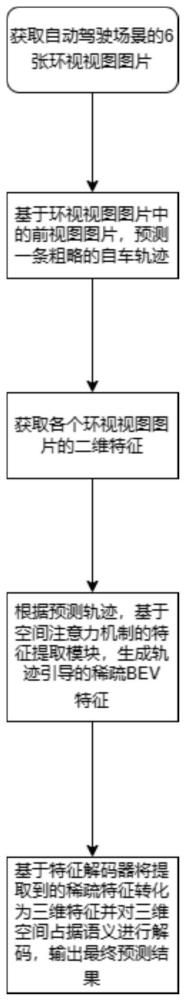

2、为了解决上述技术问题,本发明公开了一种自动驾驶场景中的三维空间占据识别方法和系统,其中,所述方法包括:

3、步骤1,获取所述自动驾驶场景中的环视视图图片;所述环视视图图片,使用车载相机拍摄,分别为:前视图图片、左前视图图片、右前视图图片、后视图图片、左后视图图片、右后视图图片;

4、步骤2,基于所述前视图图片,初步预测一条当前车辆的轨迹;

5、步骤3,获取自动驾驶场景中各环视视图图片的二维特征;

6、步骤4,构建基于空间注意力机制的bev特征提取模块,根据步骤2中初步预测的自车轨迹,生成轨迹引导的稀疏bev特征;

7、步骤5,构建3d特征解码器,将提取到的稀疏bev特征转化为三维特征并对三维空间占据语义进行解码,得到最终预测结果,完成自动驾驶场景中的三维空间占据识别。

8、进一步的,步骤2中所述的初步预测一条当前车辆的轨迹,具体包括:

9、步骤2-1,使用深度残差网络resnet对所述前视图图片提取特征,得到前视图图片的特征图;

10、步骤2-2,对上述特征图使用grunet模型预测自车未来轨迹,得到3d空间中世界坐标系下当前车辆未来6步的轨迹偏移其中,δwt表示第t步的轨迹偏移。

11、进一步的,步骤2-1中所述的使用深度残差网络resnet对所述前视图图片提取特征,具体包括:

12、所述的深度残差网络resnet,由四组残差模块resblock组成,每组残差模块resblock对输入的前视图图片进行卷积和下采样的操作,最终得到前视图图片的特征图。

13、进一步的,步骤2-2中所述的grunet模型,由一个单层gru加一个线性层组成,grunet模型用于预测当前车辆的未来轨迹。

14、进一步的,步骤3中所述的获取自动驾驶场景中各环视视图图片的二维特征,具体包括:

15、使用深度残差网络resnet对各个环视视图图片提取特征,将所有特征组成特征图,即得到环视视图的特征图f。

16、进一步的,步骤4中所述的生成轨迹引导的稀疏bev特征,具体包括:

17、步骤4-1,获取当前车辆在世界坐标系下的真实位置w0;

18、步骤4-2,根据步骤2-2中预测的轨迹偏移以当前车辆的位置w0为起始点,通过迭代计算得到每个轨迹点的坐标其中wt表示第t步的轨迹点坐标,所有的轨迹点组合得到一条轨迹线l;

19、步骤4-3,将当前车辆所在的三维空间等间距划分成相同大小的网格,得到网格点;

20、步骤4-4,定义占据候选区域m,具体方法如下:

21、对于上述三维空间中的任意点p和轨迹线上的轨迹点q,其欧氏距离为d,通过下述公式计算:

22、

23、其中,xp,yp,zp为三维空间中的点p在世界坐标系的坐标,xq,yq,zq为轨迹线l上的轨迹点q在世界坐标系的坐标;

24、设阈值d=1m,定义占据候选区域m为到轨迹线的欧氏距离小于阈值d的所有网格点的集合,即:对于轨迹线上的任意点q和三维空间中的网格点p,如果d<d,则p属于占据候选区域m;

25、步骤4-5,根据生成的占据候选区域m,将其中包含的所有n个网格点作为n个三维参考点;

26、步骤4-6,根据三维参考点,使用车载相机的投影矩阵及内外参,将所述三维参考点投影到各个环视视图图片的像素坐标系下,得到每个三维参考点在像素坐标系下的坐标,作为原始的二维参考点sij,具体如下:

27、sij=(uij,vij)

28、

29、

30、

31、

32、

33、其中,为第j个三维参考点在世界坐标系的坐标;为第j个三维参考点在当前车辆坐标系的坐标;为第j个三维参考点在相机坐标系的坐标;rot和tran分别为世界坐标系到自车坐标系的旋转矩阵和平移矩阵;rot′和tran′分别为自车坐标系到相机坐标系的旋转矩阵和平移矩阵;xij,yij为第j个三维参照点在第i个图像坐标系上的投影坐标;为第i个相机的投影矩阵,i=1,2,3,…,6;fi为相机焦距;dxi,dyi为相机i在u轴和v轴方向上的尺寸因子,为图像i的中心像素坐标和图像原点像素坐标之间相差的横向和纵向像素数;uij,vij为第j个三维参照点在第i个像素坐标系上的投影坐标;

34、步骤4-7,构建基于空间注意力机制的bev特征提取模块,结构如下:

35、基于可变形注意力机制,通过空间交叉注意力计算利用bev查询从环视视图的特征图中获取空间信息,生成轨迹引导的稀疏bev特征。

36、进一步的,步骤4-7中所述的生成轨迹引导的稀疏bev特征,具体包括:

37、步骤4-7-1,定义一组可学习的嵌入向量,随机初始化其权重参数作为bev查询,其中,h和w代表bev查询的高和宽,c代表bev查询的通道长度;

38、步骤4-7-2,进行空间交叉注意力计算,bev查询经过第一全连接层fc1得到注意力权重;bev查询经过第二全连接层fc2,为所有二维参考点生成相应的偏移量,得到位置偏移δs,将二维参考点sej和相应的位置偏移相加得到采样点,采用双线性插值的方法对特征进行采样得到采样点的特征;进行可变形多头注意力计算,得到输出矩阵z;

39、步骤4-7-3,在进行空间交叉注意力计算后,进入残差连接与正则化层,该层由残差连接层和正则化层两部分组成,残差连接层将初始bev查询fbev和可变形多头注意力计算的输出结果相加,对bev查询进行更新;正则化层进行正则化;

40、步骤4-7-4,进入前馈层,该层是一个两层的全连接层,第一层的激活函数为relu,第二层不使用激活函数;

41、步骤4-7-5,上述将前馈层的输出再输入至残差连接与正则化层,生成最终的轨迹引导的稀疏bev特征。

42、进一步的,步骤4-7-2中所述的输出矩阵z,具体计算方法如下:

43、

44、其中,deformattn(q,s,f)表示可变形多头注意力计算,nhead表示多头注意力的检测头的数量,wk表示不同检测头的输出映射矩阵,nkey表示采样点的数量,akk为注意力权重,wk′表示不同检测头的输入映射矩阵,f表示环视视图的特征图,s表示像平面上的二维参考点的二维坐标,δskl表示关于参考点sij的偏移量,q表示bev查询fbev经过线性映射生成的查询向量。

45、进一步的,步骤5中所述的得到最终预测结果,具体包括:

46、将步骤4中生成的轨迹引导的稀疏bev特征转化为三维特征,对三维特征使用语义分类器进行分类,得到预测结果,即被占据或者为空,被占据的位置及其所属的语义类别。

47、本发明还提出了一种自动驾驶场景中的三维空间占据识别系统,包括存储介质和处理器;

48、所述存储介质用于存储指令;

49、所述处理器用于根据所述指令进行操作以执行上述方法的步骤。

50、有益效果:

51、本发明方法能够很好的解决现有的三维空间占据识别方法效率低的问题,现有方法需要预测四周360度大范围内的占据,而本方法根据预测的自车轨迹,只预测轨迹附近的局部小范围占据,利用轨迹生成稀疏bev特征,减少了参考点数量和注意力权重计算的复杂度,从而减少计算成本,提高推理速度,提供了一种高效的三维空间占据识别方法;此外,本方法首先预测一条粗糙的轨迹,借助轨迹来进一步预测占据情况,预测的占据结果可用于下游任务中在已经预测的轨迹基础上进一步优化自车的未来轨迹,可以更方便的和下游规划任务结合,形成轨迹预测到占据预测、占据预测到轨迹预测的闭环。

- 还没有人留言评论。精彩留言会获得点赞!