一种基于辅助监督信号改进时序知识图谱的问答方法

本发明涉及一种基于辅助监督信号改进时序知识图谱的问答方法,属于人工智能。

背景技术:

1、在当前人工智能领域,时序知识图谱问答是一个重要的任务,它涉及了对知识图谱中的时序信息进行推理和问答。

2、然而,传统的强化学习方法在解决时序知识图谱问答问题时面临着一些挑战。强化学习通常仅依赖于延迟的奖励信号,这意味着智能体需要在没有明确监督的情况下进行无目的探索,这可能导致效率低下和推理路径缺乏可解释性。

3、因此,本发明的所要解决的技术问题是时序知识图谱问答对推理路径缺乏可解释性以及基于强化学习方法实现时序知识图谱问答在推理过程中出现监督不力无目的探索问题。

技术实现思路

1、目的:为了克服现有技术中存在的不足,本发明提供一种基于辅助监督信号改进时序知识图谱的问答方法,具有更强的对推理路径的可解释性和推理能力,可以更准确地回答多跳复杂时序问题。

2、技术方案:为解决上述技术问题,本发明采用的技术方案为:

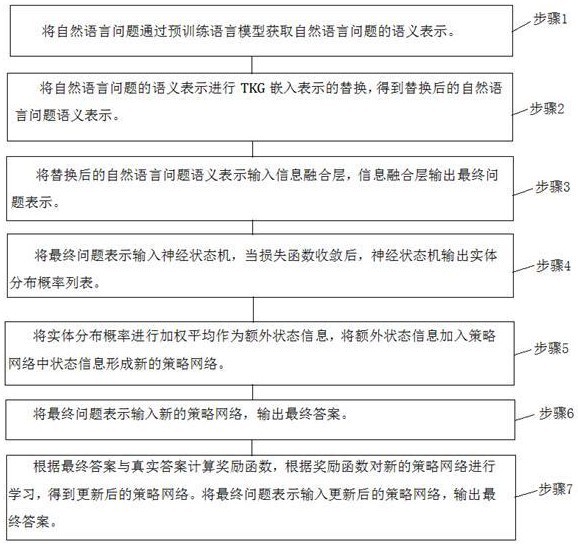

3、一种基于辅助监督信号改进时序知识图谱问答方法,包括以下步骤:

4、将自然语言问题通过预训练语言模型获取自然语言问题的语义表示。

5、将自然语言问题的语义表示进行tkg嵌入表示的替换,得到替换后的自然语言问题语义表示。

6、将替换后的自然语言问题语义表示输入信息融合层,信息融合层输出最终问题表示。

7、将最终问题表示输入神经状态机,当损失函数收敛后,神经状态机输出实体分布概率列表。

8、将实体分布概率进行加权平均作为额外状态信息,将额外状态信息加入策略网络中状态信息形成新的策略网络。

9、将最终问题表示输入新的策略网络,输出最终答案。

10、作为优选方案,还包括:根据最终答案与真实答案计算奖励函数,根据奖励函数对新的策略网络进行学习,得到更新后的策略网络。将最终问题表示输入更新后的策略网络,输出最终答案。

11、作为优选方案,所述自然语言问题的语义表示计算公式如下:

12、其中,表示自然语言问题的语义表示,表示d×的可学习矩阵,其中,d是tkg嵌入的维度,是distillbert的嵌入维度;是nlp处理模块;是自然语言问题的文本信息。

13、作为优选方案,所述将自然语言问题的语义表示进行tkg嵌入表示的替换,得到替换后的自然语言问题语义表示,具体包括:

14、将自然语言问题的语义表示中的实体部分替换tkg实体嵌入表示,得到。

15、再中的时间戳部分替换tkg时间戳表示,得到替换后的自然语言问题语义表示。

16、其中,中第i个元素计算公式如下:

17、

18、其中,表示实体或者,表示时间戳,表示替换过实体表示后问题表示的d×d维可学习矩阵,表示中第 i元素,表示头实体,表示尾实体。

19、其中,中第i个元素计算公式如下:

20、

21、其中,t1,t2分别表示将问句中所有实体查询时序知识图谱后得到的所有时间进行排序后的最大时间和最小时间。

22、作为优选方案,所述将替换后的自然语言问题语义表示输入信息融合层,信息融合层输出最终问题表示,具体包括:

23、替换后的自然语言问题语义表示通过多层自注意力机制和前馈神经网络进行处理和整合,得到矩阵,将矩阵中的元素作为最终问题表示。其中,表示自然语言问题的标志位。

24、作为优选方案,所述将最终问题表示输入神经状态机,当损失函数收敛后,神经状态机输出实体分布概率列表,具体包括:

25、根据最终问题表示,计算当前第k个推理步对应的指令向量。

26、根据当前第k个推理步实体,计算实体的动态特征,获得当前第k推理步实体,,,表示推理步骤中实体集合。

27、根据实体,获取实体在第k-1个推理步的实体分布概率。

28、根据指令向量,计算匹配向量。

29、根据实体分布概率和匹配向量,计算当前第k个推理步的实体集合。

30、根据实体,计算当前第k个推理步实体分布概率。

31、重复以上步骤,当每个推理步骤损失函数收敛后,神经状态机输出实体分布概率,经过n个推理步骤,获得实体分布概率列表。

32、作为优选方案,所述指令向量计算公式如下:

33、

34、其中,表示当前第k个推理步注意力权重,代表编码器的隐藏状态信息; j表示隐藏状态序列的长度,表示隐藏状态序列总长度。

35、所述计算公式如下:

36、

37、其中,表示当前第k个推理步最终问题表示,表示的d×d维可学习矩阵,表示的d×d维可学习偏置矩阵;softmax表示激活函数。

38、所述实体的动态特征计算公式如下:

39、

40、其中,表示当前推理步中实体所在时间戳与问题中时间戳的时间之差,是一个实体的动态特征的d×d维可学习矩阵,是一个实体的动态特征的d×d维可学习偏置矩阵;表示激活函数。

41、所述匹配向量计算公式如下:

42、

43、其中,表示匹配向量的d×d维可学习矩阵,表示激活函数,表示kronecker积,表示第 i个实体的关系。

44、所述计算公式如下:

45、

46、其中, u表示当前推理步所关联的实体的总数;

47、所述计算公式如下:

48、

49、其中,是推导实体分布的参数,表示激活函数。

50、作为优选方案,所述损失函数计算公式如下:

51、

52、其中,和表示控制因子权重的超参数,表示前向损失,表示后向损失,表示约束损失。

53、作为优选方案,所述将实体分布概率进行加权平均作为额外状态信息,将额外状态信息加入策略网络中状态信息形成新的策略网络,具体包括:

54、从实体分布概率列表中获取每个实体 n个推理步中对应的实体分布概率,将 n个推理步中对应的实体分布概率进行加权平均,获得每个实体的加权平均分布概率。

55、将加权平均分布概率作为额外状态信息加入策略网络中状态信息形成新的策略网络。

56、所述新的策略网络为,其中,状态信息为,动作信息为。

57、其中,,。

58、其中,表示当前实体,表示当前时间戳,表示问题中实体,表示问题中的时间戳,表示额外状态信息,表示当前所选的动作实体,表示当前所选的动作关系,表示当前所选的动作时间戳。

59、作为优选方案,所述将最终问题表示输入新的策略网络,输出最终答案,具体包括:

60、将最终问题表示输入最大池化层得到问题上下文向量。

61、获取历史搜索路径。

62、根据历史搜索路径,问题上下文向量计算期望目标节点和边。

63、根据期望目标节点和边,计算第步可选动作的候选动作分数,。

64、将候选动作分数最大值对应的动作作为下一步智能体的输入,当迭代至第l步时,智能体输出动作作为最终答案。

65、所述历史搜索路径计算公式如下:

66、

67、其中,,分别代表推理第步过程中当前节点所在关系、实体、时间。

68、所述期望目标节点和边计算公式如下:

69、

70、

71、其中,是d×d维的目标节点可学习矩阵,是d×d维的目标边可学习矩阵,表示输出期望目标的可学习矩阵,为激活函数。

72、所述候选动作分数计算公式如下:

73、

74、其中,,是的可学习矩阵;为激活函数,表示当前实体,表示当前时间戳;表示第步的可选动作,表示第步的可选动作中的实体,表示第步的可选动作中的关系。

75、作为优选方案,所述根据最终答案与真实答案计算奖励函数,根据奖励函数对新的策略网络进行学习,得到更新后的策略网络;将最终问题表示输入更新后的策略网络,输出最终答案,具体包括:

76、根据最终答案和真实答案,获得奖励值,表示最终状态。

77、根据奖励值,计算奖励函数。

78、根据奖励函数对新的策略网络进行学习,得到更新后的策略网络;将最终问题表示输入更新后的策略网络,输出最终答案。

79、其中,所述奖励值计算公式如下:

80、

81、表示指示函数,当指示函数内等式为真输出1,为假输出0。

82、所述奖励函数计算公式如下:

83、

84、其中,,表示狄利克雷分布,是问题关系的dirirchlet分布的参数向量。

85、有益效果:本发明提供的一种基于辅助监督信号改进时序知识图谱的问答方法,用于解决目前现有时序知识图谱问答方法普遍存在对推理路径缺乏可解释性以及使用基于强化学习方法实现时序知识图谱问答时不同于监督学习,在强化学习中只有奖励信号,并且奖励信号一般是延迟的,环境很久才会反馈所采取的动作是不是有效的,因此会在推理过程中出现监督不力无目的探索问题。其次,针对时序知识图谱这一任务背景,在nsm(神经状态机)推理模块中添加动态时间编码模块体现时序知识图谱的时序信息,并在整个指令模块中对实体表示进行改造,采用相对时间表示,将实体分为静态和动态表示两部分,将这两部分进行拼接来实时更新实体表示。该模型结合了nsm和强化学习算法,通过模拟和跟踪知识图谱中的状态变化和时序关系,实现了对时序知识图谱多跳推理下进行精准和高效的时序知识图谱问答,并相较于其他类型方法(基于信息检索和基于语义解析),体现出对推理路径的可解释性。

86、本发明提出的方法具有广泛的应用前景,可用于智能助理、知识图谱管理和智能搜索等领域,提供智能、准确和个性化的问答服务,推动人工智能和知识图谱技术的发展与应用。

- 还没有人留言评论。精彩留言会获得点赞!