文本驱动的语音和人脸动作生成方法、装置、设备及介质

本技术涉及语音视频生成,特别涉及一种文本驱动的语音和人脸动作生成方法、装置、设备及介质。

背景技术:

1、虚拟数字形象合成技术是指给定特定的人物图像,生成对应的可驱动的数字虚拟形象,能够在文本或者音频的驱动下输出与输入相匹配的,生动自然的动作。

2、相关技术中,虚拟数字形象合成技术为:利用给定的人物图像生成可驱动的数字虚拟形象,使其在文本或音频驱动下展现自然动作。然而,相关技术中多采用语音驱动,存在生成质量的缺陷,同时,音频获取难度较大。

技术实现思路

1、本技术提供一种文本驱动的语音和人脸动作生成方法、装置、设备及介质,以解决相关技术中数字形象生成中的自然度低、模态单一、音频获取难、灵活性差以及多模态输入输出数据间时序匹配度低等问题。

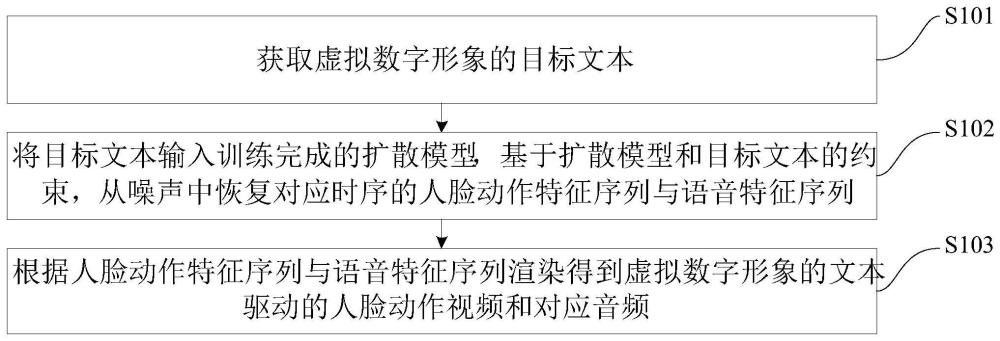

2、本技术第一方面实施例提供一种基于扩散模型的文本驱动的语音和人脸动作生成方法,包括以下步骤:获取虚拟数字形象的目标文本;将所述目标文本输入训练完成的扩散模型,基于所述扩散模型和所述目标文本的约束,从噪声中恢复对应时序的人脸动作特征序列与语音特征序列;根据所述人脸动作特征序列与所述语音特征序列渲染得到所述虚拟数字形象的文本驱动的人脸动作视频和对应音频。

3、可选地,所述扩散模型包括多个网络模块,其中,在每个网络模块中,对于所述语音特征序列中的语音特征进行频域卷积与时间卷积,对于所述人脸动作特征序列中的人脸动作特征进行空间卷积与时间卷积,并对所述人脸动作特征与语音特征分别施加自注意力机制。

4、可选地,所述多个网络模块包括第一至第八网络模块,其中,在第二至第六网络模块中加入所述人脸动作特征与所述语音特征各自与文本向量的第一交叉注意力机制、以及所述人脸动作特征与所述语音特征之间的第二交叉注意力机制;第一至第四网络模块之间由降采样层连接,对于所述语音特征在频域维度上进行降采样,对于所述人脸动作特征在空间维度上进行降采样;第五至第八网络模块之间由上采样层连接,对于所述语音特征在频域维度上进行上采样,对于所述人脸动作特征在空间维度上进行上采样。

5、可选地,所述第一交叉注意力机制为:

6、

7、其中,i为第i段音语音征序列,j为第j帧人脸动作特征序列,为语音特征提取出来的查询值,为j帧人脸动作特征序列线性展开后提取出来的键值,为j帧人脸动作特征序列值,t为一个无穷大的时序数,为使用softmax网络结构提取两个模态间的注意力权重。

8、所述第二交叉注意力机制为:

9、

10、其中,qtext为文本向量提取出来的语义查询值,ka为语音特征序列线性展开后提取出来的键值,va为语音特征序列值,为使用softmax网络结构提取文本与语音间的语义注意力权重。

11、可选地,在将所述目标文本输入训练完成的扩散模型之前,还包括:获取训练数据音频和训练数据视频;提取所述训练数据音频的语音特征序列和所述训练数据视频的人脸动作特征,并在所述人脸动作特征序列与所述语音特征序列按照时序加入随机噪声;利用随机加入噪声的序列对所述扩散模型进行训练,基于训练完成的扩散模型和输入的测试文本约束,预测扩散时间t后对应人脸动作特征序列与语音特征序列的噪声水平,从噪声中恢复对应时序的人脸特征序列与语音特征序列。

12、可选地,所述随机噪声的加入公式为:

13、

14、其中,q(xt|xt-1)为从t-1时刻到t时刻动作序列的扩散过程公式,n()为高斯分布,xt为扩散时序中t时刻的三维人脸模型特征序列,xt-1为扩散时序中t-1时刻的三维人脸模型特征序列,βt是预先设置好的噪声方差参数,i为单位矩阵。

15、所述噪声水平对应的损失函数为:

16、

17、其中,lθav为扩散模型的损失函数;∈a为实际施加在语音特征上噪声;为扩散模型在文本约束下,对语音特征序列at在扩散时刻t所施加噪声的估计结果;∈v为实际施加在人脸动作特征上的噪声;为扩散模型在文本约束下,对人脸动作特征序列vt在扩散时刻t所施加噪声的估计结果;为均方根误差计算公式。

18、可选地,所述人脸特征序列的恢复公式为:

19、

20、其中,θav为训练得到的扩散模型,为扩散模型在文本约束text的条件下,对视频序列vt在扩散时刻t所施加噪声分布的估计,vt为扩散过程中t时刻的人脸动作模型特征序列,vt-1为扩散过程中t-1时刻的人脸动作模型特征序列,at为扩散过程中t时刻的语音特征序列,pθav(vt-1|(at,vt,text))为从噪声序列vt还原降噪序列vt-1的过程。

21、所述语音特征序列的恢复公式为:

22、

23、其中,为扩散模型在文本约束text的条件下,对语音序列vt在扩散时刻t所施加噪声分布的估计,at-1为扩散过程中t-1时刻的语音特征序列,pθav(at-1|(at,vt,text))为从语音序列at还原降噪序列at-1的过程。

24、本技术第二方面实施例提供一种基于扩散模型的文本驱动的语音和人脸动作生成装置,包括:第一获取模块,用于获取虚拟数字形象的目标文本;恢复模块,用于将所述目标文本输入训练完成的扩散模型,基于所述扩散模型和所述目标文本的约束,从噪声中恢复对应时序的人脸动作特征序列与语音特征序列;渲染模块,用于根据所述人脸动作特征序列与所述语音特征序列渲染得到所述虚拟数字形象的文本驱动的人脸动作视频和对应音频。

25、可选地,所述扩散模型包括多个网络模块,其中,在每个网络模块中,对于所述语音特征序列中的语音特征进行频域卷积与时间卷积,对于所述人脸动作特征序列中的人脸动作特征进行空间卷积与时间卷积,并对所述人脸动作特征与语音特征分别施加自注意力机制。

26、可选地,所述多个网络模块包括第一至第八网络模块,其中,在第二至第六网络模块中加入所述人脸动作特征与所述语音特征各自与文本向量的第一交叉注意力机制、以及所述人脸动作特征与所述语音特征之间的第二交叉注意力机制;第一至第四网络模块之间由降采样层连接,对于所述语音特征在频域维度上进行降采样,对于所述人脸动作特征在空间维度上进行降采样;第五至第八网络模块之间由上采样层连接,对于所述语音特征在频域维度上进行上采样,对于所述人脸动作特征在空间维度上进行上采样。

27、可选地,所述第一交叉注意力机制为:

28、

29、其中,i为第i段音语音征序列,j为第j帧人脸动作特征序列,为语音特征提取出来的查询值,为j帧人脸动作特征序列线性展开后提取出来的键值,为j帧人脸动作特征序列值,t为一个无穷大的时序数,为使用softmax网络结构提取两个模态间的注意力权重;

30、所述第二交叉注意力机制为:

31、

32、其中,qtext为文本向量提取出来的语义查询值,ka为语音特征序列线性展开后提取出来的键值,va为语音特征序列值,为使用softmax网络结构提取文本与语音间的语义注意力权重。

33、可选地,还包括:第二获取模块,用于在将所述目标文本输入训练完成的扩散模型之前,获取训练数据音频和训练数据视频;提取模块,用于提取所述训练数据音频的语音特征序列和所述训练数据视频的人脸动作特征,并在所述人脸动作特征序列与所述语音特征序列按照时序加入随机噪声;训练模块,用于利用随机加入噪声的序列对所述扩散模型进行训练,基于训练完成的扩散模型和输入的测试文本约束,预测扩散时间t后对应人脸动作特征序列与语音特征序列的噪声水平,从噪声中恢复对应时序的人脸特征序列与语音特征序列。

34、可选地,所述随机噪声的加入公式为:

35、

36、其中,q(xt|xt-1)为从t-1时刻到t时刻动作序列的扩散过程公式,n()为高斯分布,xt为扩散时序中t时刻的三维人脸模型特征序列,xt-1为扩散时序中t-1时刻的三维人脸模型特征序列,βt是预先设置好的噪声方差参数,i为单位矩阵;

37、所述噪声水平对应的损失函数为:

38、

39、其中,lθav为扩散模型的损失函数;∈a为实际施加在语音特征上噪声;为扩散模型在文本约束下对语音特征序列at在扩散时刻t所施加噪声的估计结果;∈v为实际施加在人脸动作特征上的噪声;为扩散模型在文本约束下对人脸动作特征序列vt在扩散时刻t所施加噪声的估计结果;为均方根误差计算公式。

40、可选地,所述人脸特征序列的恢复公式为:

41、

42、其中,θav为训练得到的扩散模型,为扩散模型在文本约束text的条件下对视频序列vt在扩散时刻t所施加噪声分布的估计,vt为扩散过程中t时刻的人脸动作模型特征序列,vt-1为扩散过程中t-1时刻的人脸动作模型特征序列,at为扩散过程中t时刻的语音特征序列,pθav(vt-1|(at,vt,text))为从噪声序列vt还原降噪序列vt-1的过程;

43、所述语音特征序列的恢复公式为:

44、

45、其中,为扩散模型在文本约束text的条件下对语音序列vt在扩散时刻t所施加噪声分布的估计,at-1为扩散过程中t-1时刻的语音特征序列,pθav(at-1|(at,vt,text))为从语音序列at还原降噪序列at-1的过程。

46、本技术第三方面实施例提供一种电子设备,包括:存储器、处理器及存储在所述存储器上并可在所述处理器上运行的计算机程序,所述处理器执行所述程序,以实现如上述实施例所述的基于扩散模型的文本驱动的语音和人脸动作生成方法。

47、本技术第四方面实施例提供一种计算机可读存储介质,其上存储有计算机程序,该程序被处理器执行,以用于实现如上述实施例所述的基于扩散模型的文本驱动的语音和人脸动作生成方法。

48、由此,本技术至少具有如下有益效果:

49、本技术实施例可以通过扩散模型建模任意文本输入为条件下,从噪声中同时恢复时序匹配的语音与人脸动作序列的逆向过程,并通过渲染合成给定人物形象下的语音视频,驱动该人物形象以自然的动作和语音表达文本所描述的内容;通过引入模态间的交叉注意力机制,使扩散模型能够更好地学习不同模态数据之间的时序对应关系,提高合成结果的时序匹配度,从而生成自然、灵活的虚拟人物语音与动作。由此,解决了相关技术中数字形象生成中的自然度低、模态单一、音频获取难、灵活性差以及多模态输入输出数据间时序匹配度低等技术问题。

50、本技术附加的方面和优点将在下面的描述中部分给出,部分将从下面的描述中变得明显,或通过本技术的实践了解到。

- 还没有人留言评论。精彩留言会获得点赞!