一种基于分布式多智能体自主决策的无人机资源管理方法

本发明涉及一种基于分布式多智能体自主决策的无人机资源管理方法,属于无人机自动控制。

背景技术:

1、无人机技术的快速发展和广泛应用,使其进入到人们科技和生活的各个领域。由于无人机的工作特点和当前的技术瓶颈制约其无法长时间高负荷运转。对于一些高复杂度的计算任务,传统无人机系统通常将任务数据传输至云计算中心服务器进行处理,从而缓解本地计算负载、节约能耗。边缘计算(mobile edge computing,mec)技术的出现为解决无人机的计算负载问题提供了有效地解决方式。通过将无人机高能耗的复杂计算任务卸载到路侧基站中的mec服务器,能够有效缓解无人机的计算负载、节约能耗,同时有效降低传输时延,提升通信效率。

2、然而,现有的基于mec辅助的无人机系统仍然面临一些挑战。

3、首先,现有方法局限于简单的任务卸载和,任务卸载过程中未考虑动态无线网络环境、功率控制、资源分配策略以及无人机的移动性等影响因素。

4、其次,现有的针对无人机的任务卸载与资源分配算法大多基于集中式方法,决策的准确性和实时性不高,无法适应无人机的实际应用环境。

5、此外,现有的基于强化学习的决策算法,需依赖大量的系统全局观测信息来进行训练,增加了决策智能体的数据获取成本,且智能体的决策依赖于系统的全局状态,算法收敛速度慢。

6、因此,本领域技术人员急需要提升mec系统对无人机系统的服务能力,增强边缘计算节点对无人机的任务卸载能力,延长无人机续航时间(降低能耗),实现无人机任务卸载与资源分配的快速、准确决策。

技术实现思路

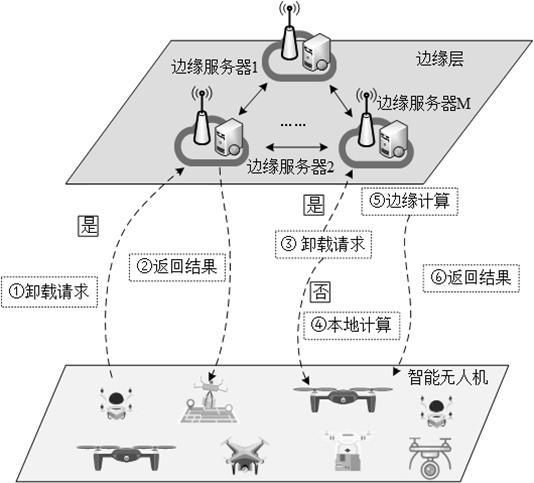

1、目的:为了克服现有技术中存在的不足,本发明提供一种基于分布式多智能体自主决策的无人机资源管理方法,考虑了动态无线环境、无人机移动性与负载状态、mec节点的任务能力等因素,致力于通过设计一种分布式在线学习算法,并利用局部观测信息,实现快速、准确的无人机任务卸载与资源分配,提高无人机系统性能。

2、一种基于分布式多智能体自主决策的无人机资源管理方法,包括如下步骤:

3、预构建马尔可夫博弈过程系统模型。

4、以最小化无人机能耗为目标,进行任务卸载与资源分配决策。

5、所述马尔可夫博弈过程系统模型,具体包括:

6、系统状态,具体如下:

7、

8、其中,表示 t时刻智能体 m的系统状态,表示智能体 m在 t时刻的本地观测信息,表示其他智能体的观测信息,表示智能体的总数量,每个mec服务器 m都可被视为一个智能体 m。

9、系统动作,具体如下:

10、=

11、其中,表示 t时刻智能体 m的系统动作,表示mec服务器 m对无人机 n的任务卸载决策,当时,无人机 n将任务卸载至服务器 m中处理,0时,任务在无人机 n本地执行,表示mec服务器 m对无人机 n的补偿功率,表示边缘节点 m对无人机 n的带宽分配决策,表示为边缘服务器 m为无人机 n分配的计算资源。

12、奖励函数,具体如下:

13、

14、其中,表示n个无人机总能耗统。

15、作为优选方案,当选择合适的变量值、变量值或者变量值时,系统动作满足如下约束:

16、

17、其中,n表示无人机的总数量。

18、

19、其中,表示任务卸载决策,任务模型处理总时延,表示无人机 n的任务最大延时要求。

20、

21、其中,n表示无人机的总数量,表示mec服务器 m的最大cpu频率。

22、

23、

24、其中,为mec服务器m提供的最大发射功率。

25、作为优选方案,计算公式如下:

26、

27、式中:表示无人机n总能耗,计算公式如下:

28、

29、其中,表示无人机n对于任务模型本地处理能耗,表示无人机n上传任务至mec服务器m的能耗,表示无人机n下载任务至mec服务器m的能耗。

30、作为优选方案,计算公式如下:

31、

32、其中,表示无人机 n在本地处理任务的时延消耗,表示无人机 n产生任务模型,并将任务上传至mec服务器 m的传输时延, 表示mec服务器m计算的无人机n产生任务模型的计算时延,表示mec服务器m处理的无人机n产生任务模型的下载延时。

33、作为优选方案,任务模型,计算公式如下:

34、

35、其中,为的输入数据量,为完成任务所需的cpu周期数,为某任务的时延约束。

36、作为优选方案,计算公式如下:

37、

38、其中,为的输入数据量,为无人机在时刻的上行链路传输速率。

39、式中,计算公式如下:

40、

41、其中,为mec服务器为无人机节点提供的通信带宽,为边缘节点 m对无人机 n的带宽分配决策。表示mec服务器 m对无人机 n的补偿功率,为在接收处的加性高斯白噪声随机变量,为内部干扰,为无人机 n与mec服务器 m在时刻的上行链路snr参数。

42、作为优选方案,所述以最小化无人机能耗为目标,进行任务卸载与资源分配决策,具体包括:

43、步骤2-1:初始化每个智能体 m的actor网络和critic网络,构建参数为的actor网络。构建参数为 w的critic网络。

44、步骤2-2:当前智能体在 t时刻的观测信息为,则基于策略选择一个动作。

45、步骤2-3:执行动作,并获得奖励 和 t+1时刻的观测集合。

46、步骤2-4:每个智能体 m基于已获得信息,构建局部信息元组,将局部信息元组存储到本地经验回放池 s中,并将局部信息元组发送给其它智能体。

47、步骤2-5:智能体 m从 s中随机采取样本数据,构建全局信息元组,其中,表示 t+1时刻智能体 m的系统状态。

48、步骤2-6:对于每个智能体 m,基于全局信息,训练critic网络,具体如下:

49、

50、其中,表示智能体的critic网络参数 w,为关于函数的导数,为更新权重,表示如下:

51、

52、其中,对所有元组信息求期望值。

53、

54、其中,表示任务处理后与任务处理前的数据量比值,表示 t+1时刻智能体 m的系统动作。

55、步骤2-7:对于每个智能体 m,基于局部信息,训练自身的actor网络,具体如下:

56、

57、其中,表示智能体的actor网络参数,为函数关于参数的导数运算,具体如下:

58、

59、其中,表示对函数关于的导数。

60、步骤2-8:对于每个智能体 m,基于所获得的参数和参数,更新目标actor网络和目标critic网络。

61、步骤2-9:重复步骤2-2至步骤2-8整个迭代过程,每一轮迭代过后,actor网络和critic网络得到更新,最终策略趋于收敛。收敛后的策略即最优策略。智能体 m基于策略,在局部观测信息下,做出动作。

62、有益效果:本发明提供的一种基于分布式多智能体自主决策的无人机资源管理方法,本方法考虑了无人机的动态无线网络环境、无人机的移动性与负载状态、mec节点的任务处理能力。在此基础上,将无人机的任务卸载与资源分配问题建模为马尔科夫博弈过程,并提出基于maddpg(multi-agent deep deterministic policy gradient)算法的分布式在线决策算法对马尔科夫博弈过程进行决策。该算法能够使每个mec节点仅利用局部观测的动态环境信息,实现对全局mec节点的任务卸载与资源分配决策的优化,提升对无人机集群的服务能力。

63、本发明能够充分利用边缘计算节点的计算能力,提高系统对无人机的服务能力。本方法基于分布式多智能体强化学习算法,决定无人机机算的计算任务是否在本地执行或将任务卸载到边缘计算服务器进行处理。这样以最小化无人机能耗为目标,考虑任务延时要求、边缘计算服务器处理能力、无人机的移动性、以及动态无线环境,进行任务卸载与资源分配的实时决策。同时,基于多智能体强化学习的分布式优势,通过边缘节点的局部观测信息,进行分布式模块化训练,实现对无人机集群的快速、准确任务卸载与资源分配,提高任务处理速度,并降低无人机的能耗。

- 还没有人留言评论。精彩留言会获得点赞!