一种基于深度学习模型的非侵入式电力负荷分解方法

本发明属于用户负荷,具体涉及一种基于深度学习模型的非侵入式电力负荷分解方法。

背景技术:

1、全球能源消耗总量中,住宅和商业部门的能源使用占据40%的份额。在如今追求节能减排的大环境下,负荷监测显得尤为重要,因为它有助于提升能源利用效率,降低建筑物的碳排放量。与此同时,对于终端用户而言,负荷监测能够为他们提供不同时间段的电能消耗数据,为用户提供有效的节能参考。

2、20世纪80年代,hart提出了nilm(non-intrusive load monitor)方法。与传统的侵入式负荷监测不同,nilm的目标是通过分析住宅入口处测得的聚合电流和电压信号来感知住宅内电器的运行状态。它不需要接入房屋内部电路或为电器配备单独的传感器,从而节省了时间和成本。

3、目前,nilm技术主要涵盖数学优化、基于隐马尔可夫模型的方法以及基于深度学习的方法。有研究表明,深度学习方法凭借其卓越的非线性映射能力,其在分解精度和准确性方法均优于其他两种方法。但是,现有的基于深度学习的非侵入式负荷分解方法存在一些问题。例如,它们很容易丢失特征并且难以检测,所构建的模型对特征信息挖掘不够,导致不能很好地识别低使用率的电器。因此,提供一种具有提取更全面,更深层次,更关注“分解信息”的负荷特征的基于深度学习的非侵入式电力负荷分解方法,是非常有必要的。

技术实现思路

1、本发明的目的是为了克服现有技术的不足,而提供一种具有提取多尺度功率序列信息、关注时序中对分解任务起重要作用的负荷特征,同时具有全局特征和局部特征提取能力的非侵入式负荷分解方法。

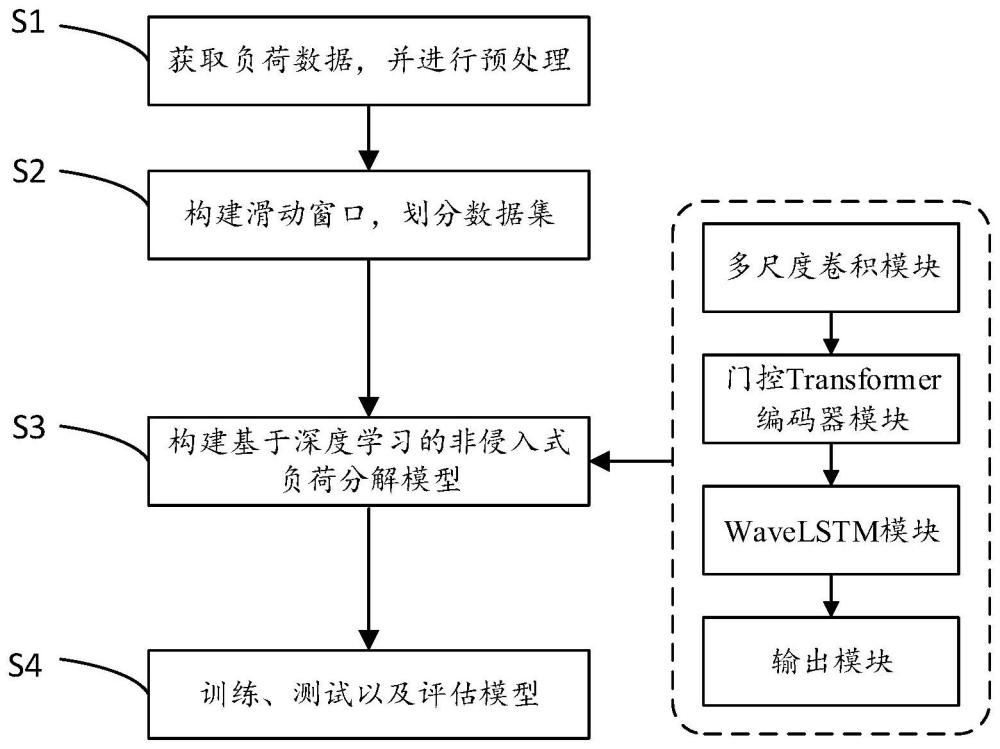

2、一种基于深度学习模型的非侵入式电力负荷分解方法,包括以下步骤:

3、s1:获取总功率和各个设备的负荷数据,并进行数据预处理操作;

4、s2:利用滑动窗口的方法对预处理后的数据进行操作,获取相应的特征数据,将数据划分为训练集与测试集;

5、s3:构建一种基于深度学习模型的非侵入式电力负荷分解模型;

6、s4:将预处理后的训练集数据输入构建好的负荷分解模型中进行训练,得到训练好的负荷分解模型,用测试集数据对训练好的负荷分解模型进行测试,得出各个设备的分解功率,对其准确性进行评估。

7、进一步地,所述步骤s1中的数据预处理,具体包括如下步骤:

8、s11:对获取的电力负荷数据进行清洗操作,查找并处理缺失值;

9、s12:对清洗后的数据下采样,降低其频率,并将设备功率数据与总功率数据对齐时间戳;

10、s13:对采样后的负荷数据进行最小-最大归一化处理,使结果映射到[0,1]之间,公式如下所示:

11、

12、其中,x′t为t时刻归一化的结果;xt为总功率或目标设备t时刻的功率数据;xmax为功率序列最大值;xmin为功率序列最小值。

13、进一步地,所述步骤s2中的具体步骤如下:

14、s21:构造窗口数据,对预处理后的时间序列数据进行提取,取t时刻至t+w-1时刻已归一化的功率序列为一个窗口数据,表示为z={x′t,x′t+1,x′x+2,...,x′t+w-1},w表示滑动窗口长度。

15、s22:使用滑动窗口,对总功率序列x和单个设备功率序列y进行分割,并将数据划分为训练集和测试集。

16、进一步地,所述步骤s3中建立的深度学习网络模型,包括:多尺度卷积模块、门控transformer编码器模块、wavelstm模块以及输出模块;

17、s31:所述多尺度卷积模块由四种拥有不同大小卷积核的卷积构成,用于获取不同尺度的浅层次的特征信息,具体数学表达如下:

18、x1=maxpool(relu(bn(conv1d1(x))))

19、x2=maxpool(relu(bn(conv1d2(x))))

20、x3=maxpool(relu(bn(conv1d3(x))))

21、x4=maxpool(relu(bn(conv1d4(x))))

22、x=dropout(cat(x1,x2,x3,x4))

23、其中,x表示输入功率序列,conv1d和bn分别代表一维卷积和批归一化,relu为激活函数,cat表示通道串联,dropout层用于防止过拟合。

24、s32:所述门控transformer编码器与原始transformer编码器模块的主要区别在于,特征向量在经过多层感知机(multi-layer perceptron,mlp)之后要通过一个门控线性单元层glu。门控transformer编码器由k个相同的层组成。每层依次三个块组成,即多头注意力机制(multi-head attention,mha)、逐位置的全连接前馈层(mlp)和门控线性单元层(glu),每个子层的输入都通过残差连接与后面的归一化层(layernorm)相连,该过程由下式表示:

25、z′k=mha(layernorm(zk-1))+zk-1

26、z″k=mlp(layernorm(z′k))+z′k

27、zk=glu(z″k)

28、其中,zk-1、z′k、zk″和zk分别表示每层的输出。

29、s33:所述wavelstm模块由wavenet网络与lstm网络串联构成,结合两者可以增强模型对序列数据的表示能力,使其更有效地捕捉功率序列中的复杂结构。wavenet网络具有多个wavenet层,包括因果卷积、空洞卷积和两种激活函数构成的门控结构。输入功率序列q′首先经过因果卷积层,之后进入空洞卷积层,获取更长时间的感知,再将其送入门激活函数,激活函数的值,再经过卷积核为1×1的1d卷积。此过程为一层的操作,将多层叠加后得到最终输出在经过批标准化层(batch normalization)后送入lstm层,提取时序的长期时间特征,得到增强功率序列q。

30、s34:所述输出模块由全连接层构成。

31、s35:将s31、s32、s33和s34分别构建的多尺度卷积模块、门控transformer编码器模块、wavelstm模块以及输出模块,顺次串联连接,完成多尺度卷积结合transformer非侵入负荷分解模型的搭建。

32、进一步地,所述步骤s4中评估模型的评价指标采用平均绝对误差(mae)和信号聚合误差(sae),计算公式如下所示:

33、

34、

35、为对应时间点模型输出分解值,pt为对应时间点实际数据,t为时间点个数。

36、本发明的有益效果:本发明提供一种基于多尺度卷积结合transformer的非侵入式负荷方法,所提出的多尺度卷积模块通过四条具有不同滤波器大小的并行路径提取各种特征,这有助于提取特征的多样性和可分离性;为了关注时序中对分解任务起重要作用的相关部分,引入了带多头注意力机制的transformer编码器,同时为了让transformer在并行处理数据时加快运算速度和减少运算量,在transformer编码器结构中融合了门控线性单元层glu;由wavenet和lstm结合的wavelstm模块,同时具有全局特征和局部特征提取能力有助于帮助模型更好地做出决策。

- 还没有人留言评论。精彩留言会获得点赞!