一种路侧视角下基于点跟踪的单目3D车辆检测方法

本发明涉及图像处理,尤其涉及一种路侧视角下基于点跟踪的单目3d车辆检测方法。

背景技术:

1、自动驾驶车辆主要依靠计算机视觉、人工智能、雷达、监控装置和全球定位系统,以及网联通信等技术,完成自主环境感知、决策规划和控制功能。环境感知作为最基础的任务,通过配备多种模态的传感器,对道路交通各类目标的类别、位置、运动状态和轨迹等进行精准检测,获取有效感知信息。三维目标检测作为环境感知的重要内容之一,在图像特征提取、分类和定位的基础上,增加了物理尺寸、深度、姿态等信息的估计,为后续的决策和规划任务提供更精确的信息。

2、单目3d目标检测因其在数据处理和传感器成本上的巨大优势,受到学术界和工业界的广泛关注。现有单目3d目标检测研究依赖于单目图像和相机参数,但仅从单个rgb图像中无法回归出3d物体尺寸、朝向角度、立体姿态等信息,面临着距离感知和目标遮挡两大挑战。单目3d检测将场景信息投影到二维图像平面时会丢失部分场景深度信息,且由于透视投影引起的尺度距离模糊的影响,图像空间的像素点误差会在3d空间放大,导致物体的姿态信息出现偏差。针对这一问题,一些研究基于深度特征来提升单目3d目标检测精度,结合深度估计、lidar引导、直接回归等方法来回归目标的三维几何特征,而这些方法需要额外的数据作为辅助,缺乏准确的深度信息。另一些研究针对固定的路侧视角场景,基于相机自标定和消失点的模型从二维图像中获取消失点坐标,在相机标定模型中利用模型参数推导出三维世界坐标和二维图像坐标之间的关系,结合路况信息,如相机内外参数据、相机安装高度、车道线间距、车道线长度等数据,进行数理公式计算,但实际路况中车道线长、宽信息是变化的,不具有普遍性。

3、此外,将采集到的二维图像作为唯一的信息源,当检测目标出现遮挡、截断等情况时,单帧图像难以提供检测目标充足的姿态信息。相较于单一的静态数据,连续图像帧之间同一目标存在着位置、形态等差异,其上下文信息存在着一定的连续性,将同一目标的多个时间节点产生的位置信息结合起来,利用不同位置对应的图像特征来提供时域信息,以此作为三维数据参考。

技术实现思路

1、本发明的目的在于提供一种路侧视角下基于点跟踪的单目3d车辆检测方法,本发明不依赖感知数据、传感器参数数据等先验数据,且不需要设计复杂的网络模型结构,用动态连续帧代替静态单帧图像进行分析,获取的时域信息提供给第三维度上的尺寸参考。

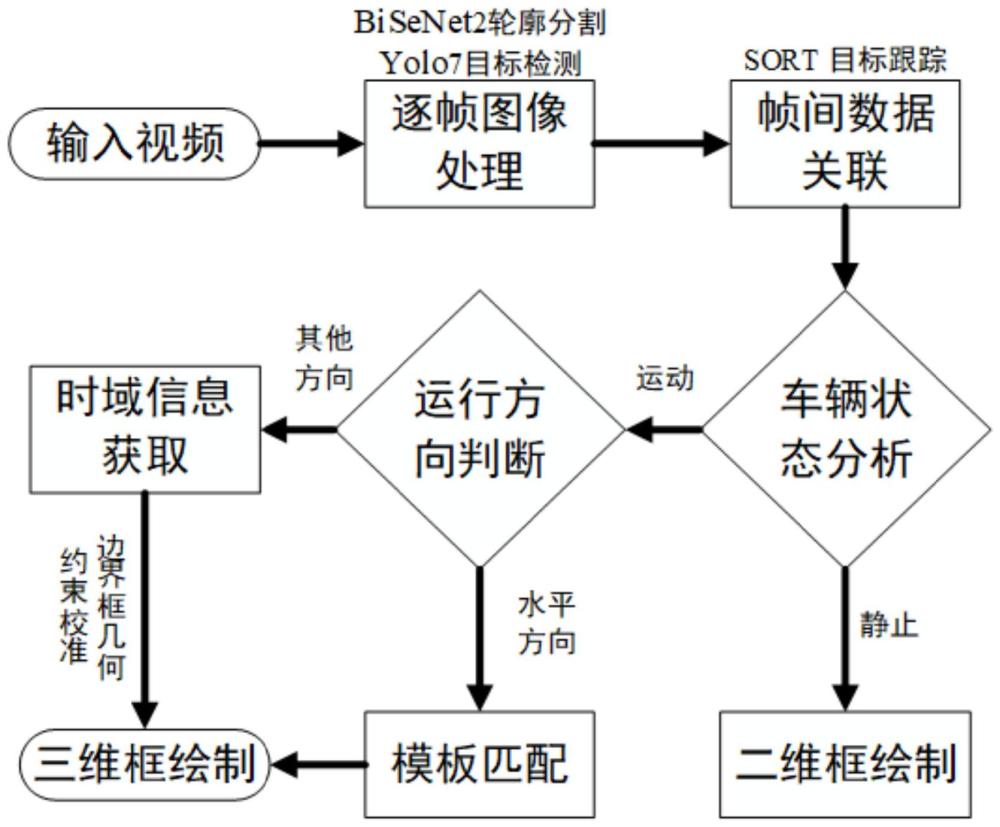

2、为实现上述目的,本发明提供如下技术方案:一种路侧视角下基于点跟踪的单目3d车辆检测方法,包括以下步骤:

3、s1.对输入的图像进行逐帧处理,采用yolo目标检测算法和bisenet轮廓分割算法提取图像特征,将轮廓点与二维框进行匹配,获得轮廓点边界框,用二维特征和统计分析来获取水平、垂直方向的参数数据。

4、s2.将车辆轮廓点边界框的中心点作为跟踪点,采用sort目标跟踪算法记录每帧图像的所有跟踪点信息,以及跟踪点的历史信息,根据当前帧和历史帧的像素坐标变化程度区分某段时间内车辆静止、运动状态;车辆处于静止状态时,其车辆轨迹信息不具备参考价值,不能提供绘制三维框的有效信息,只对静止车辆绘制二维框;车辆处于运动状态时,进一步对其行驶状态进行分析。

5、s3.根据轮廓点边界框的宽高比区分运动状态车辆的不同运动方向,当前帧跟踪点横坐标和历史帧跟踪点横坐标大小判断是水平向左运动还是水平向右运动,水平方向运动车辆采用模板匹配方式绘制三维框,其它方向运动车辆由跟踪点将帧间检测目标关联起来,结合时间戳及当前帧和历史帧横纵坐标之间的斜率,根据获取的有效时域信息绘制三维框。

6、优选的,s1中,采用yolo目标检测算法得到目标类别和二维框位置信息,采用bisenet轮廓分割算法得到车辆轮廓点横纵坐标,匹配车辆轮廓点边界框和车辆目标检测二维框。

7、优选的,所述基于统计分析得到车身水平和垂直方向的尺寸参考包括以下步骤:

8、根据车辆轮廓点坐标分布进行统计分析,首先得到车辆id下轮廓点像素横纵坐标的边界值:

9、left =min ( xlist ) (3);

10、top =min ( ylist ) (4);

11、right =max ( xlist ) (5);

12、bottom =max ( ylist ) (6);

13、其次,将车辆轮廓像素点横坐标xlist作为直方图绘制数据,right-left作为分组数,有:

14、xn,xbin,xp = plt.hist ( xlist, right-left ) (7);

15、水平方向车身二维信息参考尺寸表达式为:

16、xw =max ( |rightx-left |, | right-leftx | ) (8);

17、垂直方向车身二维信息参考尺寸表达式为:

18、yh =max ( | ymean-top |, | bottom-ymean |) (9);

19、式中,xy为bisenet轮廓分割得到当前帧所有车辆轮廓像素点横纵坐标,xlist、ylist分别为车辆id下横纵坐标列表,xn为车辆轮廓像素点横坐标直方图组内元素数量,xbin为横坐标区间范围,xp为每个区间范围包含的数据,mxn=max(xn)为车辆id横坐标密度最多的坐标值,纵坐标均值ymean=mean(ylist)。

20、优选的,s2包括以下步骤:

21、定义跟踪点坐标属性为:

22、centroidarrj=[bleftj,btopj,brightj,bbottomj,cxj,cyj,] (12);

23、其中,cxj=(bleftj+brightj)/2,cyj=(btopj+bbottomj)/2,为轮廓边界框的中心点;j∈m,m为跟踪点的历史个数,即检测目标从目标出现到当前经过的图像帧数;

24、当centroidarr列表长度超过跟踪点历史个数阈值track_num时,计算当前帧和历史帧两像素坐标的位移为:

25、

26、式中,当前帧curi和历史帧hisi在centroidarr列表中的下标分别为curi=len(track.centroidarr)-1,hisi=len(track.centroidarr)-track_num;

27、当d<5时,认为在该段时间内车辆处于静止状态,对静止车辆绘制二维框;

28、当d≥5时,认为在该段时间内车辆处于运动状态,需进一步对其行驶状态进行分析。

29、优选的,s3中,当轮廓点边界框的宽高比大于1.75时,车辆为水平方向运动,采用模板匹配的方式,定义跟踪点坐标:

30、curcenterx=track.centroidarr[curi][4] (15);

31、curcentery=track.centroidarr[curi][5] (16);

32、curcenterx=track.centroidarr[hisi][4] (17);

33、curcentery=track.centroidarr[hisi][5] (18);

34、如果curcenterx<hiscenterx,则认为车辆水平向左运动;否则水平向右运动;

35、式中,curcenterx、curcentery分别为当前帧跟踪点横、纵坐标,hiscenterx、hiscentery分别为历史帧跟踪点横、纵坐标;

36、当轮廓点边界框的宽高比小于等于1.75时,车辆为其他方向的运动,定义当前帧和历史帧的斜率:

37、

38、当k<0&curcentery≥hiscentery时,车辆靠近摄像头方向,且偏向左侧方向移动;

39、当k<0&curcentery<hiscentery时,车辆远离摄像头方向,且偏向右侧方向移动;

40、当k≥0&curcentery≥hiscentery时,车辆靠近摄像头方向,且偏向右侧方向移动;

41、当k≥0&curcentery<hiscentery时,车辆远离摄像头方向,且偏向左侧方向移动。

42、优选的,s3中,所述绘制三维框的方法为:

43、当车辆水平向右运动时,将二维框的右上点作为基准点,将xw作为车身二维像素的宽,将yh作为车身二维像素的高,设置水平方向车身模块宽度默认值为4像素,根据坐标平移变换得到三维框八角点像素坐标系;

44、当车辆水平向左运动时,将二维框的左上点作为基准点,将xw作为车身二维像素的宽,将yh作为车身二维像素的高,设置水平方向车身模块宽度默认值为4像素,根据坐标平移变换得到三维框八角点像素坐标系;

45、当k<0&curcentery≥hiscentery,将二维框的左下点作为基准点,根据坐标平移变换得到三维框八角点像素坐标,并采用轮廓点边界框的几何约束对角点的横、纵坐标进行校准;

46、当k<0&cur_center_y<his_center_y,将二维框的右上点作为基准点,根据坐标平移变换得到三维框八角点像素坐标,并采用轮廓点边界框的几何约束对角点的横、纵坐标进行校准;

47、当k≥0&cur_center_y≥his_center_y,将二维框的右下点作为基准点,根据坐标平移变换得到三维框八角点像素坐标,并采用轮廓点边界框的几何约束对角点的横、纵坐标进行校准;

48、当k≥0&cur_center_y<his_center_y,将二维框的左上点作为基准点,根据坐标平移变换得到三维框八角点像素坐标,并采用轮廓点边界框的几何约束对角点的横、纵坐标进行校准。

49、与现有技术相比较,本发明具有如下有益效果:

50、1、本发明不借助车辆物理尺寸、相机内外参、相机安装高度、底平面方程等任何额外数据,输入视频数据,逐帧获取二维图像特征,基于统计任务得到水平、垂直方向的尺寸参考,并借助跟踪点将帧间数据关联起来,连续处理检测目标的上下文信息,通过时域信息来处理3d任务。相较于基于深度特征、基于相机自标定和消失点的单目3d方法,本发明除了具有解除对感知数据、传感器参数数据等先验数据的严重依赖,且不需要设计复杂的网络模型结构的优点之外,用动态连续帧代替静态单帧图像进行分析,利用时间序列上的信息来帮助估算物体在三维空间中的尺寸。

51、2、本发明用跟踪方法来处理检测任务。跟踪点一般定义为目标检测二维框的中心点,但对于远端小目标,由于其缺乏充足的外观信息,常见的fast rcnn、ssd、yolo4等检测算法难以将其与背景或相似的目标区分开来。相比之下,轮廓分割算法能提供更细粒度的二维图像特征,能有效识别和区分远端小目标,但未对其输出结果进行聚类和区分。因此,本发明在定义跟踪点时,先分别进行车辆目标检测和车辆轮廓分割,提取图像轮廓特征,再匹配轮廓像素点和二维检测框进行聚类,构建新的轮廓点边界框,将其中心点作为跟踪点,进行了更细粒度的划分,并消除目标检测算法对于远端小目标检测精度不高,以及轮廓分割算法输出结果未能有效标识类别id等对跟踪效果的影响。

52、3、本发明在保证评价指标在误差允许范围内时,相较于现有技术中的deep3dbox、bevheight不需要相机内外参、角点世界坐标、实际尺寸、底平面方程等信息,相较于vwh、vlh、vwl不需要相机内外参数、相机安装高度、实际尺寸等信息。采用数据清洗、小目标拼接、数据增强,并调整锚框尺寸大小和模型参数来提升yolo7模型的检测精度。

- 还没有人留言评论。精彩留言会获得点赞!