一种用于扩展输入上下文长度的金融大模型长度外推方法

本发明涉及自然语言处理领域,具体来说,尤其涉及一种用于扩展输入上下文长度的金融大模型长度外推方法。

背景技术:

1、在处理长上下文时,传统的大型语言模型面临着一系列复杂而严峻的挑战。其中之一是由于长文本包含的信息量巨大,要求模型具备高度准确的理解和处理能力。然而,由于模型的记忆力有限,较长的文本可能会超出其处理范围,导致信息丢失或在处理中出现错误。此外,处理长文本还会引入巨大的计算和存储负担,给模型的效率和性能带来严峻的考验。

2、在没有足够长的预料进行微调的情况下,大型语言模型在处理长上下文时可能表现不尽如人意,即便试图通过微调大型模型以适应特定领域的长文本,构建训练预料也是相当具有挑战性的任务。同时,微调过程所需的计算资源庞大,长文本训练会占用大量显存和计算开销。

3、目前,针对预训练大模型在处理长文本方面的不足,业界通常采用两种主要解决方法。其中一种方法是通过获取新的与后续推理相对应的训练预料,然后在训练预料上重新训练微调原有的模型,以获得能够满足需要的文本长度的模型,这一策略通过有针对性的数据增强来弥补在处理长文本时的不足之处;另一种解决方法则是修改模型推理代码,即通过一系列手段使得模型在没有足够长上下文的训练前提下,依然能够在这些较长文本上进行有效推理。

4、在微调上增加上下文长度相对容易,但一方面,获取长文本的下游任务训练预料较为困难,另一方面,上下文需要占用大量显存资源,导致较大的开销;因此,为了避免大模型微调长上下文造成更高算力需求和显存压力,主流方法是通过减小模型尺寸,采用滑动窗口的方式主动舍弃前文,只保留最新输入的注意力机制或者仅保留部分输入的注意力机制,然而,这种方法会对模型性能造成较大程度的损害,尽管可以输入输出较长长度的上下文,但大语言模型难以记住全部的上下文窗口,例如,在输入的全文信息基础上回答总结性问题上回答困难,跨越多个提供文本综合考虑答案的难度也会出现回答不全面的问题。

5、除了上述技术,还有一些创新方法,一种独特的技术是位置插值,这种方法通过放缩位置索引,使得最大的位置索引与预训练时的对齐,一般可以在微调的前1000步内就能让模型逐步适应相应的上下文长度。此外,最近codellama(以代码补全任务为目标的大型语言模型元智能)的方式也通过微调旋转位置编码的旋转角度,以提升模型在外推方面的性能。

6、另一种方式着重在扩展大模型的输入长度范围,这种方式无需在长文本上微调大语言模型,因此避免了显存开销,但效果通常不如经过特定微调的模型。目前主流的方法之一是streamingllm(流式大语言模型),该方式利用注意力下沉现象,通过修改注意力掩码矩阵,始终保持对起始几个token(词标识,即输入句子中的词在词表中的位置序号)的关注,从而扩大上下文长度,然而,该方式不符合金融大模型的需求,它只适用于满足多轮对话的需要,模型仅保持短期记忆,而项目需要直接注入大量上下文信息,需要模型关注全部输入数据,另一种则是通过改进模型的位置编码方式来扩大上下文信息,现有的方法有rerope(修正的旋转位置编码),通过对旋转位置编码的位置信息缩放到训练长度来适应长上下文情况。

7、在业务工作中,面对知识库和庞大工具prompt(提示词)描述的整合,原始的模型难以直接适应如此复杂的上下文环境,尽管考虑了对模型进行微调的可能性,但这涉及到额外的人力、时间和显存资源开销,不符合初期尝试的资源限制。因此,迫切需要一种方法,在允许牺牲少量模型性能的前提下,能在不进行微调的情况下将模型的上下文窗口扩展到所需的长度。

8、传统方法如streamingllm虽然在减少长上下文显存开销方面取得了一些进展,却未能满足对模型对所提供的全部上下文信息进行全面感知的要求,其他一些方法也未能在自建的模型上得以应用。

9、针对相关技术中的问题,目前尚未提出有效的解决方案。

技术实现思路

1、为了克服以上问题,本发明旨在提出一种用于扩展输入上下文长度的金融大模型长度外推方法,目的在于解决传统方法如streamingllm虽然在减少长上下文显存开销方面取得了一些进展,却未能满足对模型对所提供的全部上下文信息进行全面感知的要求,其他一些方法也未能在自建的模型上得以应用的问题。

2、为此,本发明采用的具体技术方案如下:

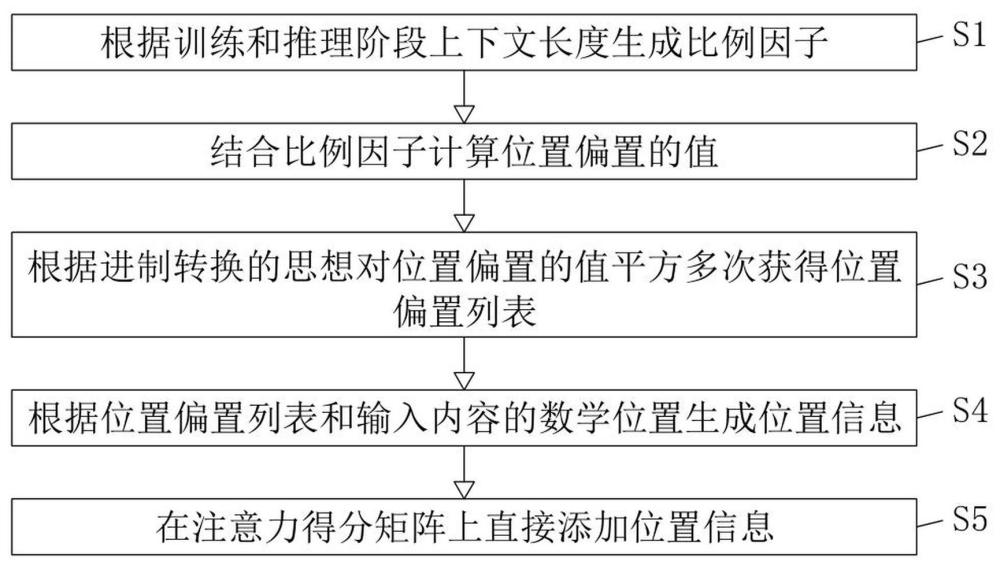

3、一种用于扩展输入上下文长度的金融大模型长度外推方法,该金融大模型长度外推方法包括以下步骤:

4、s1、根据训练和推理阶段上下文长度生成比例因子;

5、s2、结合比例因子计算位置偏置的值;

6、s3、根据进制转换的思想对位置偏置的值平方多次获得位置偏置列表;

7、s4、根据位置偏置列表和输入内容的数学位置生成位置信息;

8、s5、在注意力得分矩阵上直接添加位置信息。

9、可选地,计算位置偏置的公式为:

10、;

11、;

12、式中,表示位置偏置;

13、表示训练模型多头注意力机制的头数;

14、表示针对每个注意力头位置偏置的集合。

15、可选地,生成位置信息的计算公式为:

16、

17、式中,表示输入句子中每个词的数学位置;

18、表示不带比例因子的偏置集合生成的位置编码;

19、表示针对每个注意力头位置偏置的集合。

20、可选地,根据进制转换的思想对位置偏置的值平方多次获得位置偏置列表包括以下步骤:

21、s31、引入比例因子,计算优化模型在处理超出原始训练窗口长度的文本时的性能;

22、s32、利用位置编码计算公式和引入的比例因子计算新的偏置值;

23、s33、根据新的偏置值和注意力头数生成新的偏置列表。

24、可选地,引入比例因子,计算优化模型在处理超出原始训练窗口长度的文本时的性能的公式为:

25、;

26、式中,表示比例因子;

27、maxlength表示在推理时输入上下文的最大长度;

28、表示训练模型多头注意力机制的头数;

29、trainlength表示在训练模型时使用的训练语料的最大长度。

30、可选地,利用位置编码计算公式和引入的动态外推计算新的偏置值的公式为:

31、;

32、式中,表示引入比例因子后的位置偏置;

33、表示训练模型多头注意力机制的头数;

34、表示比例因子。

35、可选地,根据新的偏置值和比例因子生成新的偏置列表的计算公式为:

36、;

37、式中,newbisalist表示针对每个注意力头带比例因子的位置偏置集合;

38、表示比例因子;

39、表示位置偏置;

40、表示训练模型多头注意力机制的头数。

41、相较于现有技术,本技术具有以下有益效果:

42、1、本发明通过改进模型的位置编码,提升模型对更长上下文的处理能力,在尽量不损害模型性能的前提下,使模型更好地理解和利用更广泛的语境,从而提高其在处理输入长度超出训练任务时的表现。

43、2、本发明在模型的位置编码中引入了对长序列的更好适应性,通过优化位置编码的设计,有效地处理长文本中的复杂结构,保持信息的完整性和准确性,不仅仅是简单地将模型的记忆窗口扩展,更是对模型推理机制的深度优化,使其在长文本上的表现更为出色。

44、3、本发明能够避免信息的丢失和不连贯,通过对长文本进行外推,模型可以持续学习上下文之间的关系,而不受固定长度的限制,充分发挥了已有模型的能力,提高了在长上下文中的信息表示能力和语义一致性。

45、4、本发明可以扩展大型语言模型的能力,使其能够处理更复杂的文本,并更好地理解和推理长文本中的关系,通过长度外推方法,充分利用现有模型,提高其在长上下文中的性能和效率,特别是需要处理长文本的任务,具有重要的实际作用。

46、5、本发明过重新构建位置编码的细节,扩展上下文窗口,使其能够处理超出训练长度的上下文信息,无需对模型进行特定的微调,从而显著减轻了人力和时间成本,这使得模型能够迅速在扩展的上下文中运行,为项目的尝试提供了更为灵活的选择,通过扩展上下文窗口,有效地处理更加复杂和庞大的上下文信息,使模型在长上下文任务时表现更为卓越;此之外,还具有良好的兼容性,可与其他基于微调的方法协同运作,在进行上下文外推的同时进行长度微调,以进一步拓展模型的处理范围。

47、6、本发明过扩展输入上下文长度来提高模型在处理长文本推理任务时的效果,通过验证相应的数据集,证明了这一方法的有效性,其主要目标是在提供更长的上下文信息的情况下,无需调整模型参数配置即可赋予模型全文理解的能力,从而扩展了模型的上下文范围和摘要能力,这一创新的关键组成部分是采用动态长度外推方法,通过改进大型语言模型的位置编码,引入进制转换的概念去优化位置编码,从而扩展了已有大模型的上下文窗口长度,同时避免了大型模型在上下文窗口上的调优时间,提高了编程效率,总体而言,为大型语言模型引入外部知识、应对总结性任务等方面提供了重要的技术支持。

- 还没有人留言评论。精彩留言会获得点赞!