自验证式的探索预训练语言模型中明喻知识的方法及其系统

本发明属于自然语言处理,具体涉及一种自验证式的探索预训练语言模型中明喻知识的方法及其系统。

背景技术:

1、明喻是日常交流中常见的语言现象,对于使话语更加生动、有趣和易于理解在人类语言中扮演着重要角色(vlad niculae and cristian danescu-niculescu-mizil.brighter than gold:figurative language in user generated comparisons.inproceedings of the 2014 conference on empirical methods in natural languageprocessing,emnlp 2014;jiayi zhang,zhi cui,xiaoqiang xia,yalong guo,yanran li,chen wei,and jianwei cui.writing polishment with simile:task,dataset andaneural approach.in thirty-fifth aaai conference on artificial intelligence,aaai 2021.)。明喻通过共享属性来比较来自不同类别的两个事物(称为本体和喻体)(anthony m paul.figurative language.in philosophy&rhetoric,1970.)。本体和喻体通常通过诸如"like"或"as"等比较词连接。例如,"the man is as strong as a bull."(这个男人像一头公牛一样强壮)是一个明喻,其中本体(tenor)是"the man"(这个男人),喻体(vehicle)是"abull"(一头公牛),比较词是"as...as"(像…一样),共享属性(property)是"strong"(强壮)。相比之下,"the girl looks like her mother."(这个女孩长得像她母亲)不是明喻,因为这句话比较的是同一类别中的两个事物(比较两个人的长相)。这种语言现象在明喻研究中通常被称为literal(ehsan aghazadeh,mohsen fayyaz,and yadollah yaghoobzadeh.metaphors in pre-trained language models:probingand generalization across datasets and languages.in proceedings of the 60thannual meeting of the association for computational linguistics,acl 2022;rowan hall maudslay and simone teufel.metaphorical polysemy detection:conventional metaphor meets word sense disambiguation.in proceedings of the29th international conference on computational linguistics,coling 2022),本文将literal翻译为非明喻。

2、自然语言处理研究中有各种类型的明喻任务。不同类型的明喻任务要求模型具备不同类型的明喻知识。例如,明喻识别(sr)任务是一个二元分类任务(yulia tsvetkov,leonid boytsov,anatole gershman,eric nyberg,and chris dyer.metaphor detectionwith cross-lingual model transfer.in proceedings of the 52nd annual meetingof the association for computational linguistics,acl 2014),要求模型判断文本序列(例如三元组或句子)是否为明喻。明喻解释(si)任务要求模型为明喻生成解释文本(yuri bizzoni and shalom lappin.2018.predicting human metaphor paraphrasejudgments with deep neural networks.in proceedings of the workshop onfigurative language processing,fig-lang@naacl-hlt 2018)或推断本体和喻体的共享属性(qianyu he,sijie cheng,zhixu li,rui xie,and yanghua xiao.can pre-trainedlanguage models interpret similes as smart as human?in proceedings of the60th annual meeting of the association for computational linguistics,acl2022)。明喻生成(sg)任务要求模型生成缺失的喻体(wei song,jingjin guo,ruiji fu,ting liu,and lizhen liu.a knowledge graph embedding approach for metaphorprocessing.ieee acm trans.audio speech lang.process.2021;kexin yang,dayihengliu,wenqiang lei,baosong yang,xiangpeng wei,zhengyuan liu,and junxie.fantastic expressions and where to find them:chinese simile generationwith multiple constraints.in proceedings of the 61st annual meeting of theassociation for computational linguistics,acl 2023)或一个明喻句子(yucheng li,chenghua lin,and frank guerin.cm-gen:a neural framework for chinese metaphorgeneration with explicit context modelling.in proceedings of the29thinternational conference on computational linguistics,coling 2022)。

3、近年来,预训练语言模型(pre-trained language models,plms)在自然语言处理领域取得了巨大成功,因为它们从大型语料库中学习了通用知识(jacob devlin,ming-weichang,kenton lee,and kristina toutanova.bert:pre-training of deepbidirectional transformers for language understanding.in proceedings of the2019 conference of the north american chapter of the association forcomputational linguistics:human language technologies,naacl-hlt 2019;colinraffel,noam shazeer,adam roberts,katherine lee,sharan narang,michael matena,yanqi zhou,wei li,and peter j.liu.exploring the limits of transfer learningwith a unified text-to-text transformer.j.mach.learn.res.,2020)。在明喻研究中,也已经付出了相当多的努力,探索从plms中获取明喻知识以解决sr/si/sg任务(weijiechen,yongzhu chang,rongsheng zhang,jiashu pu,guandan chen,le zhang,yadong xi,yijiang chen,and chang su.probing simile knowledge from pre-trained languagemodels.in proceedings of the 60th annual meeting of the association forcomputational linguistics,acl 2022)。例如,一种广泛采用的方法是对plms进行微调以适应特定的明喻任务(tuhin chakrabarty,smaranda muresan,and nanyunpeng.generating similes effortlessly like a pro:a style transfer approach forsimile generation.in proceedings of the 2020 conference on empirical methodsin natural language processing,emnlp 2020)。然而,先前的工作通常只探索了一种类型的明喻知识来解决特定的明喻任务,这并没有充分利用plms的能力,因为先前的研究也表明plms拥有多种类型的明喻知识(qianyu he,xintao wang,jiaqing liang,andyanghua xiao.maps-kb:a million-scale probabilistic simile knowledge base.inthirty-seventh aaai conference on artificial intelligence,aaai 2023)。

4、本发明研究了如何利用多种类型的明喻知识来完成明喻任务。具体而言,当使用plms执行明喻任务(si/sg)时,除了与该任务直接相关的明喻知识之外,本发明希望plms还可以利用其他间接的明喻知识(sr)。间接的明喻知识可以作为一种自我验证的视角,以提高目标任务的性能,从而充分利用plms中的多种类型的明喻知识。然而,不同类型的明喻知识之间存在差距。例如,sr任务要求plms区分明喻和非明喻,而si/sg任务要求plms生成缺失的明喻组成部分。sr和si/sg任务在任务格式和训练对象上有所不同。直接利用明喻识别知识来辅助si/sg任务是困难的。为了解决这个问题,本发明提出了一种新颖的任务,称为多级明喻识别(multi-level simile recognition,mlsr),以对齐不同类型的明喻知识。mlsr任务将sr任务从二元分类扩展到多类别分类。经过mlsr训练后,plms不仅可以区分明喻和非明喻,还可以为给定的明喻分配质量分数。然后,这个质量分数可以作为一种自我验证机制来评估si/sg任务的生成结果,并根据评估重新组织结果。通过这种方式,本发明整合了plms中的不同类型的明喻知识,并更好地利用了它们。对多个明喻数据集的实验表明,本发明的方法达到了新的最先进性能。本发明还测试了不同plms的方法,结果表明本发明提出的自验证方法适用于不同类型的plms,并且可以应用于更大规模的语言模型。

技术实现思路

1、本发明提供一种自验证式的探索预训练语言模型中明喻知识的方法,为解决现有预训练语言模型无法很好评价明喻好坏从而无法很好地探索明喻知识的问题。

2、本发明提供一种自验证式的探索预训练语言模型中明喻知识的系统,为了实现一种自验证式的探索预训练语言模型中明喻知识的方法。

3、本发明还提供一种计算机设备。

4、本发明还提供一种计算机可读存储介质。

5、发明通过以下技术方案实现:

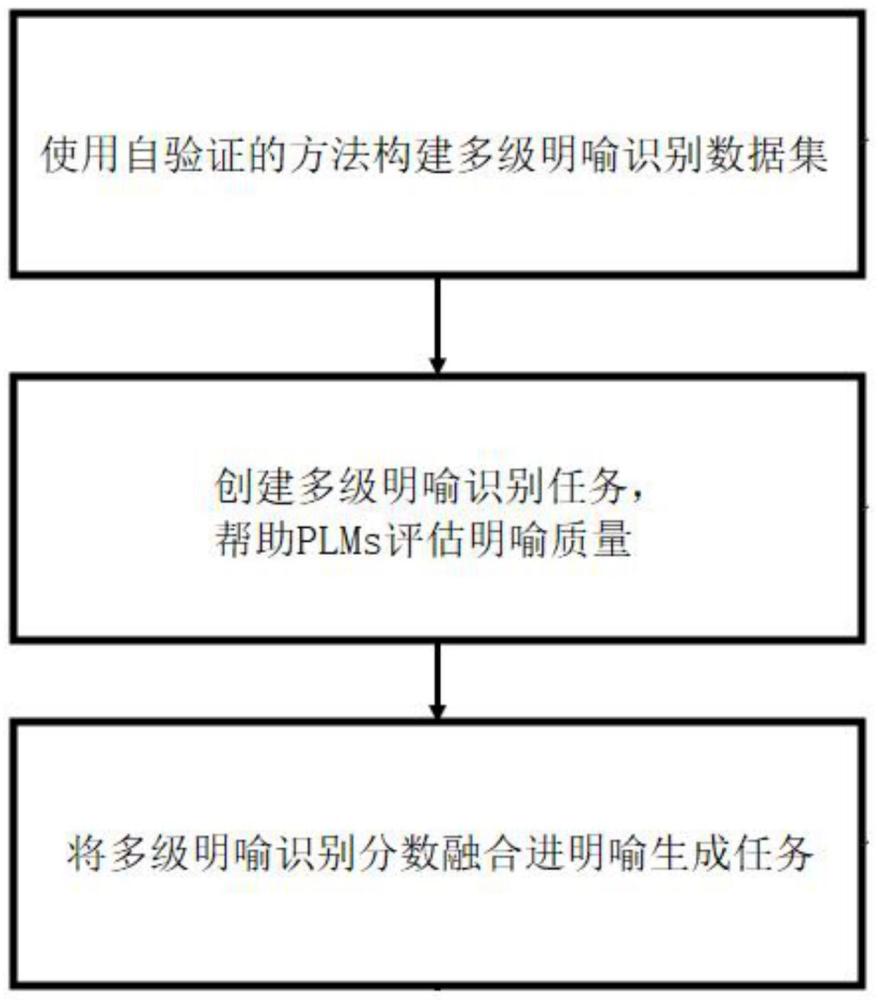

6、一种自验证式的探索预训练语言模型中明喻知识的方法,所述方法包括以下步骤,

7、步骤1、构建多级明喻识别数据集;

8、步骤2、创建多级明喻识别任务,帮助plms评估明喻质量;

9、步骤3、将多级明喻识别分数融合进明喻生成任务。

10、进一步的,所述步骤1具体为,构建具有多个明喻级别的明喻数据;利用明喻数据训练plms为每个级别分配质量分数。

11、进一步的,定义四个具有不同明喻质量的明喻级别;

12、第一级是正确的明喻,其中在明喻组成部分之间有三种健康的明喻关系;其余级别是通过替换明喻组成部分构建,并且导致明喻关系受到不同程度的损害;

13、第二层级有两种替换方式,第一种替换方式具体为,将喻体替换为其上位词;

14、第二种替换方式具体为,用本体的同义词替换喻体;

15、第三层级将喻体或共享属性按照替换规则进行替换;

16、第四层次使用替换规则替换所有共享属性和喻体。

17、进一步的,所述替换规则,首先,替换使用与原词相同词性的词语,即共享属性被替换为形容词,而主体/喻体被替换为可作为动词主语/宾语的名词/短语/句子;

18、其次,利用conceptnet中的关系来选择更合适的词语;

19、在第二层次中,使用conceptnet中的“isa”关系来找到主体/喻体的上义词;在第四层次中,当替换喻体时,选择与该喻体不共享属性的名词/短语;当替换属性时,选择与主体和喻体没有关系的形容词;

20、当明喻组件超过一个词时,使用该组件中的第一个名词或形容词进行替换;

21、当conceptnet中没有可用的明喻组件,或者无法找到合适的替换时,仅遵循第一条规则,并从conceptnet中随机选择词语。

22、进一步的,所述步骤2具体为,采用多级对比学习方法来训练plm;对于每个明喻层次,分配一个介于0和1之间的参考分数(1.000,0.667,0.333,0.000);在训练过程中,mlsr模型学习预测输入序列的分数;训练目标是最小化预测分数与参考分数之间的距离;假设参考质量分数与明喻层次之间存在线性关系,是让模型自动学习不同层次的质量分数;

23、在使用bert作为骨干结构时mlsr的模型结构;第一个输出位置被用作序列表示;当将的方法应用于其他具有解码器结构的plm时,第一个解码向量被用作输入表示以计算mlsr损失;将输入序列表示为,将输入序列集合表示为d,将d中一个句子表示为hd;hd使用一个多层感知器来获取输入序列d的预测质量分数sd:

24、sd=σ(w2·μ(w1·hd+b1)+b2),

25、分别使用sigmoid函数和tanh函数;将每个明喻层次分别表示为di(i∈{1,2,3,4});然后,使用分离损失和紧凑性损失来训练mlsr模型。

26、进一步的,分离损失通过区分代表不同明喻层级的质量分数来区分不同的明喻层次;对于每个明喻层次i,首先计算一个中心分数其中是这个层次的质量分数,ki是训练批次中di的示例数;不同明喻层次之间的分离损失为:

27、

28、其中,λ=0.333是两个中心分数之间距离的下限,ω=l-j是用于根据明喻质量差距放大下限的权重;

29、紧凑性损失将同一明喻层次中的示例压缩在一起,以避免每个层次的异常值;

30、具体而言,对于k∈{1,2,...,ki}中的每个示例,其明喻质量分数被强制与相应的中心分数更接近,如下所示:

31、

32、其中,γ是某个替换级别的中心点与该级别内得分之间距离的上限;γ允许模型在一定范围内自动调整每个级别的质量分数;mlsr的最终损失为:

33、

34、其中,n是训练样本的数量;训练完成后,mlsr模型可以为输入序列分配一个明喻质量分数。

35、进一步的,所述步骤3具体为,当使用bert作为骨干网络时,si和sg任务与bert中的mlm任务相同;其中bert学习恢复被掩蔽的属性或喻体;当对si/sg任务使用具有解码器结构的其他plms时,提供给plms一个任务指示和被遮蔽的序列,并要求plms生成缺失的组件;损失函数为:

36、

37、其中,表示被掩蔽的属性/喻体的第t个单词,

38、训练一个单一的plm来处理所有三个明喻任务,即mlsr、si和sg;损失函数为在si/sg测试中,遵循先前的工作,plms从候选池中选择缺失的属性或喻体;

39、在使用bert进行实验时,使用bert的遮蔽词预测头来计算每个候选的概率;具有最高概率的候选将被选为最终选择;当使用其他具有解码器结构的大型plms进行si/sg任务时,提供一份指示,并要求plms生成缺失的组件;每个候选的概率是生成概率;

40、为了利用mlsr结果进行自验证,将每个候选项连接到输入序列作为新输入;然后模型可以计算该候选的mlsr分数;每个候选的最终得分sfinal是mlsr分数smlsr和si/sg分数ssi/sg的加权和:

41、sfinal=β*smlsr+(1-β)*ssi/sg

42、其中,β是超参数。

43、一种自验证式的探索预训练语言模型中明喻知识的系统,所述系统使用如上述自验证式的探索预训练语言模型中明喻知识的方法,所述系统包括,

44、数据集构建模块,构建多级明喻识别数据集;

45、明喻识别创建模块,创建多级明喻识别任务,帮助plms评估明喻质量;mlsr得分作为一种自我验证机制,用于对齐不同类型明喻任务中使用的明喻知识;

46、明喻生成模块,将多级明喻识别分数融合进明喻生成任务。

47、一种计算机设备,包括存储器、处理器及存储在存储器上并可在处理器上运行的计算机程序,所述处理器执行所述计算机程序时,实现如上述的方法。

48、一种计算机可读存储介质,所述计算机可读存储介质内存储有计算机程序,所述计算机程序被处理器执行时实现上述的方法。

49、本发明的有益效果是:

50、本发明将传统的明喻识别(sr)任务从二元分类扩展到多类别分类。经过mlsr训练后,plms不仅可以区分明喻和非明喻,还可以为给定的明喻分配质量分数。

51、本发明利用mlsr分数作为一种自我验证机制来评估明喻解释/生成(si/sg)任务的结果,并根据评估重新组织结果。通过这种方式,本发明整合了plms中的不同类型的明喻知识,并更好地利用了它们。

52、在探索预训练语言模型中明喻知识的准确率方面起到很好的提升作用。在多个明喻数据集的实验表明,本发明的方法达到了新的最先进性能(比现有方法提升5%以上的准确度)。

53、本发明还测试了不同plms的方法,结果表明,自我验证方法适用于不同类型的plms,例如t5模型(exploring the limits of transfer learning with a unifiedtext-to-text transformer),并且可以应用于具有更大规模的语言模型。

- 还没有人留言评论。精彩留言会获得点赞!