基于柔性基板的表情识别方法、系统、计算机设备及可读存储介质

本发明属于人工智能,具体地涉及一种基于柔性基板的表情识别方法、系统、计算机设备及可读存储介质。

背景技术:

1、在汽车人工智能领域,实时识别驾驶员的情绪,已成为解决疲劳驾驶、醉酒驾驶等问题的重要的解决方案,这有利于提高驾驶员的安全性。

2、许多功能用来提高实时识别情绪的的准确性,例如声音、文字、生物电信号等,某些语音和文字功能可用于识别人们的情绪状态。但在现实的驾驶情况下,如高速驾驶,获取这些特征的难度较大。相比而言,视觉特征的获取比较容易。

3、目前有一些方案是通过面部表情来识别情绪,例如,基于照相机的检测,通过定时拍摄观察者的面部表情判断用户情绪。通常,面部识别方法有两种,即基于几何的方法和基于外观的方法。然而,此两种方法使用面部表情特征在准确识别情绪这一方面,需要基于持续时间长且对复杂的面部表情行为进行采样以获取大量图像样本、并经过深度神经网络训练学习,进而进行识别。

4、但是,由于人的面部表情行为是非常复杂且多样的,且会随着时间的推移产生新的表情行为,甚至同一种表情行为在不同环境下具备不同语义,也都是非常常见的情况。因此,延续动作识别采用将所有面部可能产生的复杂表情行为进行采样需要获取大量图像样本数据,并进行人工标注的现有技术的解决思路,不仅耗费巨大,而且精准度及模型普适性极低。

5、此外,基于图像及视频序列来识别表情,特别是微表情和微动作,仅仅采用卷积神经网络算法还受限于表情捕捉的精确程度,很难达到较高的准确度。

6、因此,针对现有视频中针对面部复杂表情识别技术存在的图像样本数据要求多、识别精准度及模型普适性差的技术问题,尚未提出有效的解决方案。

技术实现思路

1、为了解决上述技术问题,本发明提供了一种基于柔性基板的表情识别方法、系统、计算机设备及可读存储介质,通过柔性基板上的传感器获取人脸面部的三维数字化微表情数据,使得所述人的面部三维动态微表情和微动作予以精确地展示,三维运动信息转化成数字化矩阵进行传递,显著降低了数据体量,提高了数据的传输性能。

2、第一方面,本技术实施例提供一种基于柔性基板的表情识别方法,所述柔性基板用于贴合于人的面部,且所述柔性基板由多个贴合于人的面部局部区域的柔性基片组成,多个压电薄膜传感器设置于所述柔性基片,其中,所述方法包括:

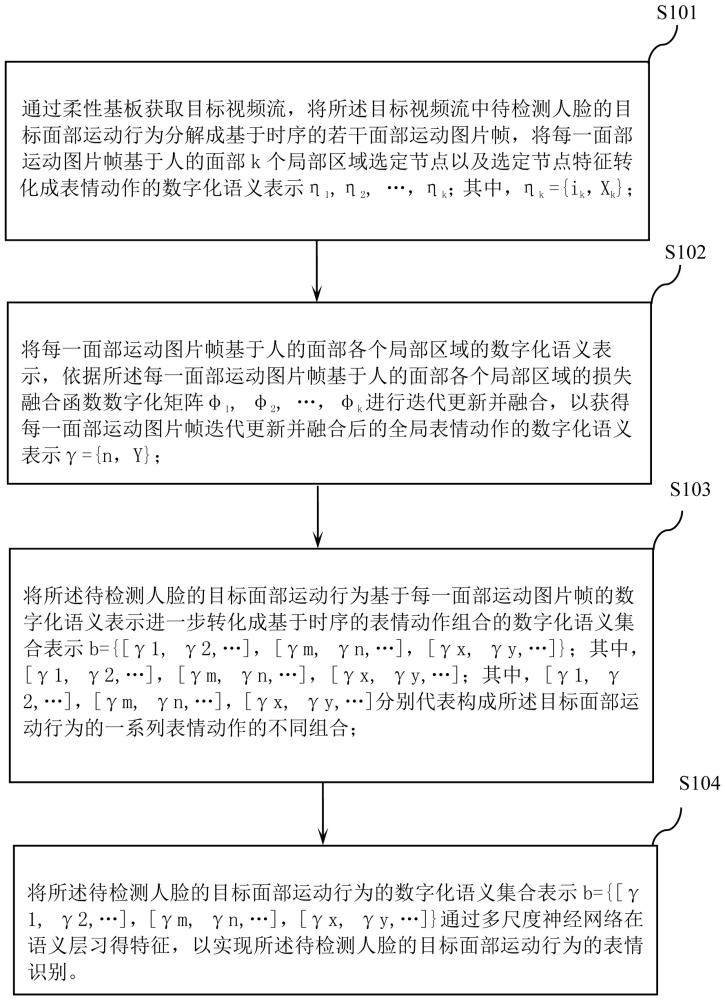

3、s1、通过柔性基板获取目标视频流,将所述目标视频流中待检测人脸的目标面部运动行为分解成基于时序的若干面部运动图片帧,将每一面部运动图片帧基于人的面部k个局部区域选定节点以及选定节点特征转化成表情动作的数字化语义表示η1,η2,…,ηk;其中,ηk={ik,xk},其中,ik代表第k个局部区域表情动作的动作名称,xk代表第k个局部区域表情动作的数字化特征矩阵;其中,所述面部运动图片帧基于人的面部局部区域选定节点的运行信息由一组浮点数进行数字化表示;

4、s2、将每一面部运动图片帧基于人的面部各个局部区域的数字化语义表示,依据所述每一面部运动图片帧基于人的面部各个局部区域的损失融合函数数字化矩阵φ1,φ2,…,φk进行迭代更新并融合,以获得每一面部运动图片帧迭代更新并融合后的全局表情动作的数字化语义表示γ={n,y},其中,n代表全局表情动作的动作名称,y代表全局表情动作的数字化特征矩阵;

5、s3、将所述待检测人脸的目标面部运动行为基于每一面部运动图片帧的数字化语义表示进一步转化成基于时序的表情动作组合的数字化语义集合表示b={[γ1,γ2,…],[γm,γn,…],[γx,γy,…]};其中,[γ1,γ2,…],[γm,γn,…],[γx,γy,…];其中,[γ1,γ2,…],[γm,γn,…],[γx,γy,…]分别代表构成所述目标面部运动行为的一系列表情动作的不同组合;

6、s4、将所述待检测人脸的目标面部运动行为的数字化语义集合表示b={[γ1,γ2,…],[γm,γn,…],[γx,γy,…]}通过多尺度神经网络在语义层习得特征,以实现所述待检测人脸的目标面部运动行为的表情识别。

7、较佳地,所述每一面部运动图片帧基于人的面部k个局部区域的损失融合函数数字化矩阵φ1,φ2,…,φk融合后的全局表情动作的数字化特征矩阵y为η1×φ1+η2×φ2+…+ηk×φk。

8、较佳地,所述每一面部运动图片帧进一步基于人的面部k个局部区域的边界融合函数数字化矩阵ω1,ω2,…,ωk融合后的全局表情动作的数字化特征矩阵y为η1×φ1×ω1+η2×φ2×ω2+…+ηk×φk×ωk。

9、较佳地,所述面部运动图片帧基于人的面部局部区域选定节点以及选定节点特征,采用词向量浮点向量方式进行动作词表示;其中,所述选定节点特征包括运动速度、运动方向、运动强度、瞬时运动位移以及单位时间内的总位移量中的一种或多种组合。

10、第二方面,本技术实施例提供一种基于柔性基板的表情识别系统,所述柔性基板用于贴合于人的面部,且所述柔性基板由多个贴合于人的面部局部区域的柔性基片组成,多个压电薄膜传感器设置于所述柔性基片,其中,所述系统包括:

11、定义模块,用于通过柔性基板获取目标视频流,将所述目标视频流中待检测人脸的目标面部运动行为分解成基于时序的若干面部运动图片帧组,将每一面部运动图片帧基于人的面部k个局部区域选定节点以及选定节点特征转化成表情动作的数字化语义表示η1,η2,…,ηk;其中,ηk={ik,xk},其中,ik代表第k个局部区域表情动作的动作名称,xk代表第k个局部区域表情动作的数字化特征矩阵;其中,所述面部运动图片帧基于人的面部局部区域选定节点的运行信息由一组浮点数进行数字化表示;

12、融合模块,用于将每一面部运动图片帧基于人的面部各个局部区域的数字化语义表示,依据所述每一面部运动图片帧基于人的面部各个局部区域的损失融合函数数字化矩阵φ1,φ2,…,φk进行迭代更新并融合,以获得每一面部运动图片帧迭代更新并融合后的全局表情动作的数字化语义表示γ={n,y},其中,n代表全局表情动作的动作名称,y代表全局表情动作的数字化特征矩阵;

13、构建模块,用于将所述待检测人脸的目标面部运动行为基于每一面部运动图片帧的数字化语义表示进一步转化成基于时序的表情动作组合的数字化语义集合表示b={[γ1,γ2,…],[γm,γn,…],[γx,γy,…]};其中,[γ1,γ2,…],[γm,γn,…],[γx,γy,…];其中,[γ1,γ2,…],[γm,γn,…],[γx,γy,…]分别代表构成所述目标面部运动行为的一系列表情动作的不同组合;

14、识别模块,用于将所述待检测人脸的目标面部运动行为的数字化语义集合表示b={[γ1,γ2,…],[γm,γn,…],[γx,γy,…]}通过多尺度神经网络在语义层习得特征,以实现所述待检测人脸的目标面部运动行为的表情识别。

15、较佳地,所述每一面部运动图片帧基于人的面部k个局部区域的损失融合函数数字化矩阵φ1,φ2,…,φk融合后的全局表情动作的数字化特征矩阵y为η1×φ1+η2×φ2+…+ηk×φk。

16、较佳地,所述每一面部运动图片帧进一步基于人的面部k个局部区域的边界融合函数数字化矩阵ω1,ω2,…,ωk融合后的全局表情动作的数字化特征矩阵y为η1×φ1×ω1+η2×φ2×ω2+…+ηk×φk×ωk。

17、较佳地,所述面部运动图片帧基于人的面部局部区域选定节点以及选定节点特征,采用词向量浮点向量方式进行动作词表示;其中,所述选定节点特征包括运动速度、运动方向、运动强度、瞬时运动位移以及单位时间内的总位移量中的一种或多种组合。

18、第三方面,本技术实施例提供一种计算机设备,包括存储器、处理器以及存储在所述存储器上并可在所述处理器上运行的计算机程序,所述处理器执行所述计算机程序时实现上述所述的表情识别方法。

19、第四方面,本技术实施例提供一种可读存储介质,其上存储有计算机程序,该程序被处理器执行时实现上述所述的表情识别方法。

20、相比现有技术,本技术实施例提供的基于柔性基板的表情识别方法、系统、计算机设备及可读存储介质的有益效果为:通过柔性基板获取目标视频流,将所述目标视频中分解成基于时序的若干面部运动图片帧组,将每一面部运动图片帧基于人的面部k个局部区域选定节点以及选定节点特征转化成k个局部表情动作的数字化语义表示;基于人的面部k个局部区域的损失融合函数数字化矩阵φ1,φ2,…,φk进行更新并融合获得全局表情动作的数字化语义,以实现所述目标面部运动行为的表情识别。本技术通过所述目标面部运动行为三维数字化矩阵,使得所述人的面部三维动态微表情和微动作予以精确地展示,三维运动信息转化成数字化矩阵进行传递,显著降低了数据体量,提高了数据的传输性能。

- 还没有人留言评论。精彩留言会获得点赞!