本发明涉及相机重定位,尤其涉及一种基于稠密点云与全景图像的全景相机位姿估计方法及装置。

背景技术:

1、当前主流的视觉定位方法主要面向的是普通工业相机,普通工业相机的视场角和观测场景范围有限,定位精度受重复结构、视觉特征或场景变化的影响大,甚至无法进行定位。全景相机具备全景观测能力,解决了普通工业相机视场角受限的问题,有利于提升基于视觉定位的能力。但全景相机拍摄的全景图像具有严重的畸变,传统的视觉定位算法难以直接应用于全景图像。因此,开发一种基于全景图像和稠密点云的全景相机位姿估计算法,充分发挥全景相机360度视场角的优势,提升了全景相机的定位能力。

技术实现思路

1、本发明所要解决的技术问题在于,提供一种基于稠密点云与全景图像的全景相机位姿估计方法及装置,解决了全景图像失真的问题,实现了全景相机快速准确的自主定位。

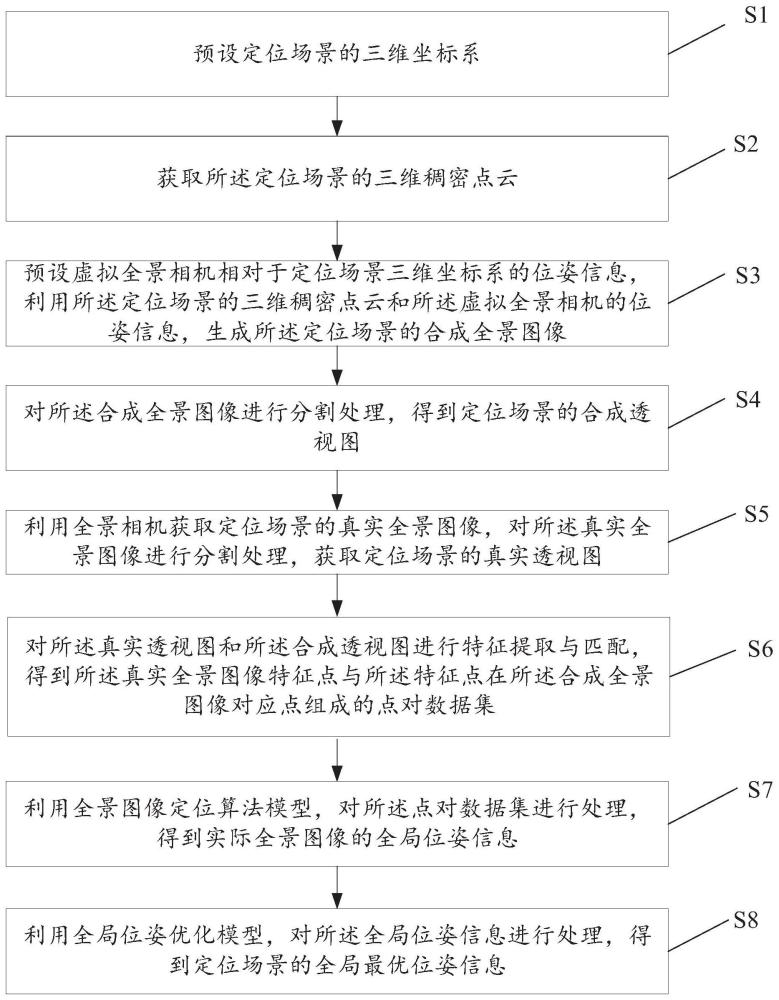

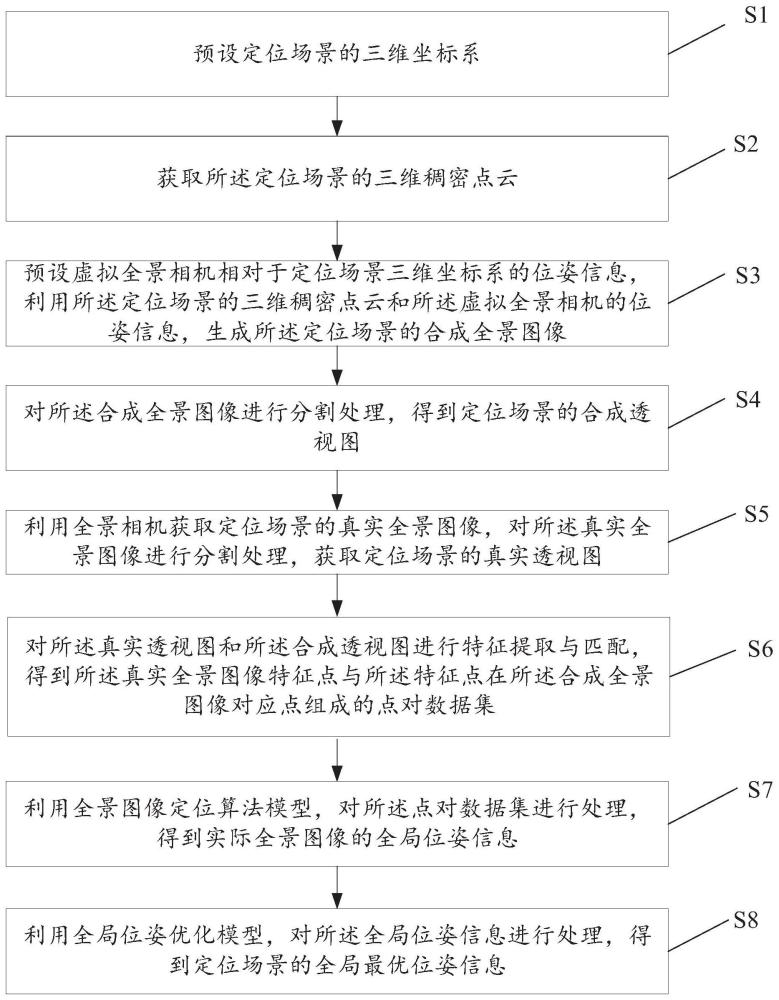

2、为了解决上述技术问题,本发明实施例第一方面公开了一种全景相机位姿估计方法,所述方法包括:

3、s1,预设定位场景的三维坐标系;

4、以用户需求为依据,预设所述定位场景的三维坐标系;

5、s2,获取所述定位场景的三维稠密点云;所述稠密点云包含3d点的三维坐标和颜色值信息;所述稠密点云长、宽、高与所述定位场景的长、宽、高相一致,稠密点云的坐标系设置与所述定位场景坐标系的设置相一致;

6、s3,预设虚拟全景相机相对于定位场景三维坐标系的位姿信息,利用所述定位场景的三维稠密点云和所述虚拟全景相机的位姿信息,生成所述定位场景的合成全景图像;

7、s4,对所述合成全景图像进行分割处理,得到所述定位场景的合成透视图;

8、s5,利用全景相机获取定位场景的真实全景图像,对所述真实全景图像进行分割处理,得到所述定位场景的真实透视图;

9、s6,对所述真实透视图和所述合成透视图进行特征提取与匹配,得到所述真实全景图像特征点与所述特征点在所述合成全景图像对应点组成的点对数据集;

10、s7,利用全景图像定位算法模型,对所述点对数据集进行处理,得到实际全景图像的全局位姿信息;

11、s8,利用全局位姿优化模型,对所述全局位姿信息进行处理,得到定位场景的全局最优位姿信息。

12、作为一种可选的实施方式,本发明实施例第一方面中,所述预设虚拟全景相机相对于定位场景三维坐标系的位姿信息,利用所述定位场景的三维稠密点云和所述虚拟全景相机的位姿信息,生成所述定位场景的合成全景图像,包括:

13、s31,预设虚拟全景相机相对于定位场景三维坐标系的位姿信息,得到所述虚拟全景相机的位姿信息(r,t);

14、s32,利用所述虚拟全景相机的位姿信息(r,t),对所述定位场景坐标系下稠密点云的三维点,进行3d坐标转换处理,得到全景相机坐标系下的3d点;

15、所述3d坐标转换表达式为:

16、

17、其中,(x,y,z)为定位场景坐标系下的3d点坐标,(x,y,z)为全景相机坐标系下的3d点坐标,r为定位场景坐标系到全景相机坐标系的旋转矩阵,t为定位场景坐标系到全景相机坐标系的平移向量;

18、s33,对所述全景相机坐标系下的3d点进行像素坐标转换处理,得到全景图像坐标系上的像素坐标;

19、所述像素坐标转换表达式为:

20、

21、

22、

23、其中,w,h分别为所述合成全景图像的宽、高,u、v为投影点的像素坐标,xu,yv分别为投影点在全景图像坐标系下的坐标,α,β分别是全景相机坐标系下的3d点在全景相机坐标系下的方位角与高低角,(x,y,z)为全景相机坐标系下的3d点坐标值;

24、s34,将n个所述像素坐标按坐标顺序进行组合,得到所述合成全景图像。

25、作为一种可选的实施方式,本发明实施例第一方面中,所述对所述合成全景图像进行分割处理,得到所述定位场景的合成透视图,包括:

26、s41,按照立方体格式预设6张合成透视图,所述预设合成透视图大小一样,且所述预设合成透视图的水平视场角与垂直视场角皆为90°,得到所述合成透视图成像内参k1值;

27、k1值表达式为:

28、

29、其中,

30、s42,利用像素坐标对应关系模型,对所述合成全景图像中像素坐标对应的3d点进行处理,得到所述3d点在所述合成透视图中的像素坐标以及对应像素值;

31、所述像素坐标对应关系模型表达式为:

32、

33、

34、

35、

36、其中,(u1,v1)为所述合成透视图特征点像素值,(x,y,z)为全景相机坐标系下的3d点,(up,vp)为投影点在全景球面图像坐标系下的坐标,(xu,yv)为投影点在全景图像坐标系下的坐标,α,β分别是全景相机坐标系下的3d点在全景相机坐标系下的方位角与高低角,r为全景相机坐标系到合成透视图所对应的虚拟透视相机坐标系的旋转矩阵,k1为合成透视图成像内参;

37、s43,将n个所述像素坐标按坐标顺序进行组合,得到所述合成透视图。

38、作为一种可选的实施方式,本发明实施例第一方面中,所述利用全景相机获取定位场景的真实全景图像,对所述真实全景图像进行分割处理,得到所述定位场景的真实透视图,包括:

39、s51,利用全景相机获取所述定位场景的真实全景图像;

40、s52,按照立方体格式预设6张真实透视图,所述真实透视图大小一样,且所述预设真实透视图的水平视场角与垂直视场角皆为90°,得到所述真实透视图成像内参k2值;

41、k2值表达式为:

42、

43、其中,

44、s53,利用像素坐标对应关系模型,对所述真实全景图像中像素坐标对应的3d点进行处理,得到所述3d点在所述真实透视图中的像素坐标以及对应像素值;

45、所述像素坐标对应关系模型表达式为:

46、

47、

48、

49、

50、其中,u2,v2为所述真实透视图像素值,(x,y,z)为全景相机坐标系下的3d点,(xu,yv)分别为投影点在全景图像坐标系下的坐标,(up,vp)为投影点在全景球面图像坐标系下的坐标,α,β分别是全景相机坐标系下的3d点在全景相机坐标系下的方位角与高低角,r为全景相机坐标系到真实透视图所对应的虚拟透视相机坐标系的旋转矩阵,k2为真实透视图成像内参;

51、s54,将n个所述像素坐标按坐标顺序进行组合,得到所述真实透视图。

52、作为一种可选的实施方式,本发明实施例第一方面中,所述对所述真实透视图和所述合成透视图进行特征提取与匹配,得到所述真实全景图像特征点与所述特征点在所述合成全景图像对应点组成的点对数据集,包括:

53、s61,对所述真实透视图进行编号处理,获取第一真实透视图、第二真实透视图、第三真实透视图、第四真实透视图、第五真实透视图、第六真实透视图;

54、所述第一真实透视图为位于立方体前方的真实透视图,所述第二真实透视图为位于立方体后方的真实透视图,所述第三真实透视图为位于立方体左面的真实透视图,所述第四真实透视图为位于立方体右面的真实透视图,所述第五真实透视图为位于立方体上方的真实透视图,所述第六真实透视图为立方体下方的真实透视图;

55、对所述合成透视图进行编号处理,获取第一合成透视图、第二合成透视图、第三合成透视图、第四合成透视图、第五合成透视图、第六合成透视图;

56、所述第一合成透视图为位于立方体前方的合成透视图,所述第二合成透视图为位于立方体后方的合成透视图,所述第三合成透视图为位于立方体左面的合成透视图,所述第四合成透视图为位于立方体右面的合成透视图,所述第五合成透视图为位于立方体上方的合成透视图,所述第六合成透视图为立方体下方的合成透视图;

57、s62,对所述第一真实透视图和第一合成透视图、所述第二真实透视图和第二合成透视图、所述第三真实透视图和第三合成透视图、所述第四真实透视图和第四合成透视图、第五真实透视图和第五合成透视图、所述第六真实透视图和第六合成透视图,两两进行特征提取与匹配,得到所述真实透视图和合成透视图的特征点2d-2d点对;

58、s63,对所述真实透视图和合成透视图的特征点2d-2d点对进行转换,得到真实全景图像特征点和定位场景坐标系下对应点的特征点2d-3d点对;

59、s64,将n个所述特征点2d-3d点对按坐标顺序进行组合,得到所述真实全景图像特征点与合成全景图像的对应点的点对数据集。

60、作为一种可选的实施方式,本发明实施例第一方面中,所述利用自监督特征提取算法神经网络模型和图卷积特征匹配算法神经网络模型,对所述第一真实透视图和第一合成透视图、所述第二真实透视图和第二合成透视图、所述第三真实透视图和第三合成透视图、所述第四真实透视图和第四合成透视图、第五真实透视图和第五合成透视图、所述第六真实透视图和第六合成透视图,,两两进行特征提取与匹配,得到所述真实透视图和合成透视图的特征点2d-2d点对,包括:

61、s621,采用superpoint自监督特征提取算法神经网络模型,对对所述第一真实透视图和第一合成透视图、所述第二真实透视图和第二合成透视图、所述第三真实透视图和第三合成透视图、所述第四真实透视图和第四合成透视图、第五真实透视图和第五合成透视图、所述第六真实透视图和第六合成透视图,两两进行处理,实现图像特征提取,得到所述特征点的位置、置信度及特征点对应的描述符;

62、s622,将所述特征点及描述符,输入superglue图卷积特征匹配算法神经网络模型,得到所述真实透视图和合成透视图的特征点2d-2d点对。

63、作为一种可选的实施方式,本发明实施例第一方面中,所述利用全景图像定位算法模型,对所述点对数据集进行处理,得到所述真实全景图像的第一全局位姿信息,包括:

64、s71,利用特征点对预处理模型,将述所述真实全景图像特征点转换为全景相机坐标系下特征点的单位向量;

65、所述特征点对预处理模型表达式为:

66、

67、

68、

69、其中,w,h分别为所述真实全景图像的宽、高,u、v为所述真实透视图特征点的像素坐标,xu,yv分别为所述真实全景图像特征点在全景图像坐标系下的坐标,α,β分别是全景相机坐标系下的3d点的方位角与高低角,(x,y,z)为全景相机坐标系下特征点的单位向量;

70、s72,利用控制点求解模型,将所述定位场景坐标系下的3d点转化为全景相机坐标系下的3d点;

71、所述控制点求解模型表达式为:

72、

73、

74、

75、

76、其中,为通过主成分分析获得的定位场景坐标系下四个控制点坐标,为定位场景坐标系下的3d特征点坐标,kij为权重,(xi,yi,zi)为所述全景相机坐标系下特征点的单位向量,为全景相机坐标系下控制点坐标,为全景相机坐标系下的3d特征点坐标;与组成3d-3d点对数据。

77、s73,对所述3d-3d点对使用点云配准进行解算,得到所述真实全景图像的第一全局位姿信息。

78、作为一种可选的实施方式,本发明实施例第一方面中,所述利用全局位姿优化模型,对所述第一全局位姿信息进行处理,得到定位场景的最优全局位姿信息,包括:

79、s81,预设优化步长与目标迭代次数;

80、s82,初始化迭代次数为0;

81、s83,将所述第一全局位姿信息输入全局位姿优化模型,得到第一颜色值损失值;

82、所述全局位姿优化模型表达式为:

83、

84、其中,l(r,t)为颜色损失值,pi为定位场景坐标系下的3d点坐标,r,t为定位场景坐标系到全景图像坐标系的转换关系,π(·)为所述3d点到全景图像像素坐标的映射函数,γ(·)为采样函数,i为被采样全景图像,c为pi点对应的像素值,∏-1(·)为反投影函数,即将全景图像像素坐标映射为三维向量,ω(·)为归一化操作;

85、s84,按照预设优化步长调整全局位姿信息得到优化全局位姿信息;

86、s85,将所述优化全局位姿信息输入所述全局位姿优化模型,得到第二颜色值损失值;

87、s86,判断所述第二颜色损失值是否小于第一颜色损失值,得到颜色损失值判断结果;

88、判断所述迭代次数是否小于目标迭代次数,得到迭代次数判断结果;

89、当所述颜色损失值判断结果为是且所述迭代次数判断结果为是时,所述第二全局位姿信息设置为第一全局位姿信息,所述迭代次数加1,返回步骤s82;

90、当所述颜色损失值判断结果为是且所述迭代次数判断结果为否时,得到最优全局位姿信息;

91、当所述颜色损失值判断结果为否时,得到最优全局位姿信息。

92、作为一种可选的实施方式,本发明实施例第一方面中,所述获取所述定位场景的三维稠密点云,包括:

93、s21,使用普通针孔相机对所述定位场景进行拍摄,获取所述稠密点云的图像数据;

94、s22,使用多视图重建算法对所述图像数据进行稠密点云重建,得到所述定位场景的三维稠密点云。

95、作为一种可选的实施方式,本发明实施例第一方面中,所述使用多视图重建算法对所述图像数据进行稠密点云重建,得到所述定位场景的三维稠密点云,包括:

96、s221,利用特征提取与匹配算法神经网络,对所述图像数据进行特征点检测与匹配,得到n对匹配点对;

97、s222,利用所述匹配点对,得到相机之间的本征矩阵;

98、s223,对所述本征矩阵奇异值进行分解,得到相机之间的旋转矩阵与平移向量;

99、s224,利用所述旋转矩阵与平移向量,通过三角测量与捆集调整,得到定位场景稀疏点云;

100、s225,选取参考图像序列和所述稀疏点云中的种子点,获取所述种子点的深度与法向量;

101、s226,利用所述深度与法向量,计算所述稀疏点云深度,获得参考图像序列的深度图;

102、s227,对所述深度图进行融合,得到所述定位场景的三维稠密点云。

103、本发明实施例第二方面公开了一种全景相机位姿估计装置,用于执行本发明实施例第一方面公开的全景相机位姿估计方法中的部分或全部步骤,装置包括:图像采集单元301、坐标转换单元302、图像分割单元303、图像匹配单元304、全景图像转换单元305、位姿优化单元306;

104、所述图像采集单元301,包括若干个针孔相机和点云获取模块;所述针孔相机用于对定位场景进行拍摄,得到所述稠密点云的图像数据;所述点云获取模块用于对所述图像数据进行稠密点云重建,得到所述稠密点云稠密点云;

105、所述坐标转换单302,包括3d坐标转换模块和像素坐标转换模块;所述3d坐标转换模块,对所述定位场景坐标系下稠密点云的三维点,进行3d坐标转换处理,得到全景相机坐标系下的3d点;所述像素坐标转换模块,用于对所述全景相机坐标系下的3d点进行像素坐标转换处理,得到全景图像坐标系上的像素坐标;

106、所述图像分割单元303,包括真实图像分割模块和合成图像分割模块;所述真实图像分割模块用于对所述真实全景图像进行分割,得到所述真实透视图;所述合成图像分割模块,用于对所述合成全景图像进行分割,得到所述合成透视图;

107、所述图像匹配单元304,用于对所述真实透视图和所述合成透视图进行特征提取和匹配,得到所述真实透视图和所述合成透视图的特征点2d-2d点对;

108、所述全景图像转换单元305,用于对所述点对数据集进行处理,得到真实全景图像的全局位姿信息;

109、所述位姿优化单元306,用于对所述全局位姿信息进行处理,得到定位场景的最优全局位姿信息。

110、本发明实施例第三方面公开了一种计算机可存储介质,所述计算机存储介质存储有计算机指令,所述计算机指令被调用时,用于执行实施例一所描述的全景相机位姿估计方法中的步骤。

111、与现有技术相比,本发明实施例具有以下有益效果:

112、1、本发明基于稠密点云与全景图像的全景相机的位姿估计方法,解决了全景图像失真导致定位效果降低的问题,实现了全景相机快速准确的自主定位。

113、2、本发明提出了基于稠密点云与全景图像的全景相机快速准确定位方法,能够很好的应用于在虚拟现实、增强现实、即时定位与地图构建、自动驾驶等领域。