基于锚框位置引导和细节增强的多尺度目标检测方法

本发明属于目标检测,具体涉及一种基于锚框位置引导和细节增强的多尺度目标检测方法。

背景技术:

1、小目标检测技术是计算机视觉领域的一个重要研究方向,旨在通过图像或视频数据中准确地检测和定位尺寸较小的目标物体。小目标的检测面临的挑战之一是目标物体的尺寸较小,因此往往缺乏明显的纹理和结构信息。传统的特征描述子如sift、hog等在小目标检测中效果较差。为了解决这个问题,研究者们提出了一些针对小目标的特征表示方法,如局部特征、金字塔特征等,以提高目标的可检测性。

2、然而,同一场景下往往存在尺度大小不一的多个目标,这对目标检测任务造成两方面的困难。首先,拥有不同尺度的目标之间存在相互遮挡的关系,这对锚框设置、特征提取以及不同尺度特征图的融合策略提出了更高要求。其次,与场景中的大中型目标相比,小型目标因其可利用特征少、定位精度要求高、数据不足和正负样本不均衡等特点更加难以准确检测。位于杂乱背景中的小目标通常容易受到周围目标或背景元素的遮挡,并且分布拥挤。

3、促进小目标检测常用的有效方法是使用高分辨率图像或特征图。然而,这会导致昂贵的算力消耗,因为计算成本会随着图像和特征大小的增加而成正比增长。由于小目标在空间中通常是稀疏分布的,在高分辨率特征图上密集布置锚框检测小目标将带来严重的算力空耗。同时,特征金字塔是高度结构化的,尽管无法准确检测低分辨率特征图中的小物体,但仍然可以高置信度地推断它们的存在和大致位置。

4、申请公布号为cn114612709a,名称为“基于联合递归特征金字塔的多尺度目标检测方法”的专利申请,公开了一种基于图像金字塔特征指导的多尺度目标检测方法,该方法不仅能加强空间位置信息,而且能避免在下采样中丢失大量细节信息,从而增加了目标检测网络对小目标和邻近目标的辨识度。但该方法的不足之处在于,在高分辨率特征图上密集布置锚框检测小目标导致算力空耗。

5、申请公布号为cn109344821a,名称为“基于特征融合和深度学习的小目标检测方法”的专利申请,公开了一种基于特征融合和深度学习的小目标检测方法,该方法具有在保证实时检测的要求下,确保小目标检测高精度的优点。但该方法的不足之处在于,在高分辨率特征图上密集布置锚框检测小目标导致算力空耗。

6、综上所述,现有技术以特征金字塔为代表的目标检测方法倾向于从高分辨率的底层特征图中检测小目标,然而,由于小目标在空间中通常是稀疏分布的,在高分辨率特征图上密集布置锚框检测小目标将带来严重的算力空耗,且计算成本会随着图像和特征大小的增加而成正比增长。

技术实现思路

1、为了克服上述现有技术存在的不足,本发明的目的在于提供一种基于锚框位置引导和细节增强的多尺度目标检测方法,本方法利用提出的级联式锚框位置引导机制,实现从粗到精的锚框位置生成来降低特征金字塔的计算成本:在底层特征图上预测小目标的粗略位置,然后利用粗略位置指导高层特征图上相应位置的锚框生成,细节增强模块辅助指导从浅层到深层的信息传递,语义约束模块增强低级特征图中的小目标特征,提高对小目标的检测性能,用于解决现有技术在高分辨率特征图上密集布置锚框检测小目标带来的算力空耗问题。

2、为了实现上述目的,本发明采用的技术方案是:

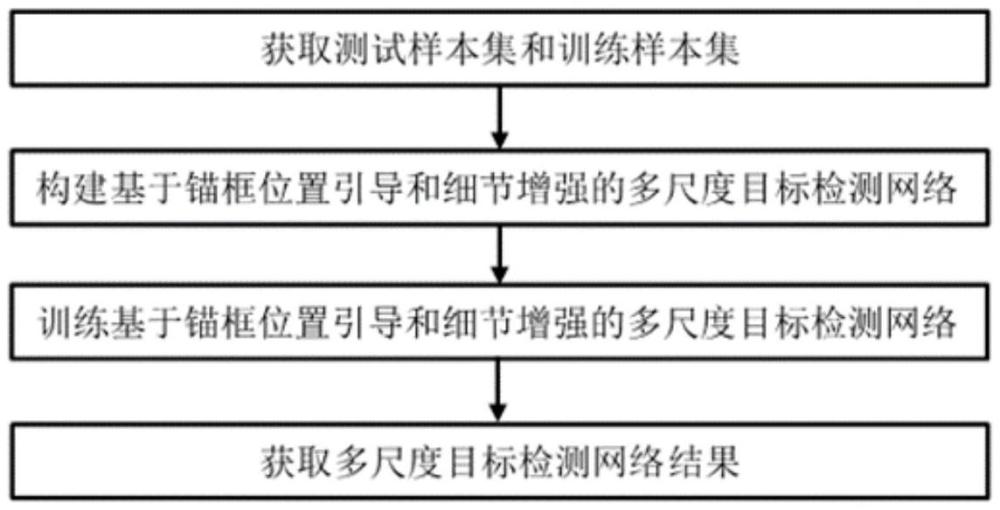

3、基于锚框位置引导和细节增强的多尺度目标检测方法,包括以下步骤:

4、步骤1,获取测试样本集a和训练样本集b;用于锚框位置引导和细节增强的多尺度目标检测网络s的训练和基于锚框位置引导和细节增强的多尺度目标检测网络s*的测试;

5、步骤2,构建锚框位置引导和细节增强的多尺度目标检测网络模型s,用于获取训练好的基于锚框位置引导和细节增强的多尺度目标检测网络s*;

6、步骤3,对锚框位置引导和细节增强的多尺度目标检测网络模型s进行迭代训练,得到训练好的锚框位置引导和细节增强的多尺度目标检测网络模型s*;

7、步骤4,获取多尺度目标检测网络结果:

8、将测试样本集a作为训练完成的基于锚框位置引导和细节增强的多尺度目标检测网络模型s*的输入进行前向推理,得到测试样本的检测精度,以验证模型效果。

9、所述步骤1中,从公开目标检测数据集中任意选取占所有图像数一定比例的图像作为训练样本集b,剩余的图像作为测试样本集a。

10、所述步骤2具体包括以下步骤;

11、步骤2.1,构建级联式锚框位置引导模块e,引导模块e由多尺度特征提取网络m、检测头c、查询头q组成;多尺度特征提取网络m提取的特征结果为多尺度特征图f;

12、步骤2.2,构建细节增强模块d,采用交叉注意力机制的自适应融合方法,指导从浅层到深层的信息传递的同时,抑制不必要的背景噪声,利用注意力机制自适应地融合特征,确保只传输相关的信息,从而增强深层特征中的细节;

13、步骤2.3,构建语义约束模块y,采用基于注意力机制的语义约束方法,旨在选择性地增强低级表征中的小物体特征,同时抑制来自高级特征的较少相关语义信息。

14、所述步骤2.1具体为:

15、采用resnet-50作为多尺度特征提取网络m,提取出了图像的多尺度特征图表示f,然后利用检测头c预测小目标的粗略位置,并在检测头部分添加了一个与分类头和回归头平行的查询头q,用来输出网格中包含目标的概率。

16、所述多尺度特征提取网络m将该主干网络第2层至第5层的输出特征图表示为{fi|i=2,3,4,5},对于尺度为h×w的输入特征图,第fi层输出特征图的尺度为h/2i×w/2i×(c×2i-1);

17、所述检测头c包括一个对标签进行分类的分类头和一个用于对目标精确定位的回归头,由四个3×3卷积层组成,其次是用于最终检测的额外的3×3卷积层,且不同特征层次共享相同的检测头参数;

18、在检测头部分添加的查询头q,接收特征图fi作为输入,将每个层级上的小目标定义为尺度小于预定义阈值si的目标,将si设置为层级fi上的最小锚框尺度,对于一个小目标o,通过计算目标中心位置(xo,yo)与特征图上每个位置之间的距离来对查询头的目标图进行编码,并将距离小于si的位置设置为1,否则设置为0;且使用焦点损失对查询头进行训练,选择目标概率图预测得分大于阈值σ的位置作为查询,第i层特征图上,将预测得分大于阈值σ的位置作为该层小目标查询位置,然后将第i层特征图上小目标o的查询位置映射到fi-1层上的4-最近邻点作为关键位置,收集fi-1层上的所有的形成密钥位置集{ki-1},并输出热力图其中vi,j表示热力图网格(i,j)中包含小目标的概率,对于每个层级fi,损失函数计算公式如下:

19、

20、其中,ci、ri、mi分别对应分类头、回归头和查询头的输出,是分类头、回归头和查询头对应的真值,是lfl焦点损失,lr是边界框回归损失;

21、所述步骤2.2具体为:

22、多尺度特征提取网络m提取的特征图表示为{fi|i=2,3,4,5},i越小,对应的是底层特征图,i越大,对应高层特征图;

23、所述自适应融合方法,首先将多尺度特征提取网络m提取的高层特征ci展平,将其转换为两个张量和将多尺度特征提取网络m提取的低级特征dk=i-1展平为张量对这三个张量应用线性投影来计算查询(q)、键(k)和值(v),query是用于表示待查询信息的矩阵;key是用于表示输入序列中每个位置的关键信息的矩阵;value是与输入序列中的每个位置相对应的值的矩阵。

24、计算公式如下:

25、

26、

27、

28、其中,φi和φk代表在第i和第k层上的3×3卷积核,σ(g)代表对张量维度的重塑,fi和fk分别对应高级特征和低级特征,wq、wk、wv是投影矩阵;

29、然后,通过矩阵乘法和归一化获得对特征间关系进行建模的交叉权重矩阵随后,计算更新的特征表示并将其重塑回其原始维度,得到输出特征dk=i。计算公式如下:

30、

31、其中,qfi,i代表第i层上特征fi所对应的待查询信息矩阵,代表第k层上特征fk所对应的关键信息矩阵。

32、所述步骤2.3具体为:

33、所述基于注意力机制的语义约束方法,通过元素之间的关系映射从输入序列中捕获上下文信息,通过计算像素与其上下文在空间和通道维度上的全局相关性来收集上下文空间通道信息,多尺度特征提取网络m提取的特征图对应的张量被展平并归一化为三个投影矩阵wq、wk、wv分别将张量x投影到尺寸为n×n×c/n的qshared、kshared、vspatial,计算表示特征相似性的空间注意力图

34、

35、qshared和kshared被复用来计算通道注意力图

36、

37、最终输出fcon是空间和通道注意力特征的融合,通过卷积层和快捷连接进行细化以增强特征表示:

38、

39、所述步骤3具体为:

40、步骤3.1,初始化迭代次数为t,最大迭代次数为t,当前基于锚框位置引导和细节增强的多尺度目标检测网络模型为st,并令t=1,s*=st;

41、步骤3.2,从训练样本集b中不放回地随机选取b个训练样本作为锚框位置引导和细节增强的多尺度目标检测网络模型st的输入;多尺度特征提取网络m,提取出图像的多尺度特征图表示f,然后利用检测头c预测其中小目标的粗略位置,并使用查询头q,用来输出网格中包含目标的概率;使用细节增强模块d指导从浅层到深层的信息传递,增强深层特征中的细节,并使用语义约束模块y增强低级表征中的小物体特征,同时抑制来自高级特征的较少相关语义信息。

42、步骤3.3,计算第i个特征图fi上每个特征位置(x,y)与所有小目标真实边界框中心的最小距离di[x][y]来衡量模型st的损失值,对网络模型st的各层权值参数进行更新;

43、步骤3.4,判断是否已遍历训练样本集b,若是,执行步骤3.5,否则,执行步骤3.2和3.3;

44、步骤3.5,判断t=t是否成立,若是,得到训练好的基于锚框位置引导和细节增强的多尺度目标检测网络模型s*=st,否则,令t=t+1,并执行步骤3.3和3.4。

45、所述步骤3.3具体为:

46、计算fi上每个特征位置(x,y)与所有小目标真实边界框中心的复合损失函数公式为

47、

48、其中,ci、ri、mi分别对应分类头、回归头和查询头的输出,是分类头、回归头和查询头对应的真值,是lfl焦点损失,lr是边界框回归损失。

49、本发明的有益效果:

50、本发明提出级联式锚框位置引导机制,在底层特征图上预测小目标的粗略位置,然后利用粗略位置指导高层特征图上相应位置的锚框生成;

51、选择目标概率图预测得分大于阈值σ的位置作为查询,然后将该位置映射到fi-1层上的4-最近邻点作为关键位置,收集fi-1层上的所有的形成密钥位置集{ki-1};利用从粗到精的锚框位置生成方法来降低不同尺度的特征图融合构成的特征金字塔的计算成本:

52、在底层特征图上预测小目标的粗略位置,然后利用粗略位置指导高层特征图上相应位置的锚框生成,细节增强模块辅助指导从浅层到深层的信息传递,语义约束模块将高级特征的语义信息传播到低级特征中,增强低级特征图中的小目标特征,提高了对小目标的检测性能,解决了在高分辨率特征图上密集布置锚框检测小目标带来的算力空耗问题。

- 还没有人留言评论。精彩留言会获得点赞!