一种基于多智能体强化学习鲁棒奖励函数的充电站定价及充电方法

本发明属于电-交通网协同优化,具体涉及一种基于多智能体强化学习鲁棒奖励函数的充电站定价及充电方法。

背景技术:

1、目前,大力投资交通电气化,以促进能源转型和脱碳。这包括大规模部署电力运输网络和配电网络。汽车和快速充电站之间的紧密结合。近年来,电动汽车的规模增长迅速。到2030年,电动汽车的数量预计将达到18.1亿辆,每年消耗43000gwh的电力。配电网络和造成局部拥塞,这可能导致大范围停电。电动汽车随机充电所消耗的大量电能给电动汽车用户带来了巨大的负担会造成严重的经济损失和负面的社会影响。

2、然而,在现有文献对于充电站决策有两个重要的空白。首先,现有的大多数将充电需求封装在交通网的建模工作中。事实上,这高度依赖于电动汽车始发目的地行程完整和私密信息。而现实环境具有高度的随机性和动态性,精确的需求建模可能不够现实。其次,在现有的一些文献中,电动汽车被用作智能体进行决策。随着电动汽车数量的增加,定价优化的计算复杂度将显著增加。因此,亟待研发一种基于多智能体强化学习鲁棒奖励函数的充电站定价及充电方法,以考虑充电需求的不确定性以及配电网与电动汽车的耦合关系。

技术实现思路

1、发明目的:本发明所要解决的技术问题是针对现有技术存在的不足而提供一种基于多智能体强化学习鲁棒奖励函数的充电站定价及充电方法。本发明计及了配电网、电动汽车、充电站之间的高效协同,鲁棒强化学习算法基于历史数据,计算充电站的收费和定价决策,用于处理电动汽车行为的不确定性。引入电网相关约束,对电力-充电站进行协同调度。本发明不仅能够促进信息壁垒下配电网和电动汽车之间的协同,也帮助充电站基于动态市场提高自身利润。

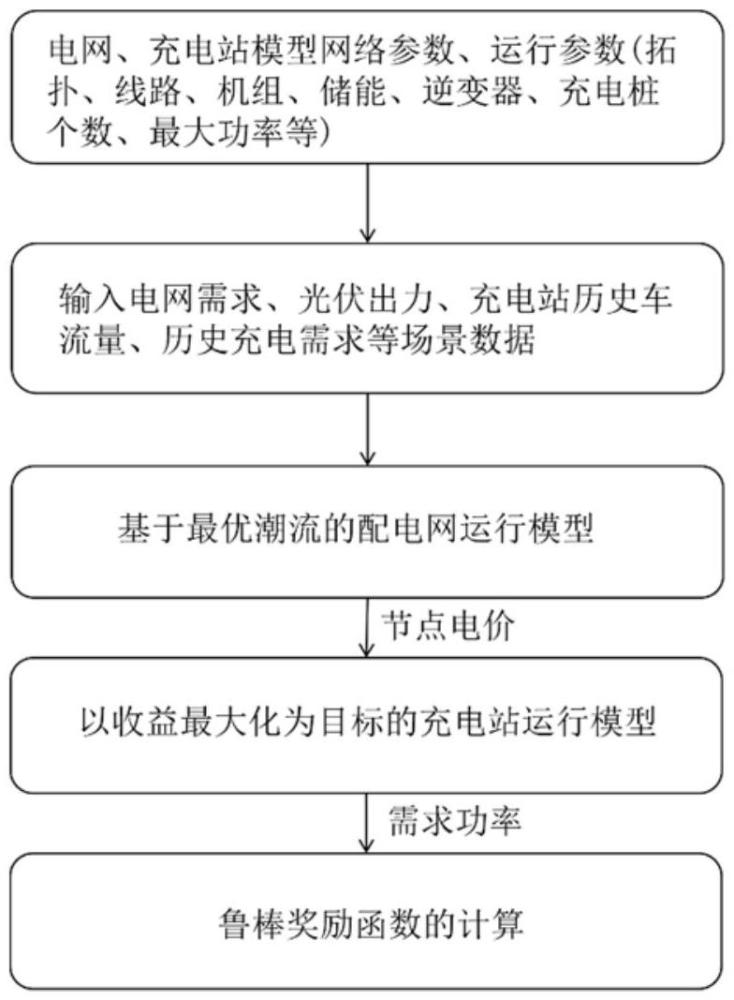

2、技术方案:为了解决上述技术问题,本发明提出一种基于多智能体强化学习鲁棒奖励函数的充电站定价及充电方法,该方法包括以下步骤:

3、步骤1、获取电网模型的网络系数和运行系数,所述网络系数包括电网拓扑、线路电阻和阻抗,所述运行系数包括发电机组发电系数、储能系统充放电系数、光伏逆变器系数、充电站参数;

4、步骤2、获取电网负荷需求、光伏出力、充电站历史车流量、历史充电需求场景数据;

5、步骤3、针对获取的配电网参数,以电网运行约束、机组运行约束为约束条件,以配电网运行成本最小为目标函数,建立基于最优潮流的配电网运行模型,根据该模型得到充电站所属节点的节点电价;

6、步骤4、充电站作为智能体,将基于步骤3得到的节点电价及充电站的历史数据作为智能体状态的输入,以车辆充电需求更新约束、停车时间更新约束、充电功率约束为约束条件,充电站综合收益最大为目标函数,建立充电站运行模型,根据该模型计算得出充电站与配电网的申报功率;

7、步骤5、基于步骤3得到的节点电价和步骤4得到的申报功率,利用多智能体鲁棒近端策略优化算法计算得到充电站的鲁棒奖励函数,构建鲁棒奖励函数的过程即量化最恶劣情况下的奖励与确定性奖励的差值的过程,用霍尔德不等式和柯西-施瓦兹不等式的对偶形式对该差值进行松弛。

8、进一步的,步骤3中,配电网运行模型为:

9、

10、式中,fdn表示配电网运行成本,g表示分布式电源,ag表示分布式电源g的二阶成本系数,bg表示分布式电源g的一阶成本系数,cg表示分布式电源g的常数成本系数,pg,t表示分布式电源g在时刻t的输出功率,psub,t表示在时刻t下向根节点购买的电功率,csub,t表示在时刻t下向根节电购电的电价,cdne表示编号为dne储能的充放电成本系数,表示在时刻t下编号为dne储能的放电功率,表示在时刻t下编号为dne储能的充电功率,ccut表示符合削减的惩罚系数,j表示负荷节点,表示在时刻t下节点j的负荷削减量。

11、进一步的,步骤3中,配电网运行约束为:

12、pg,t-pg,t-1≤rug (a-2)

13、pg,t-1-pg,t≤rdg (a-3)

14、

15、socdne,min≤socdne,t≤socdne,max(a-5)

16、

17、pg,min≤pg,t≤pg,max (a-12)

18、qg,min≤qg,t≤qg,max (a-13)

19、

20、psub,min≤psub,t≤psub,max(a-15)

21、

22、式中,rug和rdg分别表示分布式电源g功率爬坡的上下界,socdne,t,socdne,t+1分别表示在时刻t及时刻t+1下编号为dne储能的荷电状态,表示在时刻t下编号为dne储能的充电状态,表示在时刻t下编号为dne储能的放电状态,ηch和ηdis分别表示充、放电效率,δtdn表示配电网的时间间隔,socdne,min,socdne,max分别表示编号为dne储能荷电状态的最小值和最大值,pj,t表示在时刻t下节点j的有功负荷,表示在时刻t下节点j负荷的削减量,f、k均表示配电网中的节点,ndn表示配电网节点集合,fdn表示配电网中流入节点j的线路集合,tdn表示配电网中流出节点j的线路集合,表示在时刻t下节点j削减后的有功功率负荷量,qj,t表示在时刻t下节点j的无功功率负荷量,pjf,t和pkj,t分别表示t时刻线路jf和线路kj的有功功率,qjf,t和qkj,t分别表示t时刻线路jf和线路kj的无功功率,rkj、xkj分别表示线路kj的电阻、电抗;ikj,t、ijf,t分别表示t时刻线路kj和jf的电流;bdn表示配电网中所有线路的集合,vf,t、vj,t、vk,t分别表示t时刻节点f、j、k的电压,vk,min,vk,max分别表示节点k电压的最小、最大限制,ijf,max表示线路jf电流的最大值,pg,min、pg,max分别表示分布式电源g有功出力的最小、最大值,qg表示分布式电源g的无功出力,.qg,min.和qg,max分别表示分布式电源g无功出力的最大、最小值,psub,min和psub,max分别表示根节点购电量的最小、最大值,和分别表示编号为dne储能放、充电的最大功率。

23、进一步的,步骤4中,以收益最大化为目标的充电站运行模型为:

24、

25、充电需求更新约束:

26、

27、剩余停车时间更新约束:

28、

29、充电功率约束:

30、

31、集合定义:

32、

33、式中,cz,t表示t时刻下充电站z的收益,rz,t表示t时刻下充电站z的服务费定价,表示电动汽车i到达的时刻,表示在历史t时刻下到达充电站z的车辆集合,di(rz,t)表示电动汽车i在服务费rz,t下的充电需求,pi表示电动汽车i的初始停车时长,λj,t表示t时刻下节点j的边际电价,ω表示电量偏差的惩罚系数,ez,t表示t时刻下充电站z的总充电率,表示t时刻下充电站z的实际充电率,分别表示t时刻及t+1时刻电动汽车i的剩余充电需求,分别表示t时刻及t+1时刻电动汽车i的剩余停车时间,xi,t表示t时刻下电动汽车i的充电率,表示电动汽车i的最大充电率,表示充电站z的最大总充电率,和分别表示在t和t+1时刻在充电站z内的电动汽车集合。

34、进一步的,步骤5中,鲁棒奖励函数的计算为:

35、

36、式中,分别表示充电站在不确定状态、确定状态下的策略,a表示充电站的动作集合,s表示充电站的状态集合,表示策略和πcs下充电站z奖励函数的差值,st/st+1分别表示时刻t、t+1时充电站的状态,分别表示策略πcs和下充电站在t时刻处于状态st的概率,表示策略πcs和下充电站在t时刻处于状态st的状态价值函数,at表示充电站在时刻t下的动作,rt表示时刻t下充电站的收益,分别表示策略下充电站的综合收益,表示策略和πcs下充电站状态st的总变差距离。

37、有益效果:与现有技术相比,本发明的技术方案具有以下有益效果:

38、本发明的技术方案与传统充电站决策的方案相比,本发明通过引入鲁棒奖励函数处理电动汽车行为的不确定性。同时,为应对信息壁垒的问题,智能体是基于历史数据对自身行为进行决策。算例测试结果表明,本发明所提方法较现有方法有助于充电站在更复杂的现实环境中提高自身收益,提高了充电桩的利用率,平衡了配电网负荷峰谷值,提高了电力系统的稳定性。本发明考虑当下交通网与充电站间存在信息壁垒的现实情况,通过基于历史数据的鲁棒强化学习做决策保障了信息隐私下充电站的精准策略,实现了充电站最优定价及充电决策。

- 还没有人留言评论。精彩留言会获得点赞!