一种基于三维重建的自动驾驶街景无监督4D自动标注方法与流程

本发明涉及自动驾驶数据处理,尤其是涉及一种基于三维重建的自动驾驶街景无监督4d自动标注方法。

背景技术:

1、现阶段,对自动驾驶的研发已经不仅仅停留在学术研究阶段,工业界对技术的践行反馈出了诸多需求。其中,最基本的一项是,对于采集好的真实数据,需要对其进行数据标注,包含但不限于场景中物体的4d框和语义信息(这里的4d框是指长宽高坐标和时间维度,也就是需要知道每个物体在不同时刻的具体位置)。4d标注是种数据标注方法,它不仅包含了传统2d标注的所有信息且引入了高度和时间等维度使得标注数据更加丰富和完整,在自动驾驶领域,4d标注有着广泛的应用前景,但是这项工作目前只能依靠人工或者半自动来完成,这意味着数据标注方需要花费大量的人力、财力和时间,类似的已标注好的数据集可参考waymo和nuscenes等。

2、现有的数据标注技术方案是使用数据驱动的训练神经网络方法,基于一部分已有的2d/3d/4d标注数据,以对模型进行训练,训练完成后的模型即可完成目标功能,即输入逐帧的图像和点云给模型,由模型输出物体逐帧的3d信息。比如,bevfusion和auto4d等工作很好地完成了固定数据集下的物体检测,通过对某一种数据集的训练,模型可以对当前数据集域的数据进行检测,输出效果良好,但是无法直接在其他数据(非训练数据域)上推理;vsrd则采用隐式重建的方法,对单帧图像进行重建,推理过程只需要2d图像作为输入,即可输出3d框,但由于其单帧重建的特性,这种方案仍然依赖2d框以及物体的类别身份信息等真值数据,并不能完全做到无监督。

3、综上可知,现有技术对于待检测的目标数据,往往依赖于3d真值标注、2d真值标注,均不能做到完全无监督。此外,绝大多数技术都存在域差异问题,即无法在未知或者模型未见过的数据上直接推理(强行推理的检测精度几乎为0)。

技术实现思路

1、本发明的目的就是为了克服上述现有技术存在的缺陷而提供一种基于三维重建的自动驾驶街景无监督4d自动标注方法,能够在没有真值标注的情况下,仅利用图像信息即可实现3d物体检测。

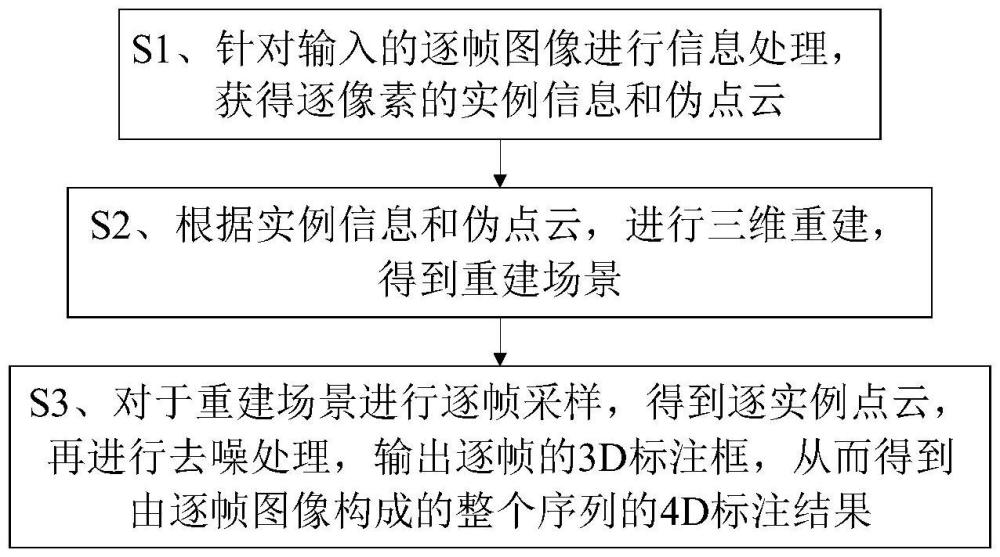

2、本发明的目的可以通过以下技术方案来实现:一种基于三维重建的自动驾驶街景无监督4d自动标注方法,包括以下步骤:

3、s1、针对输入的逐帧图像进行信息处理,获得逐像素的实例信息和伪点云;

4、s2、根据实例信息和伪点云,进行三维重建,得到重建场景;

5、s3、对于重建场景进行逐帧采样,得到逐实例点云,再进行去噪处理,输出逐帧的3d标注框,从而得到由逐帧图像构成的整个序列的4d标注结果。

6、进一步地,所述步骤s1具体是使用通用的预训练好的视觉模型,以对逐帧图像进行信息处理。

7、进一步地,所述通用的预训练好的视觉模型包括图像分割模型和深度估计模型,所述图像分割模型用于获取图像中各个像素点的语义信息,进而得到实例信息;

8、所述深度估计模型用于获取图像中各个像素点的距离信息,并转化为伪点云格式。

9、进一步地,所述图像分割模型的工作过程为:

10、针对图像数据其中k是不同时刻的采集帧,j是同一时刻下不同的图像;

11、将输入到图像分割模型,得到逐像素的实例信息中的数值即为当前像素所属的实例id,为获取跨帧和跨视图一致的实例信息,将图像按照实例计算2d框,并分别按照2d框的区域投影到图像分割模型的内部隐空间中,获得与每个图像中的每个框所对应特征向量m为当前帧单张图像的框的数量,也是当前图像的实例数;

12、之后度量多视图特征向量之间的欧式距离以确定当前两个框是否属于同一个实例,如果距离小于阈值,则认为属于同一实例,从而让当前帧的所有视图的实例统一,逐帧实例数为m,即当前帧所有视图下的实例总数;

13、继续度量不同帧的特征向量之间的欧氏距离对进行更新,以实现实例上的追踪,使得整个场景的实例统一。

14、进一步地,所述深度估计模型的工作过程为:

15、针对图像数据其中k是不同时刻的采集帧,j是同一时刻下不同的图像;

16、将输入到深度估计模型,获取得到逐像素深度信息、即深度信息,再对应转化为伪点云格式。

17、进一步地,所述步骤s2具体是采用基于符号距离场的隐式表面重建方法streetsurf,并且利用实例信息进行跨帧的全场景实例重建。

18、进一步地,所述步骤s2的具体过程包括:

19、streetsurf通过将场景信息编码成隐空间向量,来记忆并过拟合所需的信息,所使用的损失函数包括逐像素的颜色正则和深度正则是重建网络预测的当前点的颜色信息,是重建网络预测的深度信息;

20、此外,对于实例信息,采用额外的多层感知机模型(multilayer perceptron,mlp)来预测实例信息,使用额外的实例正则是重建网络预测的实例信息。

21、进一步地,所述步骤s3包括以下步骤:

22、s31、对于重建场景进行逐帧采样,通过采集稠密的空间点坐标,并查询这些空间点坐标对应的实例信息,获取逐帧的实例点云数据pck;

23、s32、针对获取的实例点云进行去噪处理,以滤除离群点,之后按照实例类别,逐帧计算得到3d标注框。

24、进一步地,所述步骤s32具体是采用dbscan(density-based spatial clusteringof applications with noise,具有噪声的基于密度的聚类)算法进行去噪处理。

25、进一步地,所述步骤s32中3d标注框的计算公式为:

26、

27、其中,rk为第k帧图像对应的3d标注框结果,z表示第z个标注框,m是标注框总数。

28、与现有技术相比,本发明具有以下优点:

29、本发明针对输入的逐帧图像进行信息处理,以获得逐像素的实例信息和伪点云,用于进行三维重建,得到重建场景,之后对重建场景进行逐帧采样,得到逐实例点云,再进行去噪处理,输出逐帧的3d标注框,从而得到由逐帧图像构成的整个序列的4d标注结果。由此能够实现图像无监督自动标注,仅需要2d的时序图像和相机参数,即可对场景进行物体框标注。

30、本发明使用通用的预训练好的视觉模型,以对逐帧图像进行信息处理,其中,通用的预训练好的视觉模型包括图像分割模型和深度估计模型,利用图像分割模型获取图像中各个像素点的语义信息,进而得到实例信息;利用深度估计模型获取图像中各个像素点的距离信息,并转化为伪点云格式。本发明利用预训练的通用视觉模型来进行信息处理,既避免了模型对真值的需求,同时由于这些通用的视觉模型并不是在单一数据集下训练过的,因此避免了数据域差异问题。

31、本发明针对获取的语义信息,进一步利用跟踪方法,对逐帧的数据进行相似度匹配,以实现实例信息跨帧一致,即同一实例在不同时刻的身份信息相同,有利于后续使得整个场景的实例统一。

32、本发明考虑到伪点云不够稠密,故设计采用基于符号距离场的隐式表面重建方法streetsurf,并且利用实例信息进行跨帧的全场景实例重建,此外,对于已经重建好的场景,进行逐帧采样,获取更加稠密的三维语义和实例点云,将点云按照实例类别使用dbscan聚类算法进行分别去噪、滤除离群点,从而能够计算得到精准的3d框。

- 还没有人留言评论。精彩留言会获得点赞!