一种基于多尺度特征协同与语义互补的遥感目标检测方法

本发明涉及遥感图像识别和目标检测,具体涉及一种基于多尺度特征协同与语义互补的遥感图像目标检测方法。

背景技术:

1、随着遥感观测技术的快速发展,世界各地的许多高分辨率遥感卫星获取了大量多地貌、多维度、高分辨率的遥感图像。高分辨率遥感图像中包含了丰富的地物细节特征,具有更加丰富的空间结构和拓扑关系。如今遥感图像已经被广泛应用于气象、农业、环境和灾害监测等领域,具有广泛的实用价值。近年来,深度学习的快速发展,为遥感图像智能信息提取提供有利的技术支撑。为了有效促进基于深度学习的遥感图像目标检测方法,许多机构和研究人员也公开发布了多种大规模遥感图像识别相关的数据集。

2、与常见的自然场景相比,遥感和航空图像通常是从俯视角度捕获任意水平或方向的物体,再加上不同的拍摄角度和成像条件,这使得针对多场景遥感图像目标的检测仍具有挑战性。具体来说,存在以下两个主要挑战需要解决。

3、复杂的背景干扰问题:遥感图像中前景目标通常所占比例较小,容易受到周围复杂背景如建筑群、植被的干扰,使得目标物体的特征模糊,不利于算法识别。

4、目标的大尺度变化问题:遥感图像通常是从具有宽视野的卫星或无人机上捕获的,因此目标尺度跟随图像分辨率而变化,巨大的尺度变化往往阻碍了精确的目标检测。

5、针对复杂背景对于前景目标的干扰问题,当前很多工作聚焦于探索不同的方法利用语义信息提高检测的性能。语义信息有助于建模遥感图像中的物体和背景之间的关系,减轻复杂背景对于精确目标特征的影响。目前许多方法通过特征融合、语义编码或者注意力机制提取语义信息,然而,这些方法没有考虑到相邻特征层的语义差距较小,可以通过聚合相邻层的显著特征补充当前输出层的语义信息。

6、针对目标的大尺度变化问题,目前大多数研究主要围绕特征金字塔及其变体结构,空间和通道注意力和跨尺度特征融合等方面来获取多尺度信息。但是采用特征金字塔结构的网络中路径数量过多,非相邻层之间只能间接交互,导致跨层信息交互时出现信息丢失,阻碍网络更好地进行信息融合。

技术实现思路

1、本发明的目的是为了解决现有的遥感图像目标检测方法存在由于复杂背景对于前景目标的干扰以及目标尺度通常会跟随图像分辨率而变化,从而导致遥感图像目标检测的检测精度容易受到影响的技术问题,而提出的基于多尺度特征协同与语义互补的遥感目标检测方法。

2、为了解决上述技术问题,本发明采用的技术方案为:

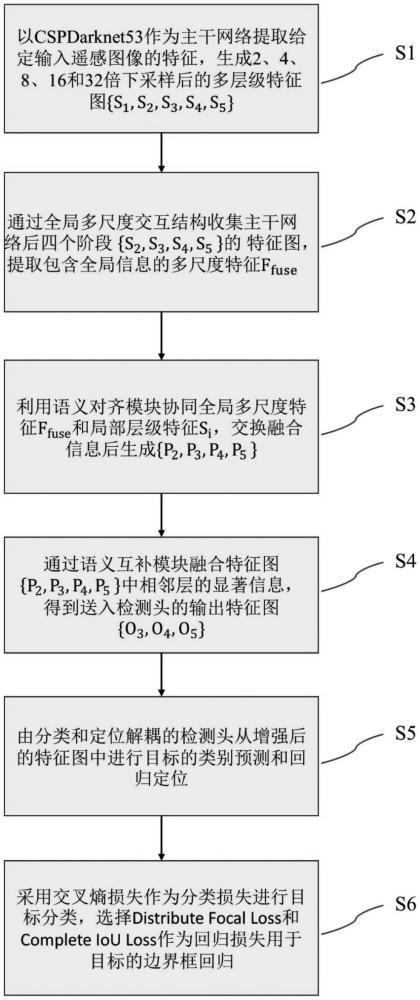

3、一种基于多尺度特征协同与语义互补的遥感目标检测方法,包括以下步骤:

4、步骤s1:采用主干网络提取给定输入遥感图像的特征,生成下采样后的多层级特征图其中i∈{1,2,3,4,5},h和w表示输入图像的高度和宽度,hi×wi表示特征图si的尺寸(h/2∧i×w/2∧i);

5、步骤s2:通过gmi收集并挖掘所述多层级特征图后四个阶段{s2,s3,s4,s5}中的全局语义信息,从而获得包含全局信息的多尺度特征ffuse;

6、步骤s3:利用sam协同全局多尺度特征ffuse和局部层级特征si,交换融合信息后生成{p2,p3,p4,p5};

7、步骤s4:通过scm融合特征图{p2,p3,p4,p5}中相邻层的显著信息增强输出特征图的语义表示,得到输出特征图{o3,o4,o5};

8、步骤s5:由分类和定位解耦的检测头从增强后的特征图中分别预测目标的类别和检测框;

9、步骤s6:采用交叉熵损失作为分类损失进行目标分类,选择distribute focalloss和complete iou loss作为回归损失用于目标的边界框回归。

10、在步骤s2中,包括以下步骤:

11、步骤s21:将主干网络的三层特征图{s2,s3,s4}通过下采样到与s5相同的统一尺寸后在通道维度拼接和r倍缩放后得到全局特征f;该过程采用以下公式:

12、s'i=downsample(si),i∈{2,3,4}

13、f=conv1×1([s'2,s'3,s'4,s5])

14、其中downsample(·)表示下采样操作,通过平均池化实现,[·,·]表示沿通道维度的级联操作;

15、步骤s22:在全局特征f上利用并行的,膨胀率分别为r={1,2,2,3}的两个3×3卷积和两个5×5卷积分别获取不同感受野大小的特征图;将不同感受野的特征图进行融合,进而获得更加丰富的多尺度特征fms;该过程采用以下公式:

16、fms=conv1×1([f,f'1,f'2,f'3,f'4]);

17、步骤s23:引入transformer层来对多尺度特征fms的长距离全局依赖进行建模,进一步提取和融合特征信息;首先通过1×1卷积层替换线性层对fms执行投影操作得到查询q、键k和值v;该过程采用以下公式:

18、q、k、v=flatten(fms);

19、步骤s24:然后对q、k、v执行transformer层中的多头自注意力操作和残差连接得到fattn,多头自注意力操作可以对特征进行加权提高模型的表示能力;该过程采用以下公式:

20、fattn=residual(attn(q,k,v));

21、步骤s25:最后在fattn进行前馈网络和残差连接运算,加强网络的非线性提取能力,同时将特征的维度调整回去,获得全局多尺度特征ffuse;该过程采用以下公式:

22、ffuse=reshape(residual(mlp(fattn)))

23、其中mlp(·)表示多头自注意力,residual(·)表示残差连接。

24、在步骤s3中,包括以下步骤:

25、步骤s31:首先使用conv1×1将步骤s2得到的ffuse的通道按步骤s21中给出的缩放因子r进行放大,之后按照局部特征{s2,s3,s4,s5}的通道维度进行划分得到gi={g2,g3,g4,g5};该过程采用以下公式:

26、[g2,g3,g4,g5]=split(conv1×1(ffuse));

27、步骤s32:然后将gi上采样至步骤s1中si的尺寸得到g′i,令g′i和该过程采用以下公式:

28、g′i=bilinear(gi)

29、其中bilinear(·)表示基于双线性插值的上采样操作;

30、步骤s33:最后,利用g′i作为衡量跨尺度交互的权重,该权重视为主干网络特征si的辅助残差,运算得到pi:

31、

32、其中和分别表示元素乘法和元素加法,作为语义对齐模块的输出参与后续运算。

33、在步骤s3中,包括以下步骤:

34、步骤s41:语义互补模块接收s33步骤的输出特征图pi={p2,p3,p4,p5}作为输入;

35、步骤s42:首先融合最高层的特征图p4和特征图p5得到特征图o5,其中特征图p5作为全局信息调整通道后作为权重过滤特征图p4的冗余信息,同时利用repblock卷积块进一步提取信息,该过程采用以下公式:

36、

37、步骤s43:接下来利用fusion结构分层次融合相邻层级特征{p4,p3,o5}得到特征图o4,之后再融合{p3,p2,o4}得到特征图o3;该过程采用以下公式:

38、oi=fusion(oi+1,pi,pi-1),i={3,4}

39、步骤s44:利用当前层级特征pi和下一层级特征pi-1做为局部特征生成plocal,再利用上一层级fusion块的oi+1作为全局信息得到oglobal;该过程采用以下公式::

40、plocal=conv1×1([pi,downsample(pi-1)])

41、oglobal=bilinear(conv1×1(oi+1))

42、步骤s45:采用注意力操作融合全局信息oglobal和局部信息plocal,过滤掉局部特征的干扰信息,最后通过重参数化卷积块repblock进一步提取和融合信息;信息融合过程可以计算如下:

43、oact=bilinear(sigmoid(conv1×1(oi+1)))

44、

45、其中oact表示注意力权重,和分别表示元素乘法和元素加法。

46、步骤s6中选择distribute focal loss和complete iou loss作为回归损失用于目标的边界框回归,采用的损失函数为:

47、

48、其中,为了平衡损失,为每个损失分配相应的权重,表示为λ1,λ2和λ3;lcls表示分类损失,ldfl和lciou分别表示distribute focal loss和complete iou loss,两者共同组成回归损失。

49、与现有技术相比,本发明具有如下技术效果:

50、1)本发明针对遥感图像提供了一种新的端到端单阶段目标检测网络,它可以充分利用多尺度信息和相邻特征的上下文信息,实现遥感目标的高精度检测;

51、2)本发明针对于遥感目标的大尺度变化提出了全局多尺度交互结构,该结构收集并挖掘主干网络多级特征图的全局多尺度语义信息,实现全局和局部上下文信息的信息交换,能够精确检测遥感图像中不同尺度大小的目标;

52、3)本发明提出了语义互补模块,利用相邻特征图的语义相似性,通过融合相邻层特征的显著信息增强输出特征图的语义表示,极大程度上克服了遥感图像中复杂背景对前景目标的冗余干扰,进一步精确目标特征。

- 还没有人留言评论。精彩留言会获得点赞!