一种服务机器人智能情感交互方法与流程

本发明涉及智能机器人,尤其涉及一种服务机器人智能情感交互方法。

背景技术:

1、随着人工智能和机器人技术的不断发展,服务机器人在日常生活中的应用日益广泛,涵盖了家庭助理、医疗护理、客户服务等多个领域。在这些场景中,情感交互作为人机交互的重要组成部分,能够有效提升用户的使用体验。服务机器人通过与用户进行情感交流,可以提供更加贴心、个性化的服务,使用户在互动过程中感受到关怀与理解。因此,如何通过先进的算法和技术手段提升服务机器人对用户情感状态的识别、分析及响应能力,成为智能机器人领域的研究热点。

2、然而,现有的服务机器人在情感交互方面仍存在多个技术问题。首先,多模态情感数据的采集和处理往往缺乏统一的融合机制,导致情感识别的准确性不高。其次,现有的情感交互策略大多采用预设规则,无法根据用户的情感变化进行实时调整,交互过程缺乏灵活性和个性化。此外,缺乏有效的自学习机制,使得机器人无法根据长期的情感交互经验进行自我优化,难以应对用户长期情感状态的变化。

技术实现思路

1、本发明提供了一种服务机器人智能情感交互方法。

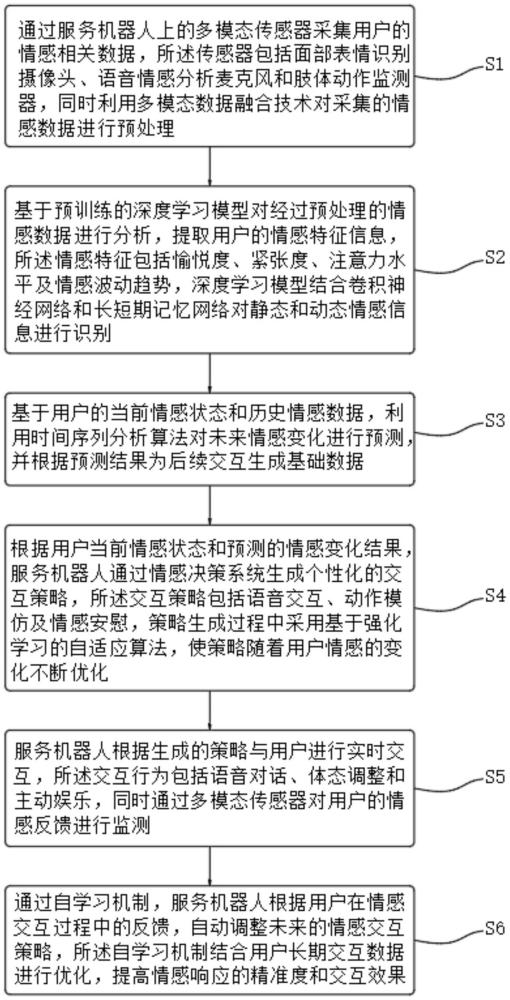

2、一种服务机器人智能情感交互方法,包括以下步骤:

3、s1,情感数据采集:通过服务机器人上的多模态传感器采集用户的情感相关数据,所述传感器包括面部表情识别摄像头、语音情感分析麦克风和肢体动作监测器,同时利用多模态数据融合技术对采集的情感数据进行预处理;

4、s2,情感状态分析:基于预训练的深度学习模型对经过预处理的情感数据进行分析,提取用户的情感特征信息,所述情感特征包括愉悦度、紧张度、注意力水平及情感波动趋势,深度学习模型结合卷积神经网络和长短期记忆网络对静态和动态情感信息进行识别;

5、s3,情感状态预测:基于用户的当前情感状态和历史情感数据,利用时间序列分析算法对未来情感变化进行预测,并根据预测结果为后续交互生成基础数据;

6、s4,交互策略生成:根据用户当前情感状态和预测的情感变化结果,服务机器人通过情感决策系统生成个性化的交互策略,所述交互策略包括语音交互、动作模仿及情感安慰,策略生成过程中采用基于强化学习的自适应算法,使策略随着用户情感的变化不断优化;

7、s5,情感交互实施:服务机器人根据生成的策略与用户进行实时交互,所述交互行为包括语音对话、体态调整和主动娱乐,同时通过多模态传感器对用户的情感反馈进行监测;

8、s6,反馈学习与策略优化:通过自学习机制,服务机器人根据用户在情感交互过程中的反馈,自动调整未来的情感交互策略,所述自学习机制结合用户长期交互数据进行优化,提高情感响应的精准度和交互效果。

9、可选的,所述s1具体包括:

10、s11,面部表情数据采集:通过服务机器人上的面部表情识别摄像头实时采集用户的面部图像,所述面部图像通过预训练的卷积神经网络模型进行预处理,提取面部特征点;

11、s12,语音情感数据采集:通过语音情感分析麦克风,采集用户的语音信号,采集过程中通过滤波器消除背景噪声,保证语音清晰度,随后对采集到的语音信号进行mel频率倒谱系数提取;

12、s13,肢体动作数据采集:通过安装在服务机器人上的肢体动作监测器,采集用户的肢体动作数据,所述肢体动作监测器包括加速计和陀螺仪,肢体动作数据经过卡尔曼滤波算法进行去噪和平滑处理;

13、s14,多模态数据融合:利用基于贝叶斯推理的多模态数据融合技术,将面部图像、语音信号和肢体动作数据的情感特征进行融合;

14、s15,数据预处理:在多模态数据融合后,对融合的多模态情感数据进行噪声过滤和标准化处理。

15、可选的,所述s2具体包括:

16、s21,情感特征数据输入:将经过s15预处理后的多模态情感数据作为深度学习模型的输入,多模态情感数据包括面部表情特征向量、语音特征向量和肢体动作特征向量,在输入深度学习模型前,对各模态数据进行向量化组合,形成综合特征向量;

17、s22,卷积神经网络处理静态情感特征:对于输入的综合特征向量x中的静态情感数据,采用卷积神经网络进行静态情感特征提取;

18、s23,长短期记忆网络处理动态情感特征:对于输入的动态情感特征(如语音和肢体动作),通过长短期记忆网络进行时序分析,提取情感变化特征;

19、s24:情感特征融合与提取:将卷积神经网络处理的静态特征和长短期记忆网络处理的动态特征进行融合,生成最终的情感特征向量;

20、s25:情感特征分类与输出:利用基于预训练的支持向量机的分类模型对最终的情感特征向量进行分类,识别用户的情感状态(如愉悦、紧张、疲劳等)。

21、可选的,所述s3具体包括:

22、s31,历史情感数据建模:将用户的历史情感数据进行时序建模,输入数据为s24生成的情感特征向量,历史情感数据包括多个时间点的情感特征,形成时间序列;

23、s32,情感状态变化预测:基于s31的历史数据模型,采用时间序列分析算法预测用户情感状态的未来变化;

24、s33,情感波动幅度计算:根据s32的预测结果,计算未来情感状态的波动幅度;

25、s34:情感变化方向预测:基于情感波动幅度,预测情感状态的变化方向,情感变化方向通过计算特征向量的角度变化进行判断;

26、s35:情感预测结果生成:根据情感状态的未来波动幅度和变化方向,生成情感预测结果。

27、可选的,所述s4具体包括:

28、s41,情感决策系统初始化:情感决策系统通过强化学习算法初始化,初始状态设定为用户当前的情感状态和服务机器人采取的所有交互动作的集合;

29、s42,即时奖励函数定义:在强化学习中定义即时奖励函数,其目标是通过最大化用户情感正向反馈来优化交互策略;

30、s43,策略优化:采用q-learning算法对交互策略进行优化,通过不断更新q值函数来选择最优的交互动作;

31、s44,自适应策略生成:根据q-learning算法更新后的q值函数,情感决策系统生成自适应的个性化交互策略;

32、s45,策略动态调整:随着用户情感状态的变化,情感决策系统根据用户的实时反馈不断调整策略。

33、可选的,所述s5具体包括:

34、s51:语音对话交互:根据s44生成的个性化交互策略,服务机器人通过语音合成系统与用户进行实时对话,语音对话的内容和语调由交互策略控制;

35、s52,体态调整交互:服务机器人根据交互策略调整自身的体态姿势,通过动作模拟与用户进行非语言的情感交互;

36、s53,主动娱乐交互:服务机器人根据用户的情感状态,主动提供娱乐交互,例如播放音乐、展示视频或进行小游戏。

37、可选的,所述s6具体包括:

38、s61,情感反馈数据采集:在每次情感交互过程中,服务机器人通过多模态传感器(面部表情摄像头、语音麦克风、肢体动作监测器)采集用户的实时情感反馈数据;

39、s62,反馈数据与策略的关联分析:通过自学习机制,将情感反馈数据与当前的交互策略进行关联分析,确定当前交互策略对用户情感状态的影响;

40、s63,策略优化模型更新:基于s62中的关联分析结果,采用强化学习中的q-learning算法,对情感交互策略进行优化调整;

41、s64,长期交互数据建模:通过持续采集用户的长期交互数据,建立用户情感变化的长期模型,预测用户的长期情感变化趋势。

42、可选的,所述s42中的即时奖励函数进一步包括:

43、s421,情感反馈权重调整:在计算即时奖励时,结合不同情感反馈的权重对奖励值进行调整,服务机器人根据用户的面部表情、语音语调和肢体动作的反馈数据动态调整权重;

44、s422,实时情感状态评估:在交互过程中,服务机器人实时评估用户的情感状态。

45、可选的,所述步骤s53中的主动娱乐交互进一步包括:

46、s531,情感状态驱动的娱乐内容选择:服务机器人根据用户当前的情感状态,主动推荐不同类型的娱乐内容,例如音乐、视频或小游戏,娱乐内容的选择依据用户的情感状态进行个性化推荐,例如当用户处于紧张状态时,推荐舒缓音乐,当用户情感积极时,推荐互动性强的游戏或视频;

47、s532:娱乐交互反馈监测:在提供娱乐内容的同时,服务机器人实时监测用户的情感反馈,分析用户对当前娱乐内容的情感反应。

48、本发明的有益效果:

49、本发明,通过面部表情、语音和肢体动作的多模态传感器数据采集,综合了多种情感线索,使得服务机器人能够在不同交互情境下准确捕捉用户的情感变化。通过多模态数据融合技术,消除了单一模态可能带来的情感识别偏差,进一步增强了情感分析的准确性。此外,标准化处理和噪声过滤保证了数据的稳定性和可靠性,即便在复杂的环境中,机器人也能保持高效的情感识别能。

50、本发明,通过结合强化学习中的q-learning算法,能够根据用户的情感反馈动态调整交互策略。服务机器人通过即时奖励机制和情感反馈权重调整,实时优化交互策略,确保与用户情感状态的持续同步。在交互过程中,机器人不仅能够选择最佳的语音、体态和娱乐互动方式,还可以通过不断学习积累的用户反馈数据,逐步优化自身的行为,使交互更加自然且富有个性化。

51、本发明,通过自学习机制结合用户长期情感交互数据,建立了长期情感预测模型。该机制不仅能够实时监测用户的情感反馈,还能够在长期互动中逐步学习用户的情感变化趋势,从而优化未来的交互策略。通过此机制,服务机器人在多次与同一用户的情感交互中,能够不断提高情感响应的精准度,使得长期交互更加符合用户的个性化需求,并提升用户体验的满意度和沉浸感。

- 还没有人留言评论。精彩留言会获得点赞!