一种AI课堂行为协同分析方法及系统

本发明涉及轨迹追踪,特别是涉及一种ai课堂行为协同分析方法及系统。

背景技术:

1、传统的课堂管理和行为分析方法存在诸多问题,这些问题限制了课堂行为分析的实时性和准确性,难以满足现代教育对精细化管理和个性化教学的需求。

2、首先,在数据采集方面,传统的课堂管理和行为分析方法主要依赖于教师或研究人员的观察和手工记录,这不仅耗时耗力,而且很难做到全面、客观。即使在使用摄像头、麦克风等设备进行数据采集的情况下,数据的同步和整合仍然是一个难题。多源数据的采集需要各个设备之间的高度协同,但由于设备种类繁多、采样频率不同,往往会导致数据在时间和空间上的不一致,影响后续的分析和处理。

3、其次,在数据处理方面,传统的课堂管理和行为分析方法常常依赖于事后分析,这种方法无法提供实时反馈,无法及时调整教学策略。现有的基于视频和音频的数据处理技术,虽然可以在一定程度上识别学生的表情、语音内容和动作,但由于算法复杂度高,计算资源需求大,导致处理延迟问题显著。

4、再者,在行为识别和评估方面,传统的课堂管理和行为分析方法往往采用简单的统计分析或基于规则的算法,难以应对复杂多变的课堂环境。现有的行为识别技术虽然可以通过机器学习和深度学习算法对数据进行分析,但由于缺乏对多模态数据的综合利用,往往只能从单一维度进行分析,无法全面评估学生的注意力、参与度和互动情况。

技术实现思路

1、本发明的目的是实时、精准地采集和处理数据,并实现学生行为的实时识别与有效评估。为了实现上述目的,本发明提供了一种ai课堂行为协同分析方法及系统。

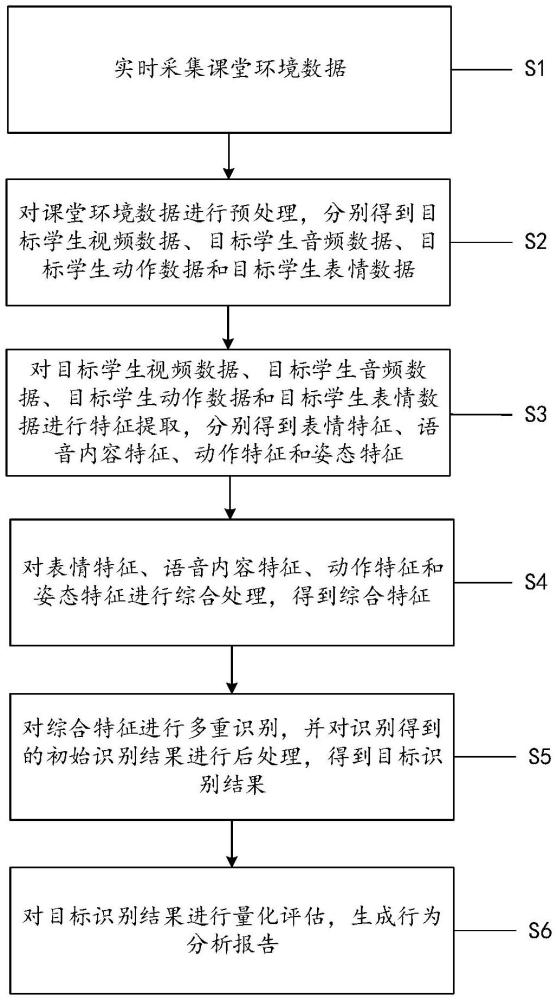

2、第一方面,本发明实施例提供了一种ai课堂行为协同分析方法,包括:

3、实时采集课堂环境数据,其中,所述课堂环境数据包括初始学生视频数据、初始学生音频数据、初始学生动作数据和初始学生表情数据;

4、对所述课堂环境数据进行预处理,分别得到目标学生视频数据、目标学生音频数据、目标学生动作数据和目标学生表情数据;

5、对所述目标学生视频数据、目标学生音频数据、目标学生动作数据和目标学生表情数据进行特征提取,分别得到表情特征、语音内容特征、动作特征和姿态特征;

6、对所述表情特征、语音内容特征、动作特征和姿态特征进行综合处理,得到综合特征,其中,所述综合处理包括单模态注意力机制处理、特征融合和多模态注意力机制处理;

7、对所述综合特征进行多重识别,并对识别得到的初始识别结果进行后处理,得到目标识别结果,其中,所述多重识别包括注意力水平识别、参与度识别和互动情况识别,所述目标识别结果包括目标学生注意力水平、目标学生参与度和目标学生互动情况;

8、对所述目标识别结果进行量化评估,生成行为分析报告,其中,所述行为分析报告包括学生注意力水平量化值、学生参与度量化值和学生互动情况量化值。

9、优选地,在所述对所述目标识别结果进行量化评估,生成行为分析报告之后,还包括:

10、基于所述行为分析报告提供实时反馈和教学建议。

11、优选地,所述对所述课堂环境数据进行预处理,分别得到目标学生视频数据、目标学生音频数据、目标学生动作数据和目标学生表情数据,包括:

12、对所述初始学生视频数据、初始学生音频数据、初始学生动作数据和初始学生表情数据进行时间同步,得到中间学生视频数据、中间学生音频数据、中间学生动作数据和中间学生表情数据;

13、对所述中间学生视频数据、中间学生音频数据、中间学生动作数据和中间学生表情数据进行去噪滤波处理,分别得到目标学生视频数据、目标学生音频数据、目标学生动作数据和目标学生表情数据。

14、优选地,所述对所述目标学生视频数据、目标学生音频数据、目标学生动作数据和目标学生表情数据进行特征提取,分别得到表情特征、语音内容特征、动作特征和姿态特征,包括:

15、对所述目标学生视频数据和所述目标学生表情数据进行第一特征提取,得到表情特征和姿态特征,其中,所述第一特征提取包括注意力机制处理、图卷积操作和特征融合;

16、对所述目标学生音频数据进行第二特征提取,得到语音内容特征,其中,所述第二特征提取包括全局特征提取、关键特征提取和自监督学习;

17、对所述目标学生动作数据进行第三特征提取,得到动作特征,其中,所述第三特征提取包括时空特征提取、时间序列特征提取和动作分类。

18、优选地,所述对所述目标学生音频数据进行第二特征提取,得到语音内容特征,包括:

19、基于transformer网络对所述目标学生音频数据进行全局特征提取,得到语音内容全局特征;

20、基于注意力机制对所述语音内容全局特征进行关键特征提取,得到语音内容关键特征;

21、对所述语音内容关键特征进行自监督学习,得到语音内容特征。

22、优选地,所述对所述表情特征、语音内容特征、动作特征和姿态特征进行综合处理,得到综合特征,包括:

23、对所述表情特征、语音内容特征、动作特征和姿态特征分别进行单模态注意力机制处理,得到加权表情特征、加权语音内容特征、加权动作特征和加权姿态特征;

24、对所述加权表情特征、加权语音内容特征、加权动作特征和加权姿态特征进行特征融合,得到融合特征;

25、对所述融合特征进行多模态注意力机制处理,得到综合特征。

26、优选地,采用第一预设公式表征所述单模态注意力机制处理,所述第一预设公式如下所示:

27、

28、其中,fatt表示加权表情特征或加权语音内容特征或加权动作特征或加权姿态特征,k表示表情特征点总数或语音内容特征点总数或动作特征点总数或姿态特征点总数,αk表示第k个表情特征点的注意力权重或第k个语音内容特征点的注意力权重或第k个动作特征点的注意力权重或第k个姿态特征点的注意力权重,fk表示第k个表情特征点或第k个语音内容特征点或第k个动作特征点或第k个姿态特征点,f表示表情特征或语音内容特征或动作特征或姿态特征;

29、采用第二预设公式表征所述特征融合,所述第二预设公式如下所示:

30、

31、其中,ffusion表示融合特征,;表示特征拼接操作,表示加权姿态特征,表示加权语音内容特征,表示加权动作特征,表示加权表情特征;

32、采用第三预设公式表征所述多模态注意力机制处理,所述第三预设公式如下所示:

33、

34、其中,cfusion表示综合特征,表示第k个融合特征点的注意力权重,表示第k个融合特征点。

35、优选地,所述对所述综合特征进行多重识别,并对识别得到的初始识别结果进行后处理,得到目标识别结果,包括:

36、基于长短期记忆网络对所述综合特征进行注意力水平识别,得到初始学生注意力水平;

37、基于卷积神经网络对所述综合特征进行参与度识别,得到初始学生参与度;

38、基于图卷积神经网络对所述综合特征进行互动情况识别,得到初始学生互动情况;

39、对所述初始学生注意力水平、初始学生参与度和初始学生互动情况分别进行去噪和异常值清除,得到目标学生注意力水平、目标学生参与度和目标学生互动情况。

40、优选地,所述对所述目标识别结果进行量化评估,生成行为分析报告,包括:

41、对所述目标学生注意力水平、目标学生参与度和目标学生互动情况分别进行分值计算,并对计算得到的分值进行标准化处理,得到学生注意力水平量化值、学生参与度量化值和学生互动情况量化值;

42、对所述学生注意力水平量化值、学生参与度量化值和学生互动情况量化值进行汇总,生成行为分析报告。

43、第二方面,本发明实施例提供了一种ai课堂行为协同分析系统,包括:

44、数据采集模块,用于实时采集课堂环境数据,其中,所述课堂环境数据包括初始学生视频数据、初始学生音频数据、初始学生动作数据和初始学生表情数据,所述数据采集模块由多个智能体组成,每一所述智能体均内置有视频数据采集设备、音频数据采集设备和动作数据采集设备;

45、数据预处理模块,用于对所述课堂环境数据进行预处理,分别得到目标学生视频数据、目标学生音频数据、目标学生动作数据和目标学生表情数据;

46、特征提取模块,用于对所述目标学生视频数据、目标学生音频数据、目标学生动作数据和目标学生表情数据进行特征提取,分别得到表情特征、语音内容特征、动作特征和姿态特征;

47、综合处理模块,用于对所述表情特征、语音内容特征、动作特征和姿态特征进行综合处理,得到综合特征,其中,所述综合处理包括单模态注意力机制处理、特征融合和多模态注意力机制处理;

48、目标识别结果确定模块,用于对所述综合特征进行多重识别,并对识别得到的初始识别结果进行后处理,得到目标识别结果,其中,所述多重识别包括注意力水平识别、参与度识别和互动情况识别,所述目标识别结果包括目标学生注意力水平、目标学生参与度和目标学生互动情况;

49、量化评估模块,用于对所述目标识别结果进行量化评估,生成行为分析报告,其中,所述行为分析报告包括学生注意力水平量化值、学生参与度量化值和学生互动情况量化值。

50、本发明实施例一种ai课堂行为协同分析方法及系统与现有技术相比,其有益效果在于:能够实时采集课堂环境中的视频、音频、动作和表情数据,并实现多源数据的实时同步和时间对齐,确保数据的准确性和一致性;引入多模态注意力机制,对各模态特征进行加权处理,充分利用多源数据的互补性,提升特征融合的精度和有效性;实现了对视频数据、音频数据、动作数据和表情数据的全面分析,提升了行为识别和评估的准确性和全面性;对提取的综合特征进行多重识别,得到学生的注意力水平、参与度和互动情况,并进行量化评估,确保评估结果的可靠性。

- 还没有人留言评论。精彩留言会获得点赞!